文章目录

- 1 前言

- 2 集群规划

- 3 hadoop安装包上传与安装

- 3.1 上传解压

- 4 hadoop配置

- 5 从节点同步和环境变量配置

- 6 创建用户

- 7 集群启动

- 8 问题集

- 8.1 Invalid URI for NameNode address (check fs.defaultFS): file:/// has no authority.

- 结语

1 前言

下面我们配置下单namenode节点hadoop集群,使用vmware虚拟机环境搭建。vmware虚拟机的配置,在下面链接2有,或者自行查阅文档。hadoop安装包可到官网下载,当前相关软件环境如下:

| 软件 | 版本 | 说明 |

|---|---|---|

| hadoop | 3.3.4 | jar包 |

| vmware | 15.5 | 虚拟机 |

| centos | 7.6 | 服务器操作系统 |

| xshell | 6 | 远程连接 |

| jdk | 1.8 | java运行环境 |

2 集群规划

在前面的准备章节,我们准备了基于vmware的三台虚拟机,现服务规划如下:

| 节点 | 服务 |

|---|---|

| node1 | NameNode、DataNode、SecondaryNameNode |

| node2 | DataNode |

| node3 | DataNode |

Hadoop HDFS的角色包含:

- NameNode:主节点管理者

- DataNode:从节点工作者

- SecondaryNameNode:主节点辅助

3 hadoop安装包上传与安装

3.1 上传解压

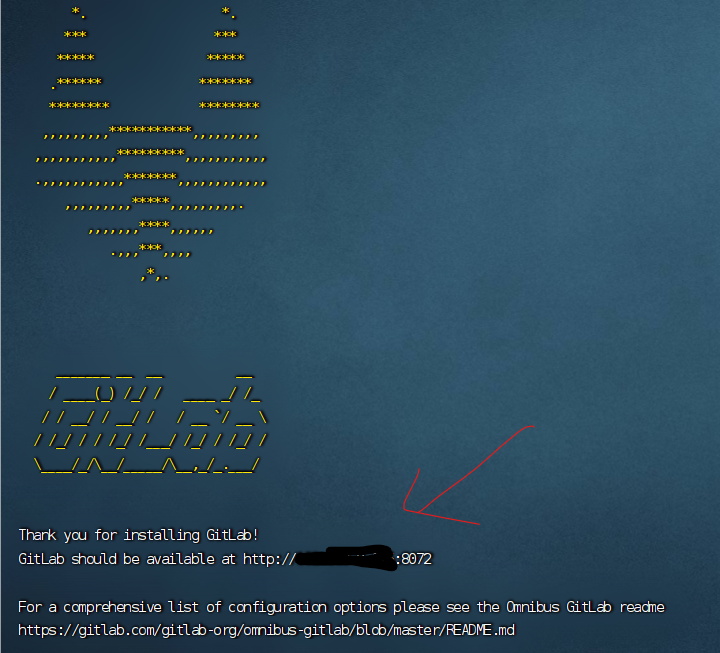

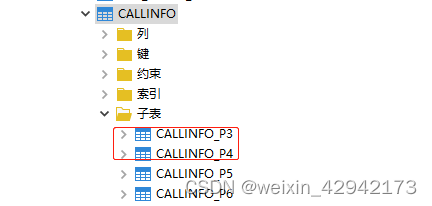

- 上传hadoop安装包到node节点中,如下图3.1-1所示

-

解压缩安装包到

/export/server中tar -zxvf hadoop-3.3.4.tar.gz -C /export/server -

构建软连接

cd /export/server ln -s /export/server/hadoop-3.3.4 hadoop

4 hadoop配置

配置HDFS集群,主要涉及以下文件的修改:

- workers:配置从节点(DataNode)有哪些

- hadoop-env.sh:配置hadoop的相关变量

- core-site.xml:hadoop的核心配置文件

- hadfs-site.xml:HDFS核心配置文件

这些文件在$HADOOP_HOME/etc/hadoop文件夹中

ps:$HADOOP_HOME是后续我们要设置的环境变量,其指代Hadoop安装文件夹即/export/server/hadoop

-

配置workers

# 进入配置文件目录 cd etc/hadoop # 编辑workers文件 vim workers # 填入如下内容 node1 node2 node3- 记录node1,node2,node3三个从节点

-

配置hadoop-en.sh

# 填入如下内容 export JAVA_HOME=/export/server/jdk export HADOOP_HOME=/export/server/hadoop export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export HADOOP_LOG_DIR=$HADOOP_HOME/logs- JAVA_HOME:jdk安装目录

- HADOOP_HOME:hadoop安装目录

- HADOOP_CONF_DIR:hadoop配置文件目录

- HADOOP_LOG_DIR:hadoop日志存放目录

-

配置

core-site.xml,此处配置NameNode会报错,后面问题集我们在分析在文件内部填入如下内容 <configuration><property><name>fs.defaultFS</name><value>hdfs://node1:8020</value></property><property><name>io.file.buffer.size</name><value>131072</value></property> </configuration>- key:fs.defaultFS;含义:HDFS文件系统的网络通讯路径;值:hdfs://node1:8020

- 协议为hdfs://

- namenode为node1

- namenode通讯端口为8020

- key:io.file.buffer.size含义:io操作文件缓冲区大小值:131072 bit

- hdfs://node1:8020为整个HDFS内部的通讯地址,应用协议为hdfs://(Hadoop内置协议)表明DataNode将和node1的8020端口通讯,node1是NameNode所在机器此配置固定了node1必须启动NameNode进程

- key:fs.defaultFS;含义:HDFS文件系统的网络通讯路径;值:hdfs://node1:8020

-

配置hdfs-site.xml

# 在文件内部填入如下内容 <configuration><property><name>dfs.datanode.data.dir.perm</name><value>700</value></property><property><name>dfs.namenode.name.dir</name><value>/data/nn</value></property><property><name>dfs.namenode.hosts</name><value>node1,node2,node3</value></property><property><name>dfs.blocksize</name><value>268435456</value></property><property><name>dfs.namenode.handler.count</name><value>100</value></property><property><name>dfs.datanode.data.dir</name><value>/data/dn</value></property> </configuration>- key:dfs.datanode.data.dir.perm;含义:hdfs文件系统,默认创建的文件权限设置值:700,即:rwx------

- key:dfs.namenode.name.dir;含义:NameNode元数据的存储位置值:/data/nn,在node1节点的/data/nn目录下

- key:dfs.namenode.hosts含义:NameNode允许哪几个节点的DataNode连接(即允许加入集群)值:node1、node2、node3,这三台服务器被授权

- key:dfs.blocksize含义:hdfs默认块大小值:268435456(256MB)

- key:dfs.namenode.handler.count;含义:namenode处理的并发线程数;值:100,以100个并行度处理文件系统的管理任务

- key:dfs.datanode.data.dir;含义:从节点DataNode的数据存储目录;值:/data/dn,即数据存放在node1、node2、node3,三台机器的/data/dn内

根据上面配置的NameNode和DataNode数据存放位置

-

namenode数据存放node1的/data/nn

-

datanode数据存放node1、node2、node3的/data/dn

-

在node1节点:

mkdir -p /data/nn mkdir /data/dn -

在node2和node3节点:

mkdir -p /data/dn

5 从节点同步和环境变量配置

目前,已经基本完成Hadoop的配置操作,可以从node1将hadoop安装文件夹远程复制到node2、node3

-

分发

# 在node1执行如下命令 cd /export/server scp -r hadoop-3.3.4 node2:`pwd`/ scp -r hadoop-3.3.4 node3:`pwd`/ -

在node2执行,为hadoop配置软链接

# 在node2执行如下命令 ln -s /export/server/hadoop-3.3.4 /export/server/hadoop -

在node3执行,为hadoop配置软链接

# 在node3执行如下命令 ln -s /export/server/hadoop-3.3.4 /export/server/hadoop

一步一步配置相对清晰,但是也繁琐,xshell有如下功能,可以在所有会话窗口执行相同的操作

配置环境变量:

在Hadoop文件夹中的bin、sbin两个文件夹内有许多的脚本和程序,现在来配置一下环境变量

-

vim /etc/profile,node1,node2,node3执行相同操作

# 在/etc/profile文件底部追加如下内容 export HADOOP_HOME=/export/server/hadoop export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

6 创建用户

hadoop部署的准备工作基本完成为了确保安全,hadoop系统不以root用户启动,我们以普通用户hadoop来启动整个Hadoop服务所以,现在需要对文件权限进行授权。

ps:请确保已经提前创建好了hadoop用户(前置准备章节中有讲述),并配置好了hadoop用户之间的免密登录以root身份,在node1、node2、node3三台服务器上均执行如下命令

# 以root身份,在三台服务器上均执行

chown -R hadoop:hadoop /data

chown -R hadoop:hadoop /export

7 集群启动

前期准备全部完成,现在对整个文件系统执行初始化,在node1节点上操作

# 确保以hadoop用户执行

su - hadoop

# 格式化namenode

hadoop namenode -format

# 一键启动hdfs集群

start-dfs.sh

# 一键关闭hdfs集群

stop-dfs.sh# 如果遇到命令未找到的错误,表明环境变量未配置好,可以以绝对路径执行

/export/server/hadoop/sbin/start-dfs.sh

/export/server/hadoop/sbin/stop-dfs.sh

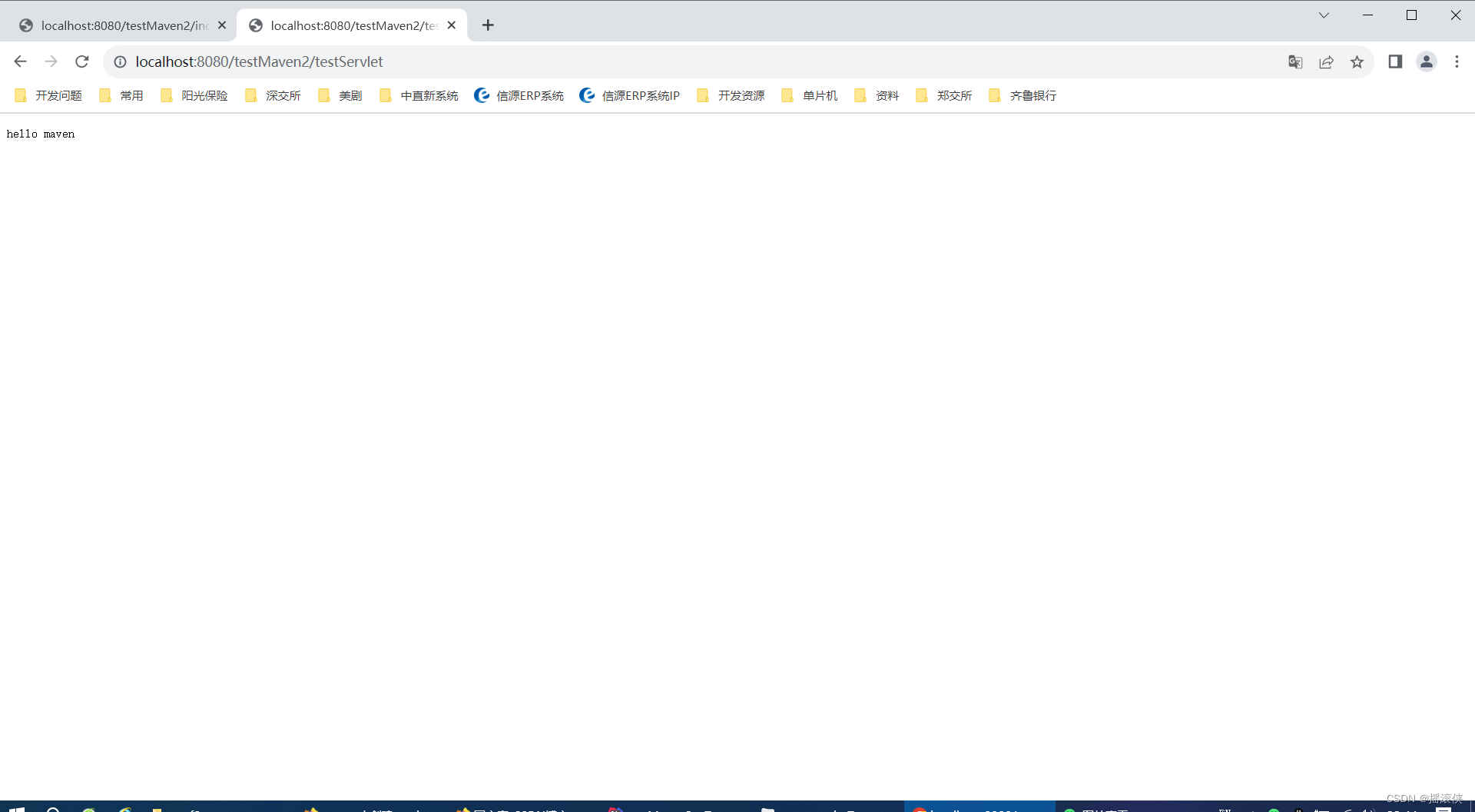

启动完成后,可以在浏览器打开:http://node1:9870,即可查看到hdfs文件系统的管理网页,如下图6-1所示

8 问题集

出了问题首先,查看日志,在配置文件$HADOOP_home/logs下面记录日志。

一些常见的报错,比如命令不存在,或者因为粗心单词写错,这里不再分析,可以去链接1视频P23-24查看原因或者自行查阅相关文档。下面主要分析一些本人遇到的非常见错误

8.1 Invalid URI for NameNode address (check fs.defaultFS): file:/// has no authority.

-

日志报错内容

2023-08-27 11:40:09,808 ERROR org.apache.hadoop.hdfs.server.namenode.SecondaryNameNode: Failed to start secondary namenode java.lang.IllegalArgumentException: Invalid URI for NameNode address (check fs.defaultFS): file:/// has no authority.at org.apache.hadoop.hdfs.DFSUtilClient.getNNAddress(DFSUtilClient.java:781)at org.apache.hadoop.hdfs.DFSUtilClient.getNNAddressCheckLogical(DFSUtilClient.java:810)at org.apache.hadoop.hdfs.DFSUtilClient.getNNAddress(DFSUtilClient.java:772)at org.apache.hadoop.hdfs.server.namenode.NameNode.getServiceAddress(NameNode.java:534)at org.apache.hadoop.hdfs.server.namenode.SecondaryNameNode.initialize(SecondaryNameNode.java:231)at org.apache.hadoop.hdfs.server.namenode.SecondaryNameNode.<init>(SecondaryNameNode.java:194)at org.apache.hadoop.hdfs.server.namenode.SecondaryNameNode.main(SecondaryNameNode.java:690)-

报错NameNode URI配置有问题,这个配置我们是按照视频做了,配置如下

<configuration><property><name>fs.defaultFS</name><value>hdfs://node1:8020</value></property>

-

-

解决方案:修改配置如下

<property><name>fs.default.name</name><value>hdfs://node1:8020</value></property> -

具体原理可以查看官方文档解释或者下面链接3

结语

如果小伙伴什么问题或者指教,欢迎交流。

❓QQ:806797785

参考链接:

[1]大数据视频[CP/OL].2020-04-16.p14-p24.

[2]0101前期准备-大数据学习[CP/OL].

[3]Hadoop的core-site.xml配置文件里的fs.default.name和fs.defaultFS[CP/OL].