1.在启动集群之前,先配置workers,有几个节点就配置几个

[atguigu@hadoop102 hadoop]$ vim /opt/module/hadoop-3.1.3/etc/hadoop/workers

在该文件中增加如下内容:

hadoop102

hadoop103

hadoop104

注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行。并将原先的localhost删除

2.同步所有节点配置文件

[atguigu@hadoop102 hadoop]$ xsync /opt/module/hadoop-3.1.3/etc

3.启动集群

注意:如果是第一次启动集群,需要进行初始化,只有第一次启动的时候才需要初始化。

- 初始化命令:(注意用户使用atguigu,不要用root,不然还是删除data,logs重新格式化)

[root@hadoop102 hadoop] hdfs namenode -format

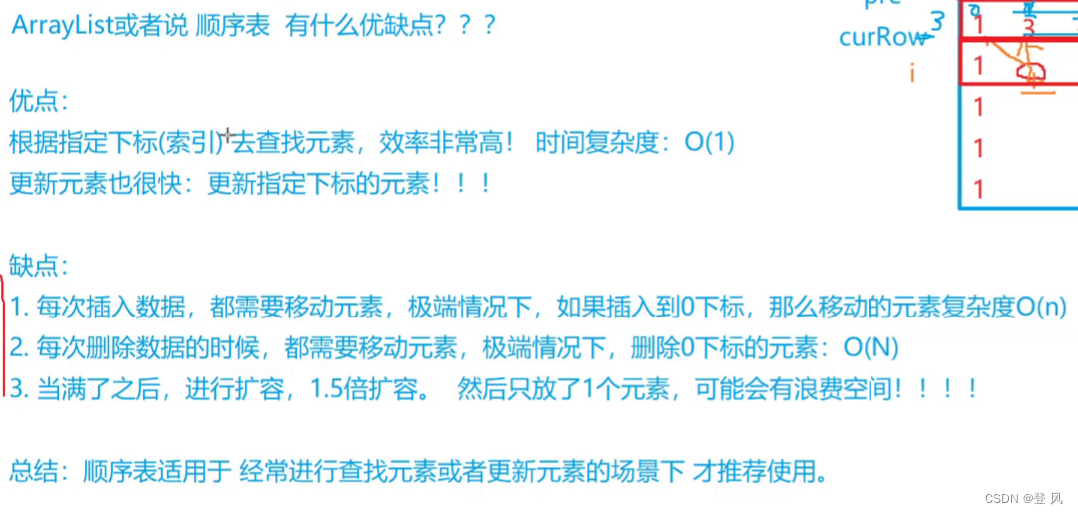

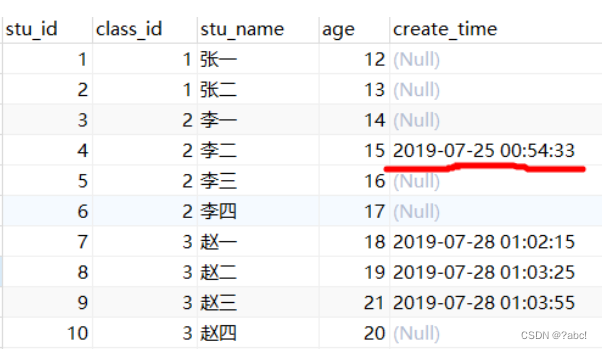

初始化结束后,路径下会多出data,logs目录,如图所示:

2) 启动HDFS

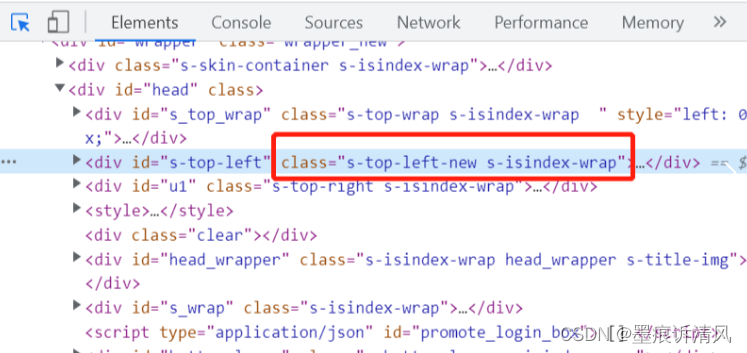

因为旨在hadoop102机器上进行了格式化,因此只有这台机器有如下的配置文件

3)在配置了ResourceManager的节点(hadoop103)启动YARN

[atguigu@hadoop103 sbin]$ start-yarn.sh

Starting resourcemanager

Starting nodemanagers

[atguigu@hadoop103 sbin]$