概述

自动化新闻生成是一种利用自然语言处理和机器学习技术,从结构化数据中提取信息并生成新闻文章的方法。它可以实现大规模、高效、多样的新闻内容生产。然而,要实现自动化新闻生成,首先需要获取可靠的数据源。这就需要使用爬虫技术,从互联网上抓取相关的新闻信息。本文将介绍如何使用Scrapy库,一个强大的Python爬虫框架,结合代理IP技术,从新浪新闻网站获取数据,并提供完整的代码示例和相关配置。

正文

1. 什么是自动化新闻生成

自动化新闻生成是一种利用自然语言处理(NLP)算法和机器学习模型,从结构化数据中提取信息并生成新闻文章的方法。它可以根据不同的数据类型、主题、风格和语言,构建完整的新闻报道,并实现大规模的新闻内容生产。

自动化新闻生成有许多优势,例如:

- 可以快速地响应事件,提高新闻时效性

- 可以覆盖更多的领域和角度,提高新闻多样性

- 可以减少人工成本和错误,提高新闻质量

- 可以根据用户的偏好和反馈,提高新闻个性化

2. 什么是爬虫技术

爬虫技术是一种程序或脚本,可以自动化地从互联网上获取数据,并将其存储或处理。在新闻报道中,爬虫技术用于从新闻网站中提取有关事件、事实和数据的信息。

爬虫技术有以下几个步骤:

- 发送请求:向目标网站发送HTTP请求,获取网页内容

- 解析内容:使用XPath或CSS选择器等方法,从网页内容中提取所需的数据

- 存储数据:将提取到的数据存储到数据库或文件中

- 循环抓取:根据网页中的链接或分页信息,继续发送请求,直到抓取完所有目标数据

3. 如何使用Scrapy和代理IP爬取新浪新闻数据

Scrapy是一个强大的Python爬虫框架,它可以实现高效、异步、可扩展的网络数据抓取。它具有以下特点:

- 基于Twisted异步网络框架,可以同时处理多个请求,提高爬取速度

- 提供了各种中间件、管道、扩展等组件,可以灵活地定制爬虫功能和逻辑

- 提供了命令行工具和可视化界面,可以方便地创建、运行和管理爬虫项目

代理IP是一种隐藏真实IP地址的方法,可以避免被目标网站识别和封禁。使用代理IP有以下好处:

- 可以突破地域限制,访问不同国家或地区的网站

- 可以降低被目标网站检测到的风险,防止被封禁或降权

- 可以提高爬取效率,减少网络延迟和拥塞

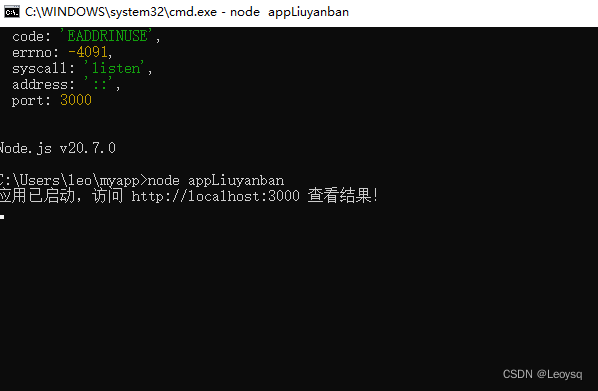

在这里,我们将介绍如何使用Scrapy库和代理IP技术,从新浪新闻网站抓取新闻数据。首先,确保已安装Scrapy库。

# 安装Scrapy

pip install scrapy

接下来,创建一个新的Scrapy项目:

scrapy startproject sina_news

接下来,创建一个新的Spider:

cd sina_news

scrapy genspider sina_news_spider news.sina.com.cn

现在,打开spiders/sina_news_spider.py文件,并添加以下代码:

import scrapyclass SinaNewsSpider(scrapy.Spider):name = 'sina_news_spider'allowed_domains = ['news.sina.com.cn']start_urls = ['http://news.sina.com.cn/']def parse(self, response):# 在这里编写爬取逻辑pass

接下来,我们需要配置代理IP。假设您使用亿牛云提供的代理IP服务,可以使用如下代码:

# 在settings.py文件中添加以下配置

import base64# 亿牛云 爬虫加强版 代理IP配置

PROXY_URL = 'http://域名:端口'

PROXY_USERNAME = '用户名'

PROXY_PASSWORD = '密码'# 定义一个代理IP中间件类

class ProxyMiddleware(object):# 重写请求处理方法def process_request(self, request, spider):# 获取 爬虫加强版 代理IP认证信息proxy_auth = f'{PROXY_USERNAME}:{PROXY_PASSWORD}'proxy_auth = base64.b64encode(proxy_auth.encode()).decode()# 设置请求头中的代理授权字段request.headers['Proxy-Authorization'] = f'Basic {proxy_auth}'# 设置请求的代理IP地址request.meta['proxy'] = PROXY_URLclass SinaNewsSpider(scrapy.Spider):name = 'sina_news_spider'allowed_domains = ['news.sina.com.cn']start_urls = ['http://news.sina.com.cn/']def parse(self, response):# 在这里编写爬取逻辑pass

在parse方法中,您可以使用XPath或CSS选择器来提取所需的新闻数据。具体的数据提取逻辑将根据新浪新闻网站的HTML结构而定。例如,如果您想要抓取首页的头条新闻的标题、链接和时间,您可以使用以下代码:

def parse(self, response):# 提取首页的头条新闻的标题、链接和时间headlines = response.xpath("//div[@class='top_newslist']/ul/li")for headline in headlines:title = headline.xpath("./a/text()").get()link = headline.xpath("./a/@href").get()time = headline.xpath("./span/text()").get()# 将提取到的数据封装成一个字典,并返回给引擎yield {"title": title,"link": link,"time": time,}

如果您想要进一步抓取每个新闻链接中的正文内容,您可以使用以下代码:

def parse(self, response):# 提取首页的头条新闻的标题、链接和时间,并发送请求进入每个链接抓取正文内容headlines = response.xpath("//div[@class='top_newslist']/ul/li")for headline in headlines:title = headline.xpath("./a/text()").get()link = headline.xpath("./a/@href").get()time = headline.xpath("./span/text()").get()# 使用代理IP访问每个新闻链接,并传递标题和时间作为元数据proxy_auth = f'{PROXY_USERNAME}:{PROXY_PASSWORD}'proxy_auth = base64.b64encode(proxy_auth.encode()).decode()yield scrapy.Request(url=link, callback=self.parse_content, headers={'Proxy-Authorization': f'Basic {proxy_auth}'}, meta={"title": title, "time": time})def parse_content(self, response):# 提取每个新闻链接中的正文内容,并与元数据一起返回给引擎content = response.xpath("//div[@id='artibody']//text()")content = "".join(content.getall()).strip()title = response.meta["title"]time = response.meta["time"]# 将提取到的数据封装成一个字典,并返回给引擎yield {"title": title,"content": content,"time": time,}这样,我们就完成了从新浪新闻网站爬取新闻数据的爬虫项目。您可以使用以下命令运行爬虫,并将数据保存到JSON文件中:

scrapy crawl sina_news_spider -o sina_news.json

结语

本文介绍了如何使用Scrapy库和代理IP技术,从新浪新闻网站获取数据,并提供了完整的代码示例和相关配置。这些数据可以为自动化新闻生成提供有力的支持,使新闻报道更加高效和多样化。自动化新闻生成和爬虫技术的结合代表着新闻报道的未来,值得我们进一步探索和应用。

![[题]欧拉函数 #欧拉函数](https://img-blog.csdnimg.cn/d7aa7888ca784610923212130c44d20c.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_Q1NETiBAWS5ZTA==,size_38,color_FFFFFF,t_70,g_se,x_16)