一、人工神经网络简介

1、神经网络起源与应用

1943年心理学家McCulloch和数学家Pitts提出神经元生物数学模型(M-P模型),后来人工神经网络(Artifical Neural Network,ANN)是在生物神经网络(Biological Neural Network,BNN)基础上发展起来的,是对人脑的某种抽象、简化和模拟,是模拟人的智能的一种途径。

神经元是神经网络的基本处理单元,一个简化的神经元是多输入、单输出的非线性元件,大量的神经元互联而成的神经网络(非线性元件),在人工智能和机器自学习、自组织、联想以及容错方面具有强大的能力。

2、人工神经元的工作原理

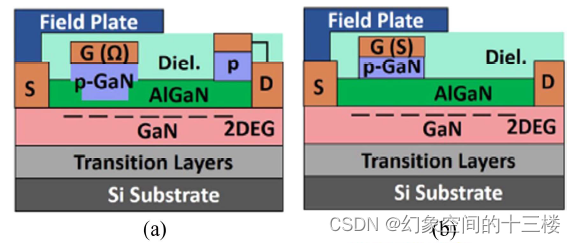

大脑的神经细胞由细胞体(soma)、一些树突(dendrite)和一根可以很长的轴突(Axon)组成,树突由细胞体的各个方向长出,本身可有分支,是用来接受信号的,轴突也有许多分支,通过分支末梢(terminal)和其它细胞的树突接触,形成突触,把产生的信号传送给其它细胞,如图(1)所示。

图(1) McCulloch-Pitts网络

大脑的神经元细胞只有两种状态:兴奋和压抑。神经细胞把所有从树突上突触进来的信号进行相加,如果全部信号超过某个阈值,就会激发细胞进入兴奋状态,就会有信号通过轴突发送信号给其它细胞。如果信号没有超过阈值,细胞就不会兴奋。

模拟大脑的人工神经网络是采用神经元组成的,神经元是人工神经网络的基本处理单元,它一般是一个多输入/多输出的非线性元件。神经元输出受到输入信号和内部其它因素的影响,所以人工神经元的建模中,常常还有一个额外的输入信号,称为偏差(bais),有时也称为阀值或限值。

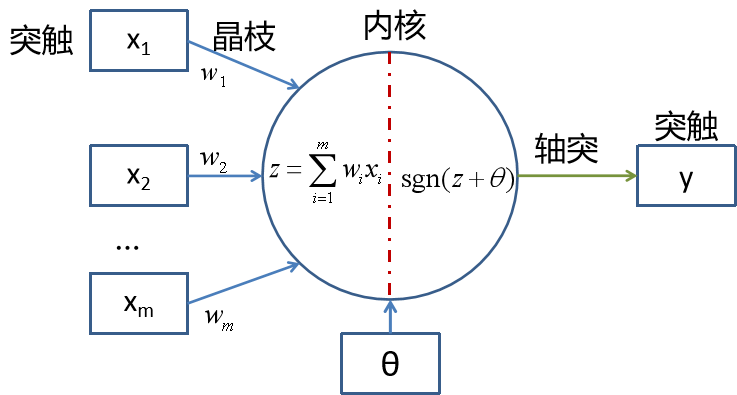

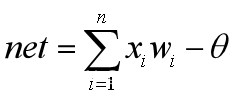

人工神经网络模拟生物神经元的一阶特性,人工神经元有n个输入,即输入为X=(x1,x2,…,xn),连接权为W=(w1,w2,…,wn)T,神经元输出为 采用向量的形式,即Net=X·W-θ.

采用向量的形式,即Net=X·W-θ.

3、神经网络结构

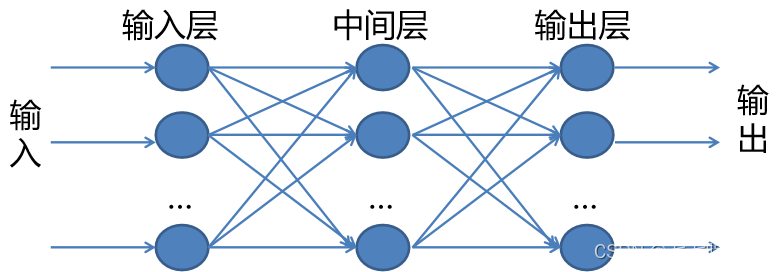

三层前馈神经网络的构造由三层排列,分别是输入层、隐含层(中间层)和输出层。每一层的神经元接受来自前一层神经元的输出作为输入,后面层对前面的层没有反馈。感知器网络和BP网络均属前馈网络。

三层前向神经网络结构

4、神经网络常用激励函数

激励函数,又称激活函数或传递函数,通常有三种

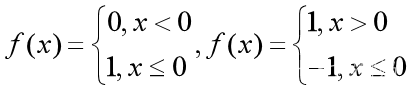

(1)阀值型

这里函数一般用在简单的分类模型中。

这里函数一般用在简单的分类模型中。

(2)线性型

f(x)=x 一般只用在输入神经元和输出神经元。

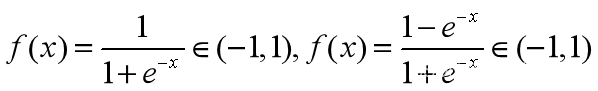

(3)S型

常用于隐含层,第一个为logsig()函数,第二个为logtan()函数。都是光滑函数,且第一个函数满足![]()

二、常见神经网络理论

1、BP神经网络

BP(Back propagation)神经网络,又称前向反馈神经网络,主要是网络训练中,调整权值和阀值的训练算法时反向传播算法(即BP学习算法),也是神经网络的精华和完美的内容。 BP神经网络是一种有三层或三层以上的神经网络,概括输入层、中间层(隐含层)和输出层,上下层之间全连接,同层之间神经元无连接。

当一对学习样本提供给输入层神经元后,神经元的激活值(该层神经元的输出值)从输入层经过各隐含层神经元向输出层传播,在输出层获得网络的输入响应,然后按照减少网络输出与实际样本样本之间误差的反向,从输出层反向经过隐含层回到输入层,从而逐步修正连接权值,这种算法称为“误差反向传播算法”,即BP算法。随着这种误差逆向传播修正的反复进行,网络对输入模式相应的正确率不断上升,BP算法的核心是“负梯度下降”理论,即BP神经网络的误差调整总是沿着误差下降最快的方向进行。

为了更好地理解BP神经网络,我们来看一个简单的例子:假设我们要训练一个网络来判断一张图片中的数字是1还是0。

首先,我们将每个像素点作为输入层的一个神经元,并将它们与隐藏层的每个神经元连接起来。隐藏层可以有多个神经元,影响网络的复杂度和表示能力。

然后,我们将隐藏层的每个神经元与输出层的两个神经元(代表数字1和0)相连。

在训练过程中,我们将输入一张图片,网络将对其进行前向传播,即通过网络计算出预测结果。然后,我们将预测结果与实际标签进行比较,并计算出损失函数(通常使用交叉熵损失)来衡量预测的错误程度。

接下来,反向传播算法将根据损失函数的梯度来调整每个连接的权重,以减小损失函数的值。这个过程会逐渐优化网络的预测能力,使得网络能够更准确地判断输入图片中的数字是1还是0。

通过不断迭代上述步骤,网络学习到的权重参数将使其在对新的图片进行数字分类时具有较好的准确性。

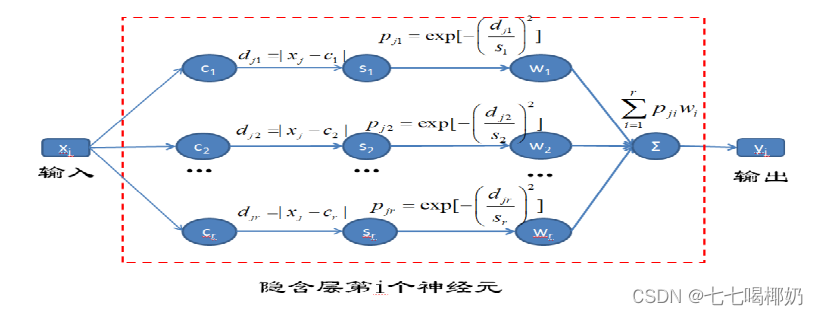

2、径向基网络

RBF(Radical Basis Function)神经网络。生物学中,中枢神经元的感受视野是指能影响某一神经元反应的视网膜或视野的区域。视网膜上的感受器(杆体细胞和锥体细胞)通过接受光并将它转换为神经输出信号,从而不同程度地激活众多神经节细胞、外膝状体细胞以及视觉皮层中的神经细胞。RBF神经网络是模拟视网膜的感受功能而产生的,其基本特征是:

(1)距离感受视野中心的越近,视神经元越兴奋,距离感受中心越远,视神经元响应越消极; (2)视神经元的激活区域呈现径向对称。

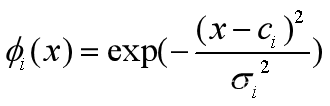

综上所述,隐含层的视神经元的刺激函数常用高斯函数,即 (i为隐含层第i神经元)

(i为隐含层第i神经元)

而输入和输出则采用线性激励函数。其中,x为输入样本,ci为感受视野中心,σ为宽度,exp( )为隐含层输出。

RBF学习方法

- 聚类方法 : 首选k聚类,即先用k—means方法确定网络数据的中心,然后根据各数据与中心的距离,确定隐含层神经元函数的宽度。

- 梯度训练法 :根据能量函数使用负梯度训练原理自行调节各神经元的数据中心、宽度、权值。

- 正交最小二乘(OLS)训练方法:依据能量的贡献,使各隐含层神经元的基函数之间趋于正交,从而使基函数之间没有信息冗余和性能相互嵌套。

![[论文笔记]SimCSE](https://img-blog.csdnimg.cn/img_convert/23ca7438cadf266f0be5fba1e0cb7689.png)