推荐看这个链接,有些问题解决出处https://zhuanlan.zhihu.com/p/643824521

以及这个https://blog.csdn.net/weixin_40547993/article/details/131775275

1.需要pytorch2.0,所以CUDA推荐11.8

ChatGLM2-6B版本要装PYTORCH2.0,而且要2.0.1 ,所以CUDA不能用12.0 ,只能用11.x 版本,11.5也不支持,推荐11.8。

cuda和cudnn安装教程推荐

Cuda和cuDNN安装教程(超级详细)-CSDN博客

2.conda新建环境,否则很容易把之前环境毁了

python大于3.8即可

conda create -n chatGLM python==3.83. 源码安装

https://huggingface.co/THUDM/chatglm2-6b

或者国内镜像(不能翻墙的福音)

https://gitee.com/dadac/ChatGLM2-6B

cd chatglm2-6b

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple#必要可以加清华源4.下载模型

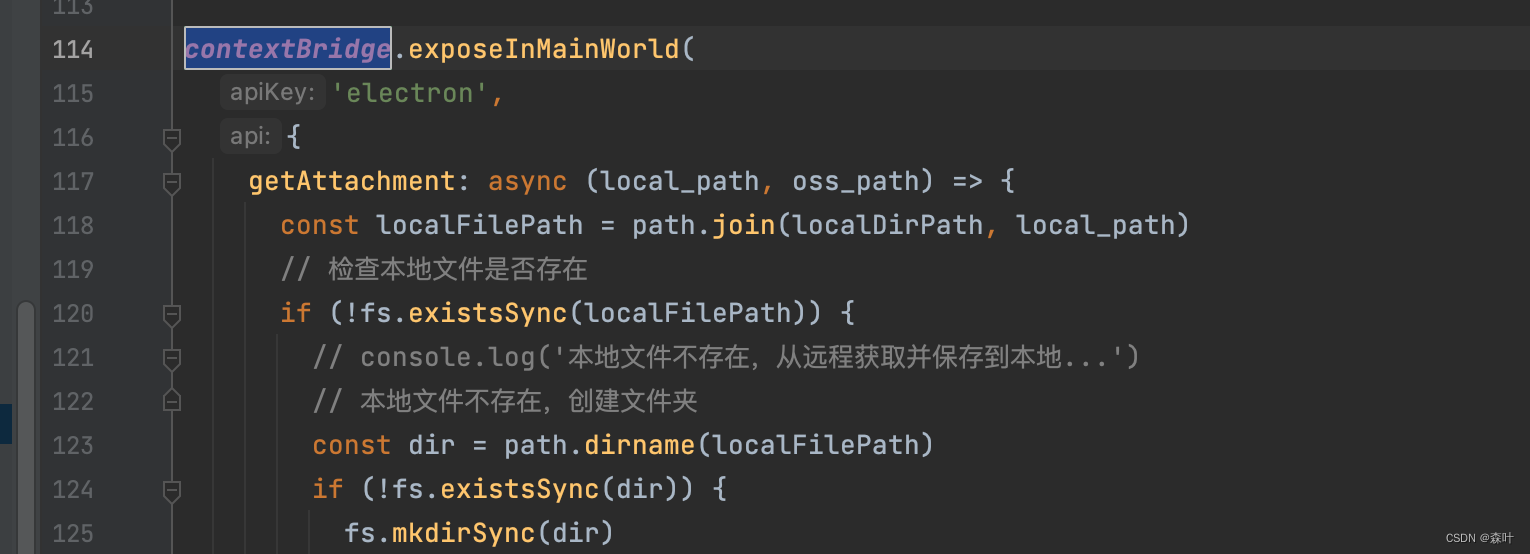

修改代码,web_demo.py和web_demo2.py

#你模型的位置

tokenizer = AutoTokenizer.from_pretrained("chatglm2-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("chatglm2-6b", trust_remote_code=True).cuda()5.启动

运行python web_demo.py或者streamlit run web_demo2.py

我运行前者,问答没有结果,运行后者结果