本文重点

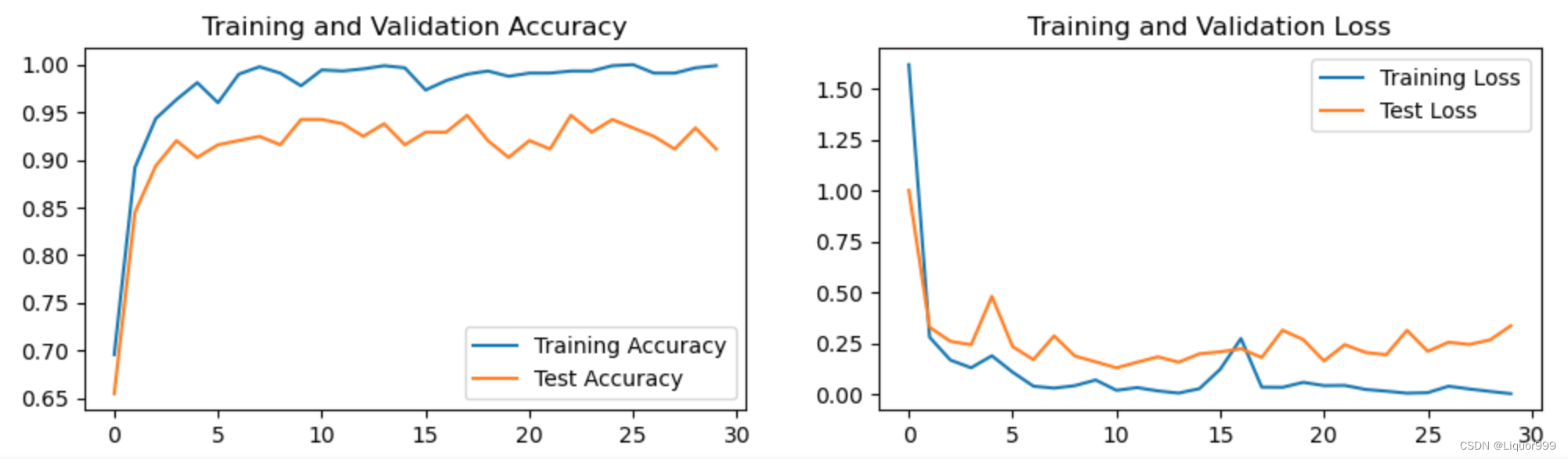

卷积神经网络(Convolutional Neural Network,CNN)作为一种强大的深度学习模型,在计算机视觉任务中取得了巨大成功。其中,池化层(Pooling Layer)在卷积层之后起到了信息压缩和特征提取的作用。然而,池化层的反向传播一直以来都是一个相对复杂和深奥的问题。本文将详细解释卷积网络池化层反向传播的实现原理,并探讨其在信息压缩方面的奥秘。

池化层的反向传播

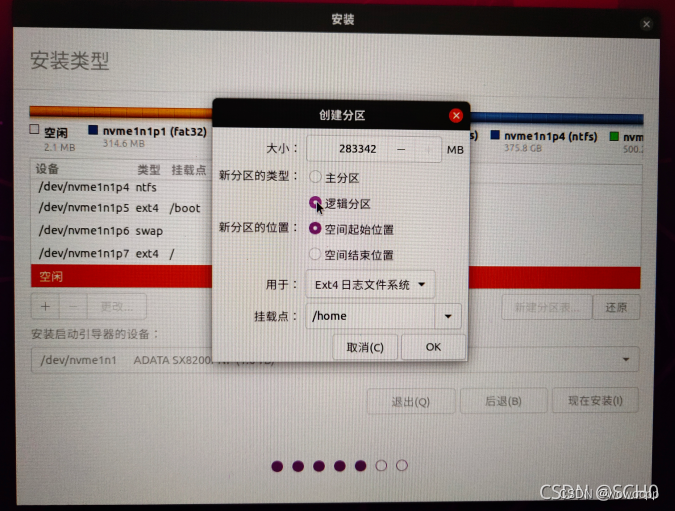

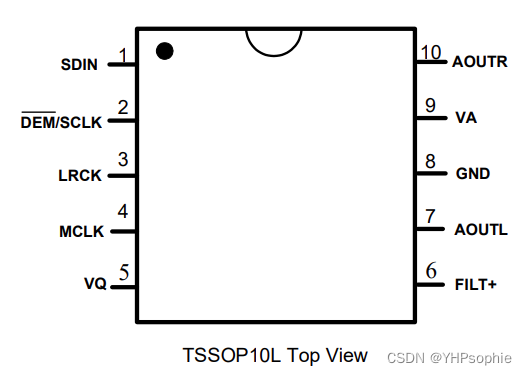

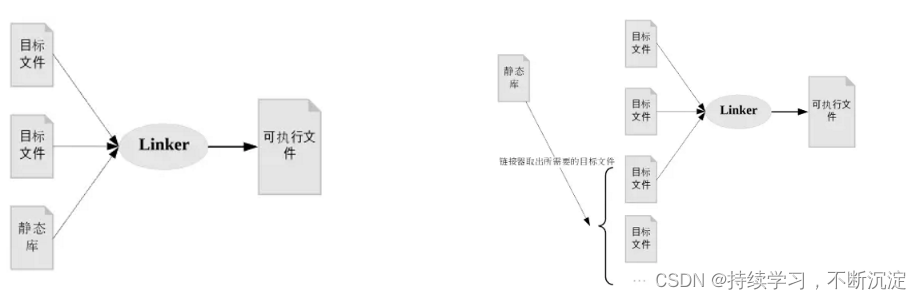

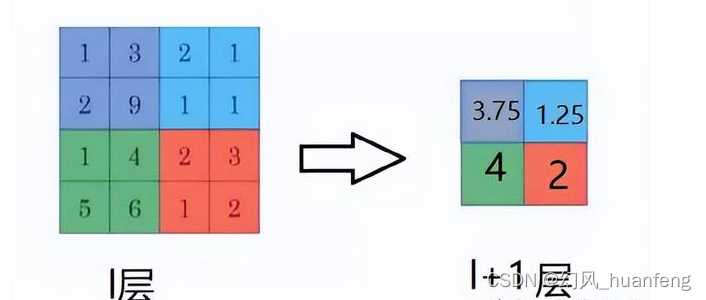

与卷积层不同,池化层并没有可学习的参数,因此其反向传播主要是为了传递梯度信息。我们假如现在有一个4*4的特征图,如果使用2*2的池化窗口处理,那么无论是最大池化还是均值池化,池化之后的特征图都应该是2*2的

因为池化操作使得特征图的尺寸发生变化,如上所示:

假如做2×2的池化,假设那么第l+1层的特征图有4个梯度,那么第l层就会有16个梯度,这使得梯度无法对位的进行传播下去。要想解决这个问题需要把1个像素的梯度传递给4个像素,但是需要保证传递的梯度总和不变,不同的池化操作是不同。

平均池化

平均池化的前向传播就是把一个特征图中的值求取平均,那么反向传播的过程也就是把元素的梯度等分为n份分配给前一层,这样就保证池化前后的梯度之和保持不变

![[Machine Learning][Part 7]神经网络的基本组成结构](https://img-blog.csdnimg.cn/7a2bf0ef65b549ada19173f67b321d17.png)