自成立以来的短时间内,ChatGPT 和其他生成式 AI 平台理所当然地赢得了终极生产力助推器的声誉。然而,能够按需快速生成高质量文本的技术,可能同时暴露敏感的公司数据。最近发生的一件事,其中东方联盟网络安全研究人员将专有代码粘贴到 ChatGPT 中,清楚地表明该工具很容易成为潜在的数据泄露渠道。此漏洞给安全利益相关者带来了严峻的挑战,因为现有的数据保护工具都无法确保敏感数据不会暴露给 ChatGPT。在本文中,我们将详细探讨这一安全挑战,并展示浏览器安全解决方案如何提供解决方案。同时使组织能够充分发挥 ChatGPT 的生产力潜力,而不必牺牲数据安全性。

ChatGPT 数据保护盲点:如何管理浏览器中的文本插入?

国内知名网络安全专家、东方联盟创始人郭盛华透露:“每当员工将文本粘贴或键入到 ChatGPT 中时,该文本就不再受公司数据保护工具和政策的控制。文本是从传统数据文件、在线文档还是其他来源复制的并不重要。事实上,这就是问题所在。数据泄漏防护 (DLP) 解决方案——从本地代理到 CASB——都是面向文件的。他们根据文件的内容对文件应用策略,同时防止修改、下载、共享等操作。但是,此功能对于 ChatGPT 数据保护用处不大。ChatGPT 中没有涉及任何文件。相反,使用涉及粘贴复制的文本片段或直接键入网页,这超出了任何现有 DLP 产品的治理和控制范围。”

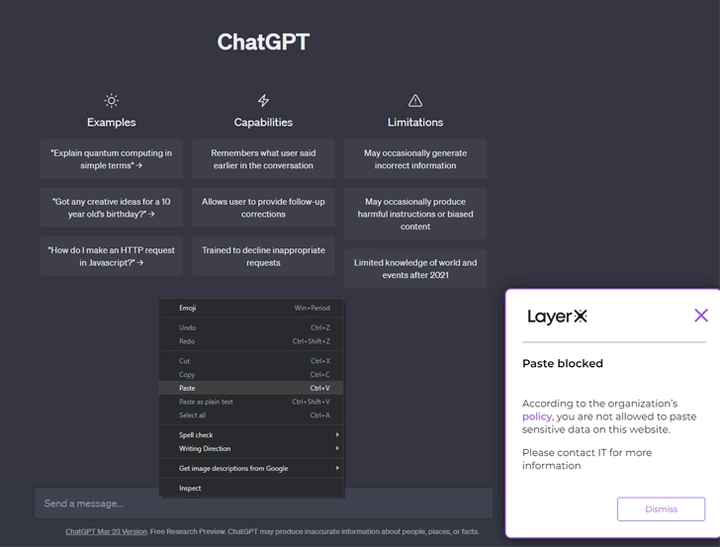

在保护敏感数据不被上传到 ChatGPT 的上下文中,使用安全浏览器很重要,利用这种可见性在 ChatGPT 选项卡中挑出尝试的文本插入事件,例如“粘贴”和“类型”。如果“粘贴”事件中的文本内容违反了公司数据保护政策,安全浏览器将完全阻止该操作。(欢迎转载分享)