前言

Python是一门强大的编程语言,它可以用于爬取互联网上的各种数据。在这篇文章中,我们将学习如何使用Python爬取全国高校数据,并使用代理IP进行爬取。

本文主要分为以下几个部分:

- 数据来源及需求

- 安装依赖包及导入模块

- 爬取全国高校数据

- 使用代理IP

- 总结

一、数据来源及需求

我们将从教育部官网爬取全国高校数据,数据包括高校名称、所在地区、办学类型、所属教育部门等信息。

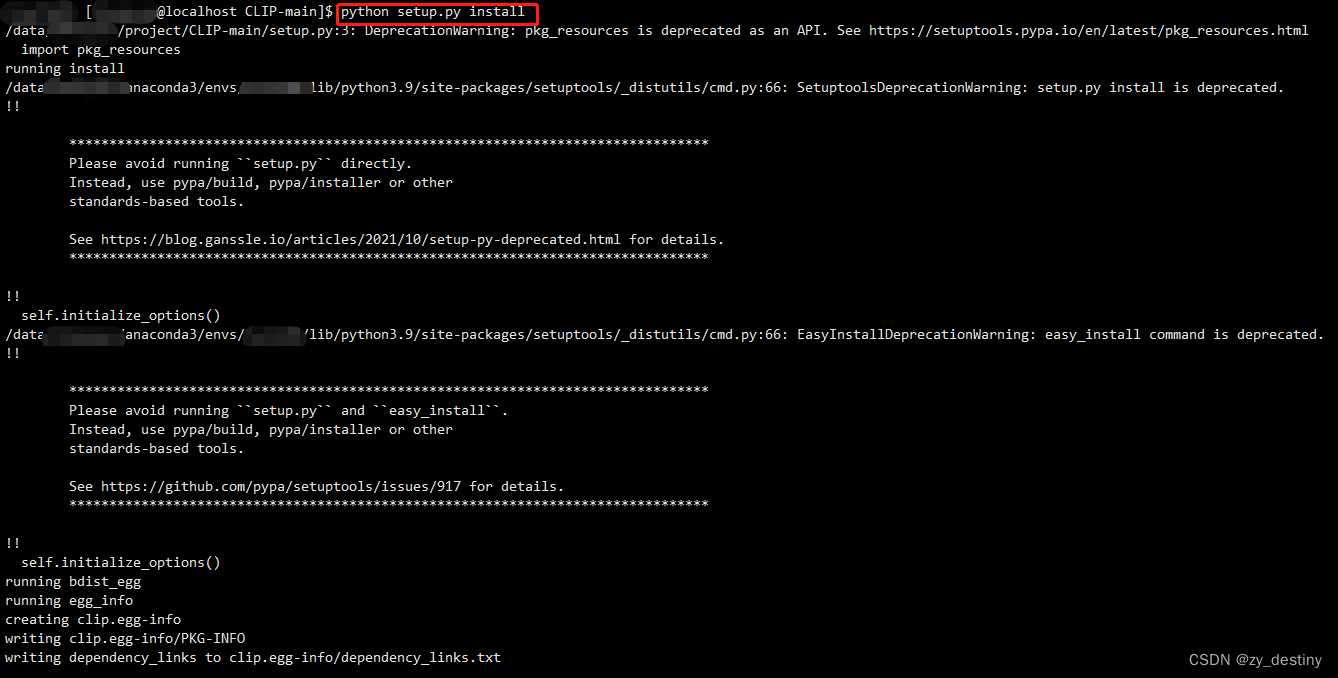

二、安装依赖包及导入模块

在爬取数据之前,我们需要安装一些依赖包,包括requests、beautifulsoup4和pandas。可以使用以下命令安装:

pip install requests beautifulsoup4 pandas

在安装完依赖包后,我们需要导入相应的模块:

import requests

from bs4 import BeautifulSoup

import pandas as pd

三、爬取全国高校数据

首先,我们需要确定爬取的网址。在本文中,我们将从教育部官网爬取全国高校名单,网址为:http://www.moe.gov.cn/s78/A03/moe_560/jytjsj_2015/。

然后,我们需要使用requests库向该网址发送请求,并获取响应:

url = 'http://www.moe.gov.cn/s78/A03/moe_560/jytjsj_2015/'

response = requests.get(url)

接下来,我们需要使用BeautifulSoup库对获取到的响应进行解析。具体来说,我们需要找到包含高校信息的表格,并提取其中的数据。在本文中,我们的数据位于一个名为'main1'的表格中。因此,我们可以使用以下代码对表格进行解析:

soup = BeautifulSoup(response.text, 'html.parser')

table = soup.find('table', id='main1')然后,我们需要从表格中提取数据并存储到一个列表中。具体来说,我们需要遍历表格中的每一行,并将每一行的信息存储到一个字典中。最后,我们将所有字典存储到一个列表中。代码如下:

data = []

for tr in table.find_all('tr')[1:]:tds = tr.find_all('td')d = {'序号': tds[0].text.strip(),'名称': tds[1].text.strip(),'所在地区': tds[2].text.strip(),'隶属单位': tds[3].text.strip(),'办学类型': tds[4].text.strip(),'院校特色': tds[5].text.strip(),}data.append(d)最后,我们可以使用pandas库将数据存储到一个CSV文件中:

df = pd.DataFrame(data)

df.to_csv('universities.csv', index=None)完整代码如下:

import requests

from bs4 import BeautifulSoup

import pandas as pdurl = 'http://www.moe.gov.cn/s78/A03/moe_560/jytjsj_2015/'

response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')

table = soup.find('table', id='main1')data = []

for tr in table.find_all('tr')[1:]:tds = tr.find_all('td')d = {'序号': tds[0].text.strip(),'名称': tds[1].text.strip(),'所在地区': tds[2].text.strip(),'隶属单位': tds[3].text.strip(),'办学类型': tds[4].text.strip(),'院校特色': tds[5].text.strip(),}data.append(d)df = pd.DataFrame(data)

df.to_csv('universities.csv', index=None)

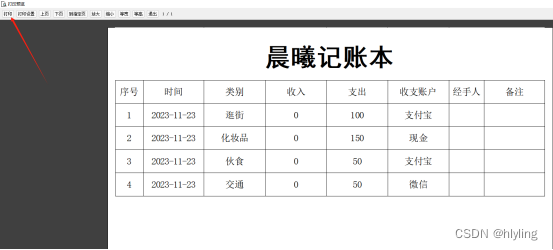

运行以上代码,我们将在当前目录下生成一个名为'universities.csv'的文件,其中包含了全国高校的信息。

四、使用代理IP

在爬取数据时,我们可能会遇到被网站屏蔽的情况。为了避免这个问题,我们可以使用代理IP进行爬取。代理IP的作用是隐藏我们的真实IP地址,并通过代理服务器向目标网站发送请求。因此,即使目标网站屏蔽了我们的IP地址,我们仍然能够顺利地爬取数据。

首先,我们需要找到可用的代理IP。可以在网上搜索相关的代理IP网站,并从中获取可用的IP地址。然后,我们需要修改代码,将代理IP配置到requests库中。具体来说,我们需要在requests.get()函数中增加proxies参数,指定代理IP的协议、IP地址和端口号。例如,如果我们的代理IP的协议为'http',IP地址为'127.0.0.1',端口号为'8080',那么我们可以这样配置代理IP:

proxies = {'http': 'http://127.0.0.1:8080','https': 'https://127.0.0.1:8080',

}

response = requests.get(url, proxies=proxies)完整代码如下:

import requests

from bs4 import BeautifulSoup

import pandas as pdurl = 'http://www.moe.gov.cn/s78/A03/moe_560/jytjsj_2015/'# 使用代理IP进行爬取

proxies = {'http': 'http://127.0.0.1:8080','https': 'https://127.0.0.1:8080',

}

response = requests.get(url, proxies=proxies)soup = BeautifulSoup(response.text, 'html.parser')

table = soup.find('table', id='main1')data = []

for tr in table.find_all('tr')[1:]:tds = tr.find_all('td')d = {'序号': tds[0].text.strip(),'名称': tds[1].text.strip(),'所在地区': tds[2].text.strip(),'隶属单位': tds[3].text.strip(),'办学类型': tds[4].text.strip(),'院校特色': tds[5].text.strip(),}data.append(d)df = pd.DataFrame(data)

df.to_csv('universities.csv', index=None)

在上面的代码中,我们将代理IP配置为了本地IP地址。实际使用时,我们需要替换为可用的代理IP地址。

总结

在本文中,我们学习了如何使用Python爬取全国高校数据,并使用代理IP进行爬取。通过本文的学习,相信读者已经了解了Python爬虫的基本原理及其应用。在实际应用中,我们需要考虑到数据的合法性和隐私保护等问题,并严格遵守相关法律法规。