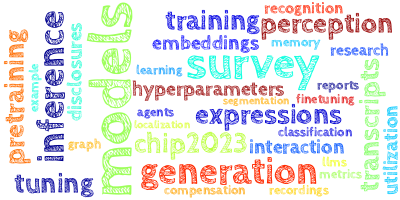

AI视野·今日CS.NLP 自然语言处理论文速览

Mon, 1 Jan 2024

Totally 42 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| Principled Gradient-based Markov Chain Monte Carlo for Text Generation Authors Li Du, Afra Amini, Lucas Torroba Hennigen, Xinyan Velocity Yu, Jason Eisner, Holden Lee, Ryan Cotterell 最近的论文证明了通过采用基于梯度的采样算法(一种保证快速收敛的 MCMC 算法范例)来生成基于能量的文本的可能性。然而,正如我们在本文中所示,以前对这种文本生成方法的尝试都未能从目标语言模型分布中正确采样。为了解决这个限制,我们考虑设计忠实的文本采样器的问题,这意味着它们将目标文本分布作为其限制分布。我们提出了几种基于忠实梯度的采样算法来正确地从基于目标能量的文本分布中进行采样,并研究了它们的理论特性。 |

| TuPy-E: detecting hate speech in Brazilian Portuguese social media with a novel dataset and comprehensive analysis of models Authors Felipe Oliveira, Victoria Reis, Nelson Ebecken 社交媒体已成为人类互动不可或缺的一部分,提供了沟通和表达的平台。然而,这些平台上仇恨言论的兴起给个人和社区带来了重大风险。由于葡萄牙语等语言丰富的词汇、复杂的语法和地区差异,检测和解决仇恨言论尤其具有挑战性。为了解决这个问题,我们引入了 TuPy E,这是最大的用于仇恨言论检测的带注释葡萄牙语语料库。 TuPy E 利用开源方法,促进研究社区内的协作。 |

| Gemini in Reasoning: Unveiling Commonsense in Multimodal Large Language Models Authors Yuqing Wang, Yun Zhao 人们对多模态大型语言模型 MLLM(例如 OpenAI 的 GPT 4V sion)的兴趣日益浓厚,对学术和工业领域产生了重大影响。这些模型增强了大型语言模型法学硕士的高级视觉理解能力,促进其在各种多模式任务中的应用。最近,Google 推出了 Gemini,这是一款专为多模式集成而设计的尖端 MLLM。尽管取得了进步,但初步基准测试表明,Gemini 在常识推理任务中落后于 GPT 模型。然而,这种基于有限数据集(即 HellaSWAG)的评估并没有完全捕捉 Gemini 真正的常识推理潜力。为了解决这一差距,我们的研究对双子座在复杂推理任务中的表现进行了全面评估,这些任务需要跨模式的常识知识的整合。我们对 12 个常识推理数据集进行了全面分析,范围从一般任务到特定领域任务。其中包括 11 个仅关注语言的数据集,以及一个包含多模态元素的数据集。我们对四个法学硕士和两个法学硕士进行的实验证明了 Gemini 具有竞争力的常识推理能力。 |

| Normalization of Lithuanian Text Using Regular Expressions Authors Pijus Kasparaitis 文本规范化是任何文本到语音合成系统的组成部分。在自然语言文本中,存在属于其他符号类别的元素,例如数字、日期、缩写等。它们被称为新南威尔士州非标准单词,需要扩展为普通单词。为此,有必要确定每个新南威尔士州的符号类别。作品中介绍了适合立陶宛语言的符号类别的分类法。创建规则集用于基于正则表达式检测和扩展 NSW。使用三个完全不同的数据集进行实验并评估准确性。 |

| Large Language Models for Generative Information Extraction: A Survey Authors Derong Xu, Wei Chen, Wenjun Peng, Chao Zhang, Tong Xu, Xiangyu Zhao, Xian Wu, Yefeng Zheng, Enhong Chen 信息提取IE旨在从纯自然语言文本中提取实体、关系和事件等结构知识。最近,生成式大型语言模型法学硕士在文本理解和生成方面表现出了卓越的能力,可以跨不同领域和任务进行泛化。因此,人们提出了许多工作来利用法学硕士的能力,并为基于生成范式的 IE 任务提供可行的解决方案。为了对 IE 任务的法学硕士工作进行全面系统的回顾和探索,在这项研究中,我们调查了该领域的最新进展。我们首先根据各种 IE 子任务和学习范式对这些作品进行分类,从而提供广泛的概述,然后我们对最先进的方法进行实证分析,并发现法学硕士 IE 任务的新兴趋势。基于进行的彻底审查,我们确定了一些技术见解和有前途的研究方向,值得在未来的研究中进一步探索。 |

| Towards Faithful Explanations for Text Classification with Robustness Improvement and Explanation Guided Training Authors Dongfang Li, Baotian Hu, Qingcai Chen, Shan He 特征归因方法突出了重要的输入标记作为模型预测的解释,已广泛应用于深度神经网络以实现值得信赖的人工智能。然而,最近的研究表明,这些方法提供的解释面临着忠实和稳健的挑战。在本文中,我们提出了一种具有鲁棒性改进和解释引导训练的方法,以实现更忠实的文本分类解释正则表达式。首先,我们通过输入梯度正则化技术和虚拟对抗训练来提高模型的鲁棒性。其次,我们使用显着排名来掩盖噪声标记并最大化模型注意力和特征归因之间的相似性,这可以看作是一种自我训练过程,无需导入其他外部信息。我们使用五种归因方法对六个数据集进行了广泛的实验,并评估了域外设置中的忠实度。结果表明,REGEX 提高了所有设置中解释的保真度指标,并根据两次随机化测试进一步实现了一致的增益。 |

| Action-Item-Driven Summarization of Long Meeting Transcripts Authors Logan Golia, Jugal Kalita 在线会议的日益普及大大增强了自动生成给定会议摘要的模型的实用性。本文介绍了一种新颖有效的方法来自动生成会议摘要。当前解决这个问题的方法产生了一般性和基本的总结,将会议简单地视为一次漫长的对话。然而,我们的新颖算法可以生成由会议记录中包含的行动项目驱动的抽象会议摘要。这是通过递归生成摘要并针对会议的每个部分并行使用我们的操作项提取算法来完成的。然后将所有这些分段摘要组合并总结在一起,以创建连贯的、行动项目驱动的摘要。此外,本文还介绍了三种将长文本分为基于主题的部分的新颖方法,以提高算法的时间效率,并解决大型语言模型法学硕士忘记长期依赖关系的问题。 |

| Building Efficient Universal Classifiers with Natural Language Inference Authors Moritz Laurer, Wouter van Atteveldt, Andreu Casas, Kasper Welbers 由于文本生成的普遍性,生成性大语言模型法学硕士已成为少样本和零样本学习的主流选择。然而,当许多用户只想自动执行分类任务时,他们不需要生成式法学硕士的广泛功能。较小的 BERT 之类的模型还可以学习通用任务,这使得它们能够执行任何文本分类任务,而无需微调 Zeroshot 分类,或者仅使用几个示例 Fewshot 来学习新任务,同时比生成式 LLM 效率更高。本文 1 解释了如何将自然语言推理 NLI 用作通用分类任务,该任务遵循与生成 LLM 的指令微调类似的原则,2 提供了用于构建通用分类器的可重用 Jupyter 笔记本的分步指南,3 分享了由此产生的通用分类器在 33 个数据集(包含 389 个不同类别)上进行训练。 |

| Enhancing Quantitative Reasoning Skills of Large Language Models through Dimension Perception Authors Yuncheng Huang, Qianyu He, Jiaqing Liang, Sihang Jiang, Yanghua Xiao, Yunwen Chen 数量是文本中独特且关键的组成部分,它表征了实体的大小属性,为理解自然语言(尤其是推理任务)提供了精确的视角。近年来,基于大型语言模型的LLM推理任务研究层出不穷,但大多只关注数值,而忽略了单位数量的量纲概念,尽管它很重要。我们认为,维度的概念对于精确理解数量至关重要,对于法学硕士进行定量推理具有重要意义。然而,维度知识和数量相关基准的缺乏导致了法学硕士的低绩效。因此,我们提出了一个框架来增强基于维度感知的语言模型的定量推理能力。我们首先构建一个维度单位知识库 DimUnitKB 来解决该领域的知识空白。我们提出了一个基准 DimEval,由三个类别的七个任务组成,以探索和增强法学硕士的维度感知技能。为了评估我们方法的有效性,我们提出了定量推理任务并进行实验。 |

| Overview of the PromptCBLUE Shared Task in CHIP2023 Authors Wei Zhu, Xiaoling Wang, Mosha Chen, Buzhou Tang |

| Truth Forest: Toward Multi-Scale Truthfulness in Large Language Models through Intervention without Tuning Authors Zhongzhi Chen, Xingwu Sun, Xianfeng Jiao, Fengzong Lian, Zhanhui Kang, Di Wang, Cheng Zhong Xu 尽管大型语言模型法学硕士在各种任务中取得了巨大成功,但他们仍会产生幻觉。我们引入了真相森林,这是一种通过使用多维正交探针发现隐藏的真相表示来增强法学硕士的真实性的方法。具体来说,它通过将正交约束合并到探针中来创建用于建模真相的多个正交基。此外,我们引入了随机查看(Random Peek),这是一种考虑序列内扩展位置范围的系统技术,减少了法学硕士中辨别和生成真实特征之间的差距。通过采用这种方法,我们将 Llama 2 7B 在 TruthfulQA 上的真实性从 40.8 提高到 74.5。同样,在微调模型中也观察到了显着的改进。我们使用探针对真实特征进行了彻底的分析。我们的可视化结果表明,正交探针捕获了互补的真实相关特征,形成了明确定义的簇,揭示了数据集的固有结构。 |

| MosaicBERT: A Bidirectional Encoder Optimized for Fast Pretraining Authors Jacob Portes, Alex Trott, Sam Havens, Daniel King, Abhinav Venigalla, Moin Nadeem, Nikhil Sardana, Daya Khudia, Jonathan Frankle 尽管 BERT 风格的编码器模型在 NLP 研究中大量使用,但由于训练成本高昂,许多研究人员并没有从头开始预训练自己的 BERT。自 BERT 首次崭露头角以来的过去五年里,其他 Transformer 架构和训练配置已经取得了许多进步,但尚未系统地纳入 BERT 中。在这里,我们介绍 MosaicBERT,一种 BERT 风格的编码器架构和训练方法,它针对快速预训练进行了经验优化。这种高效的架构将 FlashAttention、具有线性偏差的 Attention ALiBi、门控线性单元 GLU、动态删除填充令牌的模块以及低精度 LayerNorm 整合到经典的 Transformer 编码器块中。除了 RoBERTa 和其他编码器模型的最佳实践之外,训练配方还包括掩蔽语言建模 MLM 目标的 30 掩蔽比、bfloat16 精度和针对 GPU 吞吐量优化的词汇量。当在 C4 数据集上从头开始进行预训练时,该基本模型在 8 个 A100 80 GB GPU 上花费大约 20 的成本,在 1.13 小时内达到了 79.6 的下游平均 GLUE 开发分数。我们绘制了广泛的准确性与预训练速度的 Pareto 曲线,并表明:与竞争性 BERT 基础和大型相比,MosaicBERT 基础和大型始终是帕累托最优。这种预训练的经验加速使研究人员和工程师能够以低成本预训练自定义 BERT 风格模型,而不是对现有通用模型进行微调。 |

| Exploring the Sensitivity of LLMs' Decision-Making Capabilities: Insights from Prompt Variation and Hyperparameters Authors Manikanta Loya, Divya Anand Sinha, Richard Futrell 大型语言模型法学硕士的进步使其在包括决策在内的广泛任务中得到广泛使用。之前的研究从心理学角度比较了法学硕士和人类的决策能力。然而,这些研究并不总能正确解释法学硕士行为对超参数和提示变化的敏感性。在这项研究中,我们检查了法学硕士在 Binz 和 Schulz 2023 研究的 Horizon 决策任务中的表现,分析了法学硕士如何响应提示和超参数的变化。通过对三种具有不同能力的 OpenAI 语言模型进行实验,我们观察到决策能力会根据输入提示和温度设置而波动。 |

| EHR Interaction Between Patients and AI: NoteAid EHR Interaction Authors Xiaocheng Zhang, Zonghai Yao, Hong Yu 随着大型语言模型法学硕士的快速发展及其在语义和语境理解方面的出色表现,法学硕士在专业领域的潜力值得探索。本文介绍了 NoteAid EHR 交互管道,这是一种使用生成法学硕士开发的创新方法,用于协助患者教育,这项任务源于帮助患者理解电子健康记录 EHR 的需要。在 NoteAid 工作的基础上,我们从患者的角度设计了两项新颖的任务,为患者可能不理解的 EHR 内容提供解释,并回答患者在阅读 EHR 后提出的问题。我们分别从 MIMIC 出院摘要中提取了包含 10,000 个实例的数据集,从 MADE 医疗笔记集合中提取了 876 个实例,并通过 NoteAid EHR 交互管道使用这些数据执行这两个任务。收集了法学硕士在这些任务上的表现数据,并将其构建为相应的 NoteAid EHR 交互数据集。通过使用法学硕士评估对整个数据集进行全面评估以及对 64 个实例进行严格的手动评估,我们展示了法学硕士在患者教育方面的潜力。 |

| Language Model as an Annotator: Unsupervised Context-aware Quality Phrase Generation Authors Zhihao Zhang, Yuan Zuo, Chenghua Lin, Junjie Wu 短语挖掘是一项基本的文本挖掘任务,旨在从上下文中识别优质短语。然而,由于缺乏广泛的金标签数据集,需要专家进行大量注释工作,使得这项任务异常具有挑战性。此外,质量短语的新兴、罕见和领域特定性质给处理这项任务带来了进一步的挑战。在本文中,我们提出了 LMPhrase,这是一种基于大型预训练语言模型 LM 构建的新颖的无监督上下文感知质量短语挖掘框架。具体来说,我们首先通过在预训练的语言模型 BERT(称为 Annotator)上采用称为 Perturbed Masking 的无参数探测技术来挖掘质量短语作为银标签。与典型的基于统计或远程监督的方法相比,我们的银标签源自大型预训练语言模型,考虑了 LM 中包含的丰富上下文信息。因此,它们在保留优质短语的信息性、一致性和完整性方面具有明显的优势。其次,训练判别跨度预测模型严重依赖于海量标注数据,很可能面临过度拟合银标签的风险。或者,我们通过直接对 Sequence to Sequence 预训练语言模型 BART 进行微调,将短语标记任务形式化为序列生成问题,银标签被称为 Generator 。最后,考虑到它们的互补性和独特特征,我们将来自注释器和生成器的质量短语合并为最终预测。 |

| AQUALLM: Audio Question Answering Data Generation Using Large Language Models Authors Swarup Ranjan Behera, Krishna Mohan Injeti, Jaya Sai Kiran Patibandla, Praveen Kumar Pokala, Balakrishna Reddy Pailla 音频问答 AQA 是一项关键任务,其中机器分析音频信号和自然语言问题以产生精确的自然语言答案。当追求 AQA 系统的精度时,拥有高质量、多样化和广泛的 AQA 数据集的重要性怎么强调也不为过。虽然开发准确、高效的 AQA 模型一直受到人们的关注,但为手头的特定任务创建高质量、多样化和广泛的数据集并没有引起足够的关注。为了应对这一挑战,这项工作做出了多项贡献。我们引入了一个可扩展的 AQA 数据生成管道,称为 AQUALLM 框架,它依赖于大型语言模型 LLM。该框架利用现有的音频字幕注释并结合最先进的法学硕士来生成广泛的高质量 AQA 数据集。此外,我们还提供了三个广泛且高质量的 AQA 基准数据集,为 AQA 研究的进展做出了重大贡献。与现有技术相比,在所提出的数据集上训练的 AQA 模型设定了卓越的基准。此外,与使用人类注释的 AQA 数据训练的模型相比,在我们的数据集上训练的模型表现出增强的通用性。 |

| Exploring Nature: Datasets and Models for Analyzing Nature-Related Disclosures Authors Tobias Schimanski, Chiara Colesanti Senni, Glen Gostlow, Jingwei Ni, Tingyu Yu, Markus Leippold 自然是一个无定形的概念。然而,为了地球的福祉,了解经济如何与其相互作用至关重要。为了满足对企业性质披露信息日益增长的需求,我们提供数据集和分类器来检测公司的性质沟通。我们的方法以自然相关财务披露 TNFD 工作组的指导方针为基础。我们特别关注水、森林和生物多样性的具体维度。对于每个维度,我们创建一个包含 2,200 个文本样本的专家注释数据集并训练分类器模型。此外,我们发现自然传播在热点地区更为普遍,并直接影响农业和公用事业等行业。 |

| Structured Packing in LLM Training Improves Long Context Utilization Authors Konrad Staniszewski, Szymon Tworkowski, Sebastian Jaszczur, Henryk Michalewski, ukasz Kuci ski, Piotr Mi o 长上下文大语言模型 LCLM 的最新进展引起了人们的极大兴趣,特别是在查询科学研究论文等应用中。然而,它们的潜力常常受到上下文利用不足的限制。我们认为典型训练数据中缺乏长期语义依赖性是主要障碍。为了解决这个问题,我们深入研究了经常将相关文档纳入培训输入的好处。使用代码数据的固有目录结构作为训练示例的来源,我们展示了困惑度的改进,即使对于与编码无关的任务也是如此。基于这些发现,但有了更广泛的关注点,我们引入了针对长上下文 SPLiCe 的结构化包装。 SPLiCe 是一种创建培训示例的创新方法,通过使用检索方法将最相互相关的文档整理到单个培训上下文中。我们的结果表明该方法增强了模型性能,并且可用于训练大型模型以更好地利用长上下文。 |

| Effect of dimensionality change on the bias of word embeddings Authors Rohit Raj Rai, Amit Awekar 词嵌入方法 WEM 广泛用于表示文本数据。这些嵌入的维度因不同的任务和实现而异。维度变化对下游任务准确性的影响是一个经过充分探讨的问题。然而,维度变化如何影响词嵌入的偏差还需要研究。使用英语维基百科语料库,我们研究了两个静态 Word2Vec 和 fastText 以及两个上下文敏感的 ElMo 和 BERT WEM 的这种效果。我们有两个观察结果。首先,随着维度的变化,词嵌入的偏差存在显着变化。其次,维度变化对词嵌入偏差的影响并不统一。 |

| AI Content Self-Detection for Transformer-based Large Language Models Authors Ant nio Junior Alves Caiado, Michael Hahsler 使用基于大型语言模型的生成人工智能 AI 工具(包括 ChatGPT、Bard 和 Claude)进行文本生成有许多令人兴奋的应用,有可能显着提高生产力。使用人工智能工具时的一个问题是作者归属。这在学术环境中尤其重要,因为生成式人工智能工具的不当使用可能会通过创建大量自动生成的衍生作品来阻碍学生学习或扼杀研究。现有的抄袭检测系统可以追踪提交文本的来源,但尚未配备准确检测人工智能生成文本的方法。本文介绍了直接起源检测的想法,并评估生成式人工智能系统是否能够识别其输出并将其与人类书写文本区分开来。我们讨论为什么基于电流互感器的模型能够自我检测自己生成的文本,并使用零样本学习进行小型实证研究来调查是否是这种情况。结果揭示了人工智能系统识别其生成文本的不同能力。 Google 的 Bard 模型展示了最大的自我检测能力,准确度为 94 ,其次是 OpenAI 的 ChatGPT ,准确度为 83 。 |

| Stateful FastConformer with Cache-based Inference for Streaming Automatic Speech Recognition Authors Vahid Noroozi, Somshubra Majumdar, Ankur Kumar, Jagadeesh Balam, Boris Ginsburg 在本文中,我们提出了一种基于 FastConformer 架构的高效且准确的流式语音识别模型。我们通过 1 限制编码器中的前瞻和过去上下文,2 引入激活缓存机制以使非自回归编码器能够在推理期间自回归操作,从而针对流应用程序调整了 FastConformer 架构。所提出的模型经过精心设计,旨在消除训练时间和推理时间之间的精度差异,这对于许多流模型来说很常见。此外,我们提出的编码器可与各种解码器配置配合使用,包括连接主义时间分类 CTC 和 RNN Transducer RNNT 解码器。此外,我们引入了一种混合 CTC RNNT 架构,该架构利用带有 CTC 和 RNNT 解码器的共享编码器来提高准确性并节省计算量。我们在 LibriSpeech 数据集和多域大规模数据集上评估了所提出的模型,并证明与传统的缓冲流模型基线相比,它可以以更低的延迟和推理时间实现更高的准确性。我们还表明,训练具有多个延迟的模型可以比单个延迟模型获得更好的准确性,同时它使我们能够使用单个模型支持多个延迟。 |

| Large Language Models for Conducting Advanced Text Analytics Information Systems Research Authors Benjamin M. Ampel, Chi Heng Yang, James Hu, Hsinchun Chen 数字内容的指数增长产生了大量文本数据集,需要先进的分析方法。大型语言模型法学硕士已经成为能够处理大量非结构化文本数据集并从中提取见解的工具。然而,目前尚不清楚如何利用法学硕士进行基于文本的信息系统信息系统研究。为了帮助信息系统研究了解如何实施法学硕士,我们提出了信息系统研究文本分析 TAISR 框架。我们提出的框架提供了基于信息系统和法学硕士文献的详细建议,涉及如何进行基于有意义的文本的信息系统研究。我们使用 TAISR 框架进行了三个商业智能案例研究,以展示其在多个 IS 研究环境中的应用。我们还概述了采用法学硕士进行 IS 的潜在挑战和限制。 |

| PanGu-$π$: Enhancing Language Model Architectures via Nonlinearity Compensation Authors Yunhe Wang, Hanting Chen, Yehui Tang, Tianyu Guo, Kai Han, Ying Nie, Xutao Wang, Hailin Hu, Zheyuan Bai, Yun Wang, Fangcheng Liu, Zhicheng Liu, Jianyuan Guo, Sinan Zeng, Yinchen Zhang, Qinghua Xu, Qun Liu, Jun Yao, Chao Xu, Dacheng Tao 大型语言模型LLM的最新趋势是增加模型大小(即参数数量和数据集)的规模,以实现更好的生成能力,这已经被著名的GPT和Llama等大量工作所证明。然而,大型模型往往涉及大量的计算成本,实际应用无法承受如此高的价格。然而,为法学硕士构建强大的模型架构的方法却很少被讨论。我们首先分析最先进的语言模型架构并观察特征崩溃问题。基于理论分析,我们提出非线性对于语言模型也非常重要,这通常在视觉任务的卷积神经网络中进行研究。然后引入级数通知激活函数以及可以忽略的微小计算,并进一步使用增强的快捷方式来增强模型的非线性。然后,我们证明所提出的方法通过精心设计的消融对于增强模型非线性非常有效,因此,我们提出了一种新的有效模型架构来建立现代模型,即 PanGu pi 。然后使用相同的数据集和训练策略进行实验,将 PanGu pi 与最先进的法学硕士进行比较。结果表明,PanGu pi 7B 可以实现与基准测试相当的性能,推理速度提升约 10 倍,而 PanGu pi 1B 在准确性和效率方面可以实现最先进的性能。此外,我们还在金融和法律等高价值领域部署了PanGu pi 7B,开发了名为云山的法学硕士以供实际应用。 |

| Conversational Question Answering with Reformulations over Knowledge Graph Authors Lihui Liu, Blaine Hill, Boxin Du, Fei Wang, Hanghang Tong 基于知识图谱知识图谱的对话问答 convQA 涉及回答有关知识图谱中包含的信息的多轮自然语言问题。最先进的 ConvQA 方法经常会遇到不明确的问题答案对。考虑到对话历史,这些输入很容易被人类理解,但机器很难解释,这会降低 ConvQA 的性能。为了解决这个问题,我们提出了一种基于强化学习的模型 CornNet,它利用大型语言模型 LLM 生成的问题重新表述来提高 ConvQA 性能。 CornNet 采用教师学生架构,其中教师模型使用人类书写重构来学习问题表示,而学生模型则通过法学硕士生成的重构来模仿教师模型的输出。然后,强化学习模型使用学习到的问题表示来在知识图谱中找到正确答案。 |

| Improving Low-resource Prompt-based Relation Representation with Multi-view Decoupling Learning Authors Chenghao Fan, Wei Wei, Xiaoye Qu, Zhenyi Lu, Wenfeng Xie, Yu Cheng, Dangyang Chen 最近,使用预先训练的语言模型 PLM 进行即时调整已经证明了关系提取 RE 任务的能力得到了显着增强。然而,在资源匮乏的情况下,可用的训练数据稀缺,由于对关系的肤浅理解,以前的基于提示的方法对于基于提示的表示学习可能仍然表现不佳。为此,我们强调了在 RE 的资源匮乏的情况下学习高质量关系表示的重要性,并提出了一种新颖的基于提示的关系表示方法,名为 MVRE underline M ulti underline View underline Relation underline E xtraction ,以更好地利用PLM 在低资源提示调整范例中提高 RE 性能的能力。具体来说,MVRE 将每个关系解耦为不同的视角,以包含多视图关系表示,以最大化关系推理过程中的可能性。此外,我们还设计了全局局部损失和动态初始化方法,以更好地对齐表示虚拟单词的多视图关系,在优化学习过程和初始化过程中包含关系标签的语义。 |

| ESGReveal: An LLM-based approach for extracting structured data from ESG reports Authors Yi Zou, Mengying Shi, Zhongjie Chen, Zhu Deng, ZongXiong Lei, Zihan Zeng, Shiming Yang, HongXiang Tong, Lei Xiao, Wenwen Zhou ESGReveal 是一种创新方法,旨在从企业报告中高效提取和分析环境、社会和治理 ESG 数据,满足可靠 ESG 信息检索的关键需求。该方法利用通过检索增强生成 RAG 技术增强的大型语言模型 LLM。 ESGReveal系统包括用于目标查询的ESG元数据模块、用于组装数据库的预处理模块以及用于数据提取的LLM代理。其有效性采用2022年在香港联交所上市的166家各行业公司的ESG报告进行评估,确保了全面的行业和市值代表性。利用 ESGReveal 通过 GPT 4 挖掘出对 ESG 报告的重要见解,数据提取的准确性为 76.9,披露分析的准确性为 83.7,这比基线模型有所改进。这凸显了该框架提高 ESG 数据分析精度的能力。此外,还揭示了加强ESG披露的需求,环境和社会数据披露分别为69.5和57.2,表明企业追求更高的透明度。虽然 ESGReveal 的当前迭代不处理图形信息(该功能旨在未来增强),但该研究呼吁继续研究以进一步开发和比较各种法学硕士的分析能力。总之,ESGReveal 是 ESG 数据处理方面的一大进步,为利益相关者提供了一个复杂的工具,以更好地评估和推进企业可持续发展工作。 |

| TACIT: A Target-Agnostic Feature Disentanglement Framework for Cross-Domain Text Classification Authors Rui Song, Fausto Giunchiglia, Yingji Li, Mingjie Tian, Hao Xu 跨域文本分类旨在将模型从标签丰富的源域转移到标签贫乏的目标域,从而赋予其广泛的实际应用。许多方法通过捕获域不变特征来促进跨域泛化。然而,这些方法依赖于目标域提供的未标记样本,这使得当目标域不可知时模型无效。此外,模型很容易受到源域中快捷学习的干扰,这也阻碍了域泛化能力的提高。为了解决上述问题,本文提出了TACIT,一种与目标域无关的特征解耦框架,它通过变分自动编码器自适应地解耦鲁棒和不鲁棒的特征。此外,为了鼓励将不稳健的特征与稳健的特征分离,我们设计了一个特征蒸馏任务,迫使不稳健的特征逼近教师的输出。教师模型使用一些简单的样本进行训练,这些样本很容易携带潜在的未知捷径。 |

| Multimodal Classification of Teaching Activities from University Lecture Recordings Authors Oscar Sapena, Eva Onaindia 由于全球疫情的影响,人们对在线高等教育的理解方式发生了很大的变化。教学是远程进行的,教师将讲座录音作为教材的一部分。这种新的在线教学环境在很大程度上影响了大学课程。虽然过去两年丰富虚拟课堂的在线教学技术已经很丰富,但在支持学生在线学习方面却还没有出现同样的情况。为了克服这一限制,我们的目标是努力使学生能够轻松访问教师解释理论概念、解决练习或对课程组织问题进行评论的课程录音。为此,我们提出了一种多模式分类算法,该算法通过使用基于变压器的语言模型来识别在课程中的任何时间进行的活动类型,该语言模型利用音频文件和自动讲座转录中的特征。实验结果将表明,一些学术活动通过音频信号更容易识别,而其他学术活动则需要借助文本转录来识别。 |

| Empowering Working Memory for Large Language Model Agents Authors Jing Guo, Nan Li, Jianchuan Qi, Hang Yang, Ruiqiao Li, Yuzhen Feng, Si Zhang, Ming Xu 大型语言模型 法学硕士已经取得了令人印象深刻的语言能力。然而,一个关键的限制仍然存在,即它们缺乏类似人类的记忆能力。法学硕士在顺序交互中表现出有限的记忆保留,阻碍了复杂的推理。本文探讨了应用认知心理学工作记忆框架来增强法学硕士架构的潜力。分析了传统 LLM 内存设计的局限性,包括不同对话片段的隔离以及缺乏持久内存链接。为了解决这个问题,提出了一种创新模型,结合了集中式工作记忆中心和情节缓冲区访问来保留跨情节的记忆。该架构旨在在复杂的任务和协作场景中为细致入微的上下文推理提供更大的连续性。虽然前景广阔,但还需要进一步研究来优化情景记忆编码、存储、优先级、检索和安全性。 |

| Evolving Large Language Model Assistant with Long-Term Conditional Memory Authors Ruifeng Yuan, Shichao Sun, Zili Wang, Ziqiang Cao, Wenjie Li 随着大语言模型的快速发展,像ChatGPT这样的AI助手已经广泛进入人们的工作和生活。在本文中,我们提出了一种不断发展的大型语言模型助手,它利用言语长期记忆。它的重点是保存用户和人工智能助手之间历史对话中的知识和经验,这些知识和经验可以应用于未来的对话以产生更好的响应。该模型为每个完成的对话生成一组记录并将其存储在内存中。在以后的使用中,给定新的用户输入,模型使用它来检索其相关的内存以提高响应的质量。为了找到最佳的记忆形式,我们探索了构建记忆的不同方式,并提出了一种称为条件记忆的新记忆机制来解决先前方法中的问题。我们还研究了生成过程中记忆的检索和使用。 |

| From Bytes to Biases: Investigating the Cultural Self-Perception of Large Language Models Authors Wolfgang Messner, Tatum Greene, Josephine Matalone 大型语言模型法学硕士能够与人类进行自然的对话,展示出前所未有的信息检索和自动决策支持能力。它们扰乱了人类技术交互和企业运营方式。然而,众所周知,基于生成人工智能 GenAI 的技术会产生幻觉、误导和显示由训练它们的海量数据集带来的偏差。现有研究表明,人类可能会无意识地内化这些偏见,即使在他们停止使用这些程序后,这些偏见也可能持续存在。本研究通过向 ChatGPT OpenAI 和 Bard Google 提出源自 GLOBE 项目的价值问题,探讨了法学硕士的文化自我认知。调查结果显示,他们的文化自我认知与英语国家和以持续经济竞争力为特征的国家的价值观最为一致。 |

| Faithful Model Evaluation for Model-Based Metrics Authors Palash Goyal, Qian Hu, Rahul Gupta 统计显着性测试用于自然语言处理 NLP 中,以确定研究或实验的结果是否可能是偶然的,或者是否反映了真实的关系。显着性检验的关键步骤是估计置信区间,它是样本方差的函数。根据地面实况进行评估时,样本方差计算非常简单。然而,在许多情况下,常常使用度量模型来进行评估。例如,为了比较两个大型语言模型的毒性,使用毒性分类器进行评估。现有的工作通常不考虑度量模型误差导致的方差变化,这可能导致错误的结论。在这项工作中,我们为基于模型的指标建立了显着性测试的数学基础。 |

| Deep Learning-based Sentiment Classification: A Comparative Survey Authors Mohamed Kayed, Rebeca P. D az Redondo, Alhassan Mabrouk 最近,深度学习 DL 方法已被应用于解决情感分类 SC 问题,这是评论挖掘或情感分析 SA 的核心任务。这些方法的性能受到不同因素的影响。本文讨论了这些因素,并将它们分为三类:基于数据准备的因素、基于特征表示的因素和基于分类技术的因素。该论文是一项基于文献的综合调查,通过使用产品、电影和餐馆三个特定应用领域中客户给出的评论的 21 个公共数据集,比较了 100 多种基于 DL 的 SC 方法的性能。这 21 个数据集具有平衡、不平衡、大小等不同的特征,为我们的研究提供了全球视野。 |

| Jatmo: Prompt Injection Defense by Task-Specific Finetuning Authors Julien Piet, Maha Alrashed, Chawin Sitawarin, Sizhe Chen, Zeming Wei, Elizabeth Sun, Basel Alomair, David Wagner 大型语言模型法学硕士因其指令跟踪能力而吸引了广泛的研究关注,允许用户和开发人员利用法学硕士来完成各种任务。然而,LLM 很容易受到提示注入攻击,这种攻击会劫持模型的指令跟踪能力,将对提示的响应更改为不需要的、可能是恶意的。在这项工作中,我们介绍了 Jatmo,一种生成能够抵御注入攻击的任务特定模型的方法。 Jatmo 利用了这样一个事实:法学硕士只有在经过指令调整后才能遵循指令。它利用教师指令调整模型来生成特定于任务的数据集,然后使用该数据集来微调基本模型,即非指令调整模型。 Jatmo 只需要一个任务提示和一个任务输入数据集,它使用教师模型来生成输出。对于没有预先存在的数据集的情况,Jatmo 可以使用单个示例,或者在某些情况下根本不使用示例,来生成完全合成的数据集。我们对六项任务的实验表明,Jatmo 模型在其特定任务上提供了与标准 LLM 相同的输出质量,同时对即时注入具有弹性。针对我们模型的最佳攻击成功率不到 0.5,而针对 GPT 3.5 Turbo 的成功率超过 90。 |

| Research on the Laws of Multimodal Perception and Cognition from a Cross-cultural Perspective -- Taking Overseas Chinese Gardens as an Example Authors Ran Chen, Xueqi Yao, Jing Zhao, Shuhan Xu, Sirui Zhang, Yijun Mao 本研究旨在探讨多模态数据分析中感知和认知交互之间的复杂关系,特别关注海外中国园林的空间体验设计。研究发现,社交媒体上的评价内容和图像可以反映个人的关注点和情感反应,为认知研究提供丰富的数据基础,其中包含基于情感和基于图像的认知信息。利用深度学习技术,我们分析来自社交媒体的文本和视觉数据,从而揭示海外中国园林背景下人们的感知和情感认知之间的关系。此外,我们的研究还引入了多代理系统 MAS 和 AI 代理。每个智能体通过聊天场景模拟结合网络搜索来探索审美认知的规律。这项研究超越了将看法转化为情绪分数的传统方法,允许在直接分析文本和深入挖掘意见数据方面扩展研究方法。 |

| Olapa-MCoT: Enhancing the Chinese Mathematical Reasoning Capability of LLMs Authors Shaojie Zhu, Zhaobin Wang, Chengxiang Zhuo, Hui Lu, Bo Hu, Zang Li CoT Chain of Thought 是法学硕士解决推理问题的一种方法。最近,出现了许多关于提高法学硕士CoT能力的研究。在这项工作中,我们还提出了 Olapa MCoT,这是一个基于 llama2 13B PLM 的 LLM,用于微调和对齐学习。在比对训练中,我们提出了SimRRHF算法和In Correct Data Relearning,主要针对优化Olapa MCoT的中文数学推理能力。实验取得了显著成果,中文数学推理准确率达到50%,比llama2 13B提高了36%。 |

| Leveraging Open-Vocabulary Diffusion to Camouflaged Instance Segmentation Authors Tuan Anh Vu, Duc Thanh Nguyen, Qing Guo, Binh Son Hua, Nhat Minh Chung, Ivor W. Tsang, Sai Kit Yeung 文本到图像扩散技术已显示出从文本描述生成高质量图像的卓越能力。这表明视觉领域和文本领域之间存在很强的相关性。此外,由于开放概念提供了丰富多样的信息,诸如 CLIP 之类的文本图像判别模型在文本提示的图像标记方面表现出色。在本文中,我们利用这些技术进步来解决计算机视觉伪装实例分割中的挑战性问题。具体来说,我们提出了一种基于最先进的扩散模型的方法,通过开放词汇来学习伪装对象表示的多尺度文本视觉特征。这种跨域表示在分割伪装对象时是理想的,其中视觉线索很微妙,无法将对象与背景区分开来,特别是在分割训练中看不到的新对象时。我们还开发了技术支持组件,以有效地融合跨域特征并将相关特征引入到各自的前景对象中。我们验证了我们的方法,并将其与伪装实例分割和通用开放词汇实例分割的几个基准数据集上的现有方法进行比较。实验结果证实了我们的方法相对于现有方法的进步。 |

| Video Understanding with Large Language Models: A Survey Authors Yunlong Tang, Jing Bi, Siting Xu, Luchuan Song, Susan Liang, Teng Wang, Daoan Zhang, Jie An, Jingyang Lin, Rongyi Zhu, Ali Vosoughi, Chao Huang, Zeliang Zhang, Feng Zheng, Jianguo Zhang, Ping Luo, Jiebo Luo, Chenliang Xu 随着在线视频平台的蓬勃发展和视频内容量的不断增加,对熟练的视频理解工具的需求显着增强。由于大型语言模型法学硕士在关键语言任务中展示了卓越的能力,这项调查详细概述了利用法学硕士 Vid LLM 的力量在视频理解方面的最新进展。 Vid LLM 的新兴能力令人惊讶地先进,特别是它们的开放式时空推理与常识知识相结合的能力,为未来视频理解提供了一条有希望的道路。我们研究了 Vid LLM 的独特特征和功能,将这些方法分为四种主要类型:基于 LLM 的视频代理、Vid LLM 预训练、Vid LLM 指令调整和混合方法。此外,这项调查还对 Vid LLM 的任务和数据集以及评估所采用的方法进行了全面研究。此外,该调查还探讨了 Vid LLM 在各个领域的广泛应用,从而展示了其在应对现实世界视频理解挑战方面的卓越可扩展性和多功能性。最后,调查总结了现有 Vid LLM 的局限性以及未来研究的方向。 |

| Commonsense for Zero-Shot Natural Language Video Localization Authors Meghana Holla, Ismini Lourentzou 零样本自然语言视频定位 NLVL 方法通过动态生成视频片段和伪查询注释,仅使用原始视频数据训练 NLVL 模型,取得了可喜的成果。然而,现有的伪查询通常缺乏源视频的基础,导致内容非结构化且脱节。在本文中,我们研究了零样本 NLVL 中常识推理的有效性。具体来说,我们提出了 CORONET,这是一个零样本 NLVL 框架,它利用常识来弥合视频与通过常识增强模块生成的伪查询之间的差距。 CORONET 采用图卷积网络 GCN 对从知识图谱中提取的常识信息进行编码,以视频为条件,并采用交叉注意机制来在定位之前增强编码视频和伪查询表示。通过对两个基准数据集的实证评估,我们证明 CORONET 超越了零样本和弱监督基线,在各种召回阈值上实现了高达 32.13 的改进,在 mIoU 中实现了高达 6.33 的改进。 |

| SentinelLMs: Encrypted Input Adaptation and Fine-tuning of Language Models for Private and Secure Inference Authors Abhijit Mishra, Mingda Li, Soham Deo 本文解决了与深度神经语言模型相关的隐私和安全问题,深度神经语言模型是各种现代人工智能应用程序的关键组成部分。这些模型通常在针对特定任务进行预训练和微调后使用,并部署在通过互联网访问的服务器上。然而,这引入了两个基本风险:a 通过网络将用户输入传输到服务器会导致拦截漏洞;b 由于部署此类模型的组织在受限上下文中存储用户数据,因此出现了隐私问题。为了解决这个问题,我们提出了一种新方法,可以在密钥加密的用户特定文本上调整和微调基于变压器的语言模型。原始的预训练语言模型首先经历快速适应,无需任何进一步的预训练,并对标记器和标记嵌入应用一系列不可逆的转换。这使得模型能够对加密输入进行推理,同时防止根据模型参数和中间输出对文本进行逆向工程。适应后,模型在现有训练数据集的加密版本上进行微调。使用 BERT、RoBERTa 等著名模型的改编版本在已建立的基准英语和多语言数据集上进行文本分类和序列标记的实验评估表明,加密模型的性能与原始模型相当。 |

| Optimizing watermarks for large language models Authors Bram Wouters 随着大型语言模型法学硕士的兴起以及对潜在滥用的担忧,生成法学硕士的水印最近引起了广泛关注。此类水印的一个重要方面是在其可识别性和对生成文本质量的影响之间进行权衡。本文介绍了一种针对多目标优化问题进行权衡的系统方法。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com

![[蓝桥杯学习] 树状树组](https://img-blog.csdnimg.cn/direct/87320cdefb174632afc24ce6d076185b.png)

![[C#]yolov8-onnx在winform部署手势识别模型](https://img-blog.csdnimg.cn/direct/1261a96a076b46f18162bcfb81ea3b58.jpeg)