当设计一个结合了 YOLOv5 目标检测、单目测距与速度测量以及 PyQt 界面的毕业设计时,需要考虑以下几个方面的具体细节:

计算机视觉、图像处理、毕业辅导、作业帮助、代码获取,私聊会回复!

-

YOLOv5 目标检测:

- 首先,选择合适的 YOLOv5 模型(如 YOLOv5s、YOLOv5m、YOLOv5l 或 YOLOv5x)以满足项目需求,权衡模型大小和性能之间的平衡。

- 进行目标类别的标注和数据集的准备,确保训练数据的质量和多样性,以提高检测准确度。

- 考虑实时性要求,优化模型推理速度,可以使用 ONNX 进行模型转换和加速,或者利用 TensorRT 进行模型部署和优化。

-

单目测距与速度测量:

- 实现单目测距功能时,可以利用物体在图像中的大小和相机内参进行距离估计,也可结合深度学习技术进行深度估计。

- 速度测量可以通过目标在连续帧之间的位移来计算,也可以借助光流法等技术实现运动速度的测量。

- 考虑误差分析和校正方法,确保测距和测速的准确性和稳定性,例如引入卡尔曼滤波器进行数据融合处理。

-

PyQt 界面设计:

- 设计直观友好的用户界面,包括主界面、设置界面、结果展示界面等,使用户能够方便地进行操作和查看结果。

- 添加交互功能,如实时显示检测结果、测距信息和速度信息,支持用户交互式操作,提升用户体验和系统的易用性。

- 考虑美观性和响应速度,选择合适的布局、颜色和字体,优化界面加载速度,确保界面流畅和用户友好。

在 PyQt 中,可以利用 OpenCV 库来实现图片、视频和摄像头的输入,具体方法如下:

-

图片输入:

- 加载图片文件:使用 OpenCV 的 imread 函数,将图片文件读入到内存中,返回一个 numpy 数组类型的图片对象。

#qq-1309399183 import cv2 img = cv2.imread("image.jpg") - 在 PyQt 界面中显示图片:使用 PyQt 的 QLabel 组件,通过 setPixmap 方法将 OpenCV 读取的图片对象转换成 QPixmap 对象,并设置为标签的图像。

from PyQt5.QtGui import QPixmap from PyQt5.QtWidgets import QLabel, QApplication import sysapp = QApplication(sys.argv) label = QLabel() pixmap = QPixmap.fromImage(img.data, img.shape[1], img.shape[0], QImage.Format_RGB888) label.setPixmap(pixmap) label.show() sys.exit(app.exec_())

- 加载图片文件:使用 OpenCV 的 imread 函数,将图片文件读入到内存中,返回一个 numpy 数组类型的图片对象。

-

视频输入:

- 打开本地视频文件:使用 OpenCV 的 VideoCapture 函数,打开本地视频文件,创建一个视频捕捉对象。

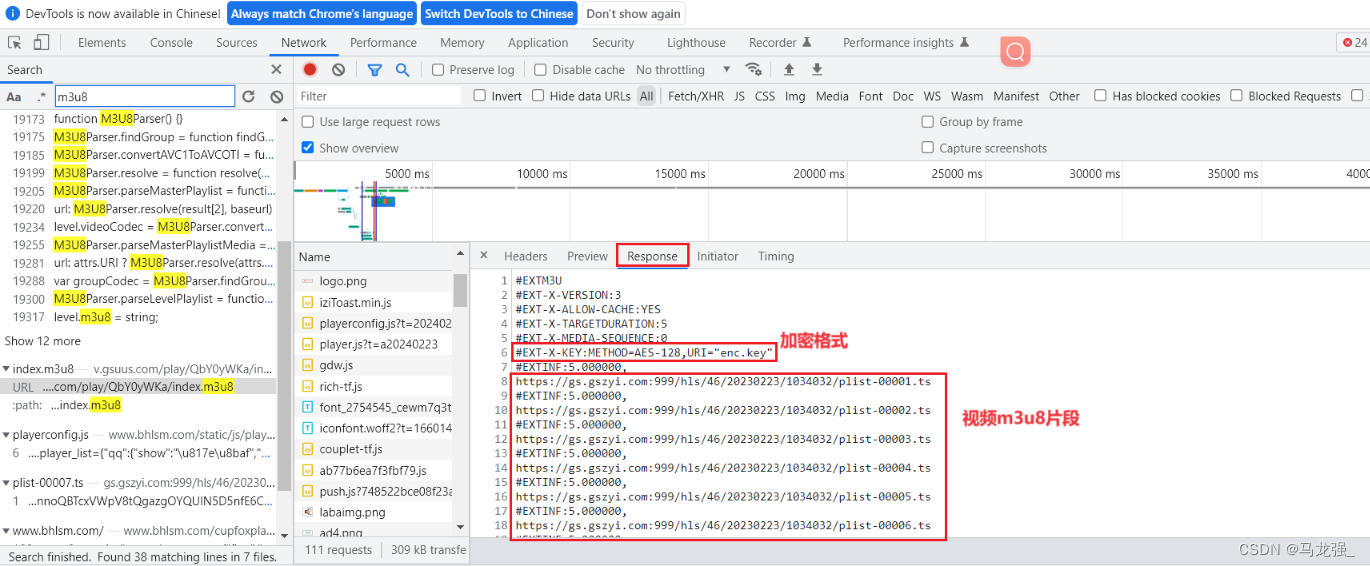

import cv2 cap = cv2.VideoCapture("video.avi") - 打开网络视频流:同样使用 VideoCapture 函数,传入视频流的 URL 地址即可打开网络视频流。

import cv2 cap = cv2.VideoCapture("http://xxx.xxx.xxx.xxx:xxxx/xxx.m3u8") - 在 PyQt 界面中显示视频:使用 OpenCV 的 imshow 函数循环读取视频帧并在界面中展示,需要注意的是需要使用 PyQt 的方法将 OpenCV 的图像类型转换为 QImage 类型。

from PyQt5.QtGui import QImage import syswhile True:ret, frame = cap.read()if not ret:breakimg = QImage(frame.data, frame.shape[1], frame.shape[0], QImage.Format_RGB888)label.setPixmap(QPixmap.fromImage(img))QApplication.processEvents()

- 打开本地视频文件:使用 OpenCV 的 VideoCapture 函数,打开本地视频文件,创建一个视频捕捉对象。

-

摄像头输入:

- 打开摄像头:同样使用 OpenCV 的 VideoCapture 函数,传入摄像头的索引号即可打开摄像头。

import cv2 cap = cv2.VideoCapture(0) - 在 PyQt 界面中显示摄像头视频:和视频输入类似,不同的是需要通过 QTimer 定时器来触发读取摄像头帧数并在界面中展示。

from PyQt5.QtCore import QTimer import sysdef update():ret, frame = cap.read()if not ret:returnimg = QImage(frame.data, frame.shape[1], frame.shape[0], QImage.Format_RGB888)label.setPixmap(QPixmap.fromImage(img))timer = QTimer() timer.timeout.connect(update) timer.start(1000 // 30) app.exec_()

- 打开摄像头:同样使用 OpenCV 的 VideoCapture 函数,传入摄像头的索引号即可打开摄像头。

-

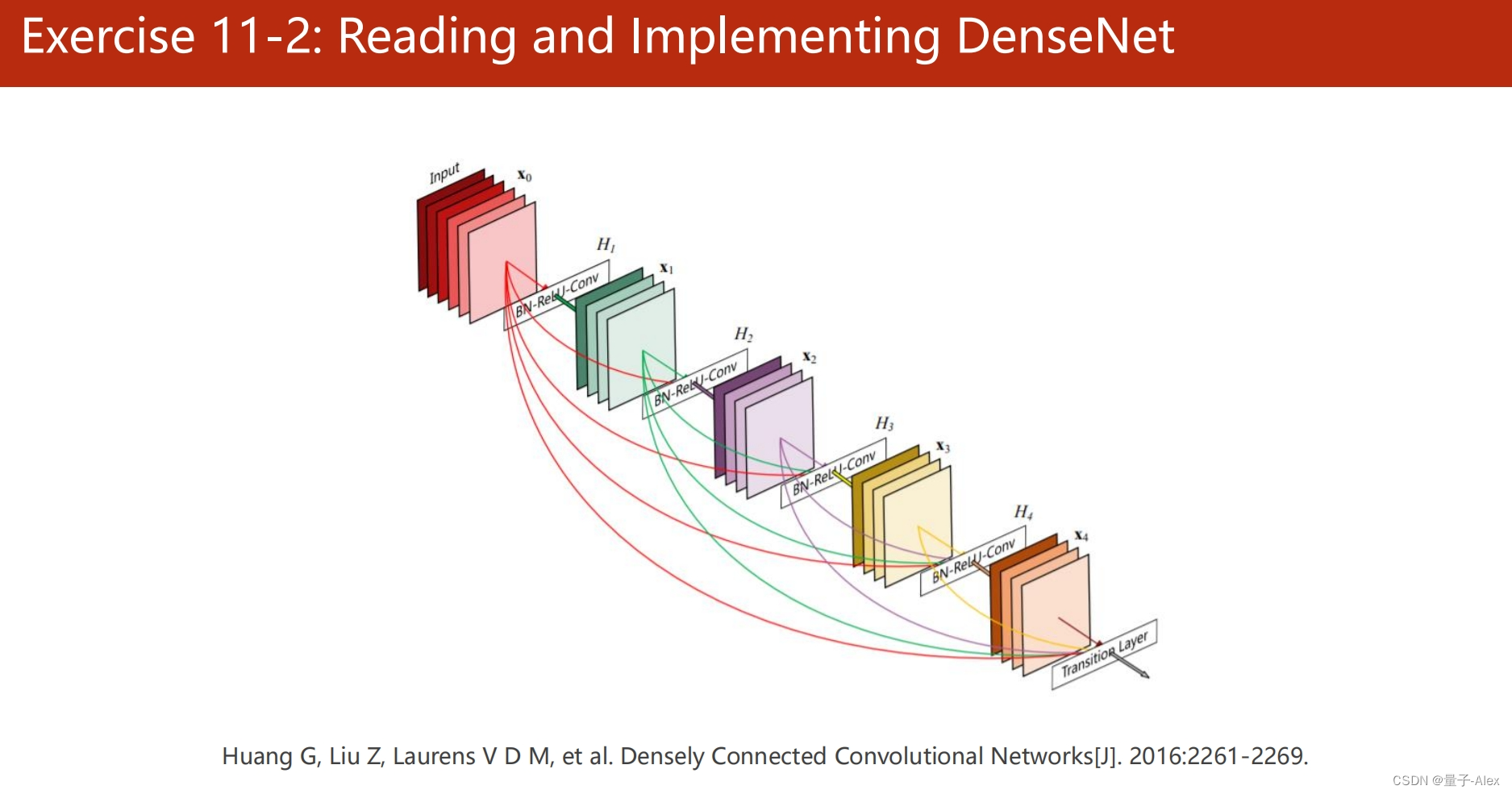

YOLOv5 改进:

- 可以尝试引入注意力机制、跨尺度特征融合等技术来改进 YOLOv5 的检测性能,提高小目标检测和边界框精度。

- 结合数据增强、迁移学习等方法,优化模型的训练过程,提升模型的泛化能力和鲁棒性。

- 进行模型压缩和加速,如剪枝、量化等技术,以降低模型计算复杂度和内存占用,提高推理速度和效率。

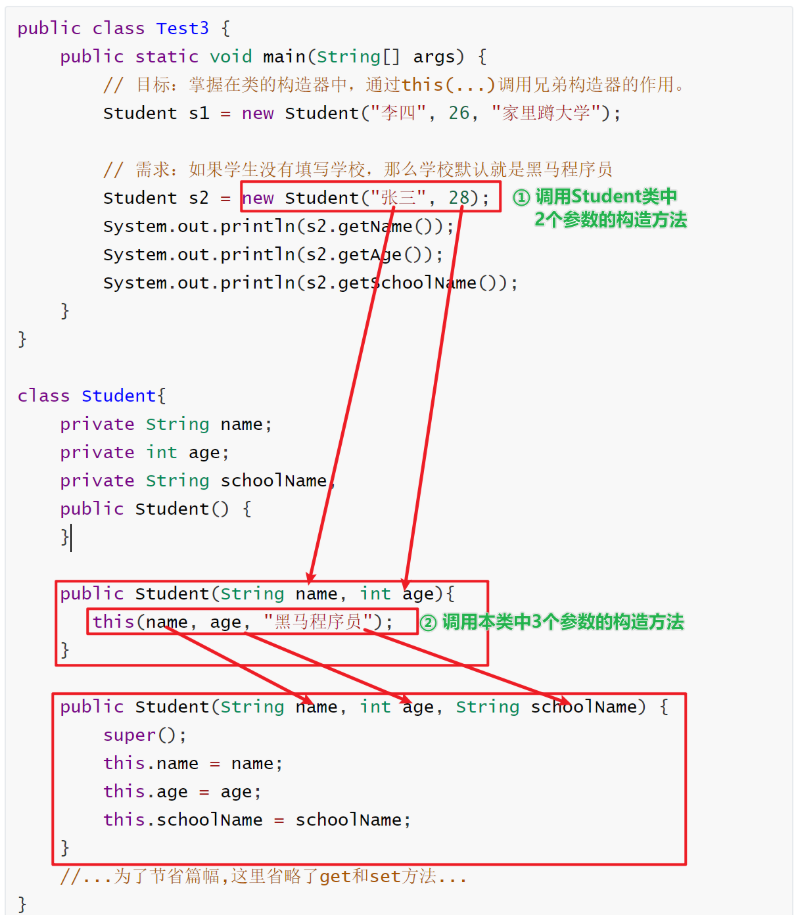

在 YOLOv5 模型中添加 SE(Squeeze-and-Excitation)注意力机制可以提高模型的表示能力和泛化性能,具体实现步骤如下:

-

SE 注意力模块:

- 定义 Squeeze 操作:对输入张量进行全局平均池化操作,将特征映射压缩为一个通道。

class Squeeze(nn.Module):def forward(self, x):return torch.squeeze(x.mean((2, 3)), dim=(-1, -2)) - 定义 Excitation 操作:通过两个全连接层将 Squeeze 操作输出的通道数降低并再次扩展,作为权重系数与原始特征相乘,实现特征的加权和。

class Excitation(nn.Module):def __init__(self, channels, reduction=16):super(Excitation, self).__init__()mid_channels = max(channels // reduction, 1)self.fc1 = nn.Linear(channels, mid_channels)self.fc2 = nn.Linear(mid_channels, channels)self.relu = nn.ReLU(inplace=True)def forward(self, x):out = self.fc1(x)out = self.relu(out)out = self.fc2(out)out = self.sigmoid(out)out = out.unsqueeze(-1).unsqueeze(-1)return x * out - 将 Squeeze 和 Excitation 操作组合在一起,形成 SE 注意力模块:

class SE(nn.Module):def __init__(self, channels, reduction=16):super(SE, self).__init__()self.squeeze = Squeeze()self.excitation = Excitation(channels, reduction)def forward(self, x):out = self.squeeze(x)out = self.excitation(out)return out

- 定义 Squeeze 操作:对输入张量进行全局平均池化操作,将特征映射压缩为一个通道。

-

基于 YOLOv5 的改进:

- 在 YOLOv5 模型中,SE 注意力模块可以应用在每个卷积层的输出上,以对特征图进行加权处理。

class Conv(nn.Module):def __init__(self, ch_in, ch_out, k=1, s=1, p=None, g=1, act=True, se=False):super(Conv, self).__init__()self.conv = nn.Conv2d(ch_in, ch_out, kernel_size=k, stride=s, padding=p, groups=g, bias=False)self.bn = nn.BatchNorm2d(ch_out)self.act = nn.SiLU() if act else nn.Identity()self.se = SE(ch_out) if se else nn.Identity()def forward(self, x):out = self.conv(x)out = self.bn(out)out = self.act(out)out = self.se(out)return out - 将 Conv 模块中的参数 se 设置为 True,即可对特定的卷积层添加 SE 注意力模块。

- 在 YOLOv5 模型中,SE 注意力模块可以应用在每个卷积层的输出上,以对特征图进行加权处理。

通过细致设计和实施上述方案,可以打造一款功能完善、性能优越的毕业设计项目,展现出对目标检测与测量技术的深度理解和创新应用,为未来相关领域的研究和发展提供有益的参考和启示。