前言

在计算机科学和数学领域,向量乘矩阵的内积计算是许多算法和模型中的核心操作之一。这一操作的高效实现对于优化算法的性能以及提高计算速度至关重要。本文将深入探讨向量乘矩阵的存内计算原理,聚焦于基于这一操作的存内计算方法。

本文的目标是解析向量乘矩阵的存内计算原理,系统性地介绍其背后的数学基础和计算机实现细节。我们将讨论不同的存内计算方法,并着重于它们在提高计算效率、减少内存占用方面的优势。通过深入研究,我们旨在为读者提供对这一核心计算操作的全面理解,为实际应用提供有益的指导。

一.向量乘矩阵的存内计算原理

在当今计算领域中,存内计算技术凭借其出色的向量乘矩阵操作效能引起了广泛关注。本文将深入研究基于向量乘矩阵的存内计算原理,并探讨几个引人注目的代表性工作,如DPE、ISAAC、PRIME等,它们在神经网络和图计算应用中表现出色,为我们带来了前所未有的计算体验。

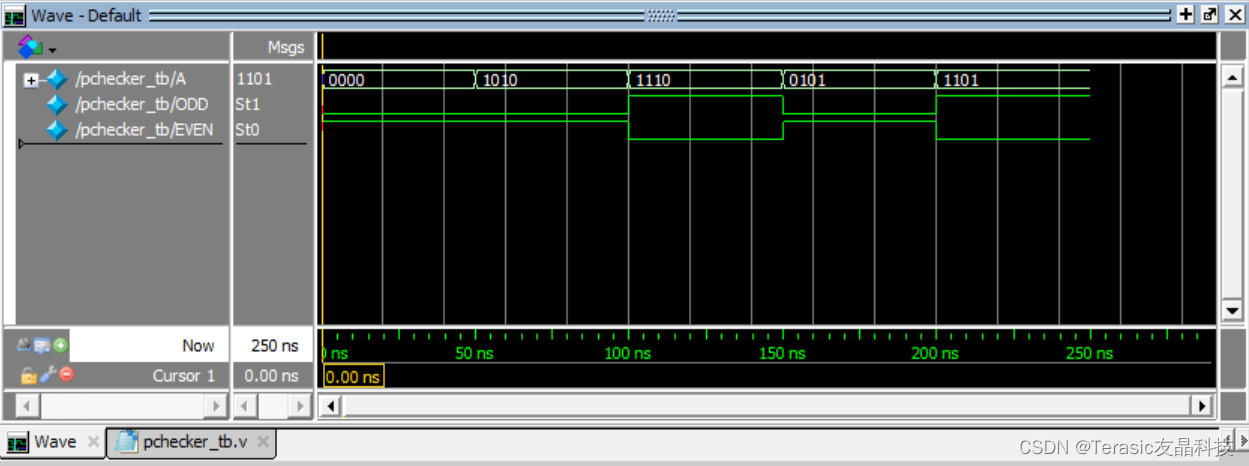

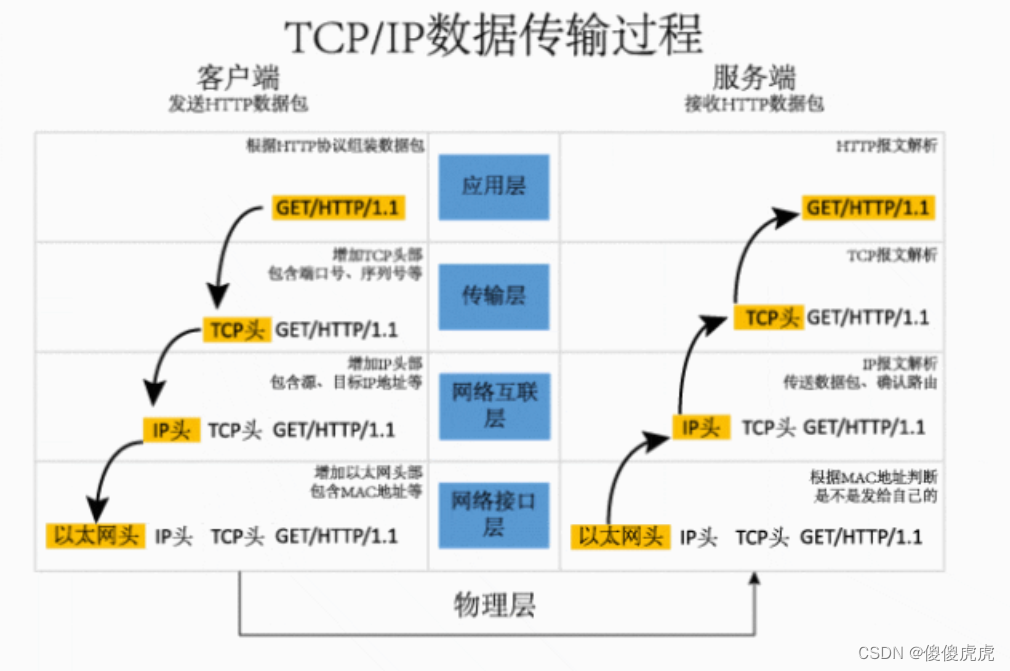

生动地展示了基于向量乘矩阵的存内计算最基本单元。这一单元通过基尔霍夫定律,在仅一个读操作延迟内完整执行一次向量乘矩阵操作。演示了一个2×1的向量(V1, V2)与一个1×2的向量(G1, G2)T相乘的过程,其中ReRAM阻值以(G1, G2)T表示,电压则以(V1, V2)表示。基于基尔霍夫定律,比特线上的输出电流便是向量乘矩阵操作的结果。将这一操作扩展,将矩阵存储在ReRAM阵列中,通过比特线输出相应的结果向量。

二.向量乘矩阵的存内计算

向量乘矩阵的存内计算,指的是计算机科学和线性代数领域中的一种优化技术,其目的是通过最大限度地减少内存访问次数,提高计算效率。在讲解存内计算原理之前,我们需要了解向量和矩阵的基本概念。

-

向量: 向量是一个有序数组,其中的元素称为分量。在计算机科学中,向量通常表示为一维数组。

-

矩阵: 矩阵是一个二维数组,其中的元素称为矩阵元。矩阵的行和列分别对应于向量的元素。

向量乘矩阵的基本原理是,将一个向量的每个元素分别与矩阵的对应元素相乘,并将结果相加。例如,设有一个向量v和一个矩阵A:

则向量乘矩阵的结果为:

现在来谈谈存内计算的优化原理。在计算机中,内存访问通常是计算中的瓶颈之一,因为内存访问的速度相对较慢。为了提高效率,存内计算尝试最大限度地减少内存访问的次数。

存内计算的优化原理包括:

-

局部性原理: 存内计算利用了局部性原理,即一旦访问了某个内存位置,附近的内存位置也很可能被访问。因此,存内计算尽量将需要访问的数据缓存在高速缓存中,减少主存访问次数。

-

循环展开: 将循环展开可以增加计算的并行性,减少内存访问次数。这意味着在计算时一次处理多个元素,而不是逐个处理。

-

矩阵块操作: 将大矩阵划分成小的矩阵块,利用局部性原理在这些块上进行计算,以减少内存访问的范围。

-

向量化: 利用硬件的向量指令,同时处理多个数据。这可以通过使用SIMD(单指令多数据)指令集来实现,例如Intel的MMX、SSE、AVX等。

-

内存对齐: 确保数据在内存中按照合适的边界对齐,以提高访问效率。

通过这些优化原理,存内计算可以显著提高向量乘矩阵操作的计算效率。这对于涉及大规模数据的线性代数运算,如深度学习中的矩阵乘法,具有重要意义。

2.1探寻代表性工作的独特之处

1. DPE (Hewlett Packard Laboratories)

DPE是专为向量乘矩阵操作设计的存内计算加速器。其独特之处在于提供了一种转化算法,将实际的全精度矩阵巧妙地存储到精度有限的ReRAM存内计算阵列中。实验证明,仅用4位的DAC/ADC就能保证计算结果没有精度损失,而性能提升更是达到了令人瞠目的1000到10000倍。

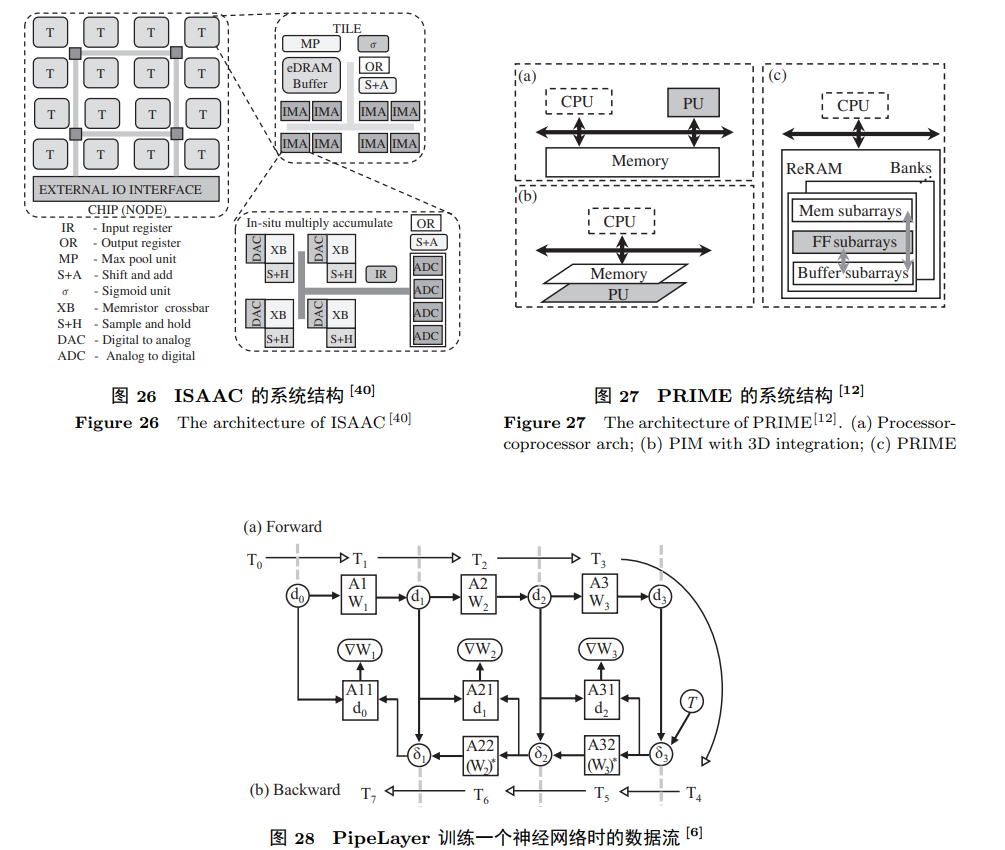

2. ISAAC (University of Utah)

ISAAC是专为神经网络推理设计的存内计算架构,其多个存内计算阵列通过C-mesh片上网络连接。每个阵列包含用于不同计算层的多种单元,如最大池化单元、Sigmoid单元、eDRAM缓存等。ISAAC通过ReRAM阵列实现向量乘矩阵操作,采用流水线方式提高推理效率,为神经网络的推理提供了独特而高效的解决方案。

3. PRIME (University of Santa Barbara)

PRIME同样专注于神经网络推理,其独特之处在于直接使用ReRAM单元进行计算。ReRAM bank包括Mem subarrays(存储)、FF subarrays(计算)和Buffer subarray(缓存)。相较于其他结构,PRIME实现了显著的性能提升和能耗节约,为神经网络推理领域带来了全新的可能性。

2.2逐鹿存内计算的新时代

随着计算领域不断演进,存内计算技术如一匹矫健的鹿儿,勇敢地迎接着新时代的挑战。DPE、ISAAC、PRIME等工作不仅为存内计算打开了崭新的篇章,也为我们提供了探索计算世界更深层次的机会。

1. PipeLayer (Duke University)

在神经网络训练领域,PipeLayer是一匹勇敢的鹿。其存内计算系统架构旨在通过复制多份权重数据实现少气泡的pipeline结构。PipeLayer巧妙地使得反向传播阶段的误差传递和权值计算并行进行,从而提高了存内计算训练神经网络的计算效率。实验结果显示,与传统的GPU系统相比,PipeLayer实现了42倍的性能提升和7倍的能耗节约。

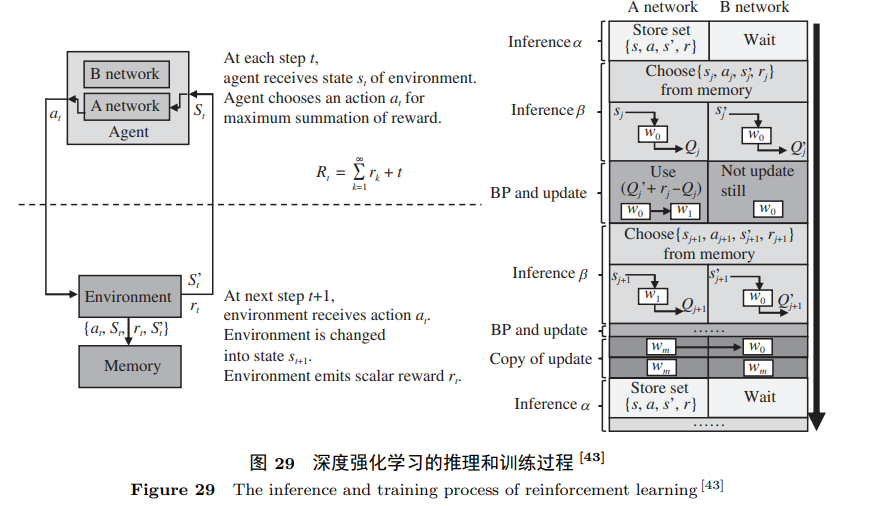

2.TIME (Tsinghua University)

在神经网络训练领域,TIME则为存内计算技术打开了新的可能性。为了降低训练时权重矩阵更新的延迟和能耗,TIME采取了权重矩阵复用的方法,与其他方法不同,它不是复制多份权重矩阵,而是通过特殊的数据映射操作来消除拷贝操作的写入开销。实验证明,TIME在有监督的神经网络和强化学习网络方面分别实现了5.3倍和126倍的能耗节约。

3.踏入未知的LerGAN之境 (Tsinghua University)

LerGAN作为对抗生成网络(GAN)的存内计算系统架构,为存内计算的发展开辟了新的天地。通过去除零相关的操作,重新构建卷积核,LerGAN巧妙地应对了GAN的挑战。它提出了一个三层堆叠的存内计算阵列结构,使得GAN训练的数据传输路径变短,路由减少。实验结果表明,相较于传统的CNN,LerGAN在性能和能耗方面分别取得了7.46倍和7.68倍的提升。

4.PCM+CMOS:IBM的前瞻之举

IBM的PCM+CMOS存内计算方法,将存储单元与计算结合,实现了全连接神经网络的前向传播、反向传播和权值计算。其独特的结构中使用PCM单元存储权值的高位,而电容器单元存储权值的低位,巧妙地平衡了计算的稳定性和存储的寿命。该方法为存内计算提供了一种前瞻性的解决方案。

三.总结-携手向前迈进

这一系列存内计算的代表性工作,如同一群勇敢的鹿群,勇敢地探索着计算领域的未知领域。DPE、ISAAC、PRIME、PipeLayer、TIME、LerGAN、PCM+CMOS等工作,各自带有独特的特点,共同构筑起存内计算技术的辉煌画卷。

未来,存内计算技术将继续与创新者携手前行,挑战更大的计算难题。这不仅是对技术的不懈探索,更是对计算领域的一次颠覆性的变革。在这个充满激情和创造力的时代,我们期待存内计算技术与计算领域共同书写新的传奇。携手向前,踏上计算的无限征程。

基于向量乘矩阵的存内计算技术正积极推动着神经网络和图计算领域的发展。DPE、ISAAC、PRIME等代表性工作展示了这一领域的多样性和创新。我们可以期待,存内计算技术将在提高计算效率、减少能耗等方面发挥更为关键的作用,为计算领域带来更多的创新与突破。在这个充满活力的领域中,我们正迈向一个更加智能和高效的未来。

参考来源—巨人的肩膀

1.知存科技

2.中国移动研究院

3.电子与信息学报—存内计算芯片研究进展及应用

4.中科院—基于NorFlash的表积神经网络量化

5.《中国科学》杂志社:内存计算研究进展

原文转载至窥探向量乘矩阵的存内计算原理—基于向量乘矩阵的存内计算-CSDN社区