在当下这个数字化高速发展的时代,大型语言模型(LLM)如ChatGPT等,已逐渐融入我们的日常生活与专业工作之中,成为不可或缺的得力助手。它们凭借强大的能力,不仅能回答我们的疑问,还能协助我们撰写文章,甚至解决复杂的技术难题。 然而,很多人在初次与ChatGPT交互时,可能会因为沟通上的障碍而感到困惑,仿佛面对一台不按常理出牌的自动售货机。这种感觉并非源于模型本身的局限,而是源于沟通方式的不当。

沟通,既是一种技巧,也是一门艺术。同样,与大型语言模型(LLM)的交互也需要我们掌握这门艺术。而要充分发挥这些模型的潜力,关键在于我们如何精准且清晰地与它们“对话”。这种对话的精髓,就在于我们提供的“Prompt”——那些精确且清晰的指令。 通过深入研究并巧妙运用这些指令,我们可以显著提高与模型“交谈”的质量和效率。特别是当我们掌握了零样本提示、一次样本提示以及少数样本提示等概念与技巧后,便能更加精准地引导模型理解我们的需求,从而使其输出更符合我们期望的结果。

以下内容需要使用到ChatGPT,尚未获得ChatGPT的用户,请移步:五分钟开通GPT4.0。

提供样本提示给Prompt指令的好处?

答案就在于这些范例能够显著增强模型对使用者需求和上下文的理解能力,进而促使其产出更加精准、更加贴合使用者期望的回答或解决方案。

通过精心设计的prompt样本提示指令,我们能够更加高效地发挥模型的能力,选择更加恰当的生成方式,并进一步优化回答的品质和相关性。这一方法不仅提升了我们与LLM模型对话的准确度,还显著增加了我们从LLM模型中获得有用回答的几率。因此,它成为了最大化ChatGPT及其他LLM大型语言模型效能的关键途径。

有哪些样本提示指令?

提示指令按照是否提供样本,可划分为三大类别:零样本提示(Zero-Shot)、一次性样本提示(One-Shot)以及少量样本提示(Few-Shot)。零样本提示允许模型在没有先前范例的情况下直接给出回答,展现了其强大的基础推理能力;一次性样本提示则通过引入一个具体范例,帮助模型更好地理解问题背景,从而提升回答的质量;而少量样本提示则通过提供多个范例,为模型提供更丰富的上下文信息,使其能够应对更复杂的问题。在实际应用中,我们可以根据不同的使用情境灵活选择这三种方式,以更精确地达成所需的结果。接下来,本文将详细解析这些样本提示技术的原理与应用。

零样本提示(Zero-Shot)

「零样本提示」技术可以让ChatGPT在无需任何先前经验或示例的情况下生成回答的能力。这种策略巧妙地利用了模型所拥有的庞大预训练知识库,使其能够深入理解并回应各类问题,从而显著提升了ChatGPT的适应性和灵活性。使用零样本提示需要精确地表达问题或需求。

为了更深入地理解零样本提示在实际应用中的效果,接下来我们将通过几个具体的范例,展示如何向ChatGPT提出零样本提示的请求。

范例1:提取关键字

从一段文字中精准筛选出关键字,无需提供繁琐的操作范例,只需以简明扼要的Prompt指令,向ChatGPT明确表达我们的需求即可。具体方法如下所示:

Extract keywords from the below text.

Text: [这里放入需要被筛选关键字的一段文字]

Keywords:Prompt指令清楚的告诉 ChatGPT 我们的目的是从指定文本中提取关键字。

范例2:情感分析

Classify the following text's sentiment as positive, neutral, or negative.

Desired Format: a number, -1 for negative, 0 for neutral, and 1 for positive

Input: [这里放入需要被筛选关键字的一段文字]

Sentiment:即便我们没有提供任何具体的范例,ChatGPT 也能理解的我们的要求并依照期望的格式进行回答(-1代表负面、0代表中性、1代表正面)。

范例3:文章摘要

要从一篇较长的文章中提取并产生成摘要,可以在指令中直接告诉 ChatGPT 我们的需求:

Generate a summary for the following text.

Text: [这里放入长文本]

Summary:通过上述范例,我们不难发现,即便未在指令中附加操作范例,只要巧妙设计Prompt指令,便能成功引导ChatGPT,它能凭借其预先训练的模型,精准把握任务的核心要求,并生成符合预期的输出。

一次性样本提示(One-Shot)

一次性样本提示(One-Shot)是通过向ChatGPT展示一个具有代表性的范例,指引其生成特定的回答或内容的方法,充分利用了模型的学习能力,使得ChatGPT能够迅速理解并模仿范例中的风格和逻辑,从而生成符合我们期望的输出。

高品质的范例在提升ChatGPT的输出质量方面扮演着至关重要的角色。特别是在需要根据特定情境或条件提供量身定做回答的领域,如医疗、法律或客户服务等。

以下是一些范例:

范例1:文章分类

Classify the following texts as related to technology or not.

Input: "Apple releases new iPhone with innovative features."

Classification: Related to technology

Input: {text}

Classification:这个Prompt通过一个清晰的范例(Input: “Apple releases new iPhone with innovative features.” Classification: Technology-related)展示了如何对特定文字内容进行科技相关性分类。随后,它要求ChatGPT运用此范例作为参照,对另一段文字内容(Input: {text} Classification:)进行同样的分类判断,以确定其是否与科技相关。

范例2:语言翻译

Translate the following sentence into French.

Input: "Hello, how are you?"

Translation: "Bonjour, comment ça va?"

Input: {text}

Translation:此范例展示了一个英文句子及其对应的法文翻译,随后要求ChatGPT依循此范例,翻译另一段文字。即便没有额外说明,ChatGPT也能明白我们的需求并完成翻译任务。

范例3:数据分析解释

Explain the following data analysis result.

Input: "Our A/B testing shows a 20% increase in user engagement for the new interface."

Explanation: "This indicates that the new interface effectively engages users, likely due to its improved design or features. A 20% increase signifies a significant enhancement over the previous interface."

Input: {data analysis result}

Explanation:此范例中,我们先展示了A/B测试结果的描述及解释,随后要求ChatGPT据此解释另一数据分析结果。这种方法不仅帮助模型理解如何处理和解释数据分析的结果,也提供了一种有效的方式,让我们转化专业数据分析为易于理解的解释。

通过以上示例,我们不难发现,一次性样本提示通过展示清晰范例,有效地引导ChatGPT完成特定任务。

少量样本提示(Few-Shot)

少量样本提示(Few-Shot)是通过提供多个精选范例来指导ChatGPT处理特定问题或请求的一种高效方法。这种方法有助于模型学习新任务,因为它为模型提供了丰富的上下文信息,从而提高了回答的质量和加速了模型的学习进程。特别是在需要快速且精确分析大量数据的场合,如金融市场分析或趋势预测,少量样本提示发挥着至关重要的作用。

以下是一些范例:

范例1:情绪分析

Classify the sentiment of the following texts as positive, neutral,

or negative.

- "This is the best day of my life!" => Positive

- "I guess it could have been worse." => Neutral

- "This was the worst experience I've ever had." => Negative

Your input: "I love this new song."

Sentiment:这个范例展示了三种不同情绪(正面Positive、中性Neutral、负面Negative)的文字样本,目的是协助ChatGPT模型理解如何根据文件情绪进行分类。

范例2:文字摘要

Generate a summary for the following texts.

Text1: "Stripe provides APIs that allow businesses to accept payments online."

Summary1:"Stripe offers online payment APIs for businesses."

Text2: "OpenAI has trained cutting-edge language models that can understand and generate human-like text."

Summary2:"OpenAI's language models mimic human text comprehension and generation."

Your input Text: "The Great Wall of China is one of the greatest wonders of the world."

Summary:在此范例中,我们展示了两组具体的文字内容及其摘要范例,以此指导ChatGPT学习如何从冗长的文字描述中精准提炼关键信息,生成高质量的摘要。

范例3:基于上下文的问答

Based on the provided context, answer the following questions.

Context: "The Great Wall of China stretches over 21,196 kilometers and

was listed as a World Heritage by UNESCO in 1987."

- "How long is the Great Wall of China?" => "It stretches over 21,196 kilometers."

- "When was it listed as a World Heritage by UNESCO?" => "In 1987."

Your question: "What is the Great Wall of China known for?"

Answer:此范例通过展示一段上下文及其对应的问题和答案,有效帮助ChatGPT理解如何根据上下文信息来准确回答新问题,从而提高了模型的回答质量和准确性。

提升生成质量

一次性样本提示与零样本提示在多种情境中往往会产生截然不同的结果,特别是在要求模型以特定格式回答或深入理解细节的任务中。

接下来,我们将通过具体的例子来对比一次性样本提示(One-Shot)和零样本提示(Zero-Shot)在生成结果上的差异,从而更直观地理解这两种方法的特性。

范例1:产生一篇关于时间管理的短文

零样本提示(Zero-Shot)

零样本提示下, 仅向 ChatGPT 提出需求,而不提供任何范例或背景信息:

写一篇关于时间管理的短文。以下是结果:

一次性样本提示(One-Shot)

"以下是一篇关于时间管理的短文范例:

在当今快节奏的社会中,有效的时间管理是成功的关键。一个人如何分配和利用时间,

可以直接影响到他们的生产力和压力水平。例如,使用番茄工作法,通过短暂休息来增

强工作焦点和效率,已被证明是提高时间利用效率的有效方法。

现在,请你根据这个范例,写一篇关于时间管理的短文。"以下是结果:

比较

由于一次性样本提示(One-Shot)提供了具体的范例作为指引,其生成的短文往往更能精准地满足读者需求,提供更为具体且深入的回答。这不仅增强了短文的针对性和实用性,还确保了生成内容的风格一致性。相比之下,零样本提示(Zero-Shot)下生成的短文在内容深度和个性化表达方面可能稍显逊色,不如一次性样本提示那般丰富与细腻。

范例2:将英文句子翻译成法文

零样本提示(Zero-Shot)

不提供任何上下文或范例直接请求ChatGPT进行翻译。

"Translate the following sentence into Chinese:

'The quick brown fox jumps over the lazy dog.'"

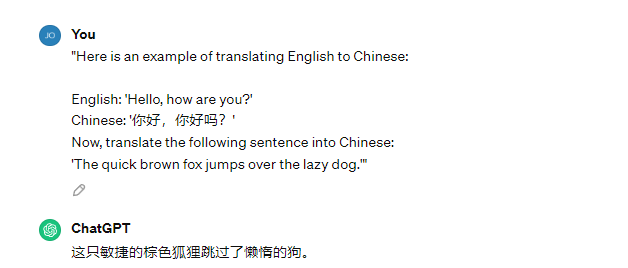

一次性样本提示(One-Shot)

在我们请求翻译时附带提供模型一个具体范例,引导 ChatGPT 如何处理类似下面的翻译时。

"Here is an example of translating English to Chinese:

English: 'Hello, how are you?'

Chinese: '你好,你好吗?'

Now, translate the following sentence into Chinese:

'The quick brown fox jumps over the lazy dog.'"以下是结果:

比较

相比之下,虽然零样本提示(Zero-Shot)能应对基本的翻译需求,但面对更具挑战性的翻译任务时,其处理结果可能无法达到一次性样本提示那样的精确度和自然度。因此,对于追求高品质翻译的人来说,一次性样本提示的价值是无可替代的。

哪种方法更能提升产出的品质?

零样本提示(Zero-Shot)、一次性样本提示(One-Shot)和少量样本提示(Few-Shot)各具特色,并适用于不同的情境。在实际应用中,选择何种方式以产出更高品质的结果,应基于具体的任务和目标来做出决策。

零样本提示(Zero-Shot)

零样本提示的优势在于其“无需提供任何示例,仅依赖模型自身预训练的知识来理解和回答问题”的特性,这使得它能够迅速应用于各类普遍性问题。当我们无法提供具体范例或对模型能力有充分信心时,零样本可以作为一个不错的选择。

一次性样本提示(One-Shot)

一次性样本提示通过提供一个相关提示来精准引导模型,使其更能满足任务的要求和期望。这种方法尤其适用于那些可以通过一个范例明确表达的任务,能够显著提高模型的输出质量和效率。

少量样本提示(Few-Shot)

通过提供数个精选范例来引导模型处理特殊请求或问题,少量样本提示的方法往往能够显著提升结果的品质,特别是在处理复杂任务的时候。

在前面的文章中,我们详细探讨了如何借助具体且明确的指令来引导大型语言模型(LLM)进行工作,特别是在采用“零样本提示”、“一次性样本提示”和“少量样本提示”这些策略时。通过提供范例,模型能够更好地理解使用者的意图,进而生成更加个性化和精准的回答。

强烈推荐使用ChatGPT 4.0,它具备更为专业的知识和分析能力,能够更好地满足您的需求。如果您不知道如何升级到Plus服务,可以按照Plus升级教程升级。

原文链接:利用优质样本提示,优化ChatGPT Prompt的编写技巧