Git学习笔记(二)

- 下载VSCode

- 创建本地仓库

- 推送远程仓库

- 界面功能

使用 VSCode 进行Git仓库的项目管理

这篇文章是我学完使用 命令行终端 管理Git仓库额外学习的

文章主要用于巩固和方便后续复习

下载VSCode

可以看我这篇文章下载VSCode

创建本地仓库

创建一个VSCode_test文件夹

打开VSCode

选择创建的文件夹

创建一个.c文件

随便写一段代码

然后按 Ctrl+s 保存

然后点击Git的图标

点初始化仓库,这一步相当于命令行的 git init

在文件夹中多出了一个.git文件

即 本地仓库 创建成功

这里相当于两个命令

git add .

git commit -m 'first add'

在下方 源代码管理图 中可以看到我们在 本地仓库 的第一次提交

且分支名为 main

这里相当于使用了命令 git-log

推送远程仓库

在Git中创建一个仓库

这里选择HTTPS

与在 Git Bash 中不一样

复制这个链接

在VSCode中粘贴到此处

我认为下面的步骤就是

命令 git remote add origin git@gitee.com:jian-haohua/vscode_test.git

即添加远程仓库

推送到远程仓库中

即命令 git push --set-upstream origin main:main

如果是第一次点击 发布Branch

可能会报错

原因:HTTPS缓存不够

解决:进入 Git bash 中执行命令git config --global http.postBuffer 524288000

点击 发布Branch 后下方源代码管理图会多出一个像云端的图标

说明成功推动到远程仓库中

在 Gitee 中也可以看到成功推送

当我们对内容进行了修改

相应的地方会有提示

可以再次提交

下方也会显示出对应的修改记录

点击同步即将修改后的再次推送到远程仓库

相当于使用命令 git push

至此就完成了Git的基本操作

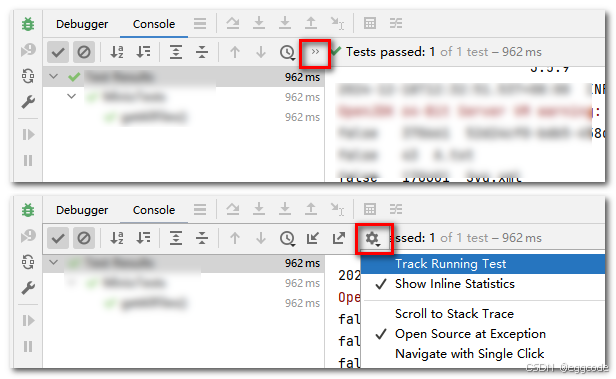

界面功能

这里包含了Git的所有命令

通过图形化界面替代了命令行

相比于用 Git Bash 会方便快捷很多

但是跟Linux一样,用命令行可能会更好

这里也可以进行快捷操作

将鼠标放到对应的图标

即会显示对应的功能

当然也可以调出终端使用命令行

使用快捷键 Ctrl+Shift+`

但是在VSCode中是用不了命令git-log的

因为这个命令要自己提前配置

如果要在终端命令行中用这个命令

就先输入bash进入Git的命令终端

然后就相当于使用bash了

Git bash是一个为 Windows 提供的命令行工具,它结合了 Git 和一个类 Unix 的 Bash 环境。通过 Git Bash,用户可以在 Windows 上运行类似 Linux 或 macOS 的命令行操作,使用 Git 来进行版本控制。具体来说,Git Bash 提供了以下功能:

Git 命令:让用户在 Windows 上运行 Git 命令,如 git clone、git commit、git push 等。

Bash 环境:提供类似 Unix 的 shell 环境,可以运行常见的 Unix 命令,如 ls、cp、rm 等。

支持脚本:可以运行 Shell 脚本(.sh),这对于自动化任务非常有用。

简单来说,Git Bash 是 Windows 用户使用 Git 和类 Unix 环境的工具