M1部署Ollama

Ollama中文网站: Featured - 精选 - Ollama中文网

下载网址: Download Ollama on macOS

安装后运行llma3模型:

ollama run llama3:8b

界面使用:

GitHub - open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI)

部署open-webui:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

访问http://localhost:3000/端口即可访问本地的大模型

下载开源模型支持中文和function calling

下载

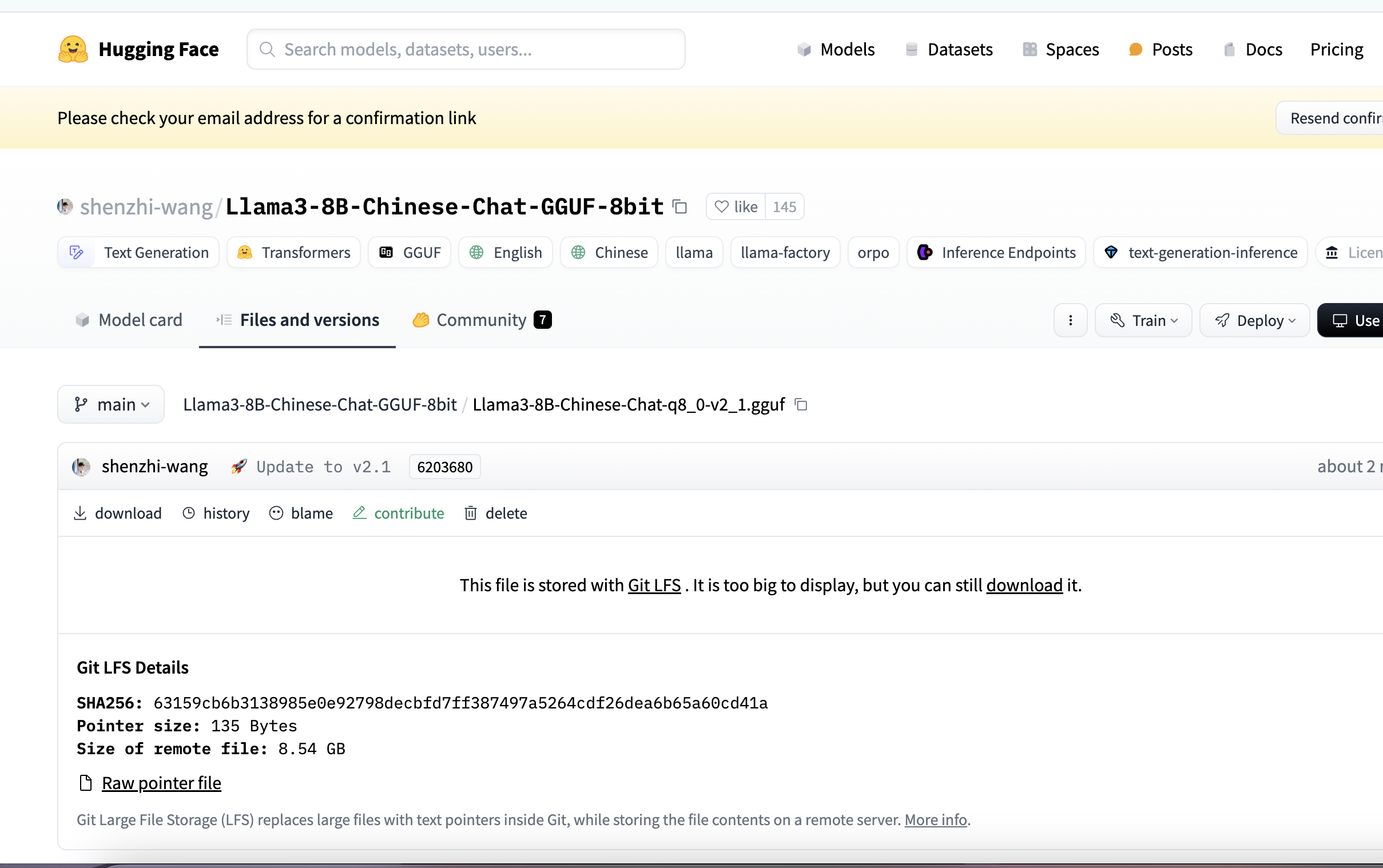

https://huggingface.co/shenzhi-wang/Llama3-8B-Chinese-Chat-GGUF-8bit

官网下载的模型虽然能理解中文, 但是对中文的支持还是比较弱. 需要在hugging face下载中文训练后的模型: Llama3-8B-Chinese-Chat-v2.1

该模型还支持了官方llama3:8b不支持的function calling 调用

ollama下使用自己下载的模型

# 与模型文件相同路径下编辑文件

vim config.txt输入内容:

FROM "/Users/louye/Downloads/tmp/Llama3-8B-Chinese-Chat-q8_0-v2_1.gguf"TEMPLATE """{{- if .System }}

<|im_start|>system {{ .System }}<|im_end|>

{{- end }}

<|im_start|>user

{{ .Prompt }}<|im_end|>

<|im_start|>assistant

"""SYSTEM """"""PARAMETER stop <|im_start|>

PARAMETER stop <|im_end|># 保存文件并退出

wq!使用命令导入模型:

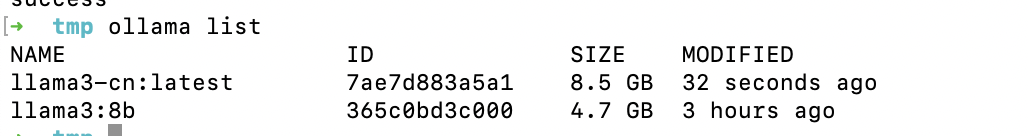

ollama create llama3-cn -f ./config.txt

查看模型是否存在

ollama list

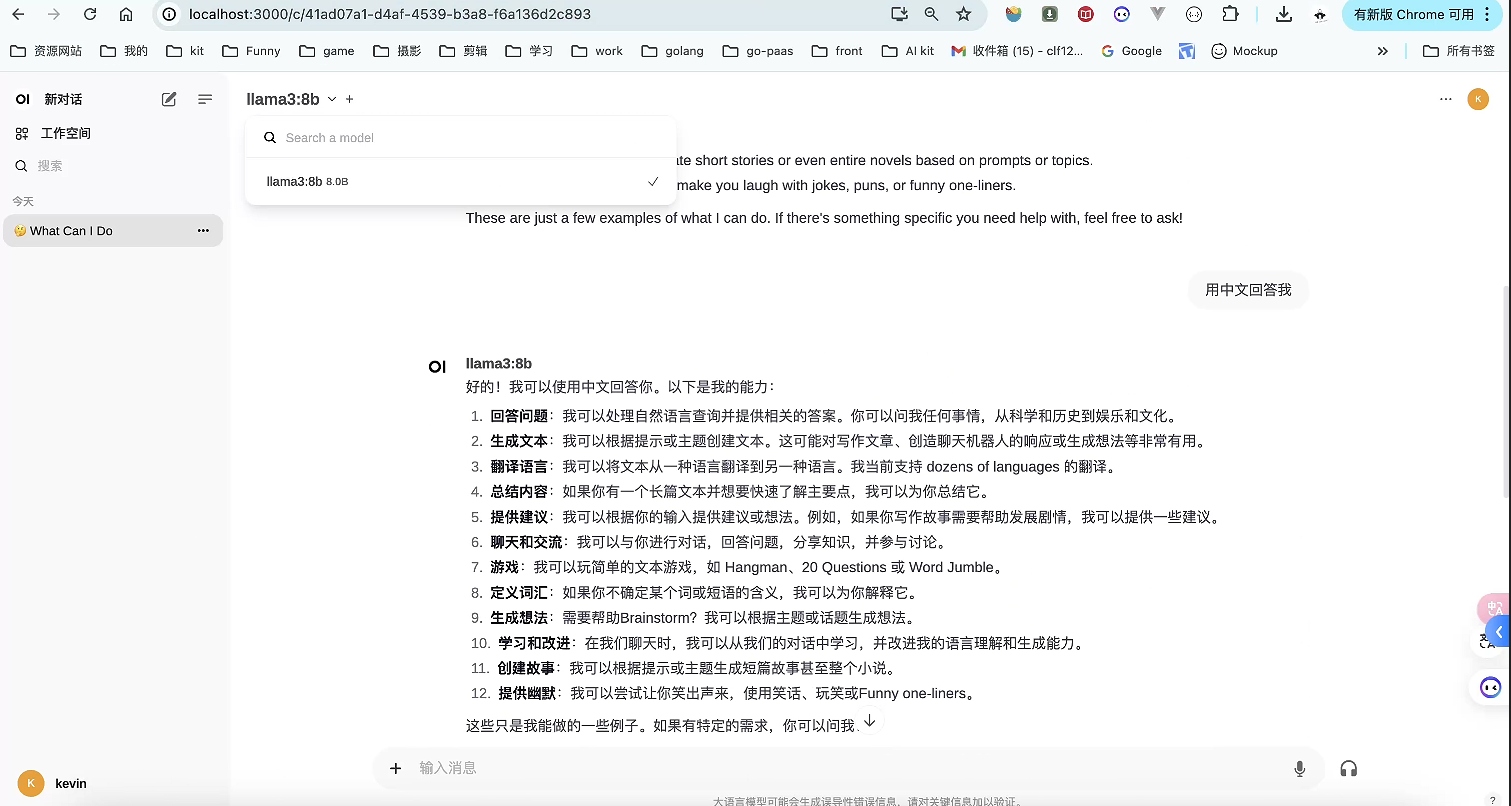

最后open-webui界面就能看到, 测试一下中文:

![[BUUCTF从零单排] Web方向 02.Web入门篇之『常见的搜集』解题思路(dirsearch工具详解)](https://img-blog.csdnimg.cn/direct/9f7b8152d18b433daa91bfbb8a8aed8e.png#pic_center)