成长路上不孤单😊【14后,C++爱好者,持续分享所学,如有需要欢迎收藏转发😊😊😊😊😊😊😊!!!!!!今日分享关于【如何本地搭建Whisper语音识别模型】

关于本地搭建Whisper语音识别模型涉及到几个非常关键的步骤,包括安装必要的软件和库、配置环境、下载模型以及进行测试。

以下是一个详细的操作指南:

-

安装ffmpeg:fmpeg是一个用于处理音频和视频文件的工具,对于语音识别模型的搭建是必要的。可以从官方网站下载并按照说明进行安装1。

-

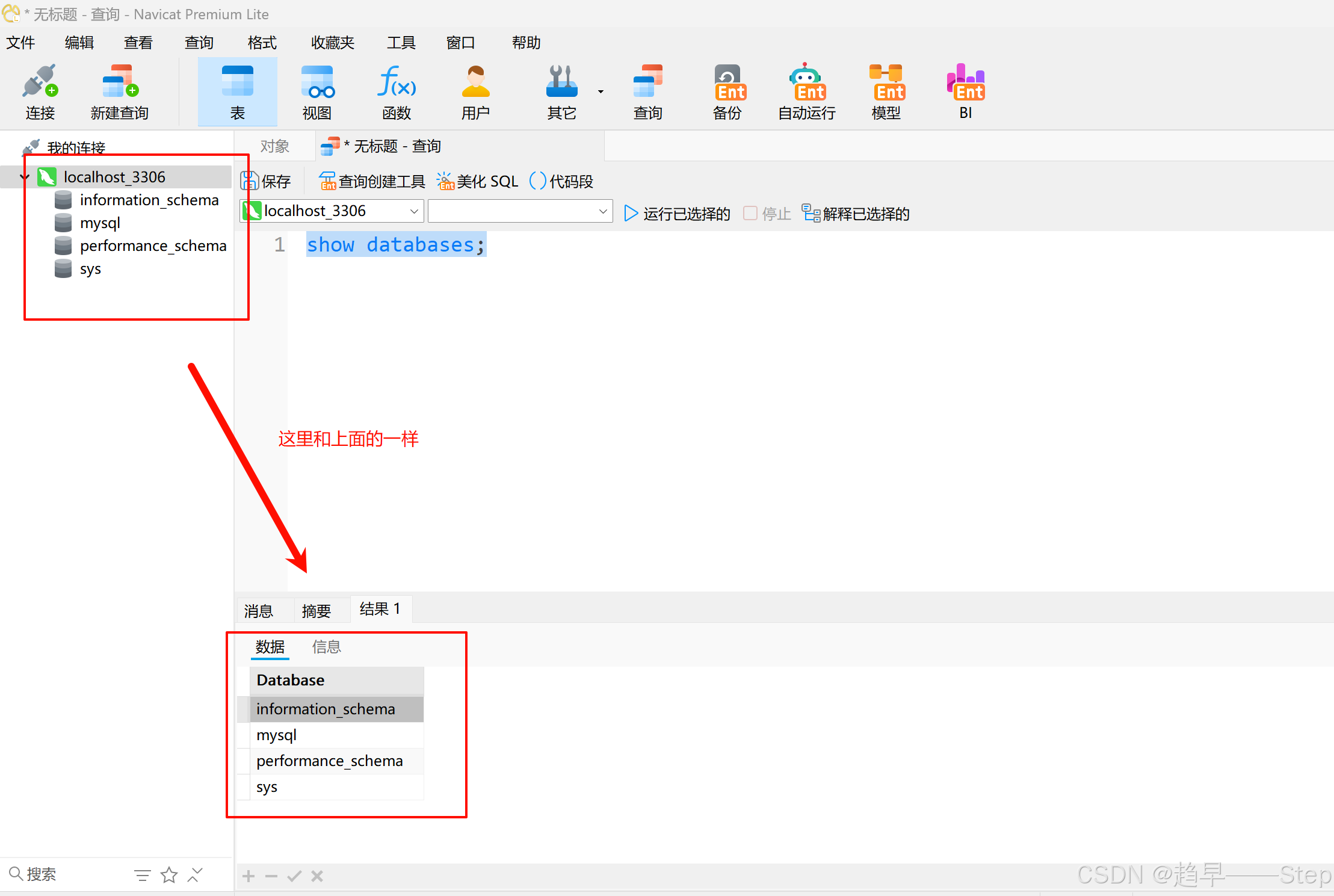

安装Anaconda并建虚拟环境:使用Anaconda创建一个新的虚拟环境,并指定Python版本(例如Python 3.9)。这将帮助隔离模型的依赖项,避免与系统其他部分产生冲突1。

-

安装CUDA和PyTorch:根据您的硬件配置,选择合适的CUDA和PyTorch版本进行安装。这些是深度学习模型运行所需的硬件加速库1。

-

下载Whisper模型:通过pip安装Whisper模型,可以从GitHUB仓库(https://github.com/openai/whisper)获取最新版本。确保使用与您的环境和模型兼容的版本12。

-

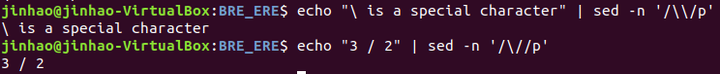

配置环境变量:在安装过程中,可能需要配置环境变量,以确保系统能够找到必要的执行文件。这通常涉及到将ffmpeg、CUDA和Python的路径添加到系统的环境变量中13。

-

测试模型:一旦所有依赖项安装完毕,可以通过运行简单的测试来验证模型是否正确安装和配置。这可以是一个简单的语音转文字测试,以确保一切工作正常1。

通过上述步骤,您就可以成功地在本地搭建Whisper语音识别模型,并进行语音识别测试。这个过程可能需要一些技术知识,特别是关于深度学习框架和依赖管理方面的知识。确保在安装过程中遵循官方文档和指南,以避免常见错误和问题。

、