近日,国内知名安全调研机构GoUpSec发布了2024年中国网络安全行业《信创安全产品及服务购买决策参考》,报告从产品特点、产品优势、成功案例、安全策略等维度对各厂商信创安全产品及服务进行调研了解。

海云安凭借AI大模型技术在信创安全领域中的创新应用成功入选本次报告,被评为信创安全“酷厂商”。

本次报告共收录24家国内网络安全厂商,共计94个安全产品及服务,具体成功实施案例52例,适用于政府、国央企、金融、教育、医疗、互联网、能源、制造业、交通、电力、银行、汽车、运营商等重点行业。

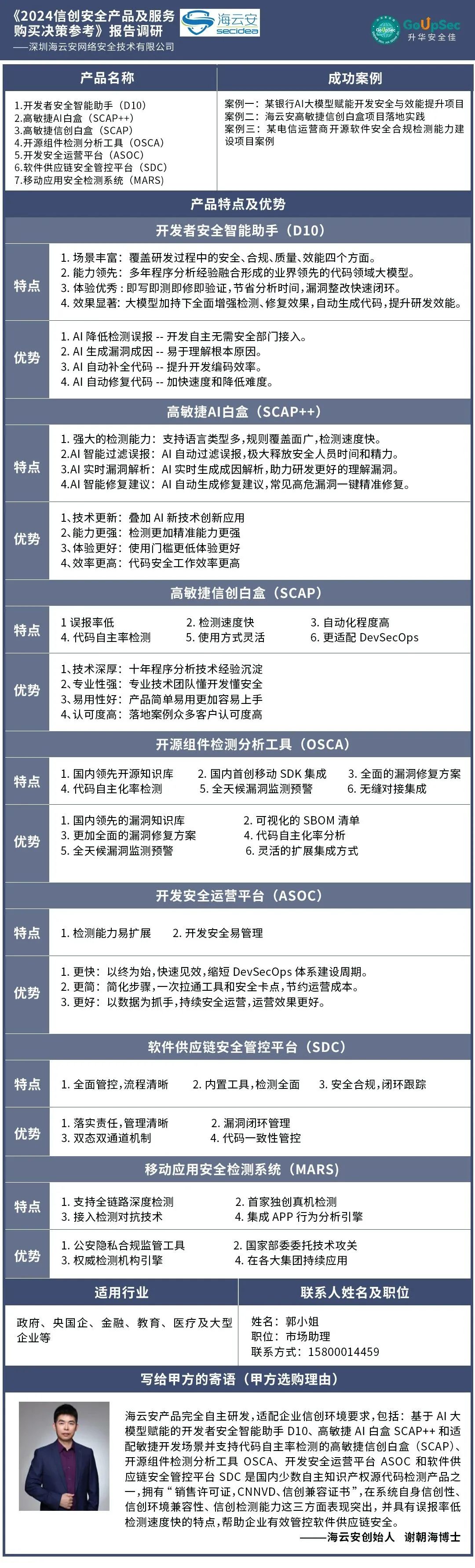

海云安开发者安全智能助手(D10)、高敏捷Al白盒(SCAP++)、高敏捷信创白盒(SCAP)、开源组件检测分析工具(OSCA)、开发安全运营平台(AS0C)、软件供应链安全管控平台(SDC)、移动应用安全检测系统(MARS)及三项成功案例被收录。

网络安全是信创的重点领域,近年来越来越多的国家黑客组织和网络犯罪集团开始将安全产品作为网络攻击的突破口,因为安全产品通常拥有较高的系统权限,可访问敏感数据,一旦被攻破可造成巨大损失。

在当前时间紧任务重的大环境下,我们首先关注的就是降低替换风险、提高替换效率。为适应政策要求,海云安技术团队完成了一系列信创实践,通过自主研发,可适配企业信创环境要求,包括:基于AI大模型赋能的开发者安全智能助手D10、高敏捷AI白盒SCAP++、高敏捷信创白盒(SCAP)、开源组件检测分析工具OSCA、开发安全运营平台ASOC和软件供应链安全管控平台SDC等,在系统自身信创性、信创环境兼容性、信创检测能力这三方面表现突出,并具有误报率低检测速度快的特点,帮助企业有效管控软件供应链安全。

此次入选《信创安全产品及服务购买决策参考》报告是业界权威机构对海云安在信创安全领域实力的认可!安全为本,海云安将不断优化升级产品及服务,从当前的威胁环境和技术趋势出发,为用户提供更加智能化、高效化的信创安全产品,切实保障企业的信创安全。