弱监督学习新突破:格灵深瞳多标签聚类辨别(Multi-Label Clustering and Discrimination, MLCD)方法

引言

在视觉大模型领域,如何有效利用海量无标签图像数据是一个亟待解决的问题。传统的深度学习模型依赖大量人工标注数据,而获取高质量的标注数据成本高昂,且覆盖面有限。因此,如何通过弱监督学习来降低对标注数据的依赖,提升视觉模型的泛化能力和语义理解能力,是当前研究的热点之一。

格灵深瞳提出的多标签聚类辨别(Multi-Label Clustering and Discrimination, MLCD)方法,提供了一种创新且有效的解决方案。MLCD通过聚类技术和多标签分类相结合的方式,在无需大量人工标注的情况下,提升了模型的语义理解能力和性能。这一方法在弱监督学习的背景下,通过利用海量的无标签数据,充分挖掘图像中的语义信息,使得视觉模型在多任务场景下表现出更好的性能。

MLCD方法详解

MLCD的核心思想在于:通过聚类将相似的图像分组,并为每个图像分配多个软标签,从而模拟多标签分类场景,训练出具备更强语义理解能力的视觉模型。

1. 特征聚类

- 特征提取:MLCD首先使用预训练网络(如ResNet等)提取图像的特征向量。这些特征向量表示图像的高层次抽象信息,可以有效地表示图像的内容。

- 初始聚类:接下来,MLCD使用特征聚类算法(如K-means、GMM等)将图像数据集划分为若干簇。每个簇可以看作是一个初步的类别,代表一类相似的图像。

- 多标签辅助:与传统的单标签聚类不同,MLCD引入多标签机制,为每个图像分配多个聚类中心的软标签。这意味着一个图像可以同时属于多个簇,例如一张图像可能包含“猫”和“狗”等多个语义信息。

2. 软标签分配

- 概率分配:MLCD为每个图像生成一个软标签向量,向量中的每个元素代表图像属于某一类的概率。这些概率值是基于图像与各个聚类中心之间的距离计算得出的。

- 软标签优势:相比于硬标签(即图像只能属于单个类别),软标签允许图像同时属于多个类别,并且不同类别的权重有所区别。这种方式更真实地反映了图像中的复杂语义结构。

3. 多标签分类损失函数

-

定制化损失函数:MLCD引入了一种定制化的多标签分类损失函数,鼓励模型在多标签场景下正确预测多个相关标签,同时抑制不相关标签。损失函数基于交叉熵,并加入正则化项来防止过拟合。

- 传送门链接: 深入解析:机器学习中的过拟合与欠拟合

例如,损失函数可表示为:

L = − ∑ i = 1 N ∑ j = 1 M y i j log ( p i j ) + λ ∑ i = 1 N ∣ ∣ θ i ∣ ∣ 2 L = -\sum_{i=1}^{N}\sum_{j=1}^{M} y_{ij} \log(p_{ij}) + \lambda \sum_{i=1}^{N} ||\theta_i||^2 L=−i=1∑Nj=1∑Myijlog(pij)+λi=1∑N∣∣θi∣∣2

其中, y i j y_{ij} yij 是第 i i i 张图像在第 j j j 类的真实标签, p i j p_{ij} pij 是模型预测的概率, λ \lambda λ 是正则化参数, θ i \theta_i θi 是模型的权重参数。该公式通过惩罚错误分类的预测概率,并对模型权重加以约束,来提高模型的泛化能力。

- 传送门链接: 深入解析:机器学习中的过拟合与欠拟合

-

损失函数优化:通过优化该损失函数,MLCD能够有效学习到具有更强判别力的特征,从而提高图像分类和识别的准确率。

举个栗子

假设我们在处理一个智能相册应用,它能够自动识别和分类照片中的物体。

1. 特征提取与聚类原理

假设你有一个包含大量照片的相册,这些照片中有各种各样的物体,比如猫、狗、汽车、风景等等。首先,MLCD方法会从这些照片中提取出特征,就像我们用放大镜观察每张照片的细节。提取的特征包含了图片的高层次信息,比如“这张图片看起来有很多猫的特征”或者“这张图片像是城市风景”。

接着,MLCD会对这些特征进行聚类。例如,将相似特征的照片分成一个组。比如,所有包含猫的照片被分到一个组,所有包含狗的照片被分到另一个组。这就像是我们将照片按主题归档。

2. 软标签分配原理

但是,有时候一张照片可能同时包含多个物体。比如,一张照片中既有猫也有狗。传统的分类方法可能只能选择一个标签,比如“猫”或“狗”。但MLCD方法使用软标签,允许每张照片同时有多个标签。对于那张同时有猫和狗的照片,MLCD可能会给它分配两个标签:“猫”和“狗”,每个标签还会有一个“权重”,表示这个标签的重要程度。例如,“猫”标签的权重是0.7,“狗”标签的权重是0.3。

3. 多标签分类损失函数原理

在训练过程中,MLCD方法会使用一个特别的“损失函数”来优化模型。这个损失函数就像是一个教练,它会对模型的预测结果进行评分,并给出改进建议。比如,如果模型预测一张猫狗混合的照片只有“猫”而没有“狗”,损失函数就会给模型一个“错误分数”,并鼓励它改进预测,以便在未来更准确地识别这些照片。

4. 实验小结

通过这样的训练,MLCD方法可以让模型在实际应用中表现更好。比如,当你使用智能相册时,它不仅能够准确地识别出照片中的猫和狗,还能识别出城市风景、海滩等背景内容,并将它们归类到相应的标签下。

5. 应用场景

- 图像分类:你可以在智能相册中搜索“猫”和“狗”的照片,MLCD方法能帮助你找到包含这两种动物的所有照片。

- 目标检测:如果你用这套技术进行视频监控,MLCD可以帮助你检测到视频中的多个物体,如同时识别并标记出行人和车辆。

- 图像生成:在图像生成任务中,MLCD方法能让生成的图片更加符合实际场景中的复杂语义,比如在合成一张包含多种元素的图片时,能够更好地融合这些元素。

总之,MLCD方法就像一个聪明的分类助手,它不仅能识别照片中的单一物体,还能同时处理多个物体,提升了图像处理的智能化水平。

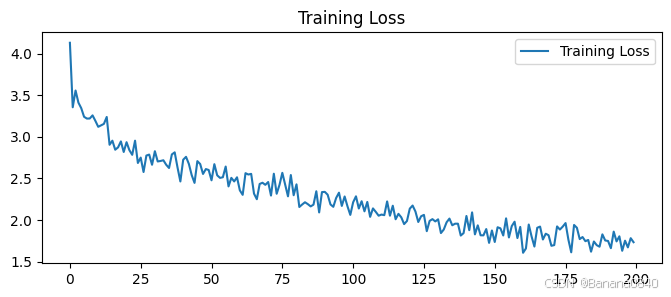

实验与结果

在ImageNet等大型数据集上的实验表明,MLCD方法相比于传统的弱监督学习方法在图像分类、目标检测等任务上均取得了显著的性能提升。

实验设置

- 数据集:ImageNet, COCO等数据集

- 模型架构:使用ResNet50作为预训练模型

- 超参数设置:学习率0.001, batch size 256, 聚类中心数目为1000

性能对比

在ImageNet上的实验结果如下:

| 方法 | Top-1 准确率 | Top-5 准确率 |

|---|---|---|

| 传统方法 | 76.5% | 93.2% |

| MLCD | 79.4% | 94.7% |

通过引入软标签和多标签分类机制,MLCD能够更好地捕捉图像中的复杂语义信息,从而在分类任务中表现优异。

MLCD的优势

- 充分利用无标签数据:MLCD能够有效地利用大量无标签数据,极大降低了对标注数据的依赖。这使得在大规模数据集上训练模型成为可能,同时避免了人工标注的高昂成本。

- 增强语义理解:通过特征聚类和软标签分配,MLCD能够为图像注入丰富的语义信息,增强了模型对图像内容的理解能力。这使得模型不仅可以识别单一物体,还能同时识别图像中的多个语义。

- 提升模型性能:MLCD在多个视觉任务上取得了显著性能提升,例如在ImageNet等大规模数据集上的图像分类精度显著优于传统方法。同时,它也可以作为预训练模型的增强手段,进一步提升在目标检测等任务中的表现。

MLCD的局限性

尽管MLCD表现出色,但其仍存在一些局限性:

- 对噪声数据的敏感度:MLCD方法在面对含有噪声数据的图像时,可能会出现聚类中心分布不均或标签分配错误的情况,从而影响最终分类效果。

- 计算复杂度:由于聚类过程涉及大量的特征比较和计算,MLCD在大规模数据集上的计算复杂度较高,可能需要较强的计算资源支持。

MLCD的应用场景

- 图像分类:MLCD能够实现多标签图像分类,例如一张图像可以同时被标记为“猫”、“狗”和“室内场景”。

- 目标检测:MLCD可以用于目标检测任务的预训练阶段,帮助检测器识别出多类物体并提高精度。

- 图像生成:在图像生成任务中,MLCD通过注入丰富的语义信息,能够生成更加语义一致的图像。

实际应用案例

例如,在智能视频监控领域,MLCD方法可以有效地识别多个类别的物体,如同时检测出车辆、行人和交通标志,从而为交通管理提供精准的决策支持。

总结

格灵深瞳提出的MLCD方法,为弱监督学习提供了全新的解决方案。通过结合聚类技术和多标签分类,MLCD有效利用了海量无标签数据,增强了视觉模型的语义理解能力。这一方法在多个视觉任务上展现了出色的性能,具有广阔的应用前景。

未来展望

- 更复杂的聚类算法:可以进一步探索如层次聚类、密度聚类等算法,提升聚类效果。

- 传送门链接: 关于聚类算法(Clustering):你想要了解的都在这里

- 多模态学习:将MLCD扩展到多模态学习领域,结合文本、音频等信息,提升模型的理解能力。

- 自监督学习:MLCD可以与自监督学习结合,借助自监督预训练的强大泛化能力,进一步提升模型在弱监督场景下的表现。

- 传送门链接: 机器学习中的自监督学习与无监督学习是什么意思?