大型语言模型和其他形式的生成式人工智能(GenAI) 的广泛使用带来了许多组织可能没有意识到的安全风险。幸运的是,网络和安全提供商正在寻找方法来应对这些前所未有的威胁。

随着人工智能越来越深入地融入日常业务流程,它面临着泄露专有信息、提供错误答案或完全“产生幻觉”不存在的事实的风险。

必须通过新的政策和程序来应对这些陷阱,以确保人类对人工智能助手的监督——以及对不了解使用人工智能风险的人类进行监督和培训。

如果你考虑 [AI] 网络需求和安全风险,你会发现,你对业务数据和业务流程的集成越多,风险就越大。

想象一下,一个 AI 应用程序可能会直接集成到票务系统中,根据模型训练的智能接收票务并进行路由。

现在,该应用程序直接与业务流程集成。这会带来更多风险,因为很明显,如果该模型被黑客入侵,它可能会扰乱业务流程。

仅使用专有信息训练大型语言模型(LLM) AU 就会带来巨大的知识产权泄露风险,因为人工智能可能会在无害的答案中泄露商业或公司机密。

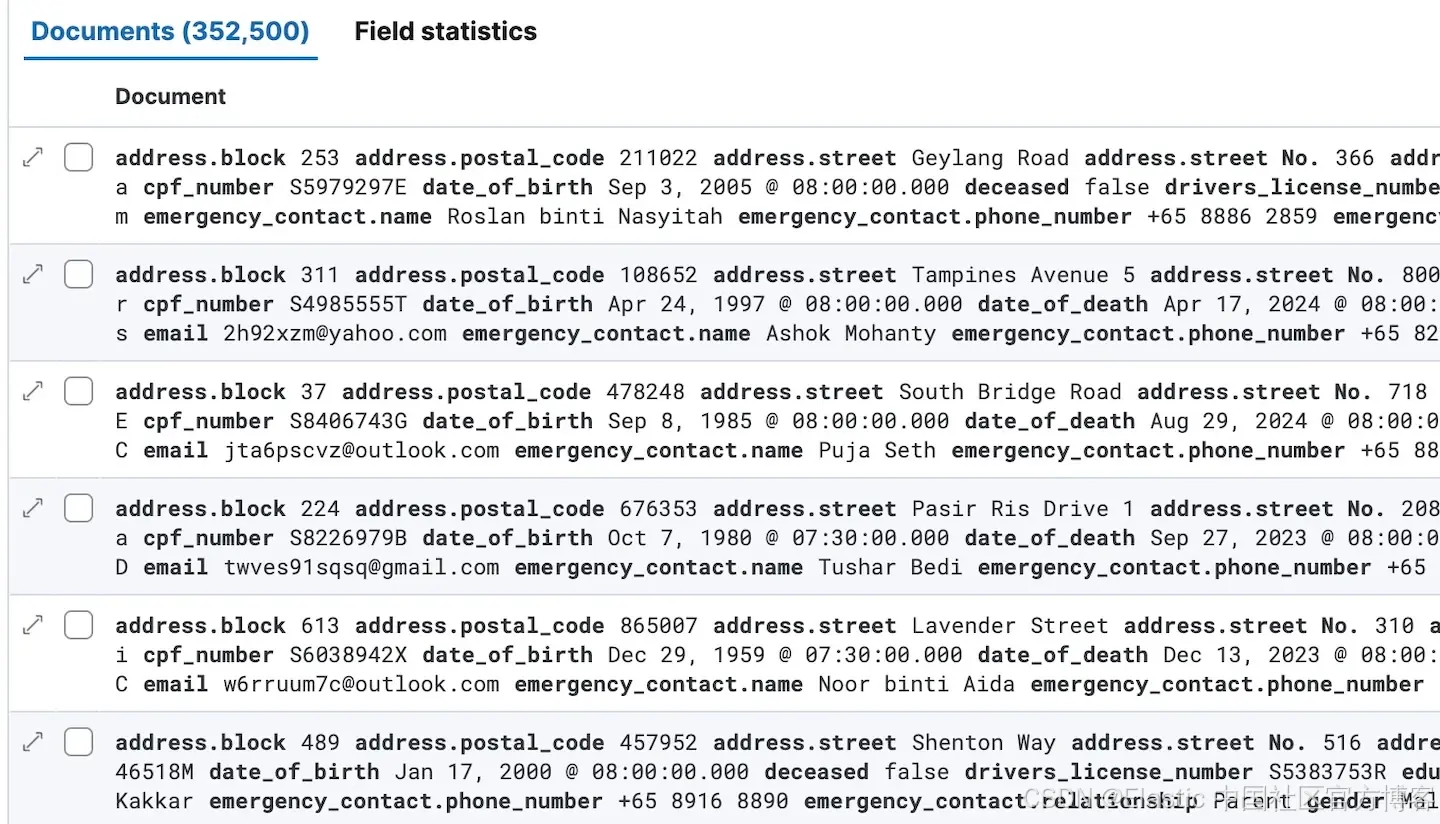

同样,让人工智能接触敏感的个人信息可能会无意中导致人工智能公开这些细节。

这些 LLM GenAI 引擎的功能之一是,它们可以发现人类无法发现的东西。

如果你想把这些发现暴露给那些不应该接触到它的人,他们可能比你更了解你的业务。

护栏至关重要

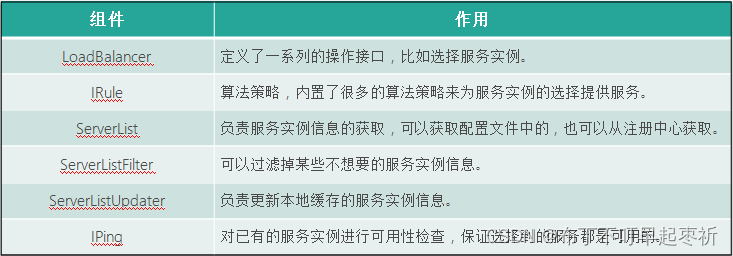

人工智能需要护栏。最重要的是控制人工智能可以访问哪些内容。

你需要制定正确的政策,以控制访问和保护数据隐私。在将这些应用程序更多地集成到流程中时,良好的访问控制和数据保护安全实践是首要前提。

Gen AI 的安全模型也强调数据丢失预防,这一术语应该扩大到涵盖更多内容。

现在有一个新术语叫做知识泄露预防,因为人工智能不仅仅涉及你的信用卡信息或PII 敏感数据,它实际上涉及你的知识产权。

人工智能的威胁防护

人工智能安全方法的第三支柱是威胁防护,阻止针对人工智能模型的各种类型的恶意攻击,这些攻击通常是旧伎俩的新花样。

就像所有可以使用的技术一样,它也可以被滥用。我们看到的攻击方式类似,但又有所不同。过去通常有 SQL 注入,现在有命令注入。还有数据中毒,我们知道 DNS 是如何被中毒的。情况类似。这些攻击很难识别。

威胁防护是一个很大的领域,OWASP 十大攻击实际上已经确定了人工智能安全领域的一些新兴类别。所以这是另一个需要关注的领域。

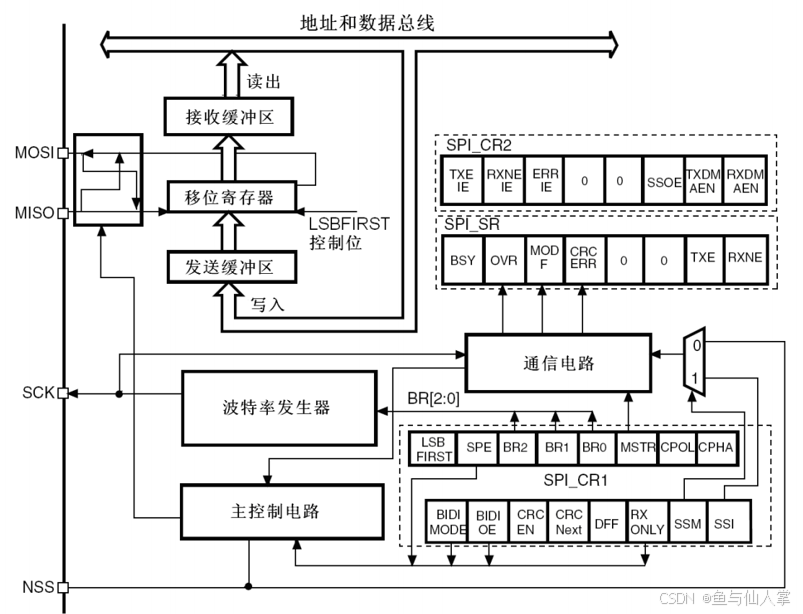

统一 SASE 即服务产品中的“一次性”数据包检查流程如何快速路由和保护 AI 网络流量。

一旦打开数据包流,你就可以做所有事情了,你要进行 QoS、压缩、WAN 优化,然后将其用于访问控制。

你可以根据用户、应用程序、位置、各种 URL、声誉、DNS、域等进行访问控制。

然后,你使用检测、签名匹配、异常、协议异常等对同一事物进行威胁防护,然后进行 CASB,匹配任何类型的 DLP。

安全性和效率

归根结底,这一切都是为了平衡安全性和效率。

如果使用太多安全产品,性能就会下降。如果试图简化变更管理和规则控制流程,实际上可能会降低其安全性。

如果试图加快速度,实际上会损害流程。因此,存在性能、灵活性、安全性等各种权衡。