大数据测试 Hive 数据库详细教程

- 一、环境准备

- 二、Hive 数据库功能测试

- 1. 创建表

- 2. 插入数据

- 3. 查询数据

- 4. 使用条件过滤查询

- 5. 删除数据

- 三、Hive 数据库性能测试

- 1. 查询响应时间

- 2. 大数据量查询测试

- 3. 分区表性能测试

- 4. 并发查询性能

- 四、Hive 数据完整性测试

- 1. 数据加载完整性验证

- 2. 数据校验

- 3. 数据导入验证

- 五、Hive 安全性测试

- 1. 用户权限测试

- 2. Kerberos 身份认证

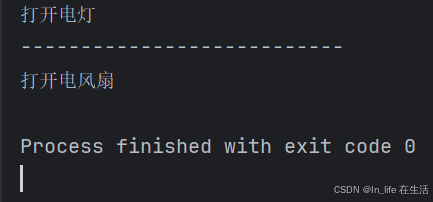

- 六、Hive 测试的自动化

- 1. Python 自动化测试

- 2. 使用 Apache JMeter

在大数据项目中,Hive 被广泛应用于批量数据存储和查询。测试 Hive 数据库的功能和性能是确保其正常工作的关键步骤。本文将详细介绍如何进行 Hive 数据库的测试,涵盖功能测试、性能测试、数据完整性测试和安全性测试,并提供详细的测试实例。

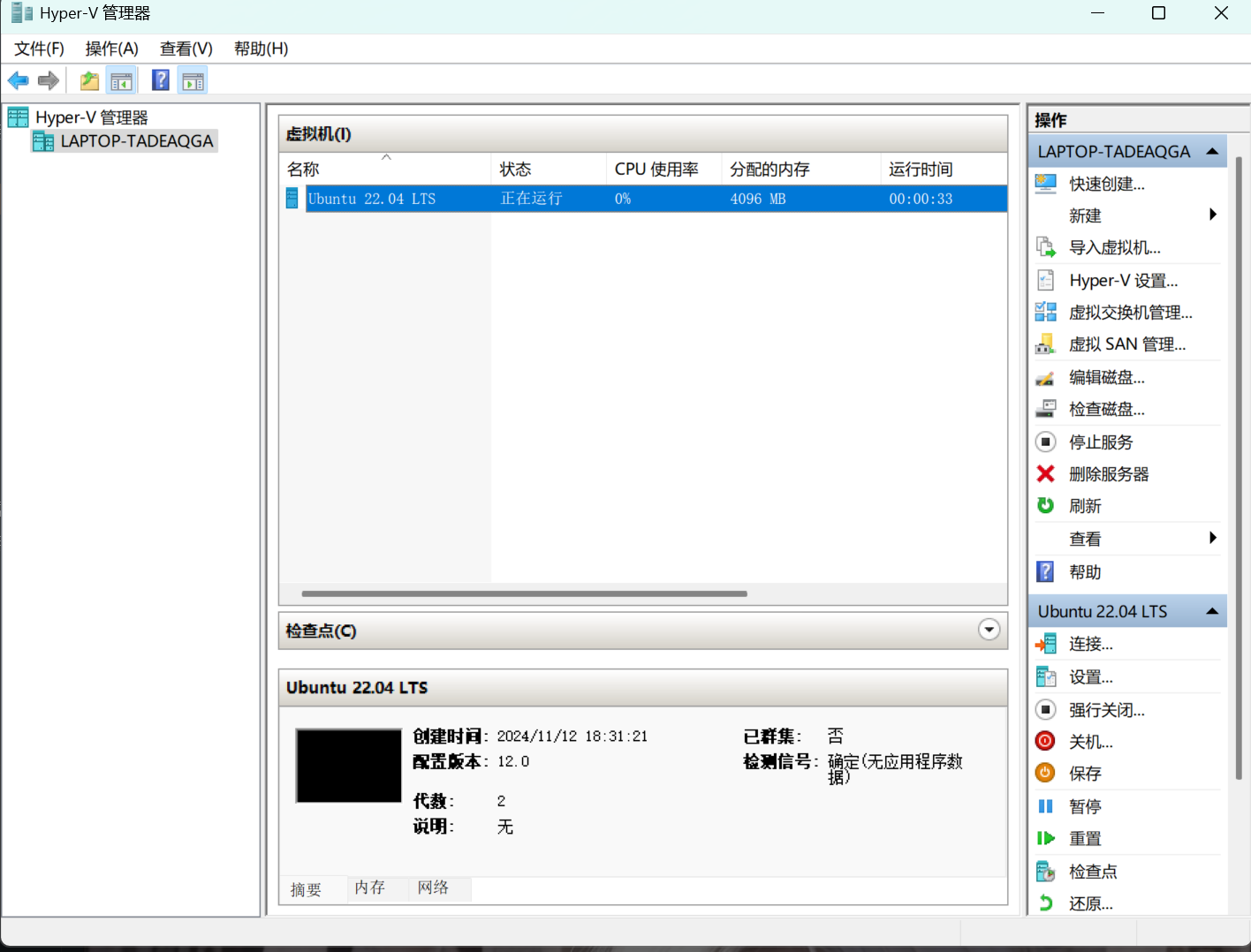

一、环境准备

-

安装 Hadoop 和 Hive 环境

确保已安装并配置 Hadoop 和 Hive 环境。以下是环境准备步骤:

- 安装 Hadoop,配置 HDFS 和 YARN。

- 安装 Hive,配置 Hive 与 Hadoop 集群的连接。

- 配置

hive-site.xml文件。

-

启动服务

start-dfs.sh # 启动 HDFS start-yarn.sh # 启动 YARN hive --service metastore # 启动 Hive metastore 服务 hive # 启动 Hive shell

二、Hive 数据库功能测试

功能测试主要验证 HiveQL 语句的正确性,确保数据能按预期操作。

1. 创建表

首先,验证 CREATE TABLE 语句是否能够创建表:

CREATE TABLE employees (id INT,name STRING,salary FLOAT

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

STORED AS TEXTFILE;

2. 插入数据

插入数据到 employees 表,测试 INSERT INTO 语句。

INSERT INTO employees (id, name, salary)

VALUES (1, 'Alice', 50000),(2, 'Bob', 60000),(3, 'Charlie', 70000);

3. 查询数据

使用 SELECT 语句查询数据,确保查询结果符合预期。

SELECT * FROM employees;

查询输出:

| id | name | salary |

|---|---|---|

| 1 | Alice | 50000 |

| 2 | Bob | 60000 |

| 3 | Charlie | 70000 |

4. 使用条件过滤查询

测试条件查询,验证是否按条件过滤数据。

SELECT * FROM employees WHERE salary > 55000;

查询结果:

| id | name | salary |

|---|---|---|

| 2 | Bob | 60000 |

| 3 | Charlie | 70000 |

5. 删除数据

测试 DELETE 语句,删除指定条件的数据:

DELETE FROM employees WHERE id = 1;

查询表数据:

SELECT * FROM employees;

查询结果:

| id | name | salary |

|---|---|---|

| 2 | Bob | 60000 |

| 3 | Charlie | 70000 |

三、Hive 数据库性能测试

性能测试主要评估 Hive 的查询效率、响应时间以及系统处理大数据时的能力。

1. 查询响应时间

使用 EXPLAIN 命令查看查询的执行计划,帮助分析查询效率。

EXPLAIN SELECT * FROM employees WHERE salary > 55000;

输出示例:

STAGE PLANS:Stage: 0Map ReduceMap Operators:TableScanalias: employeesfilter: salary > 55000Reduce Operators:FileSink

2. 大数据量查询测试

测试大数据量下的查询性能。首先加载大量数据,并进行查询:

-- 假设有一个大数据源文件,数据量较大

LOAD DATA INPATH '/path/to/large_data.csv' INTO TABLE employees;

然后,执行一个查询,观察查询响应时间:

SELECT * FROM employees WHERE salary > 50000;

3. 分区表性能测试

为了提升查询性能,Hive 支持分区表。分区表将数据根据特定字段(如日期、地区等)分成多个分区,从而优化查询效率。

创建分区表:

CREATE TABLE employees_partitioned (id INT,name STRING,salary FLOAT

)

PARTITIONED BY (year INT, month INT)

STORED AS PARQUET;

加载数据到分区表中:

LOAD DATA INPATH '/path/to/data_jan.csv' INTO TABLE employees_partitioned PARTITION (year=2024, month=1);

LOAD DATA INPATH '/path/to/data_feb.csv' INTO TABLE employees_partitioned PARTITION (year=2024, month=2);

执行查询,测试分区查询的性能:

SELECT * FROM employees_partitioned WHERE year = 2024 AND month = 1;

4. 并发查询性能

测试多个并发查询的性能,可以使用工具如 Apache JMeter 来模拟并发访问。

四、Hive 数据完整性测试

数据完整性测试主要是确保数据的准确性和一致性。以下是测试步骤:

1. 数据加载完整性验证

假设已经通过 LOAD DATA 将数据加载到 Hive 表中,可以通过以下查询验证数据完整性:

SELECT COUNT(*) FROM employees;

确保记录数与原始数据源一致。

2. 数据校验

使用聚合函数检查数据是否一致。例如,验证员工薪资总和:

SELECT SUM(salary) FROM employees;

3. 数据导入验证

确保从 HDFS 或其他数据源导入数据时,数据格式正确,字段一致性得以保持。例如:

LOAD DATA INPATH '/path/to/employee_data.csv' INTO TABLE employees;

然后通过查询验证数据是否被正确导入。

SELECT * FROM employees LIMIT 10;

五、Hive 安全性测试

Hive 提供了用户权限控制、加密等安全性功能。以下是常见的安全性测试:

1. 用户权限测试

Hive 支持基于角色的权限控制。可以使用 GRANT 和 REVOKE 来管理用户权限。

GRANT SELECT ON TABLE employees TO USER 'test_user';

REVOKE SELECT ON TABLE employees FROM USER 'test_user';

验证用户是否能执行授权的查询:

-- 登录 test_user 执行查询

SELECT * FROM employees;

2. Kerberos 身份认证

如果使用 Kerberos 进行身份认证,确保 Hive 在启动时与 Kerberos 正常集成,执行以下命令测试 Kerberos 配置:

kinit hiveuser@YOUR_REALM.COM

hive

尝试访问 Hive 进行身份验证,确保只有授权用户能访问。

六、Hive 测试的自动化

对于大规模数据和复杂查询,手动测试效率较低。可以使用自动化工具进行测试,例如通过 Python 脚本或者 Apache JMeter。

1. Python 自动化测试

使用 jaydebeapi 或 PyHive 库,自动化 Hive 查询测试:

import jaydebeapi# 连接 Hive

conn = jaydebeapi.connect("org.apache.hive.jdbc.HiveDriver", "jdbc:hive2://localhost:10000/default", ["hiveuser", "hivepassword"], "/path/to/hive-jdbc.jar")# 执行查询

cursor = conn.cursor()

cursor.execute("SELECT * FROM employees")# 获取并验证结果

results = cursor.fetchall()

assert len(results) > 0cursor.close()

conn.close()

2. 使用 Apache JMeter

Apache JMeter 是一种流行的性能测试工具,可以模拟并发查询来测试 Hive 的负载能力。

- 配置 JDBC 连接池连接 Hive。

- 编写 SQL 查询请求,模拟并发查询。

推荐阅读:

《大数据 ETL + Flume 数据清洗》,《大数据测试 Elasticsearch》,《大数据测试spark+kafka》