知识蒸馏

- 1. 知识蒸馏的核心概念

- 什么是知识蒸馏?

- 2. 知识蒸馏的关键组成部分

- (1)温度调节(Temperature Scaling)

- (2)蒸馏损失(Distillation Loss)

- (3)蒸馏流程

- 3. 知识蒸馏的主要方法

- (1)经典蒸馏(Soft Target Distillation)

- (2)中间层特征蒸馏(Feature-based Distillation)

- (3)对抗式蒸馏(Adversarial Distillation)

- (4)自蒸馏(Self-Distillation)

- 4. 知识蒸馏的优点

- 5. 知识蒸馏的实现步骤

- 6. 知识蒸馏的应用场景

- 从理论到实践全面掌握知识蒸馏

知识蒸馏(Knowledge Distillation)是机器学习中的一种技术,主要用于将一个复杂的、计算成本高的大模型(通常称为教师模型,Teacher Model)中的知识提炼并传递给一个较小的、计算高效的模型(通常称为 学生模型,Student Model)。通过这种方式,学生模型在保持接近教师模型性能的同时,具备更高的效率和更低的计算需求。

以下是系统性学习知识蒸馏的步骤:

1. 知识蒸馏的核心概念

什么是知识蒸馏?

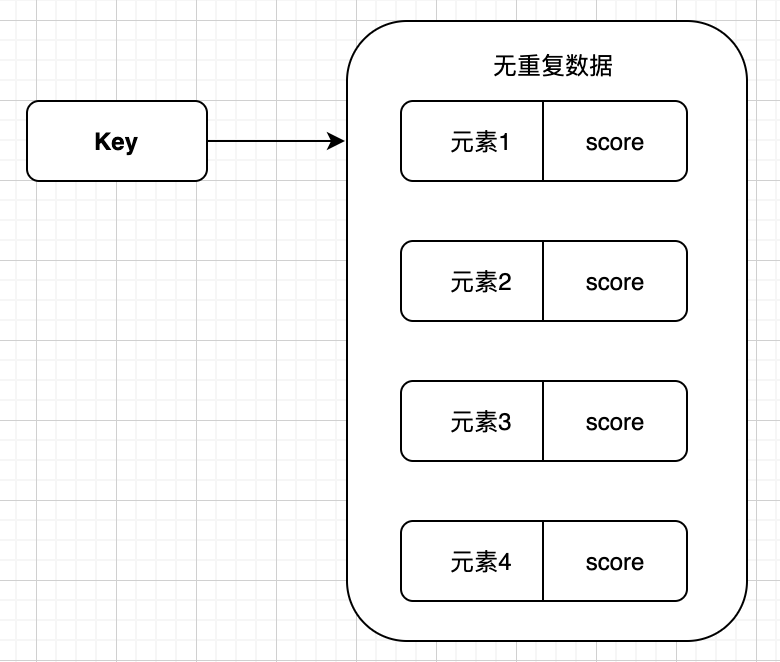

知识蒸馏是一种训练方法,重点是通过利用教师模型的输出(例如概率分布或中间特征)作为“软目标”(Soft Target),指导学生模型的训练,而不是直接依赖训练数据的真实标签(硬目标,Hard Target)。

- 硬目标(Hard Target): 常规分类问题中,每个样本的标签是确定的,例如“猫”的类别是1,其余类别为0。

- 软目标(Soft Target): 教师模型输出的概率分布,通常包含更多的信息。例如,教师模型预测“猫”的概率为0.8,但也可能预测“狗”是0.1、“兔子”是0.05,这些反映了教师对类别间关系的理解。

2. 知识蒸馏的关键组成部分

(1)温度调节(Temperature Scaling)

在知识蒸馏中,教师模型的输出概率通常会通过温度参数 T T T 进行调节:

$$

q_i = \frac{\exp(z_i / T)}{\sum_{j} \exp(z_j / T)}

$$

- z i z_i zi 是模型预测的原始得分(logits)。

- T T T 是温度参数,较高的 T T T 会使输出分布更加平滑,包含更多类别间关系的信息。

学生模型的目标是模仿教师模型的这些经过温度调节的概率分布。

(2)蒸馏损失(Distillation Loss)

知识蒸馏的训练目标是最小化以下两个损失函数的加权和:

- 蒸馏损失(Distillation Loss): 让学生模型模仿教师模型的概率分布,常用交叉熵来衡量两者的差异。

L distill = − ∑ i q i teacher log q i student \mathcal{L}{\text{distill}} = -\sum{i} q_i^{\text{teacher}} \log q_i^{\text{student}} Ldistill=−∑iqiteacherlogqistudent - 监督损失(Supervised Loss): 学生模型使用真实标签进行传统监督训练。

L supervised = − ∑ i y i true log q i student \mathcal{L}{\text{supervised}} = -\sum{i} y_i^{\text{true}} \log q_i^{\text{student}} Lsupervised=−∑iyitruelogqistudent

总损失函数:

L = α ⋅ L distill + ( 1 − α ) ⋅ L supervised \mathcal{L} = \alpha \cdot \mathcal{L}{\text{distill}} + (1 - \alpha) \cdot \mathcal{L}{\text{supervised}} L=α⋅Ldistill+(1−α)⋅Lsupervised

其中 α \alpha α 是平衡两个损失的超参数。

(3)蒸馏流程

- 先训练一个性能较好的教师模型。

- 利用教师模型生成概率分布(软目标)。

- 用上述蒸馏损失训练学生模型,使其学习教师的知识。

3. 知识蒸馏的主要方法

(1)经典蒸馏(Soft Target Distillation)

学生模型通过模仿教师模型输出的软目标概率分布进行训练,这是知识蒸馏最基础的形式。

(2)中间层特征蒸馏(Feature-based Distillation)

除了模仿最终输出概率,学生模型还可以学习教师模型中间层的特征表示,从而更好地捕捉深层信息。

(3)对抗式蒸馏(Adversarial Distillation)

将蒸馏过程视为生成对抗网络(GAN)的形式,学生模型作为生成器,教师模型的特征表示作为判别器的目标,使学生生成的输出更加接近教师。

(4)自蒸馏(Self-Distillation)

一种特殊形式,学生模型和教师模型使用相同的结构。学生模型从前几轮训练的“教师模型版本”中学习。这种方法不需要单独训练教师模型。

4. 知识蒸馏的优点

- 降低模型复杂度: 减少计算资源需求,使模型更适合部署在边缘设备或实时应用中。

- 保留教师模型知识: 学生模型不仅学习到了准确性,还能捕获类别间的潜在关系。

- 提升小模型性能: 即使学生模型参数少,通过知识蒸馏,性能通常优于直接训练的小模型。

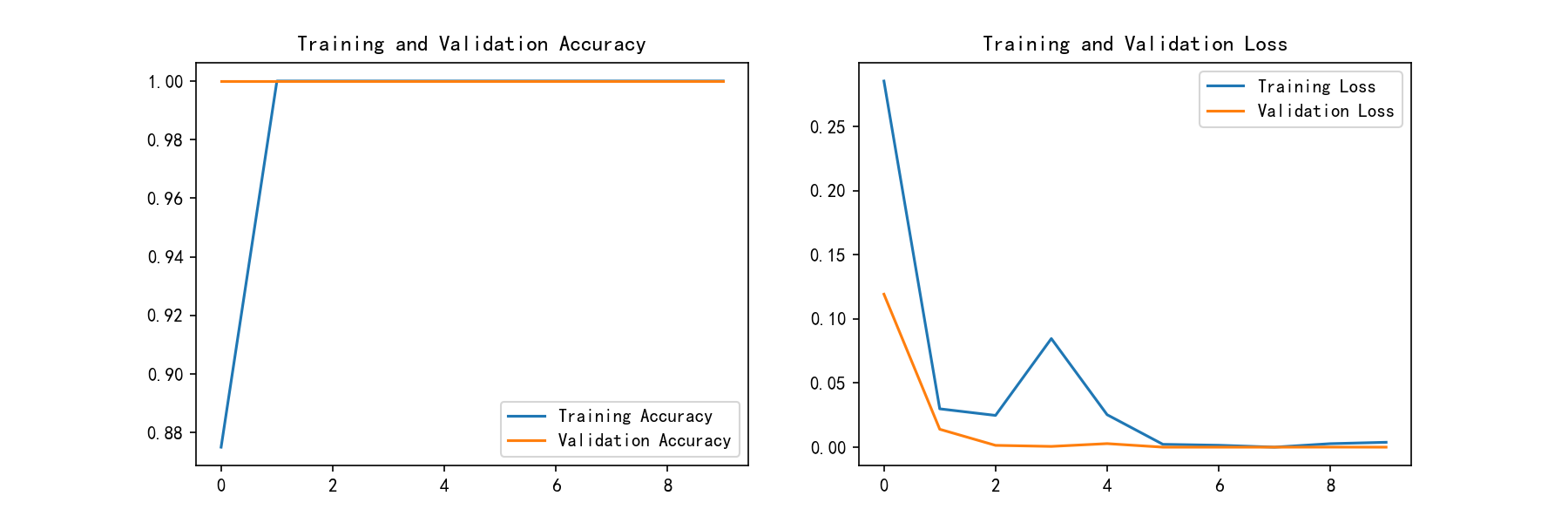

5. 知识蒸馏的实现步骤

以下是用Python(PyTorch)实现知识蒸馏的简化代码示例:

import torch

import torch.nn as nn

import torch.optim as optim# 假设已经定义好教师模型 (teacher_model) 和学生模型 (student_model)# 超参数

temperature = 4.0

alpha = 0.7 # 蒸馏损失权重

learning_rate = 0.001# 定义蒸馏损失

def distillation_loss(student_logits, teacher_logits, temperature):soft_teacher = nn.functional.softmax(teacher_logits / temperature, dim=1)soft_student = nn.functional.log_softmax(student_logits / temperature, dim=1)return nn.functional.kl_div(soft_student, soft_teacher, reduction="batchmean") * (temperature ** 2)# 优化器和损失函数

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(student_model.parameters(), lr=learning_rate)# 训练循环

for epoch in range(num_epochs):for data, labels in train_loader:# 教师模型的输出teacher_logits = teacher_model(data).detach()# 学生模型的输出student_logits = student_model(data)# 计算蒸馏损失loss_distill = distillation_loss(student_logits, teacher_logits, temperature)loss_supervised = criterion(student_logits, labels)# 总损失loss = alpha * loss_distill + (1 - alpha) * loss_supervised# 反向传播optimizer.zero_grad()loss.backward()optimizer.step()

6. 知识蒸馏的应用场景

- 模型压缩: 将大型预训练模型(如GPT-3、BERT)压缩成轻量化版本,便于在移动设备或嵌入式系统中使用。

- 迁移学习: 将复杂模型的知识迁移到特定领域的小模型中。

- 多模型集成: 用多个教师模型的输出指导单一学生模型的训练,合并多个模型的知识。

- 实时推理: 提高模型推理速度,适应低延迟场景。

通过以上步骤和知识,你可以从理论到实践全面掌握知识蒸馏!