晚上闲暇时间看到一种用于长视频语言理解的空间时间自适应压缩机制的研究工作LongVU,主要内容包括:

-

背景与挑战:多模态大语言模型(MLLMs)在视频理解和分析方面取得了进展,但处理长视频仍受限于LLM的上下文长度。

-

方法:

-

时间减少:利用DINOv2特征移除冗余帧。

-

选择性特征减少:通过跨模态查询保留关键帧的完整令牌,对其他帧进行空间池化。

-

空间令牌压缩:基于帧间的时间依赖性进一步减少令牌。

-

-

实验与结果:在多个视频理解基准测试中,LongVU显著优于现有方法,特别是在长达一小时的视频理解任务中。轻量级LongVU也展示了强大的视频理解能力。

-

消融研究:验证了各组件的有效性,包括DINOv2特征、查询引导选择和空间令牌压缩。

-

结论:LongVU通过空间时间自适应压缩,有效减少了视频令牌数量,同时保留了长视频的视觉细节,展示了在长视频理解任务中的优势。

这里主要是自己的论文阅读记录,感兴趣的话可以参考一下,如果想要阅读原文,可以看这里,如下所示:

多模态大语言模型(MLLMs)在理解和分析视频内容方面展示了显著的进展。然而,处理长视频仍然是一个重大挑战,受限于大语言模型(LLM)的上下文长度。为了解决这一限制,我们提出了LongVU,一种空间时间自适应压缩机制,能够在保留长视频视觉细节的同时减少视频令牌数量。我们的想法基于利用跨模态查询和帧间依赖性来自适应地减少视频中的时间和空间冗余。具体来说,我们利用DINOv2特征来移除表现出高相似性的冗余帧。然后,我们使用文本引导的跨模态查询来进行选择性帧特征减少。此外,我们基于帧间的时间依赖性进行空间令牌减少。我们的自适应压缩策略能够有效地处理大量帧,同时在给定的上下文长度内几乎没有视觉信息损失。我们的LongVU在各种视频理解基准测试中始终优于现有方法,特别是在长达一小时的视频理解任务中,如VideoMME和MLVU。即使在轻量级LLM的情况下,我们的LongVU也能有效地扩展到更小的规模,并保持最先进的视频理解性能。

官方项目在这里,如下所示:

1 引言

大语言模型(LLMs)(Brown, 2020; Ouyang et al., 2022; OpenAI, 2022; Achiam et al., 2023; Chiang et al., 2023; Touvron et al., 2023; Jiang et al., 2024)展示了在通用智能进步中具有重要作用的普遍能力。通过模态对齐和视觉指令调优,多模态大语言模型(MLLMs)(Alayrac et al., 2022; Li et al., 2023b; Zhu et al., 2023; Liu et al., 2024c; Ye et al., 2023; Bai et al., 2023; Chen et al., 2023c; Dong et al., 2024)在字幕生成和视觉问答等任务中展示了卓越的能力。最近的文献已经开始探索将MLLMs扩展到视频内容的理解(Li et al., 2023c; Zhang et al., 2023; Maaz et al., 2023a; Lin et al., 2023; Wang et al., 2024; Liu et al., 2024a)。尽管在特定基准测试中展示了潜力,但有效处理和理解极长的视频仍然是一个重大挑战。

一个主要原因是,考虑到先进的MLLMs使用数百个令牌表示单个图像,处理长达一小时的视频信息是不切实际的。例如,LLaVA-1.6(Liu et al., 2024b)和LLaVA-OneVision(Li et al., 2024a)分别使用576 ∼ 2,880个令牌表示每张图像,而LLaVA-OneVision使用7,290个令牌。然而,多模态训练中常用的且计算上可管理的上下文长度为8k,这限制了即使在每帧64个令牌的情况下也只能处理125帧(2分钟视频),而一小时的视频可能需要超过20万个令牌。因此,在具有额外时间维度的视频场景中,由于对过多GPU内存的需求,训练是不可行的。各种研究试图在令牌数量和帧采样频率之间建立平衡。大多数这些研究(Li et al., 2024a; Cheng et al., 2024; Zhang et al., 2024b; Chen et al., 2024)选择从视频中均匀采样固定数量的帧作为输入。然而,这些方法天真地忽略了视频中的非均匀内容,例如静态与动态场景,如图1所示。其他方法(Li et al., 2024a; Jin et al., 2023)采用密集重采样模块,显著减少了视觉令牌的数量,导致大量关键视觉信息的损失。

在这篇论文中,我们提出了LongVU,旨在尽可能多地保留帧信息,同时在不超出常用LLM的上下文长度的情况下容纳长视频。视频本质上包含显著的时间冗余。MovieChat(Song et al., 2024)采用基于相似性的帧级特征选择,使用来自CLIP的视觉表示(Radford et al., 2021)。然而,我们认为DINOv2(Oquab et al., 2023)通过在视觉中心任务上进行自监督训练,具有特征相似性目标,比视觉语言对比方法(Radford et al., 2021; Zhai et al., 2023)更有效地捕捉细微的帧差异和低级视觉特征,如图6所示。因此,(1)我们通过利用DINOv2(Oquab et al., 2023)特征的相似性,对帧序列应用时间减少策略,以移除冗余视频帧。此外,(2)我们通过跨模态查询进行选择性特征减少,同时捕捉详细的时空语义和长程时间上下文,其中我们为与给定文本查询相关的帧保留完整令牌,而对剩余帧应用空间池化以减少为低分辨率令牌表示。(3)对于过长视频,我们基于帧间的时间依赖性应用空间令牌减少机制。因此,我们的模型能够以高表现处理1fps采样的视频输入,平均每帧自适应减少令牌数量至2个,以适应MLLM在8k上下文长度内处理一小时长的视频。

为了评估我们的方法,我们在各种视频理解基准测试中进行了广泛的实验,包括EgoSchema(Mangalam et al., 2024),MVBench(Li et al., 2024b),VideoMME(Fu et al., 2024)和MLVU(Zhou et al., 2024)。我们的LongVU显著优于几个最近的开放源代码视频LLM模型,如VideoChat2(Li et al., 2024b),LongVA(Zhang et al., 2024a)和LLaVA-OneVision(Li et al., 2024a)。例如,我们的LongVU在平均准确率上比强大的开放源代码基线LLaVA-OneVision(Li et al., 2024a)高出约5%。我们还观察到,基于Llama3.2-3B(Llama, 2024)作为语言骨干的轻量级LongVU显著优于之前的小型视频LLM,例如Phi-3.5-vision-instruct-4B(Abdin et al., 2024),在VideoMME Long子集上提高了3.4%的准确率。我们的LongVU在视频理解基准测试中建立了新的最先进结果。我们相信,我们提出的方法标志着向长视频理解MLLMs迈出了有意义的进步。

2 相关工作

2.1 视觉语言模型

早期的视觉语言模型(VLMs)如CLIP(Radford et al., 2021),通过对比损失将视觉和语言嵌入投影到共享表示空间中进行训练。SigLIP(Zhai et al., 2023)采用sigmoid损失,允许进一步扩大训练批次大小并提高性能。

LLMs的发展显著推动了VLMs的进步。Kosmos-I(Huang et al., 2023; Peng et al., 2023)引入了一个端到端的框架,将视觉输入与LLM整合在一个连贯的训练体制中。Flamingo(Alayrac et al., 2022)和BLIP-2(Li et al., 2023a)分别通过交叉注意力和Q-Former模块融合视觉和语言特征。MiniGPT-4(Zhu et al., 2023)和LLaVA(Liu et al., 2024c)通过使用MLP将视觉特征直接投影到LLM嵌入空间中简化了整合。

图1展示了我们的LongVU方法相对于常用的均匀采样和密集采样的有效性。均匀采样由于其稀疏性,容易忽略关键帧。密集采样可能会超过最大上下文长度,导致目标帧的令牌被截断。相比之下,我们的方法能够自适应地进行时空压缩,既适应长视频序列,又保留更多的视觉细节。

后来的研究(Chen et al., 2023a; Peng et al., 2023; Wang et al., 2023; Chen et al., 2023c)将LMM应用扩展到更广泛的多模态任务,通过视觉定位增强空间感知。最近的努力(Liu et al., 2024a; Dong et al., 2024)旨在创建统一多种任务的通用模型,采用复杂的优化技术、高质量的多任务数据集和复杂的训练策略来提升广泛的视觉语言任务的性能。Cambrian(Tong et al., 2024)结合了多个视觉编码器的特征,并通过空间视觉聚合器(SVA)创建了一个更强大的MLLM。通过探索不同的视觉编码器,Cambrian(Tong et al., 2024)发现SigLIP(Zhai et al., 2023)是一个强大的语言监督模型,而DINOv2(Oquab et al., 2023)在视觉中心任务上表现出色。

2.2 视频大语言模型

MLLMs的最新进展已将其应用扩展到视频理解任务。视频LMM通过提取和编码帧,然后将这些帧重新排列为最终视频特征来处理视频。一些工作(Li et al., 2024a; Cheng et al., 2024)使用BLIP-2的Q-Former模块来融合视觉和文本特征,而其他工作(Lin et al., 2023; Luo et al., 2023; Ataallah et al., 2024a)直接连接帧特征。

在处理长视频时,上下文长度的限制不可避免地导致每帧令牌数量和输入帧数量之间的权衡。大多数现有工作(Li et al., 2024a; Ataallah et al., 2024a; Cheng et al., 2024; Zhang et al., 2024b; Li et al., 2024a)通过从视频中均匀采样帧来解决这一挑战,但这导致了视频中视觉细节的显著损失。Video-ChatGPT(Maaz et al., 2023a)采用池化模块来减少数据维度,提高处理效率。其他工作试图保留视频内容中的最大帧数。LLaMA-VID(Li et al., 2023d)采用额外的文本解码器来嵌入文本查询,以进行帧特征之间的交叉注意,并将上下文令牌压缩到每帧一个令牌,而MovieChat(Song et al., 2023)和TimeChat(Ren et al., 2023b)开发了记忆模块和时间戳感知编码器来捕捉详细视频内容。Golfish(Ataallah et al., 2024b)将长视频分割成较短的片段,独立处理每个片段,并根据用户查询检索最相关的片段。我们的工作专注于在给定的上下文长度内最大化保留视频内容中的帧(1fps),通过提出视频令牌的空间时间压缩。

2.3 视频令牌压缩

最近的方法在Transformer(Vaswani, 2017)框架内探索了动态图像令牌(Ma et al., 2023; Xu et al., 2022; Bolya et al., 2022)或视频令牌(Lee et al., 2024; Ren et al., 2023a; Choi et al., 2024)。Chat-UniVi(Jin et al., 2023)通过合并视频输入的帧特征中的K近邻令牌,扩展了MLLMs中视觉特征的动态令牌。SlowFast-LLaVA(Xu et al., 2024)均匀采样8帧进行高分辨率令牌,同时对更高帧率采样的帧进行空间池化以减少令牌数量。在我们的工作中,我们提出了一种空间时间自适应令牌减少策略,利用跨模态查询和帧间依赖性。这种方法有效地缓解了视频内容中的时间冗余,从而能够在给定的上下文长度内容纳长视频。

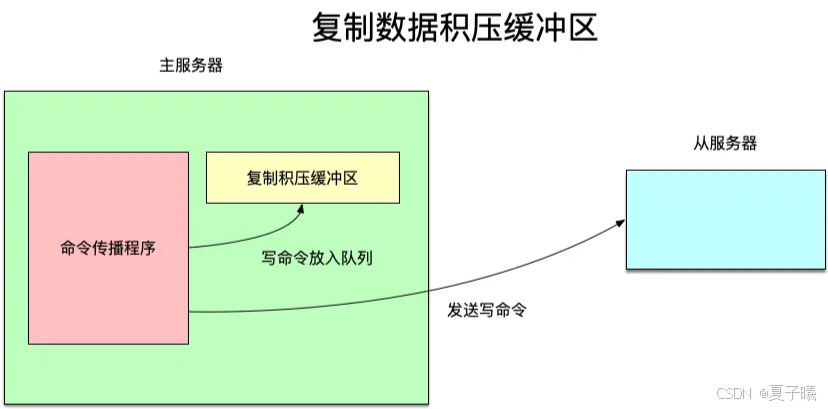

图2展示了LongVU的架构。给定密集采样的视频帧,我们首先利用DINOv2(Oquab et al., 2023)来移除冗余帧,并融合剩余帧的特征,这些特征来自SigLIP(Zhai et al., 2023)和DINOv2(Oquab et al., 2023),如第3.1节所述。然后,我们通过跨模态查询选择性地减少视觉令牌,详见第3.2节。最后,如第3.3节所示,我们基于时间依赖性进行空间令牌压缩,以进一步满足LLM的上下文长度要求。

3 方法

我们提出了空间时间自适应压缩的三个步骤,以有效处理长视频,如图2所示。首先,我们通过利用DINOv2(Oquab et al., 2023)的先验知识,对帧序列实施时间减少策略(第3.1节)。然后,我们通过跨模态查询选择性地保留关键帧的完整令牌,同时对剩余帧应用空间池化以减少为低分辨率令牌表示(第3.2节)。此外,我们基于帧间的时间依赖性实施空间令牌减少机制(第3.3节)。

3.1 帧特征提取器和时间减少

DINOv2(Oquab et al., 2023)通过在视觉中心任务上进行自监督训练,具有特征相似性目标,能够有效地捕捉细微的帧差异和低级视觉特征。相比之下,基于CLIP(Zhai et al., 2023; Radford et al., 2021)的模型在语义空间中通过视觉语言对比损失进行训练,擅长语言对齐,但牺牲了低级特征,如图6所示。此外,Cambrian(Tong et al., 2024)发现结合SigLIP(Zhai et al., 2023)和DINOv2(Oquab et al., 2023)的特征在视觉中心任务中显著提升了性能。因此,我们开创性地利用基于自监督的DINOv2(Oquab et al., 2023)和基于视觉语言对比的SigLIP(Zhai et al., 2023)作为MLLM在视频理解任务中的帧特征提取器。

注意,处理整个长视频在计算上是昂贵的。给定一个以1fps采样的视频,包含N帧,表示为I = {I1, ..., IN},我们首先使用DINOv2(Oquab et al., 2023)提取每帧的特征,得到一组DINO特征{Vdino1, ..., VdinoN}。然后,我们计算每个非重叠窗口内(J = 8帧)的平均相似性simi = 1/(J-1) Σj=1,j≠iJ sim(Vdinoi, Vdinoj),并移除与其他帧表现出高相似性的帧。这一步骤显著减少了视频冗余,通过将原始N帧时间压缩到T帧,减少了约一半的视频帧,详见第4.6节。

然后,我们使用SigLIP(Zhai et al., 2023)视觉编码器提取剩余T帧的特征,得到T个特征{Vsig1, ..., VsigT}。随后,根据Cambrian(Tong et al., 2024),我们通过空间视觉聚合器(SVA)(Tong et al., 2024)结合这两种类型的视觉特征,该聚合器使用可学习的查询来空间聚合来自多个视觉编码器的视觉特征。我们将融合后的帧特征表示为V = {V1, ..., VT}。

3.2 通过跨模态查询进行选择性特征减少

在时间减少之后,我们获得了一组来自两个视觉编码器的融合帧特征,V = {V1, ..., VT} ∈ RT×(Hh×Wh)×Dv,其中Hh×Wh表示帧特征的空间维度,Dv表示SVA后的帧特征的通道维度。如果连接的帧特征超过给定的上下文长度,即T×Hh×Wh ≥ Lmax,我们开发了一种选择性压缩策略,以捕捉详细的时空语义和长程时间上下文。

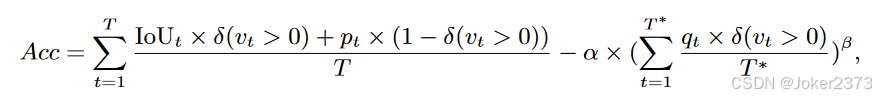

为此,我们提出使用文本查询来帮助将某些帧的空间令牌从Hh×Wh减少到Hl×Wl。给定文本查询的LLM嵌入Q ∈ RLq×Dq,其中Lq是文本查询的长度,Dq是LLM嵌入空间的维度,我们战略性地选择Nh帧以保留其原始令牌分辨率,而其余帧则通过空间池化过程减少分辨率。选择机制基于每个帧特征和文本查询之间的跨模态注意力分数。保留原始分辨率的帧数可以表示为:

其中Lmax是给定的上下文长度,F(·)表示一个基于多层感知机(MLP)的多模态适配器,设计用于将视觉特征对齐到LLM的输入空间。注意,为了简化公式1,我们省略了指令模板中的系统提示。如果Nh = 0,表示没有帧被选择保留其原始分辨率,我们将跳过注意力分数的计算,并直接对所有帧进行空间池化到较低分辨率。

3.3 空间令牌压缩

如前所述,在连接的低分辨率令牌的视觉特征仍然超过给定的上下文长度的情况下,即T×Hl×Wl ≥ Lmax,进一步的令牌压缩是必要的。在这些情况下,我们将帧特征序列划分为大小为K < T的非重叠段,在其中进行空间令牌压缩(STC)。每个窗口中的第一帧保留其完整令牌分辨率。然后,我们计算第一帧与窗口内后续帧之间的余弦相似性,对第一帧和其后继帧在相同空间位置的令牌进行逐元素比较。与第一帧在相同空间位置的令牌表现出大于阈值θ的余弦相似性的空间令牌将被修剪,可以表示为:

由于视频通常包含显著的像素级冗余,特别是在静态背景中,这种方法允许通过时间依赖性进行空间令牌减少。我们选择每个滑动窗口中的第一帧进行比较,假设DINOv2(Oquab et al., 2023)已经有效地减少了帧间的视频冗余,使得每帧的相似性较低。我们还测试了其他策略,如使用中间帧或根据帧变化自适应选择,但这些策略提供了类似的性能和压缩率。因此,我们选择在每个滑动窗口中使用第一帧策略,因为它简单且有效。

4 实验

4.1 数据集

我们在实验中采用了两阶段的训练:图像语言预训练和视频语言微调。对于图像语言预训练阶段,之前的方法(Chen et al., 2023a; Peng et al., 2023; Wang et al., 2023; Chen et al., 2023c; Liu et al., 2024a; Dong et al., 2024)通常使用两步对齐和微调。为了简单起见,我们将在LLaVA-OneVision(Li et al., 2024a)数据中的单图像数据合并为一个阶段。对于视频语言微调,我们利用了从几个公开可访问数据库中获取的大规模视频文本对。视频训练数据包含VideoChat2-IT(Li et al., 2024b)的子集,其中包括TextVR(Wu et al., 2025),Youcook2(Zhou et al., 2018),Kinetics-710(Kay et al., 2017),NExTQA(Xiao et al., 2021),CLEVRER(Yi et al., 2019),EgoQA(Fan, 2019),TGIF(Li et al., 2016),WebVidQA(Yang et al., 2021),ShareGPT4Video(Chen et al., 2024),以及作为长视频补充的MovieChat(Song et al., 2024)。所有训练数据集如表6所示。

4.2 基准测试和指标

我们在EgoSchema(Mangalam et al., 2024),MVBench(Li et al., 2024b),VideoMME(Fu et al., 2024)和MLVU(Zhou et al., 2024)上评估我们的模型。VideoMME(Fu et al., 2024)(1分钟 ∼ 1小时)和MLVU(Zhou et al., 2024)(3分钟 ∼ 2小时)是评估长视频理解能力的长视频基准测试。对于VideoMME(Fu et al., 2024),视频根据持续时间正式分割,包含从30分钟到1小时的长视频子集。我们使用贪婪解码(num_beams=1)进行标准化评估,并将我们的结果与其他开源和专有模型进行基准测试。

表1展示了在综合视频理解基准测试中的结果。

4.3 实现细节

我们使用SigLIP(Zhai et al., 2023)(so400m-patch14-384)和DINOv2(Oquab et al., 2023)作为视觉编码器,选择Qwen2-TB(Qwen, 2024)和Llama3.2-3B(Llama, 2024)作为我们的语言基础模型。我们仅计算自回归文本生成的交叉熵损失。我们使用AdamW(Loshchilov, 2017)优化器,并使用余弦调度进行所有训练。在图像语言预训练阶段,我们训练模型一个epoch,全局批量大小为128。学习率设置为1e-5,预热率为0.03。每张图像的令牌数量设置为576。对于视频语言微调阶段,我们训练模型一个epoch,全局批量大小为64。学习率设置为1e-5,预热率为0.03。每帧的最大令牌数量设置为144(Hh = Wh = 12),而每帧可能会通过我们提出的自适应压缩方法减少(≤ 64,Hl = Wl = 8)。STC减少阈值θ = 0.8,滑动窗口大小K = 8。我们的模型在64个NVIDIA H100 GPU上进行训练。

4.4 视频理解

**定量结果。**表1展示了我们在多个视频理解基准测试中的实验结果。我们的结果在各种视频理解基准测试中优于所有基线。例如,在VideoMME(Fu et al., 2024)上,我们的LongVU比VideoChat2(Li et al., 2024b)和LLaVA-OneVision(Li et al., 2024a)分别高出6.0%和2.4%。值得注意的是,在VideoMME Long子集(Fu et al., 2024)上,我们的模型比LLaVA-OneVision(Li et al., 2024a)高出12.8%。这些结果表明我们的模型具有强大的视频理解能力。注意,我们的模型在训练数据集更小的情况下实现了显著的性能提升,相比LLaVA-OneVision(Li et al., 2024a)在OneVision-1.6M(多图像,视频)上训练,该数据集尚未公开1。使用与VideoChat2-IT(Li et al., 2024b)相同的视频训练数据,我们的LongVU比VideoChat2(Li et al., 2024b)显示出更高的性能,平均准确率提高了约10%。有趣的是,我们还发现我们的模型甚至在MVBench(Li et al., 2024b)上击败了专有模型GPT4-o(OpenAI, 2024),并在其他视频基准测试中缩小了与专有模型的准确率差距。

表2展示了在视频理解基准测试中,小型视频语言模型的结果。

我们还使用轻量级LLM Llama3.2-3B(Llama, 2024)扩展了我们的LongVU,以进一步展示其强大的视频理解能力。我们在表2中观察到,轻量级LongVU在所有基线上的一致改进。我们的方法在VideoMME(Long)上比Phi-3.5-vision-instruct(Abdin et al., 2024)高出3.4%的准确率。这组实验验证了我们的方法在小规模上的有效性。

**定性结果。**我们现在在图3中提供定性结果。具体来说,我们展示了各种视频理解能力,例如在图3(a)中准确识别移动物体的方向,在图3(b)中提供详细的视频描述,在图3(c)中识别插入针的帧并进行动作计数,以及在图3(d)中对一小时长视频中的特定帧进行精确回答。这些结果表明我们的模型具有竞争性的视频语言理解能力。

4.5 消融研究

**每帧令牌数量的影响。**我们对均匀采样基线中的令牌数量进行了消融研究。每帧令牌数量和帧采样频率之间存在权衡。表3显示了使用不同令牌数量和采样频率的实验结果。当应用均匀采样时,144个令牌每帧在8k上下文长度下在VideoMME(Fu et al., 2024)和MLVU(Zhou et al., 2024)上表现出更好的性能,而在EgoSchema(Mangalam et al., 2024)上表现较差。使用144个令牌每帧保留了更多的视觉细节,但限制了总帧数,即在8k上下文长度内少于60帧。这表明需要自适应令牌以在不同视频基准测试中获得更好的性能。

**DINOv2 vs SigLIP。**表3中的结果验证了DINOv2(Oquab et al., 2023)特征比SigLIP(Zhai et al., 2023)特征更有效。正如预期的那样,我们还发现使用DINO特征进行时间帧减少优于均匀采样。因此,DINOv2(Oquab et al., 2023)是一个有用的视觉中心特征提取器,有助于进行时间减少。

图3展示了LongVU模型在各种视频理解能力方面的示例。我们展示了LongVU能够完成不同类型的视频理解任务。

**查询引导选择。**我们在时间减少后应用文本引导的帧选择,其中相关帧保留在全令牌容量(144个令牌),而其他帧减少到64个令牌。这有助于保留必要的视觉特征,并在上下文长度内容纳更多长程上下文。在表3中,我们观察到在所有基准测试中使用查询引导帧选择后的改进。此外,在表4中,MLVU(Zhou et al., 2024)中每个子任务的结果显示,使用跨模态查询时,特别是在计数和针检测等帧检索任务中,性能显著提升。

**空间令牌压缩。**我们在查询引导选择后进一步应用空间令牌压缩。我们发现空间令牌压缩(STC)不仅在8k上下文长度内增强了性能,而且在表3中实现了与16k上下文长度相当或略好的结果。我们还注意到在MLVU(Zhou et al., 2024)中的大多数子任务有所改进。

**空间令牌压缩的不同策略。**我们现在对空间令牌压缩机制的不同策略进行消融研究。此分析探索了确定锚帧的不同策略:每个滑动窗口中的第一帧/中间帧,或与其相邻帧相比表现出显著变化的帧。在表5中,我们的结果表明,在每个滑动窗口中选择第一帧给出了略好的性能和类似的减少率。

4.6 空间时间压缩分析

**压缩分析。**我们采样了数百个视频,以展示帧/令牌减少率的分布。图4(a)展示了基于DINOv2特征的帧在时间减少前后的数量。我们发现平均约45.9%的帧在时间减少后被保留。图4(b)显示了空间令牌压缩前后的令牌数量(第3.3节)。我们观察到平均约40.4%的令牌被减少。这些结果表明,通过时间和空间令牌减少,视频令牌压缩是有效的。

图4展示了我们随机采样数百个视频以展示帧/令牌级别的减少率。(a) 基于DINOv2特征的时间减少前后的帧数(第3.1节)。(b) 空间令牌压缩前后的令牌数(第3.3节)。

图5展示了Needle-in-a-Haystack任务的结果。我们的自适应令牌压缩方案将定位一小时长视频中needle帧的分数从平均0.80提高到0.88。

**长上下文分析。**最近,Needle-in-a-Haystack任务(Hsieh et al., 2024; Kamradt., 2023)被用于评估大语言模型(LLMs)检索长上下文信息的能力。我们遵循(Zhang et al., 2024a)进行视频needle-in-a-haystack实验,以展示我们的压缩策略在识别一小时长视频中的needle帧的有效性。

为了便于评估,我们随机选择MLVU(Zhou et al., 2024)中的一个一小时长测试视频。然后,我们将一组VQA问题的每个图像作为needle帧插入到这个长视频中,创建一个具有挑战性的搜索任务。我们以1 FPS采样视频,并控制帧长度从200到3.6k帧。我们还改变needle帧插入深度从0%到100%的总输入帧。我们在8k上下文长度下进行实验,并将我们的自适应令牌压缩与未应用查询引导选择(w/o Query)和空间令牌压缩(w/o STC)的时间减少后的配置进行比较。图5展示了我们的自适应压缩机制能够准确解决8k上下文长度内1k帧的needle VQA问题,并在更多帧的情况下提高分数。这展示了我们的方法在长上下文视频理解中的优势。

5 结论

我们介绍了LongVU,一个能够在常用上下文长度内解决长视频理解重大挑战的MLLM。为了实现这一点,我们提出了LongVU的空间时间自适应压缩方案,通过利用跨模态查询和帧间相似性,帮助减少视频令牌而不丢失长视频的视觉细节。在各种视频理解基准测试中的实验一致验证了我们模型的优势。我们还展示了我们的方法有助于构建基于Llama3.2-3B的高质量轻量级视频语言理解模型,这表明LongVU在视觉语言社区中有许多潜在应用。

附录

附录A 训练数据集

对于图像语言训练阶段,之前的方法(Chen et al., 2023a; Peng et al., 2023; Wang et al., 2023; Chen et al., 2023c; Liu et al., 2024a; Dong et al., 2024)通常使用两阶段的对齐和微调。为了简单起见,我们将在LLaVA-OneVision(Li et al., 2024a)数据中的单图像数据合并为一个阶段。对于视频语言微调,我们利用了从几个公开可访问数据库中获取的大规模视频文本对。视频训练数据包含VideoChat2-IT(Li et al., 2024b)的子集,其中包括TextVR(Wu et al., 2025),Youcook2(Zhou et al., 2018),Kinetics-710(Kay et al., 2017),NExTQA(Xiao et al., 2021),CLEVRER(Yi et al., 2019),EgoQA(Fan, 2019),TGIF(Li et al., 2016),WebVidQA(Yang et al., 2021),ShareGPT4Video(Chen et al., 2024),以及作为长视频补充的MovieChat(Song et al., 2024)。所有训练数据集如表6所示。

附录B 帧级位置编码

为了缓解帧间特征连接可能引起的混淆,我们引入了帧级位置编码,以强化帧间的时间边界并捕捉每个帧内的相互依赖性。由于我们减少了多个帧,直接连接所有帧使得模型无法感知帧间的时间步长。此外,我们的动态令牌采样策略没有明确划分每个帧的边界。为了解决这个问题,我们引入了帧级位置嵌入(FPE),对应于每个帧的绝对时间步长,使用共享的正弦位置编码(Vaswani, 2017),如公式3所示。

PE(t, 2i) = sin(t/100002i/d),PE(t, 2i+1) = cos(t/100002i/d)

表8和表9中的消融研究表明,添加FPE对多个基准测试的整体性能影响不大。因此,我们决定不在默认设置中包含它。

附录C DINOv2 vs SigLIP

DINOv2(Oquab et al., 2023)通过在视觉中心任务上进行自监督训练,具有特征相似性目标,能够更有效地捕捉细微的帧差异和低级视觉特征,如图6所示。

附录D 视频中的Needle-In-A-Haystack

我们使用8k上下文长度进行了实验,评估了我们的默认设置(包含自适应压缩)与未应用空间令牌压缩(w/o STC)和未应用查询引导减少(w/o Query)的配置,如图7所示。通过整合跨模态查询以选择性地保留与文本查询相关的帧的全令牌,模型在总视频帧数少于1.4k时显著提高了准确识别关键帧的能力。此外,我们的自适应令牌压缩机制在增加帧数时进一步提高了VQA准确率。

附录E 限制

我们的研究主要集中在视频理解任务上,在视频监督微调(SFT)阶段使用仅视频数据。如表10所示,我们观察到在视频SFT后模型在图像理解能力上有所下降。一个潜在的补救措施是在训练过程中整合图像、多图像和视频数据的混合。然而,由于GPU资源的限制,