作者:刘聪NLP(NLP算法工程师)

文章经过作者同意转载

作为一个NLP工程师,自22年11月30号起,我的心态的从焦虑到平静再到焦虑,每天的感觉就像做过山车一样,跌宕起伏,只因它-ChatGPT。

今天决定好好聊一聊,所见、所闻、所感。

心态为何如此波动?

第一次焦虑,在ChatGPT刚刚出来的一个月内,我跟几个同事对其进行深入探讨后,陷入了深思--“下一步我们要做什么?”。当NLP模式发生改变的时候,我们要拿什么去做回应,是不是即将被淘汰,如何抓住这一次变革所带来的机遇,焦虑和兴奋伴随着每一个日夜。于是开始了理论的学习,去了解LaMda[1]、Sparrow[2]和InstructGPT[3]。

疯狂的人总会慢慢恢复理智,于是进入了平静期。过多测试之后,越发现,生成模型在事实性上依然存在很大的问题,特别是在一本正经的胡说八道时,越发觉得可怕。细思极恐,如果使用者真的不了解,真的照做了怎么办?

并且,工作在小厂的我,无卡无人无数据,根本没有资格去碰T5及之后的模型,那么我们该如何去做这样的工作。当知道一件事情是我/我们不可为的时候,会快速地选择躺平。虽然每天都会对其关注,时而对其调侃测试,但只有一种想法,与我何干。

再一次焦虑,来自于全民的追捧。当身边所有人,无论是AI从业者,还是AI非从业者,都在谈论ChatGPT时;当朋友圈10条有8条都是ChatGPT时;当知乎每日几条ChatGPT热搜时;当客户问我们,公司什么时候会有ChatGPT时;当老板拉着一起讨论及强调ChatGPT重要性时;当劝说所有人停下来看看,却无人理时;当不管谁都敢说自己即将拥有ChatGPT时,我焦虑了,太焦虑了。

个人感觉,这种焦虑至少要持续到3月份吧,需要看看以百度为首的几大厂到底可以做到什么程度。但在这期间,并不影响我们的思考,我们要努力去拥抱它。

特别喜欢一句话:“压力不会消失,只会转移”。

ChatGPT为何能引起轰动?

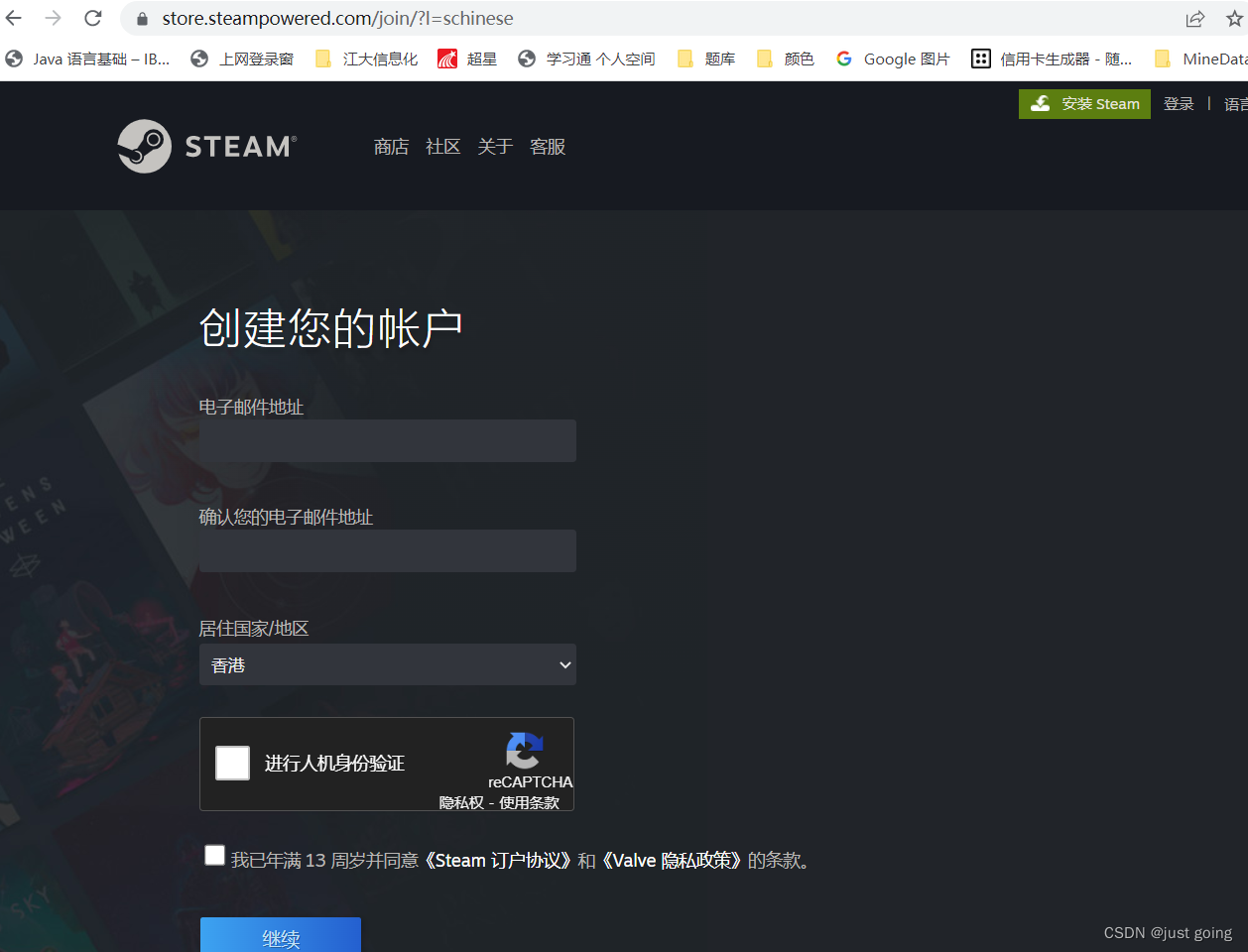

相较于之前OpenAI宣传的大模型GPT3,所有人只需注册账号,即可有免费体验,轻松得进入到了大众的视野。如果说22年12月份是AI从业者的狂欢,那么23年就是非从业的狂飙。

ChatGPT对于AI外人员来说,是一个太强大的工具了,可以无脑获取想获取的内容,无论对错,炫酷即可;极具冲击力的交互体验,让其对AI又重拾了希望,畅想着Moss的到来。

ChatGPT对于AI从业者来说,是一个思路的扩充,大模型不只是刷榜的玩具,而是可以在战场上激情挥霍的加特林;在它的加持下,所有人都认识到高质量数据的重要性,更加坚信“有多少人工,就会有多少智能”。并且从大模型的响应速度上,就足以让我们汗颜,不知后面又多少服务器在支撑,在工程上做了多少的优化。

很多人也从中看到了商机,有人靠卖号、卖服务,有人靠内容创作用到知乎、贴吧、小红书等赚取个人流量,甚至美国大学生用其写作业等等,当然也有一些人被骗。这里难免会存在很多大手在操控,像@平凡(知乎)大佬 所说:“对于这种风口类型的东西,别被骗钱,收智商税就算是挣钱了。”

我觉得ChatGPT的爆火&成功是OpenAI坚持的结果。2018年OpenAI提出GPT模型,在风头不如BERT的情况下,再次提出GPT2模型;随着Google提出T5模型之后,再次提出GPT3模型,依然是自回归语言模型,并将“参数至上和数据至上”的思想发挥到了极致。非常赞同@张俊林(知乎)大佬所说:“国内LLM在做这方面技术选型的时候,貌似很多都走了Bert双向语言模型或T5混合语言模型的技术路线,很可能方向走偏了。”[4] 而ChatGPT的爆火,还是因为经历了很多人的检验,在高质量人工校验数据下,使得模型生成的友好性、安全性更加完善,对测试结果的惊艳远远大于犯错。

特别喜欢@Naiyan Wang(知乎)在群里说的一句;“信仰是需要对问题的深刻认知才会产生的,不是无脑allin;也是多次小规模的验证才慢慢建立起来的,而不是一蹴而就。”

ChatGPT如何进行国产化?

ChatGPT的效果,虽然依赖于高质量标注数据、RLHF 技术等,但是也离不开强大的底座GPT3模型(text-davinci-002)。而这强大的底座,就需要庞大的45TB数据及1024张A100算力才能完成训练,甚至需要多轮迭代。很多学者都认为,国内大厂距离OpenAI的LLM技术至少1-2年。

我认为在数据层面,百度、腾讯、字节、知乎是有很强优势的;在算力层面,百度、阿里、腾讯、华为也是有很大优势的。通过OpenAI的提示,各大厂应该也不会再吝啬高质量标注,人海战术在国内还是有一定优势的,毕竟学生可以成为廉价劳动力。

但说句实话,国内也做了很多大模型,我就不一一举例了(都得都懂),感觉都是在刷榜玩,放出来测得,很多都不行,真是一个能打的都没有。

目前,很多大厂都已经放出狠话,都正在进行国产化ChatGPT的研发与测试。百度三月份完成内测,阿里已经在进行内测了,360、字节、快手、京东等都再进行,只希望到时候不被打脸。但目前从股票上来看,是“秦始皇摸电线,赢麻了”。

如果真的在广泛测试中,得到了大众的认可,我收回“一个能打的都没有”这句话,可别到时候变成一个产品发布会,一堆PR文,然后就没有然后了,根本就测不到看不到摸不着。

如果真的有一家成功,论证该事情的可行性,那么国内大厂应该都能做出来,只是时间长短的问题,是3个月还是6个月还是一年了。对于我们这种小厂来说,要不然调用大厂API受人限制;要不然建立企业联合会,集几家之力训练ChatGPT,几家共用;要不然直接原地解散。

如果真的没有一家做成,感觉需要各大厂联合发力了。其实,我对国内能做出来的东西的预期,只是ChatGPT的60%,差不多就算成功了,也不知道为啥这么想。

ChatGPT在应用上的问题

个人做了这么久的问答和生成任务,答案的真实及可控性依然困扰着我,虽然ChatGPT的大部分的回复使我感到惊艳,但作为一个NLP算法工程师,不能抱着娱乐至上的想法去看待这个问题。

在很多真实问答场景中,人们是不能接受犯错的,例如:“双十一优惠政策”,假设生成回复是“满300减300”,商家岂不是亏死;“鸡蛋一般煮多久”,假设生成回复是“5min”,恭喜你吃了个生蛋;假如生成回复中包含了政治内容、事实性错误、偏见问题,该如何解决,这些都是生成模型无法避开的话题。就Google新品Bard来说,仅因发布会回复答案的一个事实性错误,股价直接暴跌6%。而微软在新Bing的发布会上的例子也只是旅游类开放性问答。

而在ToB的企业场景上,往往是不允许出现事实性错误的,ChatGPT真的可以用在ToB场景吗?针对于无法连接外网的企业来说,如何使用API进行访问?真的有很多企业可以购买设备进行本地部署吗?仅在购买API的情况下,如何将通用接口进行领域数据优化?还是可以不优化,通用即最优?如何保证企业内部数据的保密性,Prompt泄露信息怎么办?那么,置信内容与生成融合、领域Prompt规范化、设备部署会成为我们重点攻克的课题。

对于ToC来说,娱乐至上,一定会有一些不轨之徒,将其用在刀刃上。那么内容检测将来一定会是一个重点,当ChatGPT生成内容泛滥时,我们如何进行检测,判断哪些是真实人写的,哪些是机器生成的。虽然目前已经存在一些内容检测工具,例如:openai自身提供的检测器(虽然仅有26%)[5], @蝈蝈 (知乎)大佬的“中英双语ChatGPT检测器”[6];但只能说,在检测的路上依然是任重而道远。

我们会被ChatGPT所取代吗?

我觉得最多是工种的改变,以前驾马车的,现在开滴滴了。

可能对于很多NLP工程师来说,以前被称为炼丹师的我们,即将成为小药童。无需调整配方,只需拿拿原材料,在炉外扇扇扇子就好了。很悲观的说法,从前需要魔改网络,2018年只需对Bert进行finetune,2023年只需要In-Context Learning了吧,只能拿着别人大模型的API找找prompt了。

但,毕竟不是所有企业,会支持外网、购买设备等。既然Bert横行的时代,都还存在TextCNN。为什么ChatGPT大模型的时代,容不下我们呢?

参考资料

[1]

LaMDa: https://arxiv.org/abs/2201.08239

[2]Sparrow: https://arxiv.org/abs/2209.14375

[3]InstructGPT: https://arxiv.org/abs/2203.02155

[4]通向AGI之路:大型语言模型(LLM)技术精要: https://zhuanlan.zhihu.com/p/597586623

[5]AI text classifier: https://platform.openai.com/ai-text-classifier

[6]中英双语ChatGPT检测器: https://zhuanlan.zhihu.com/p/598395917

END

分享

收藏

点赞

在看