本周AI界又有哪些新鲜事?

基础核心

高通推出将AD和ADAS整合的Snapdragon Ride Flex芯片

在新一年的国际消费电子展上,高通推出专门给汽车设计的处理器芯片Snapdragon Ride Flex。据了解,该芯片提供的解决方案可以将自动驾驶(AD)和高级驾驶辅助系统(ADAS)整合到一个芯片上。

据该公司表示,通过将数字驾驶舱、ADAS和自动驾驶汽车(AV)功能整合到单个系统芯片(SoC)上,汽车制造商将能无缝整合具有高质量图形的驾驶舱显示器、信息娱乐游戏显示器和后座娱乐屏幕。

高通公司高级副总裁兼总经理Nakul Duggal在“CES 2023”上接受采访时表示:“如果我能够以更低的成本为更多的车辆带来同样的能力,为什么不愿意去做呢?因此,你所看到的Flex是一个(满足)这两个(OEM要求)的组合。”

知名IT人士爆料OPPO将自主开发智能手机处理器

知名IT博主IceUniverse爆料,OPPO将开发自家的移动应用处理器。据其表示,目前OPPO拥有数千人的芯片开发团队,预计在2024年推出搭载自家应用处理器的产品。而一直以来,OPPO主要采用高通骁龙的芯片处理器。

事实上,在目前的智能手机制造商中,拥有自家处理器的企业并不多,包括三星电子、苹果、谷歌等厂商。华为自主研发的麒麟芯片虽然业界知名,但于2020年因为众所周知的原因停止了生产。

此外,也有业内人士预测,该应用处理器最快可于2023年第三季度量产,届时很可能采用4纳米的工艺技术,由台积电TSMC代工。但截至目前,具体信息尚未公开。

资本市场

Meta正在收购智能眼镜公司Luxexcel

经Meta证实,该司正在收购智能眼镜公司Luxexcel。这家公司成立于2009年,通过3D打印来制作眼镜的光学镜片,可通过LCD显示屏和全息膜等集成技术进行打印。

据Meta发言人表示,“我们很高兴Luxexcel团队加入Meta,加深了两家公司现有的合作关系。”此前,Meta和Luxexcel已经在Project Aria有过合作,这个项目聚焦在公司的增强现实(AR)研究计划上。

但截至目前,此次收购的主要条款尚未披露。

前沿技术

DeepMind的机器学习模型可在60秒内预测10天内的天气

通过卫星遥感预测天气是进行天气预报的传统技术,但一直以来都因为准确性差强人意而被寄予新的技术革命。近日,DeepMind推出一款基于机器学习的天气模拟器,据说可以在60秒内预测10天内的天气,而且准确率相当高。

这款名为GraphCast的天气模拟系统基于图神经的自回归模型构建,理论性能超越世界上其他机器学习天气预报系统。但如此高的性能并不需要多么复杂的设备打底,只需单台Cloud TPU v4便可以形成35GB的高量数据。

与传统预测方法相比,基于ML的预测数据可以更好地拓展。而通过对更大量和更高质量的数据进行训练,未来的天气预测可以持续改进。

Meta AI自监督学习框架data2vec 2.0比其他算法提升16倍

日前,Meta AI发布了自监督学习框架data2vec 2.0。相比一年前发布的上一代data2vec 1.0,data2vec 2.0在性能上进一步改进。在精度相同的情况下,训练速度比其他算法提升了16倍之多。

相较于监督学习,自监督学习能够从数量级更大的数据中进行学习,在计算机视觉和自然语言处理等领域取得很大成绩,包括Collobert-Weston 2008 model、Word2Vec、GloVE、fastText、BERT、RoBERTa、XLM-R等模型。

对于自然语言处理任务,通过在语言理解评估基准GLUE上的评估,发现data2vec 2.0仅需要一半的时间便可以达到与BERT重新实现RoBERTa的相同的精度。

产业生态

通过人工智能回答搜索查询,加持ChatGPT的Bing能否打赢Google?

据外媒The Information 最新发布的一篇报道显示,微软可能会在 2023 年 3 月之前在Bing中应用ChatGPT,用人工智能来回答一些搜索查询。

具体来看,旧版本的GPT可以在用户输入时自动提供搜索查询建议。如今,微软已经宣布计划Dall-E2模型集成到Bing Image Creator中,方便用户可以在其中发出描述性文本提示并生成AI图稿。

The Information称这“可能会在今年3月底之前推出”,而Bing可能被定位为“免费访问部分GP的唯一方式”。按照OpenAI的计划,他们将会对 ChatGPT采取收费政策,对此,外媒也将微软评价为“为初创公司的云账单买单”的企业。

热点争论

ICML禁大语言模型生成论文,引各界AI大佬热议

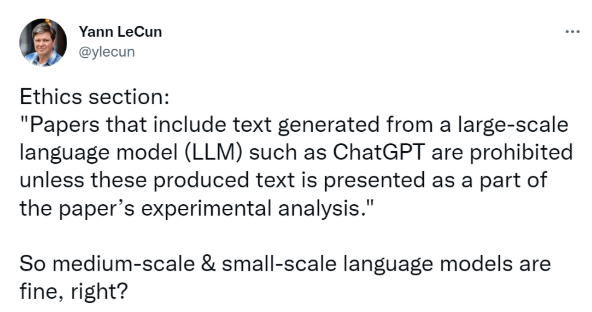

日前,国际机器学习会议(ICML)发布了2023年的论文征文公告。提交日期为1月9日至1月26日。在该公告中,一条关于提交论文需遵守的道德准则引起了纷纷议论。

规定原文是:禁止包含从大规模语言模型(LLM)(如ChatGPT)生成文本的论文,除非这些生成的文本作为论文实验分析的一部分呈现。

此言一出,学术圈各位大佬纷纷发表自己对此的观点,Yann LeCun针对该规则的“逻辑漏洞”的回复幽默又不失嘲讽:“大型语言模型不能用,意思是中型和小型语言模型还可以用。”

AAAI前主席Thomas Dietterich则表示:“这个规定很怪,对于一个人工智能会议来说更是如此。我们应该欢迎所有为科学技术做出贡献的文章,不论作者是否接受了AI的辅助。”