激活函数总结(十七):激活函数补充

- 1 引言

- 2 激活函数

- 2.1 Parametric Exponential Linear Unit(PELU)激活函数

- 2.2 Phish激活函数

- 3. 总结

1 引言

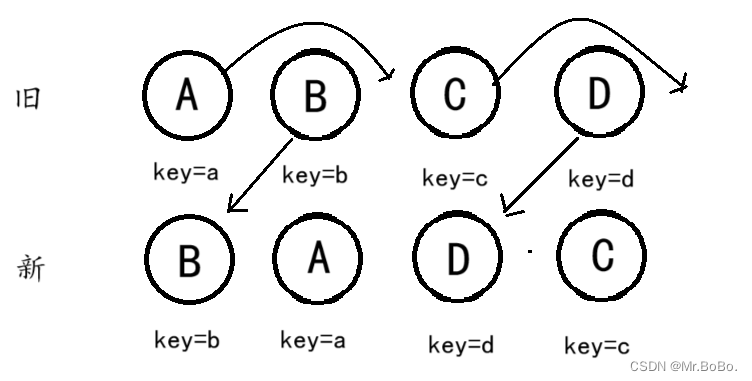

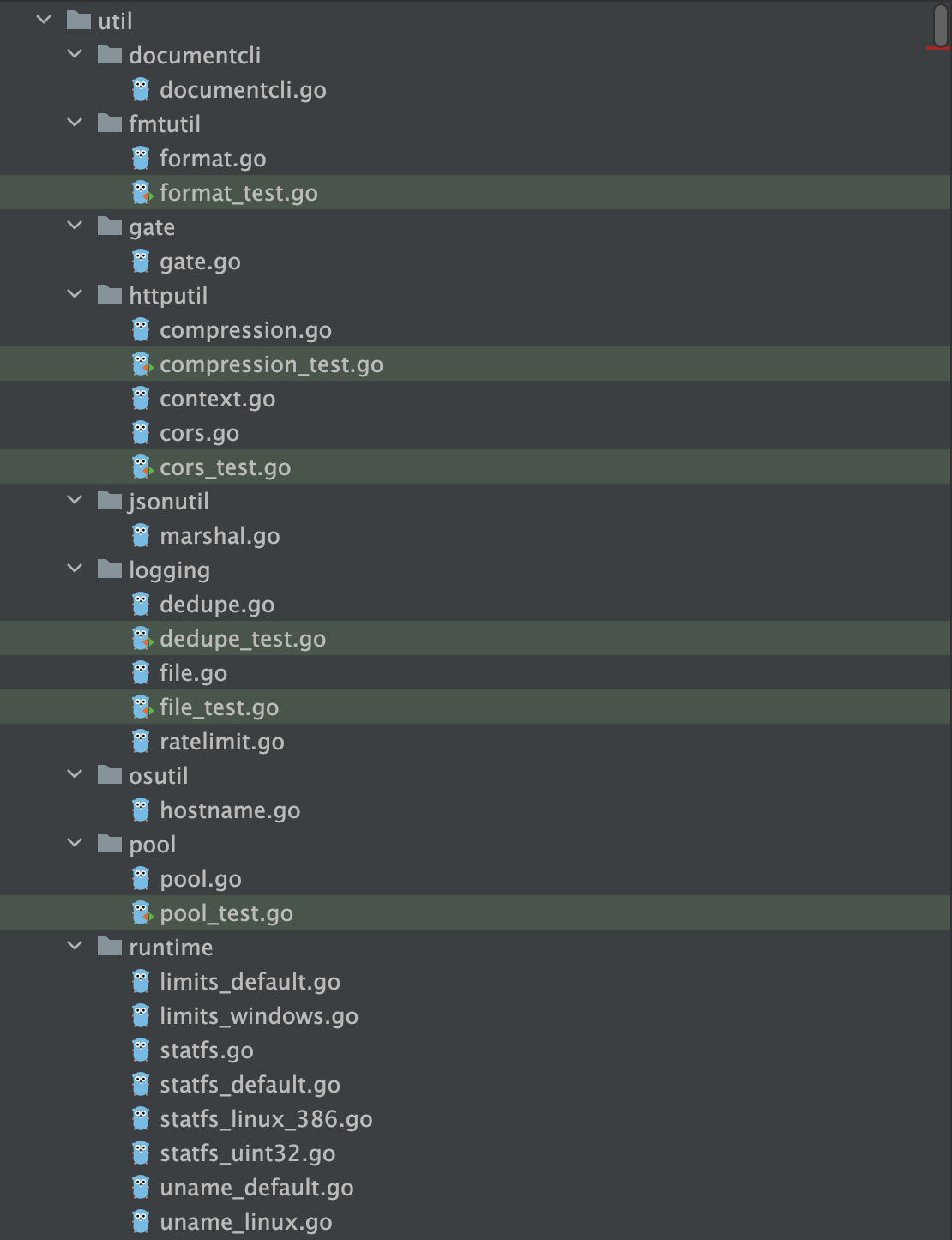

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp、Gaussian 、GCU、ASU、SQU、NCU、DSU、SSU、SReLU、BReLU)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

2 激活函数

2.1 Parametric Exponential Linear Unit(PELU)激活函数

Parametric Exponential Linear Unit(PELU)是一种 Exponential Linear Unit(ELU)的变种激活函数,它引入了可学习的参数,允许网络自适应地调整激活函数的形状。其数学表达式为和数学图像分别如下所示:

f a , b ( x ) = { a ( e x b − 1 ) , for x < 0 a b x , for 0 ≤ x f_{a,b}(x)= \begin{cases} a(e^{\frac{x}{b}} - 1), & \text{for } x < 0 \\ \frac{a}{b}x, & \text{for } 0 \leq x \\ \end{cases} fa,b(x)={a(ebx−1),bax,for x<0for 0≤x

优点:

- 非线性特性: PELU 引入了

非线性特性,使得网络能够更好地适应数据中的复杂模式。 - 可学习参数: PELU 允许

学习参数,这意味着网络可以根据数据和任务需求自适应地调整激活函数的形状。 - 避免梯度消失: 对于负的输入,PELU 引入了

指数项,这有助于在一些情况下避免梯度消失问题。 - 平滑性: PELU 在负的输入范围内是

平滑的,这有助于梯度计算和反向传播的稳定性。

缺点:

- 计算复杂性: 相对于一些简单的激活函数(如 ReLU)而言,PELU 的

计算复杂性较高,尤其是因为它涉及指数计算。 - 参数选择: 学习参数需要额外的

调整和调优,这可能需要更多的实验。

需要注意的是,PELU 激活函数可以作为一种探索性尝试,具有自适应形状的特点可能对某些问题有益。然而,在使用之前,您应该仔细考虑其优点和缺点,并在实验中评估其在具体任务和数据上的性能。

2.2 Phish激活函数

论文链接:Phish: A Novel Hyper-Optimizable Activation Function

Phish 是一种新颖的激活函数。它是一个GELU和TanH的复合函数,其数学表达式为和数学图像分别如下所示:

f ( x ) = x ∗ T a n H ( G E L U ( x ) ) f(x) = x*TanH(GELU(x)) f(x)=x∗TanH(GELU(x))

优点:

- 连续可微:在观察到的域上的

微分图中没有明显的不连续性 - 新颖:该激活函数是

2022年提出的 - 有效性:实验结果表明Phish激活函数具有

较好的效果。

缺点:

- 缺乏验证:虽然论文中说明具有较好效果,但是未经过

广泛验证

虽然该算法在论文中呈现出较好的效果,但是当前仍未经过有效验证。。。。

3. 总结

到此,使用 激活函数总结(十七) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。

![[Stable Diffusion教程] 第一课 原理解析+配置需求+应用安装+基本步骤](https://img-blog.csdnimg.cn/959dc5785b154c708100f8b356b9e262.png)