目录

Redis网络模型

用户空间和内核态空间

阻塞IO(BIO)

非阻塞IO(NIO)

IO多路复用

信号驱动IO

异步IO(AIO)

Redis到底是单线程还是多线程?

为什么要使用单线程?

Redis网络模型

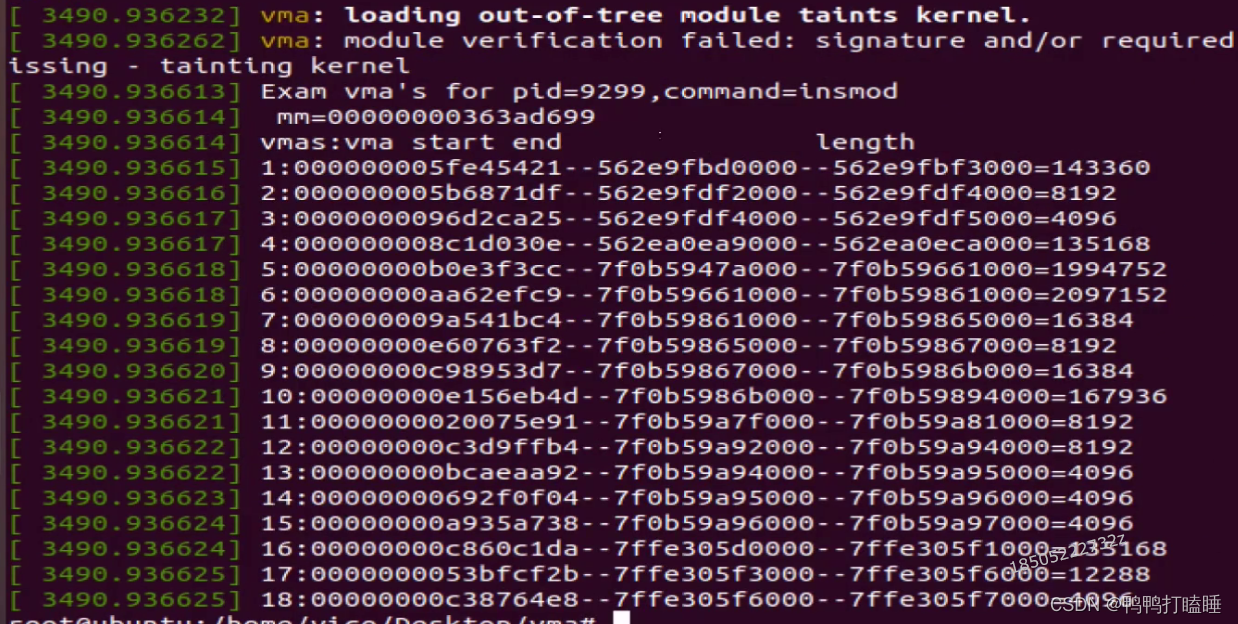

进程的寻址空间会划分为两部分:内核空间、用户空间

用户空间和内核态空间

用户空间只能执行受限的命令(Ring3),而且不能直接调用系统资源,必须通过内核提供的接口来访问

内核空间可以执行特权命令(Ring0),调用一切系统资源

Linux系统为了提高IO效率,会在用户空间和内核空间都加入缓冲区:

-

写数据时,要把用户缓冲区数据拷贝到内核缓冲区,然后写入设备

-

读数据时,要从设备读取数据到内核缓冲区,然后拷贝到用户缓冲区

阻塞IO(BIO)

用户空间和内核空间的交互:

阻塞IO具体流程:

-

用户去读取数据时,会先发recvfrom命令,尝试从内核态加载数据

-

如果内核态没有数据,那么用户就要等待

-

此时内核会从硬件上读取数据

-

内核读取数据后,会把数据拷贝到用户态.返回ok

以上整个过程都是阻塞等待,这就是阻塞IO

总结:

阻塞IO就是两个阶段都必须阻塞等待

阶段一:

-

用户进程尝试读取数据(比如网卡数据)

-

此时数据尚未到达,内核需要等待数据

-

此时用户进程也处于阻塞状态

阶段二:

-

数据到达并拷贝到内核缓冲区,代表已就绪

-

将内核数据拷贝到用户缓冲区

-

拷贝过程中,用户进程依然阻塞等待

-

拷贝完成,用户进程解除阻塞,处理数据

非阻塞IO(NIO)

非阻塞IO的recvfrom操作会立即返回结果而不是阻塞用户进程

阶段一:

-

用户进程尝试读取数据(比如网卡数据)

-

此时数据尚未到达,内核需要等待数据

-

返回异常给用户进程

-

用户进程拿到error后,再次尝试读取

-

循环往复,直到数据就绪

阶段二:

-

将内核数据拷贝到用户缓冲区

-

拷贝过程中,用户进程依然阻塞等待

-

拷贝完成,用户进程解除阻塞,处理数据

-

可以看到,非阻塞IO模型中,用户进程在第一个阶段是非阻塞,第二个阶段是阻塞状态。虽然是非阻塞,但性能并没有得到提高。而且忙等机制会导致CPU空转,CPU使用率暴增。

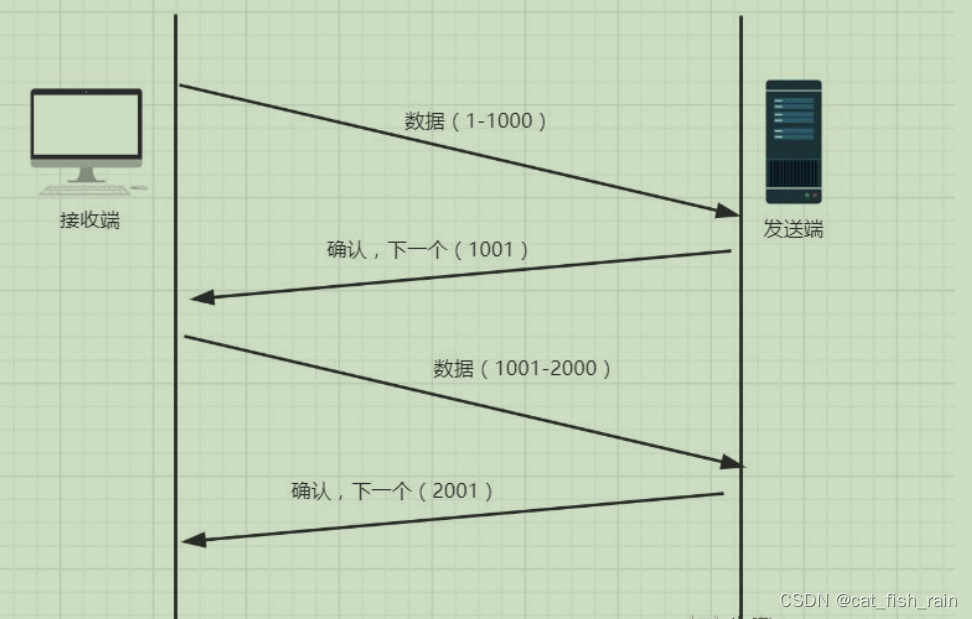

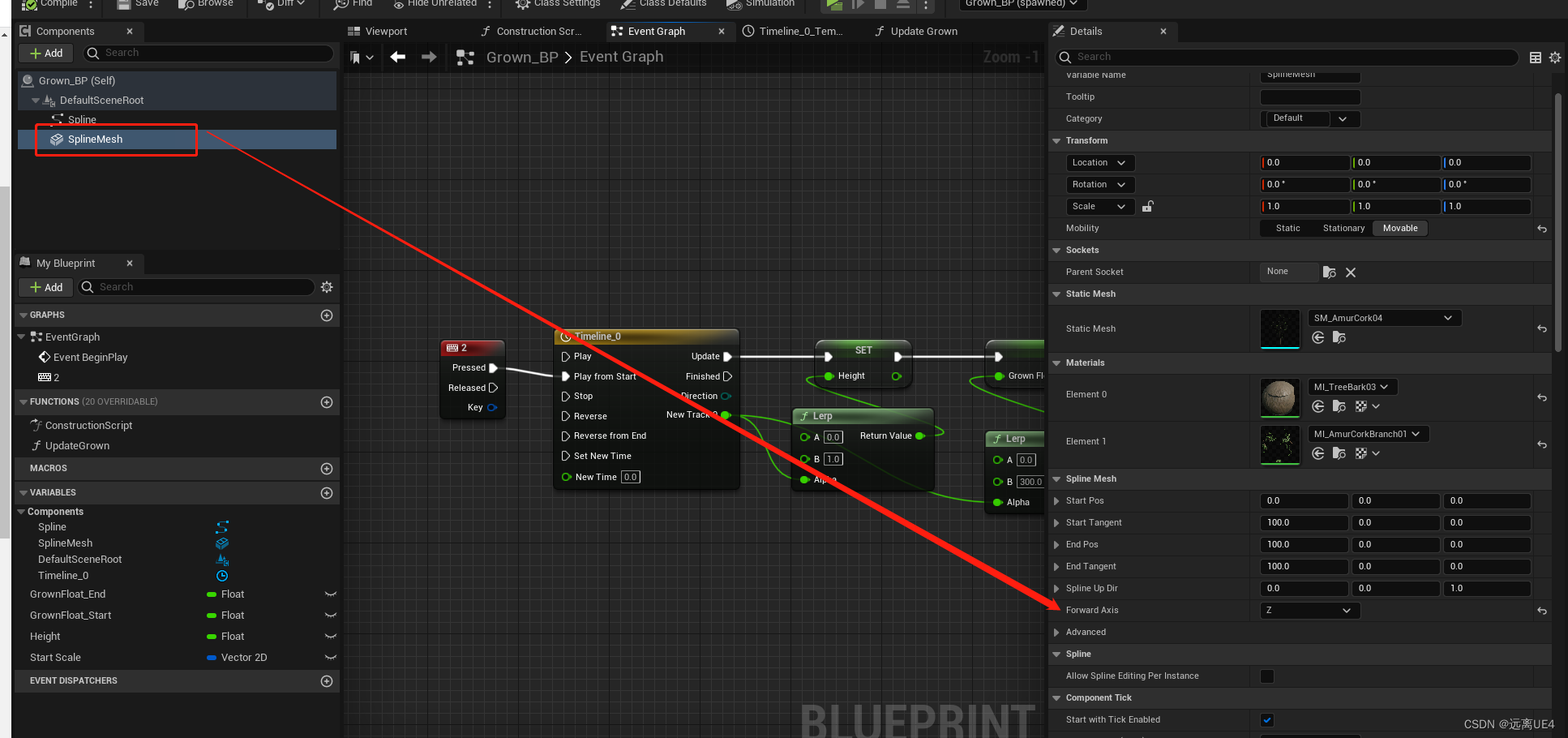

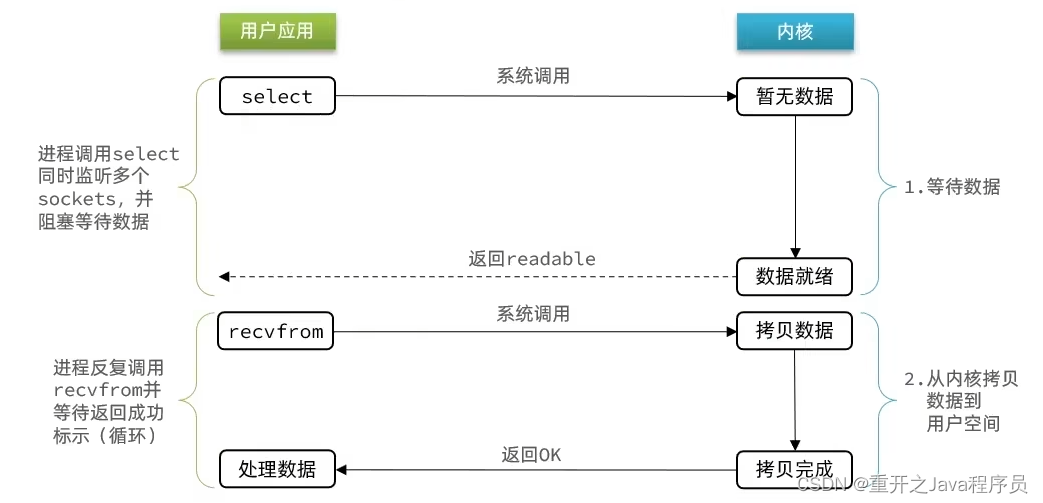

IO多路复用

无论是阻塞IO还是非阻塞IO,用户应用在一阶段都需要调用recvfrom来获取数据,差别在于无数据时的处理方案:

-

如果调用recvfrom时,恰好没数据,阻塞IO会使进程阻塞,非阻塞IO会使CPU空转,都不能充分发挥CPU作用

-

如果调用recvfrom时,恰好有数据,则用户进程可以直接进入第二阶段,读取并处理数据

这就像服务员给顾客点餐,分两步:

-

顾客思考吃什么(等待数据就绪)

-

顾客想好了,开始点餐(读取数据)

提高效率的方法:

-

增加多线程(但是也不是最好的方案)

-

不排队,谁想好了吃什么(数据就绪),服务员就给谁点餐(用户应用就去读取数据)

问题:用户进程如何知道内核中数据是否就绪呢?

文件描述符(File Descriptor):简称FD,是一个从0开始递增的无符号整数,用来关联Linux中的一个文件,Linux中,一切皆文件

IO多路复用:单个线程同时监听多个FD,并在某个FD可读,可写时得到通知,从而避免无效的等待,充分利用CPU资源

监听FD的方式、通知方式有多种实现:

-

select

-

poll

-

epoll

差异:

-

select和poll只会通知用户进程有FD就绪,但是不确定是哪一个,用户需要逐个遍历FD

-

epoll则会通知用户进程FD就绪的同时,把已经就绪的FD写入用户空间

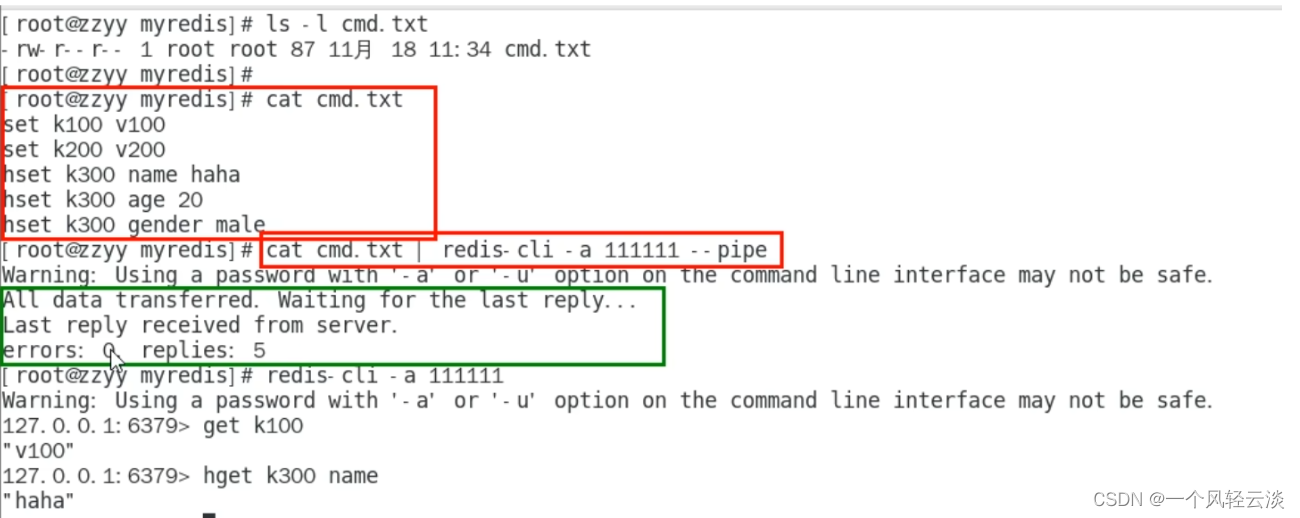

信号驱动IO

是与内核建立SIGIO的信号关联并设置回调,当内核有FD就绪时,就会发出SIGIO信号通知用户,期间用户应用就可以执行其他业务,无需阻塞等待.

问题:

当有大量IO操作时,信号较多,SIGIO处理函数不及时导致信号队列溢出.

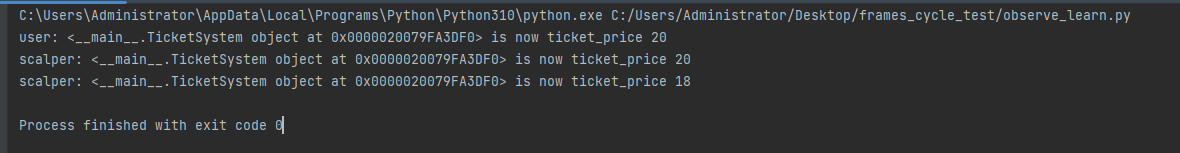

异步IO(AIO)

整个过程是非阻塞的,用户进程调用完异步API后就可以去做其他事情,内核等待数据就绪并拷贝到用户空间后才会递交信号,通知用户进程

需要控制并发,否则高并发下可能会崩溃

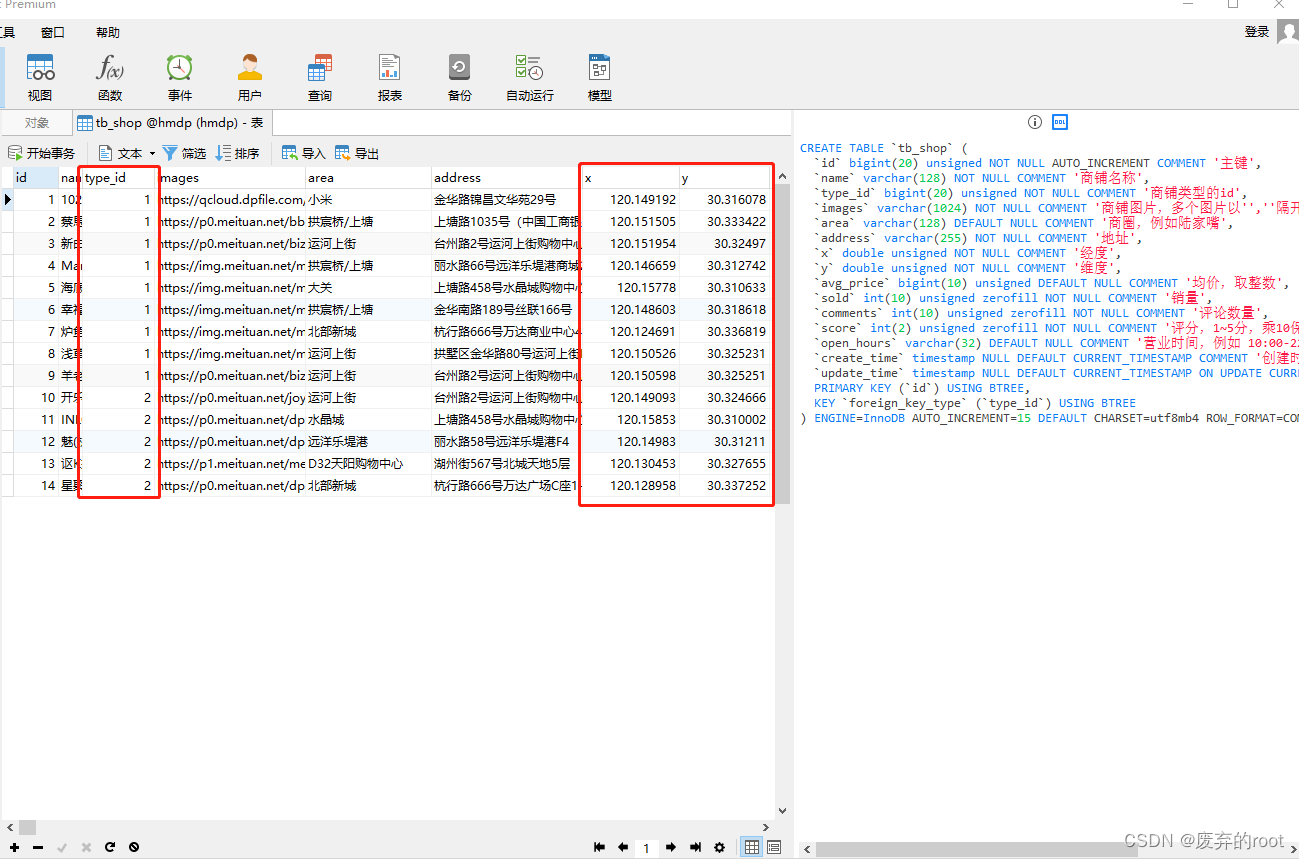

Redis到底是单线程还是多线程?

-

如果仅仅聊Redis核心业务部分(命令处理),是单线程

-

如果聊整个Redis,那就是多线程

Redis v4.0:引入多线程异步处理一些耗时较长的任务,例如异步删除命令unlink

Redis v6.0:在核心网络模型引入多线程,进一步提高多核CPU利用率

为什么要使用单线程?

-

Redis是纯内存操作,执行速度非常快,它的性能瓶颈是网络延迟而不是执行速度,因此多线程带来不了多大提升

-

多线程会导致过多的上下文切换,带来不必要的开销

-

引入多线程会有线程安全问题,必然要引入锁,性能也就会降低