文章目录

- 一、ALIGN

- 二、Contrastive Language-Image Pre-training(CLIP)

- 三、Learning Cross-Modality Encoder Representations from Transformers(LXMERT)

- 四、BLIP: Bootstrapping Language-Image Pre-training

- 五、Vision-and-Language BERT(ViLBERT)

- 六、VisualBERT

- 七、OSCAR

- 八、Vision-and-Langauge Transformer(ViLT)

- 九、OFA

- 十、ALBEF

涉及使预训练适应视觉和语言(V-L)学习领域的模型,并提高视觉问答和视觉字幕等下游任务的性能。

根据杜等人的说法。 (2022),来自不同模态的信息可以通过三种方式进行编码:融合编码器、双编码器以及两者的组合。

一、ALIGN

在 ALIGN 方法中,视觉和语言表示是从噪声图像替代文本数据中联合训练的。 图像和文本编码器是通过对比损失(表述为归一化 softmax)来学习的,对比损失将匹配的图像-文本对的嵌入推到一起,并将不匹配的图像-文本对的嵌入推开。 该模型学习使用对比损失来对齐图像和文本对的视觉和语言表示。 这些表示可用于仅视觉或视觉语言任务转移。 无需任何微调,ALIGN 即可实现零样本视觉分类和跨模式搜索,包括图像到文本搜索、文本到图像搜索,甚至联合图像+文本查询的搜索。

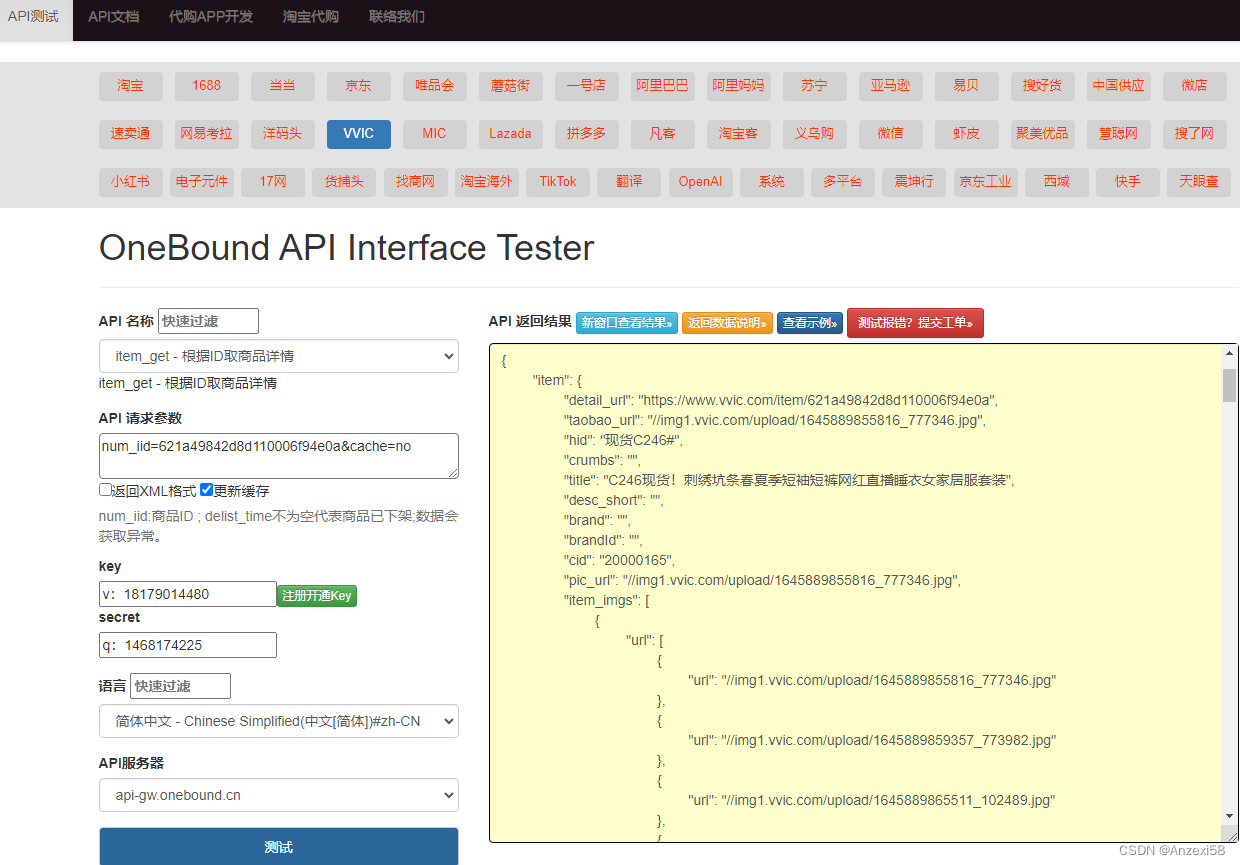

二、Contrastive Language-Image Pre-training(CLIP)

对比语言-图像预训练(CLIP)由从头开始训练的 ConVIRT 的简化版本组成,是一种从自然语言监督中学习图像表示的有效方法。 ,CLIP 联合训练图像编码器和文本编码器来预测一批(图像,文本)训练示例的正确配对。 在测试时,学习的文本编码器通过嵌入目标数据集类的名称或描述来合成零样本线性分类器。

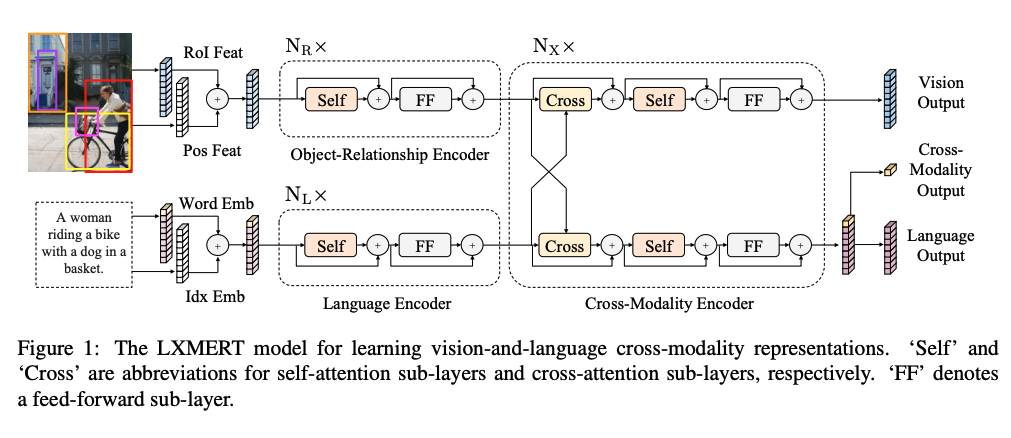

三、Learning Cross-Modality Encoder Representations from Transformers(LXMERT)

LXMERT 是一个用于学习视觉和语言跨模态表示的模型。 它由一个 Transformer 模型组成,该模型由三个编码器组成:对象关系编码器、语言编码器和跨模态编码器。 该模型接受两个输入:图像及其相关句子。 图像被表示为对象序列,而每个句子被表示为单词序列。 通过结合自注意力层和交叉注意力层,模型能够从输入生成语言表示、图像表示和跨模态表示。 该模型通过五个预训练任务使用图像-句子对进行预训练:掩码语言建模、掩码对象预测、跨模态匹配和图像问答。 这些任务帮助模型学习模态内和跨模态关系。

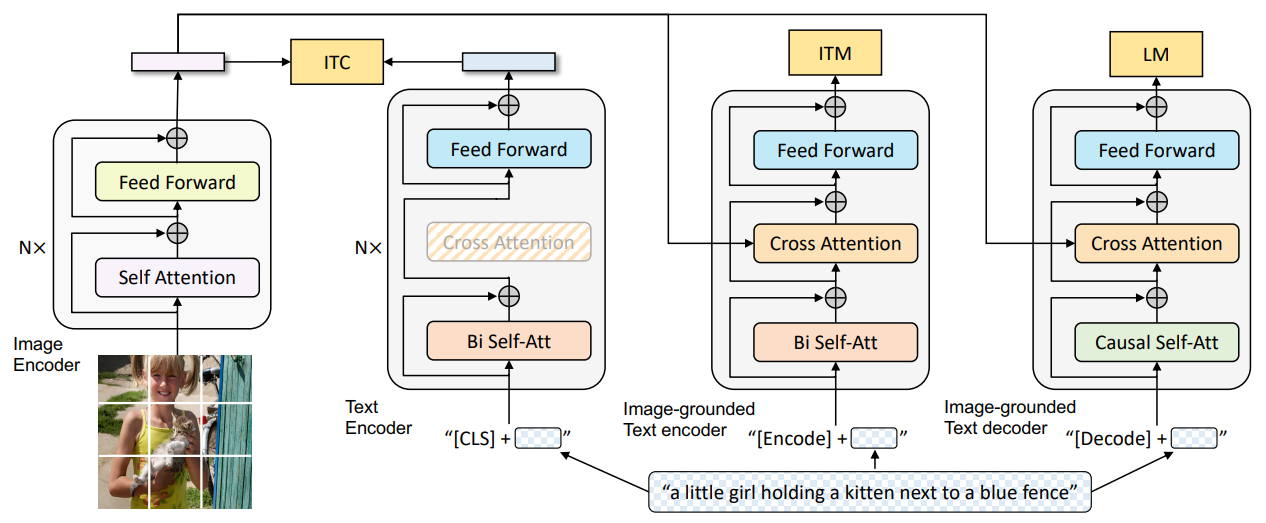

四、BLIP: Bootstrapping Language-Image Pre-training

视觉语言预训练 (VLP) 提高了许多视觉语言任务的性能。 然而,大多数现有的预训练模型仅擅长基于理解的任务或基于生成的任务。 此外,性能的提高在很大程度上是通过使用从网络收集的噪声图像文本对扩展数据集来实现的,而网络是次优的监督源。 在本文中,我们提出了 BLIP,一种新的 VLP 框架,可以灵活地迁移到视觉语言理解和生成任务。 BLIP 通过引导字幕来有效地利用嘈杂的网络数据,其中字幕生成器生成合成字幕,而过滤器则去除嘈杂的字幕。 我们在各种视觉语言任务上取得了最先进的结果,例如图像文本检索(平均召回率+2.7%@1)、图像字幕(CIDEr 中+2.8%)和 VQA( VQA 分数 +1.6%)。 当以零样本方式直接转移到视频语言任务时,BLIP 还表现出很强的泛化能力。 代码、模型和数据集发布于 https://github.com/salesforce/BLIP。

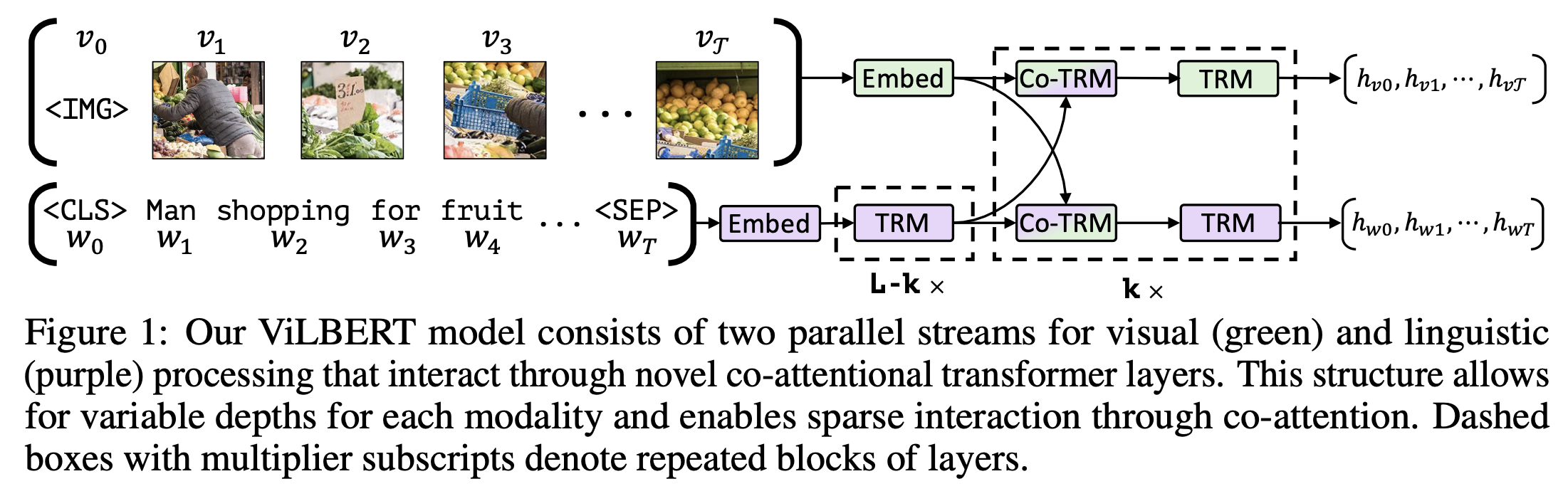

五、Vision-and-Language BERT(ViLBERT)

视觉和语言 BERT (ViLBERT) 是一种基于 BERT 的模型,用于学习图像内容和自然语言的任务无关的联合表示。 ViLBERT 将流行的 BERT 架构扩展为多模态双流模型,在单独的流中处理视觉和文本输入,并通过共同注意转换器层进行交互。

六、VisualBERT

VisualBERT 旨在重用自注意力来隐式对齐输入文本的元素和输入图像中的区域。 视觉嵌入用于对图像进行建模,其中表示由从对象检测器获得的图像中的边界区域表示。 这些视觉嵌入是通过对三个嵌入求和来构造的:1)视觉特征表示,2)片段嵌入指示它是否是图像嵌入,以及3)位置嵌入。 本质上,图像区域和语言与 Transformer 相结合,以允许自我注意力发现语言和视觉之间的隐式对齐。 VisualBERT 使用 COCO 进行训练,COCO 由与标题配对的图像组成。 它使用两个目标进行预训练:掩码语言建模目标和句子图像预测任务。 然后可以针对不同的下游任务进行微调。

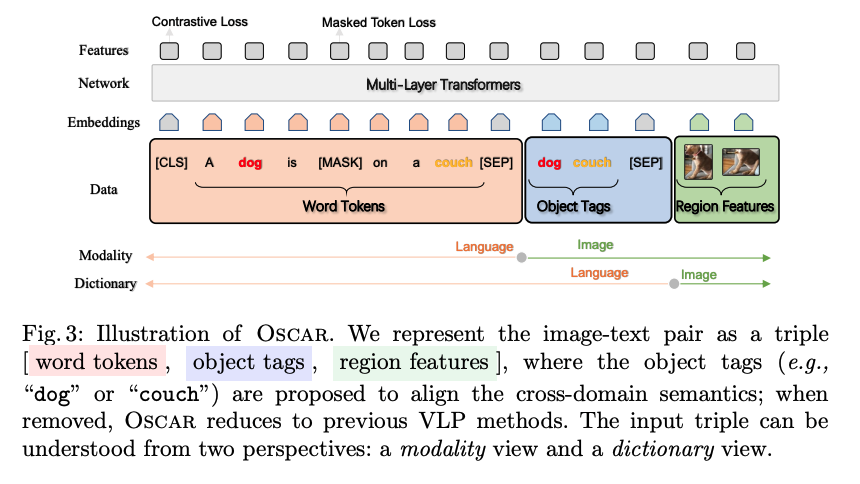

七、OSCAR

OSCAR是一种新的学习方法,它使用图像中检测到的对象标签作为锚点来简化图像文本对齐的学习。 该模型采用三元组作为输入(单词-标签-区域),并使用两个损失进行预训练(单词和标签上的屏蔽标记损失,以及标签与其他标签之间的对比损失)。 OSCAR 通过字典查找将图像-文本对表示到语义空间中。 对象标签用作锚点,将图像区域与预训练语言模型的词嵌入对齐。 然后对该模型进行微调以适应理解和生成任务。

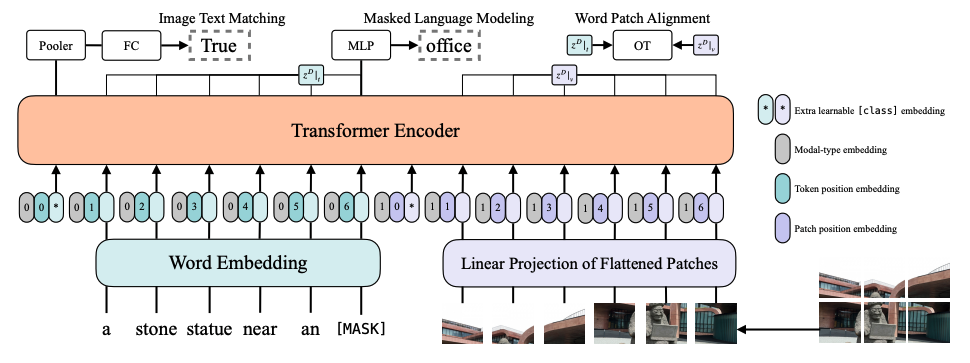

八、Vision-and-Langauge Transformer(ViLT)

ViLT 是一种最小的视觉和语言预训练转换器模型,其中视觉输入的处理被简化为与处理文本输入相同的无卷积方式。 ViLT 的模型特定组件比多模态交互的转换器组件需要更少的计算。 ViLT 模型针对以下目标进行了预训练:图像文本匹配、屏蔽语言建模和字块对齐。

九、OFA

在这项工作中,我们追求多模式预训练的统一范例,以打破复杂任务/特定模式定制的支架。 我们提出了 OFA,一个支持任务综合性的任务无关和模态无关的框架。 OFA 在一个简单的序列到序列学习框架中统一了一组不同的跨模态和单模态任务,包括图像生成、视觉基础、图像字幕、图像分类、语言建模等。 OFA 在预训练和微调阶段都遵循基于指令的学习,下游任务不需要额外的特定于任务的层。 与最近依赖于极大跨模态数据集的最先进的视觉和语言模型相比,OFA 仅在 2000 万个公开可用的图像文本对上进行了预训练。 尽管其简单且训练数据规模相对较小,OFA 在一系列跨模态任务中实现了新的 SOTA,同时在单模态任务上获得了极具竞争力的表现。 我们的进一步分析表明,OFA 还可以有效地转移到看不见的任务和看不见的领域。 我们的代码和模型可在 https://github.com/OFA-Sys/OFA 上公开获取。

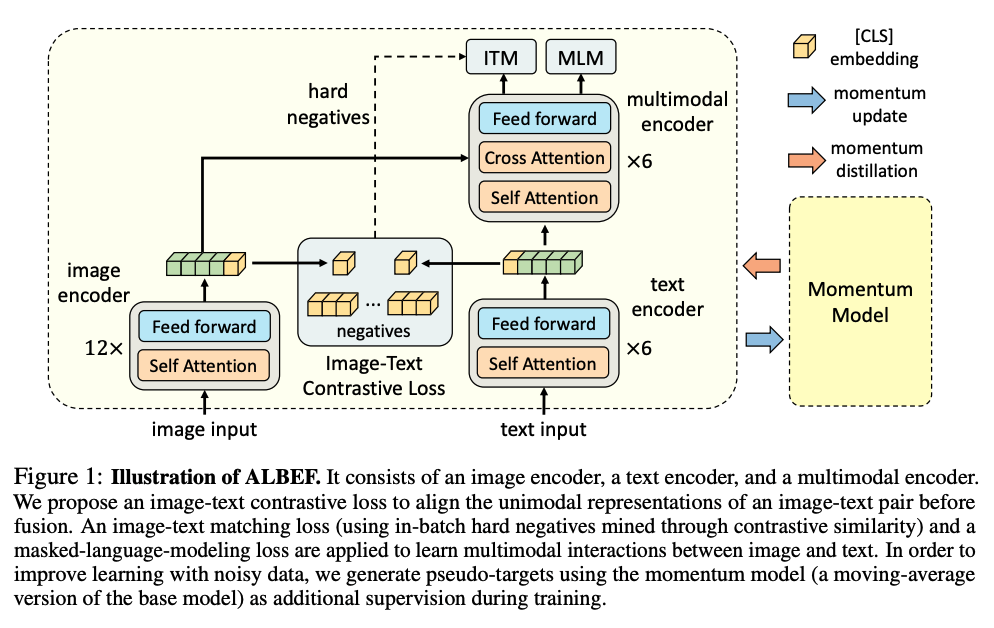

十、ALBEF

ALBEF 引入了对比损失来对齐图像和文本表示,然后通过跨模式注意将它们融合。 这使得更基础的视觉和语言表征学习成为可能。 ALBEF 也不需要边界框注释。 该模型由图像编码器、文本编码器和多模态编码器组成。 图像-文本对比损失有助于在融合之前对齐图像-文本对的单峰表示。 应用图像-文本匹配损失和掩码语言建模损失来学习图像和文本之间的多模态交互。 此外,动量蒸馏用于生成伪目标。 这可以改善对噪声数据的学习。