整理 | 屠敏

出品 | CSDN(ID:CSDNnews)

毋庸置疑,ChatGPT、GPT-4 引领了 AI 新时代的到来,但这种让很多环节都可以实现自动化流程的工具也让人颇为恐慌。

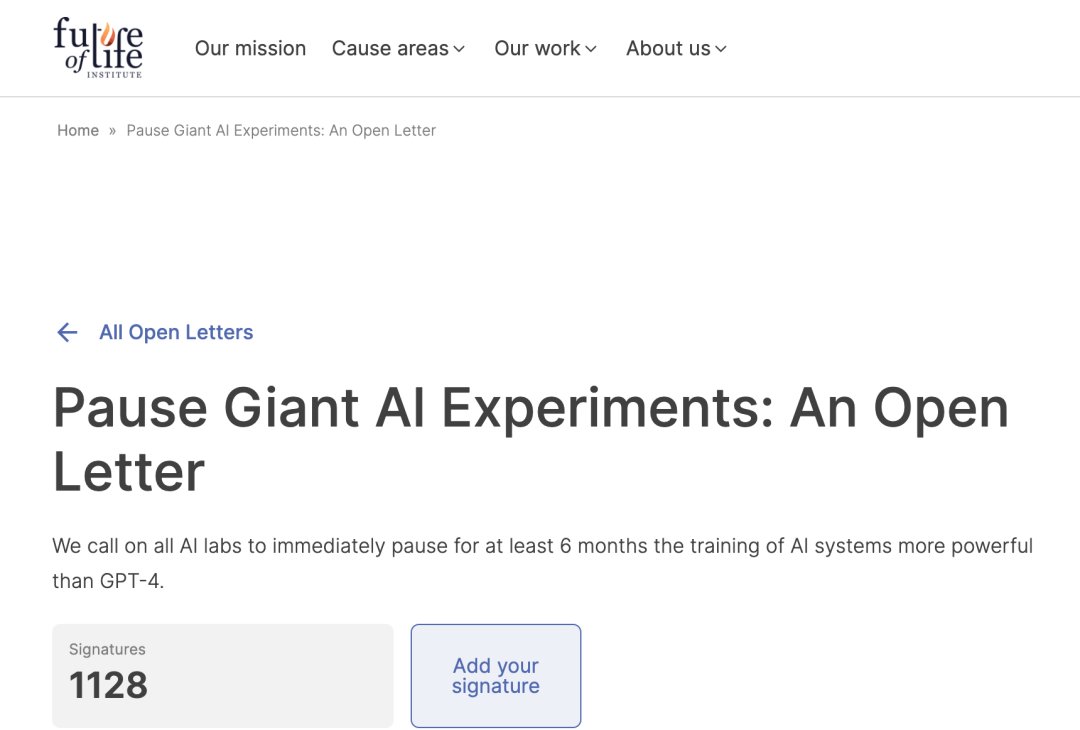

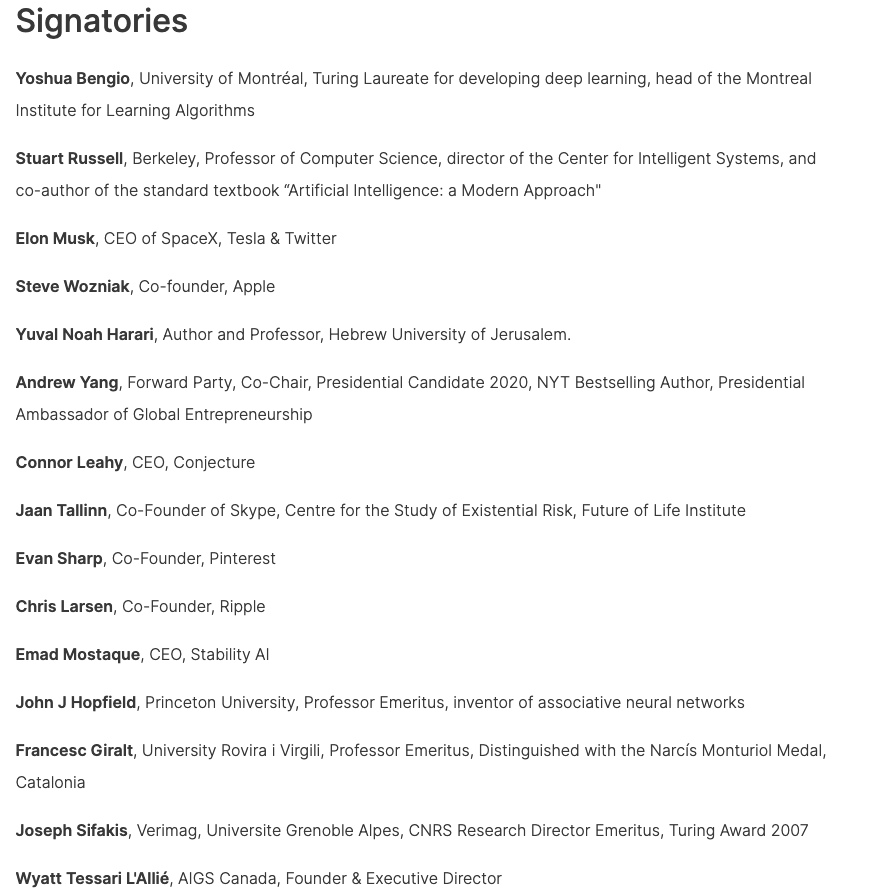

据路透社报道,包括图灵奖得主 Yoshua Bengio、伯克利计算机科学教授 Stuart Russell、特斯拉 CEO 埃隆·马斯克、苹果联合创始人 Steve Wozniak 等在内的数千名对人工智能领域关注的学者、企业家、教授最新发起了一封公开信,强烈呼吁:暂停训练比 GPT-4 更强大的系统,期限为六个月,理由是这些模型对社会和人类存在潜在风险。

这封信由非营利性的 "生命的未来研究所 "(Future of Life Institute)发出(https://futureoflife.org/open-letter/pause-giant-ai-experiments/),截至目前,已经有 1128 人签名。

这个研究所创立于 2014 年 3 月,由 Skype 联合创始人 Jaan Tallinn、麻省理工学院教授 Max Tegmark,物理学家史蒂芬霍金、SpaceX和Tesla 创始人Elon Musk、牛津大学 Future of Humanity Institute 主任 Nick Bostrom、 MIT Center for Digital Business 主任Erik Brynjolfsson、哈佛大学遗传学教授 George Church、MIT 物理学教授 Alan Guth 以及剑桥大学、UC Berkeley 等人工智能方面的专家、教授联合创立。

公开信指出,“具有人类竞争智能的人工智能系统会对社会和人类构成深刻的风险。”

同时,这封公开信也发起了灵魂四问:

-

我们是否应该让机器用宣传和谎言充斥在我们的信息渠道?

-

我们是否应该把所有的工作都自动化,包括那些有成就感的工作?

-

我们是否应该开发非人类的大脑,使其最终超过我们的数量,胜过我们的智慧,淘汰我们并取代我们?

-

我们是否应该冒着失去对我们文明控制的风险?

其写道,只有当我们确信它们的影响是积极的并且它们的风险是可控的时候,才应该开发强大的人工智能系统。

因此,“我们呼吁所有 AI 实验室立即暂停训练比 GPT-4 更强大的 AI 系统,至少 6 个月。这种暂停应该是公开的和可验证的,并且包括所有关键参与者。如果不能迅速实施这种暂停,政府应介入并暂停”,公开信写道。

同时,其希望「让我们享受一个漫长的人工智能夏季,而不是在毫无准备的情况下匆忙进入秋天。」

一线设计师、开发者无奈怒吼:我的工作被 AIGC 工具取代了

事实上,自去年发布以来,由微软主力支持的 OpenAI 的 ChatGPT 已经促使很多用户、公司用上了这些 AI 系统与模型,也激发了业界竞争对手迅速入局,Bing 推出类似的产品。

可以说,这个领域正呈现出是一家独大,却又百花齐放百家争鸣的态势。

不过,AIGC 工具及产品如此频繁的迭代与应用,引发了从企业高管、研究人员甚至到一线从业者、用户的集体焦虑。

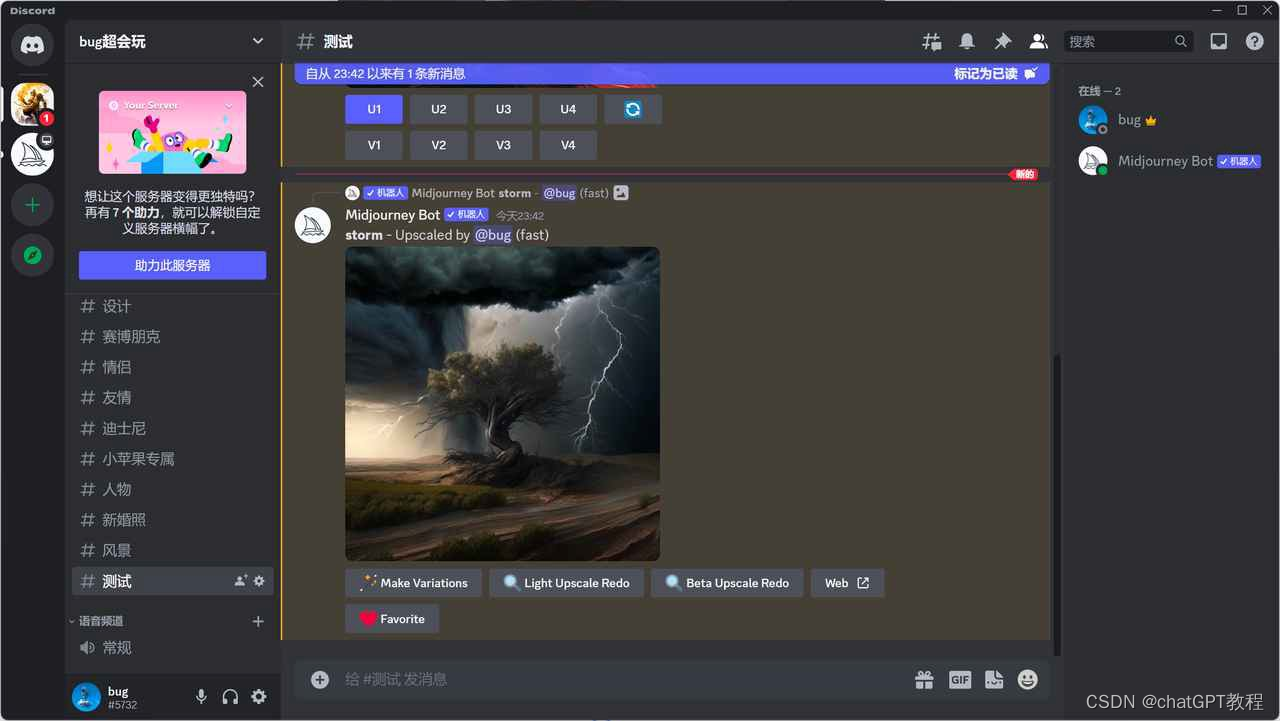

在 Reddit 上,一位设计师分享了自己的美工工作被文本生成图像工具 Midjourney 一夜之间取代的真实经历,引发了无数网友的共鸣。

其表示,“自从 Midjourney v5 上周问世以来,我的工作已经不同了。我不再是一个艺术家,也不是一个 3D 艺术家。现在我所做的是提示,Photoshopping和实现好看的图片。当初我去做 3D 艺术家的原因已经不复存在。我想在三维空间中创造形式,雕刻,创造。用我自己的创造力、用我自己的双手。”

「这对我来说是一夜之间的事。我没有选择。而我的老板也没有选择。我现在能够在 2-3 天内创造、装配和制作一个从 MJ 吐出来的图像。以前,我们花了好几周的时间做 3D。区别在于:我关心,他不关心。对我的老板来说,这只是一个巨大的时间/金钱的节省」,这位用户非常无奈地说道。

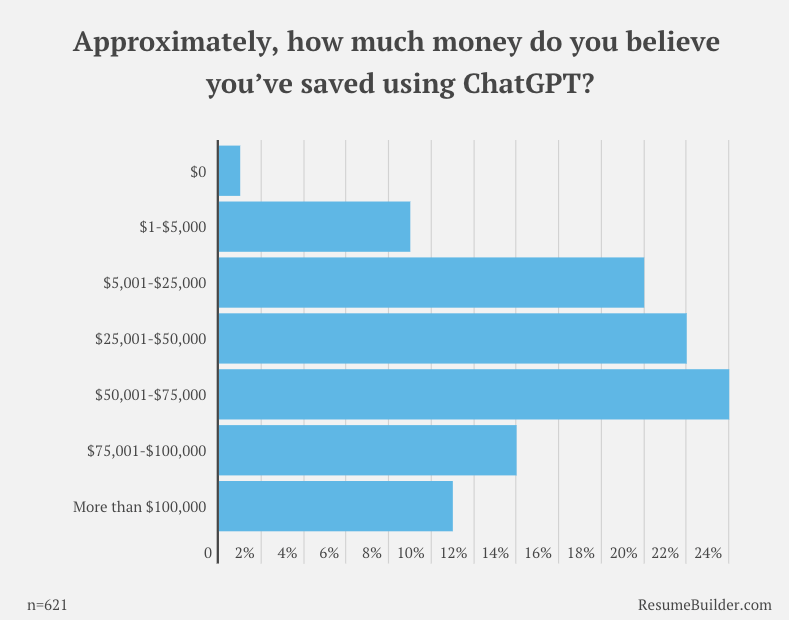

而如同 Midjourney 这类 AIGC 工具让普通劳动力丢掉工作也不在少数。此前,国外职业咨询平台 ResumeBuilder.com 对 1,000 名美国商界领袖进行了关于对 ChatGPT 工具出现看法与应用的调查,根据调查数据显示,48% 使用 ChatGPT 的公司表示,ChatGPT 取代了员工。四分之一的公司已经通过 ChatGPT 节省了 75,000 美元以上。

所以倘若有比 GPT-4 更强的人工智能产品出现,人类丢失工作亦或者快速转型的步伐会越来越快,这打得很多人措手不及。

如何掌控 AI 的边界?

站在更高的道德、法律、规范等层面上,如何控制 AI 不被滥用、合规使用、让其对人类的利大于弊,是很多 AI 专家想要发起这封公开信的主要原因。

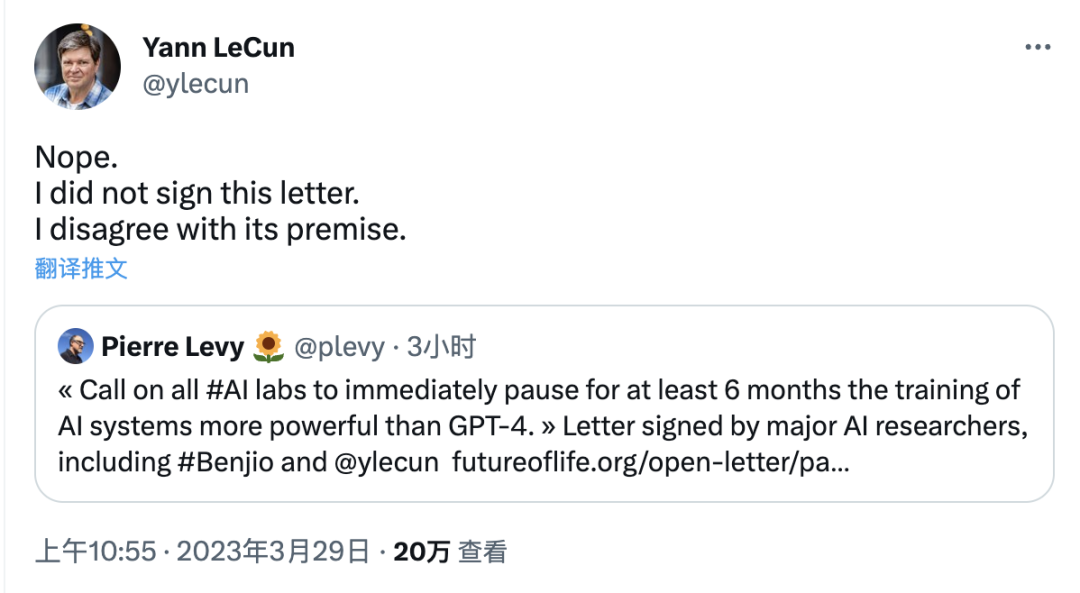

不过,对于这封公开信的发布,也有不少人持反对意见,譬如,一直对 ChatGPT 持严苛、批评态度的卷积网络之父 Yann LeCun,其表示:“不会签署这封公开信。因为不同意公开信的内容。”

以下是公开信全文:

正如广泛的研究和顶级人工智能实验室所承认的那样,具有人类竞争智能的人工智能系统会对社会和人类构成深刻的风险。正如被广泛认可的《阿西洛马人工智能原则》中所说,高级人工智能可能代表着地球上生命历史的深刻变化,应该以相应的谨慎态度和资源进行规划和管理。不幸的是,这种级别的规划和管理并没有发生,尽管最近几个月看到人工智能实验室陷入了一场失控的竞赛中,大家都在开发和部署越来越强大的数字大脑,没有人–甚至他们的创造者–都无法理解、预测甚至可靠地控制。

当代人工智能系统现在在日常任务上,可以与人类相匹敌。我们必须问自己:我们是否应该让机器用宣传和谎言充斥在我们各种信息渠道?我们是否应该把所有的工作都自动化,包括那些有成就感的工作?我们是否应该开发非人类的大脑,使其最终超过我们的数量,胜过我们的智慧,淘汰我们并取代我们?我们是否应该冒着失去对我们文明控制的风险?

这样的决定绝不能委托给未经选举的技术领袖。只有当我们确信强大的人工智能系统带来积极的效果,其风险是可控的,才应该开发。这种信心必须有充分的理由支持,并随着系统潜在影响的大小而增加。OpenAI 最近在关于人工通用智能的声明指出,“在某些时候,在开始训练未来的系统之前,可能必须得到独立的审查,并且对于最先进的工作而言,大家应该在合适时候限制用于创建新的计算的增长率”。我们同意这个观点,并认为现在就是时候这样做了。

因此,我们呼吁所有人工智能实验室立即暂停比 GPT-4 更强大的人工智能系统的训练,为期至少 6 个月。这种暂停应该是公开的、可验证的,并包括所有关键参与者都应该在列。如果这种暂停不能迅速实施,政府应该介入并制定暂停令。

人工智能实验室和独立专家应利用这次暂停期,共同制定和实施一套先进的人工智能设计和开发的共享安全协议,并由独立的外部专家进行严格的审计和监督。这些协议应该确保遵守它们的系统是安全的,无可置疑的。当然,这一行动并不意味着暂停人工智能的总体发展,只是从越来越大且不可预测的黑盒模型的危险竞赛中退后一步。

人工智能的研究和开发应该重新聚焦于使当今强大的、最先进的系统更加准确、安全、可解释、透明、稳健、一致、值得信赖和忠诚。

同时,AI 开发者必须与政策制定者合作,大幅加快开发强大的人工智能治理系统。这些至少应该包括:

-

设立专门针对人工智能的新的且有能力的监管机构;

-

监督和跟踪高能力的人工智能系统和大型计算能力池;

-

确定 AI 内容出处和加上水印系统,以帮助用户区分真实和合成的内容,并跟踪模型泄漏;

-

强大的审计和认证生态系统;

-

对人工智能造成的伤害承担责任;

-

为人工智能安全技术研究提供强大的公共资金;

-

以及资源充足的机构,以应对人工

-

智能将导致的巨大的经济和政治破坏(特别是对民主)。

人类可以享受人工智能带来的繁荣未来。在成功创造出强大的 AI 系统之后,我们现在可以享受一个 “人工智能之夏”,在这个夏天,我们收获了回报,设计这些系统以造福所有人,并为社会提供适应的机会。社会已经暂停了其他可能对社会造成灾难性影响的技术。我们在这里也可以这样做。让我们享受一个漫长的人工智能夏季,而不是在毫无准备的情况下匆忙进入秋天。

已签名的部分人士列表如下:

公开信完整内容详见:https://futureoflife.org/open-letter/pause-giant-ai-experiments/