- 📢欢迎点赞 :👍 收藏 ⭐留言 📝 如有错误敬请指正,赐人玫瑰,手留余香!

- 📢本文作者:由webmote 原创

- 📢作者格言:新的征程,用爱发电,去丈量人心,是否能达到人机合一?

开工大吉

新的一年就这么水灵灵的开始了,在这里,祝各位读者新春快乐,万事如意!

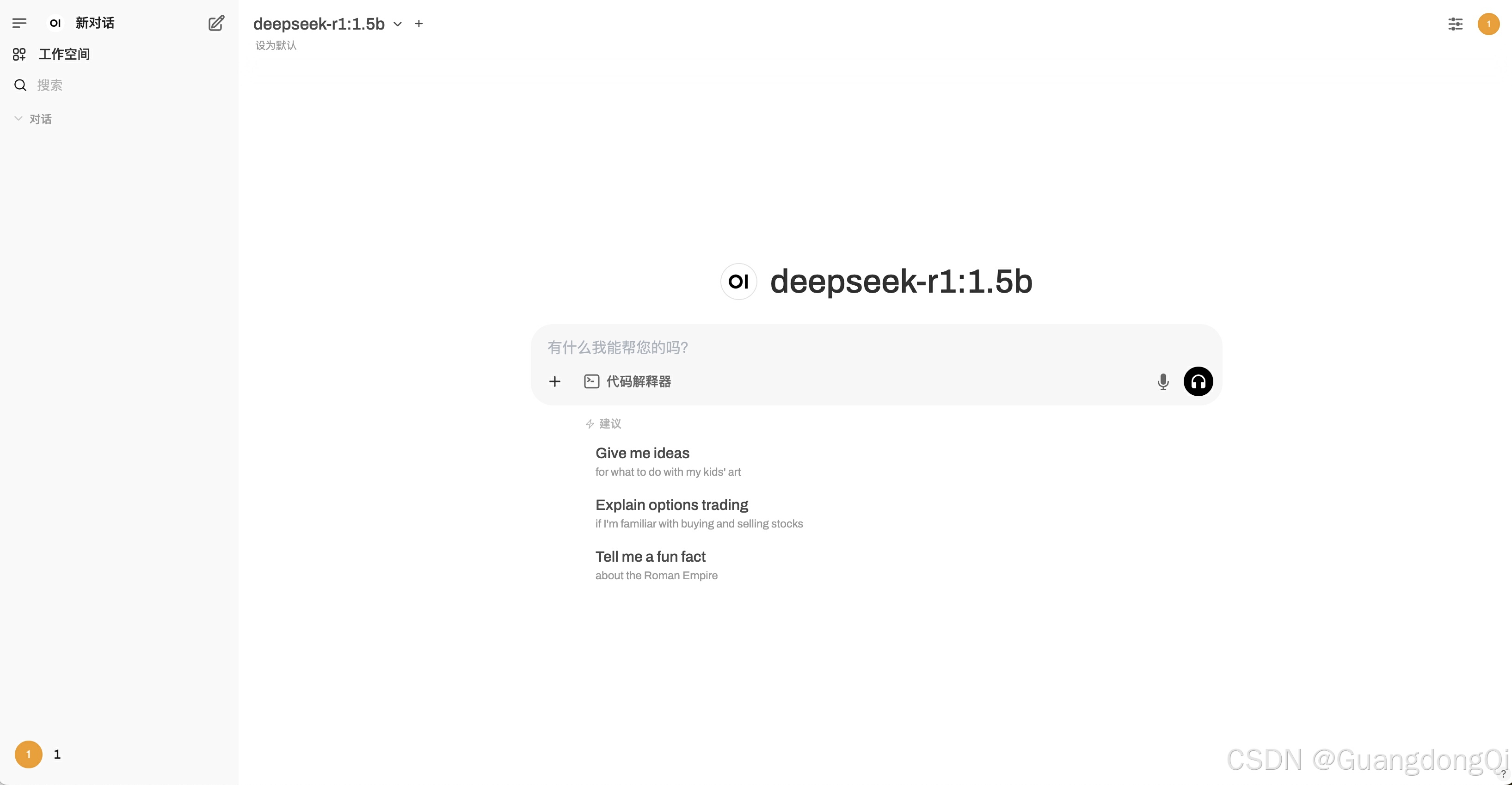

新年伊始,万象更新!随着人工智能技术的飞速发展,AI在各个领域的应用越来越广泛。无论是自然语言处理、图像识别,还是智能推荐系统,AI都在改变着我们的生活和工作方式。在这个新春佳节,AI技术的火爆程度更是达到了一个新的高度,特别是DeepSeek的耀眼成就,更是让纳斯达克众多科技股崩盘,许多企业和开发者都在积极探索如何将AI技术应用到自己的产品和服务中,以提升用户体验和业务效率。

趁着这股东风,我们就祭出.net 技术,来场AI集成秀,也祝大家在新的一