文章目录

- 🌟 离线评估:常用的推荐系统离线评估方法有哪些?

- 🍊 1. RMSE/MSE

- 🍊 2. MAE

- 🍊 3. Precision/Recall/F1-score

- 🍊 4. Coverage

- 🍊 5. Personalization

- 🍊 6. AUC

- 🌟 评估指标:我们可以用哪些指标来衡量模型的好坏?

- 🍊 1. Precision/Recall/F1-score

- 🍊 2. MAP

- 🍊 3. NDCG

- 🍊 4. Hit Rate

- 🍊 5. Coverage

- 🌟 特别加餐|TensorFlow的模型离线评估实践怎么做?

- 🍊 1. 数据准备

- 🍊 2. 模型训练

- 🍊 3. 模型评估

- 🍊 4. 指标衡量

- 🌟 在线测试:如何在推荐服务器内部实现A/B测试?

- 🍊 1. 划分用户

- 🍊 2. 实现对比

- 🍊 3. 统计结果

- 🍊 4. 结论和改进

- 🌟 评估体系:如何解决A/B测试资源紧张的窘境?

- 🍊 1. 多臂老虎机算法

- 🍊 2. 仿真技术

- 🍊 3. 分层测试

- 🍊 4. 统计学方法

📕我是廖志伟,一名Java开发工程师、Java领域优质创作者、CSDN博客专家、51CTO专家博主、阿里云专家博主、清华大学出版社签约作者、产品软文创造者、技术文章评审老师、问卷调查设计师、个人社区创始人、开源项目贡献者。🌎跑过十五公里、徒步爬过衡山、🔥有过三个月减肥20斤的经历、是个喜欢躺平的狠人。

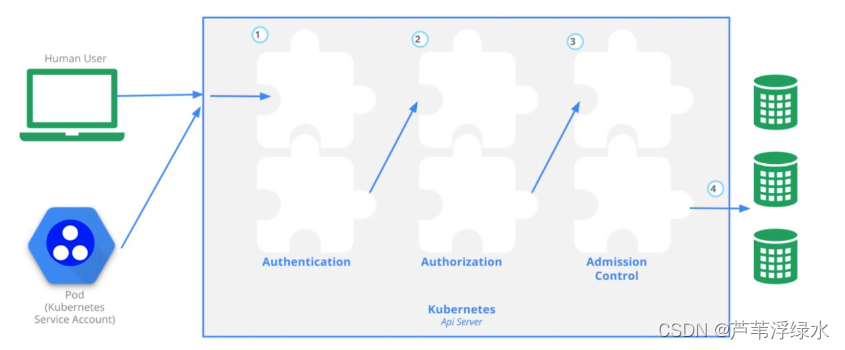

📘拥有多年一线研发和团队管理经验,研究过主流框架的底层源码(Spring、SpringBoot、Spring MVC、SpringCould、Mybatis、Dubbo、Zookeeper),消息中间件底层架构原理(RabbitMQ、RockerMQ、Kafka)、Redis缓存、MySQL关系型数据库、 ElasticSearch全文搜索、MongoDB非关系型数据库、Apache ShardingSphere分库分表读写分离、设计模式、领域驱动DDD、Kubernetes容器编排等。🎥有从0到1的高并发项目经验,利用弹性伸缩、负载均衡、报警任务、自启动脚本,最高压测过200台机器,有着丰富的项目调优经验。

希望各位读者大大多多支持用心写文章的博主,现在时代变了,信息爆炸,酒香也怕巷子深,博主真的需要大家的帮助才能在这片海洋中继续发光发热,所以,赶紧动动你的小手,点波关注❤️,点波赞👍,点波收藏⭐,甚至点波评论✍️,都是对博主最好的支持和鼓励!

- 💂 博客主页: 我是廖志伟

- 👉开源项目:java_wxid

- 🌥 哔哩哔哩:我是廖志伟

- 🎏个人社区:幕后大佬

- 🔖个人微信号:

SeniorRD

📥博主的人生感悟和目标

- 🍋程序开发这条路不能停,停下来容易被淘汰掉,吃不了自律的苦,就要受平庸的罪,持续的能力才能带来持续的自信。我本是是一个很普通程序员,放在人堆里,除了与生俱来的盛世美颜,就剩180的大高个了,就是我这样的一个人,默默写博文也有好多年了。

- 📺有句老话说的好,牛逼之前都是傻逼式的坚持,希望自己可以通过大量的作品、时间的积累、个人魅力、运气、时机,可以打造属于自己的技术影响力。

- 💥内心起伏不定,我时而激动,时而沉思。我希望自己能成为一个综合性人才,具备技术、业务和管理方面的精湛技能。我想成为产品架构路线的总设计师,团队的指挥者,技术团队的中流砥柱,企业战略和资本规划的实战专家。

- 🎉这个目标的实现需要不懈的努力和持续的成长,但我必须努力追求。因为我知道,只有成为这样的人才,我才能在职业生涯中不断前进并为企业的发展带来真正的价值。在这个不断变化的时代,我必须随时准备好迎接挑战,不断学习和探索新的领域,才能不断地向前推进。我坚信,只要我不断努力,我一定会达到自己的目标。

📙经过多年在CSDN创作上千篇文章的经验积累,我已经拥有了不错的写作技巧。同时,我还与清华大学出版社签下了四本书籍的合约,并将陆续在明年出版。这些书籍包括了基础篇、进阶篇、架构篇的📌《Java项目实战—深入理解大型互联网企业通用技术》📌,以及📚《解密程序员的思维密码–沟通、演讲、思考的实践》📚。具体出版计划会根据实际情况进行调整,希望各位读者朋友能够多多支持!

🌾阅读前,快速浏览目录和章节概览可帮助了解文章结构、内容和作者的重点。了解自己希望从中获得什么样的知识或经验是非常重要的。建议在阅读时做笔记、思考问题、自我提问,以加深理解和吸收知识。阅读结束后,反思和总结所学内容,并尝试应用到现实中,有助于深化理解和应用知识。与朋友或同事分享所读内容,讨论细节并获得反馈,也有助于加深对知识的理解和吸收。

🔔如果您需要转载或者搬运这篇文章的话,非常欢迎您私信我哦~

💡在这个美好的时刻,本人不再啰嗦废话,现在毫不拖延地进入文章所要讨论的主题。接下来,我将为大家呈现正文内容。

🌟 离线评估:常用的推荐系统离线评估方法有哪些?

在推荐系统中,离线评估是评估推荐算法效果的一种常见方法。离线评估是指在离线数据集上测试推荐算法,并使用评估指标来衡量其效果。常用的推荐系统离线评估方法有以下几种:

🍊 1. RMSE/MSE

RMSE(Root Mean Square Error)和MSE(Mean Square Error)是最常见的衡量推荐系统预测准确度的方法。RMSE和MSE都是衡量预测值和真实值之间的误差平方和的平均值。

🍊 2. MAE

MAE(Mean Absolute Error)是另一种衡量推荐系统预测准确度的方法。MAE是预测值和真实值之间的绝对误差的平均值。

🍊 3. Precision/Recall/F1-score

在推荐系统中,Precision(准确率)、Recall(召回率)和F1-score是衡量推荐系统的重要指标。Precision是推荐结果中正确的数量与推荐结果的总数量之比。Recall是正确的推荐结果数量与真实结果总数之比。F1-score是 Precision 和 Recall 的调和平均值,用于综合评估推荐系统的准确度和召回率。

🍊 4. Coverage

Coverage表示在所有可能的推荐物品中,有多少被推荐算法所推荐。Coverage的值越高,表示推荐算法能够覆盖更多的物品,提高了推荐系统的多样性。

🍊 5. Personalization

Personalization用于衡量推荐系统的个性化程度。一个好的推荐系统需要考虑用户的个性化需求,而不是只推荐热门的物品。

🍊 6. AUC

AUC(Area Under Curve)是用于衡量二分类模型好坏的指标,也可以用于推荐系统中衡量排序模型的好坏。

🌟 评估指标:我们可以用哪些指标来衡量模型的好坏?

在推荐系统中,评估指标是衡量模型好坏的重要标准。以下是常用的推荐系统评估指标:

🍊 1. Precision/Recall/F1-score

Precision(准确率)、Recall(召回率)和F1-score是衡量推荐系统的重要指标。Precision是推荐结果中正确的数量与推荐结果的总数量之比。Recall是正确的推荐结果数量与真实结果总数之比。F1-score是 Precision 和 Recall 的调和平均值,用于综合评估推荐系统的准确度和召回率。

🍊 2. MAP

MAP(Mean Average Precision)是一种综合考虑推荐系统排序质量的指标。它是通过计算每个用户的平均准确率(Average Precision)来计算的。

🍊 3. NDCG

NDCG(Normalized Discounted Cumulative Gain)是一种衡量推荐列表排序质量的指标。它将用户真实反馈和推荐结果的顺序关系考虑在内,通过计算DCG(Discounted Cumulative Gain)和IDCG(Ideal Discounted Cumulative Gain)的比值来计算。

🍊 4. Hit Rate

Hit Rate表示推荐系统中,在所有的推荐列表中,至少有一个正确物品的比例。

🍊 5. Coverage

Coverage表示在所有可能的推荐物品中,有多少被推荐算法所推荐。Coverage的值越高,表示推荐算法能够覆盖更多的物品,提高了推荐系统的多样性。

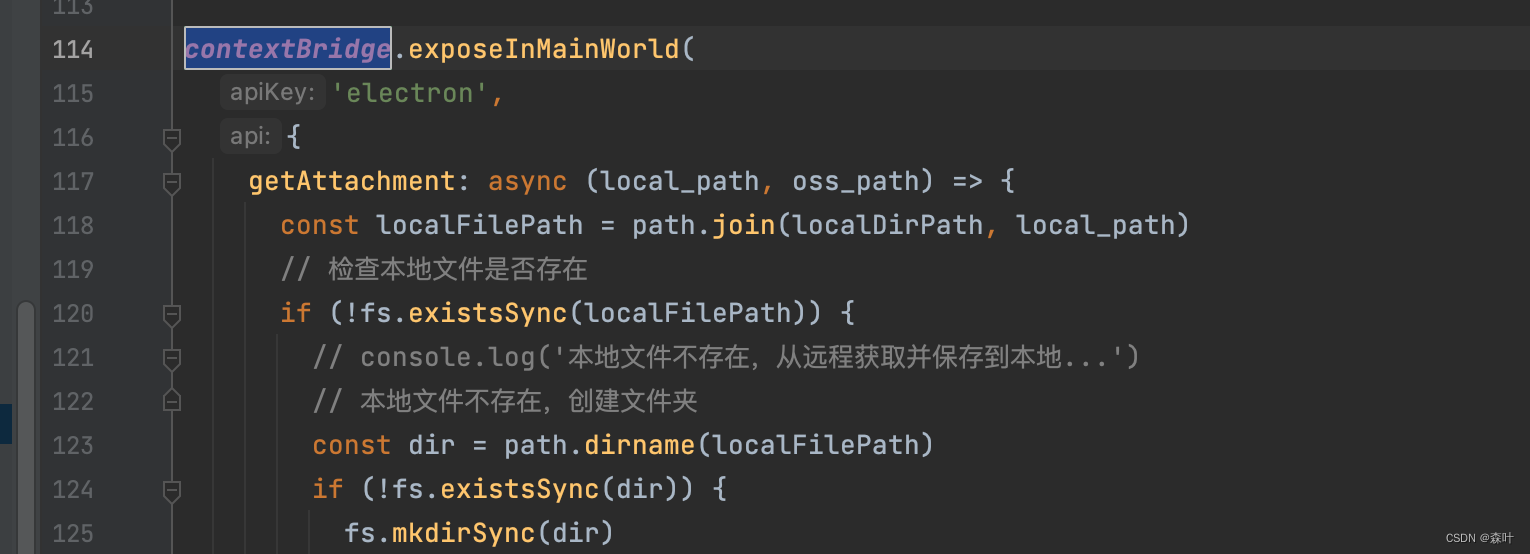

🌟 特别加餐|TensorFlow的模型离线评估实践怎么做?

TensorFlow是一种广泛应用于深度学习的工具,能够对推荐系统使用的模型进行训练和评估。以下是TensorFlow的模型离线评估实践步骤:

🍊 1. 数据准备

为了进行模型评估,需要准备可用于评估的数据集。可以使用已经分割好的训练集和测试集进行评估。

🍊 2. 模型训练

使用TensorFlow训练推荐模型,并输出模型。

🍊 3. 模型评估

使用测试集评估模型效果。可以使用TensorFlow中的评估函数,如tf.compat.v1.metrics.mean_squared_error、tf.compat.v1.metrics.precision等。

🍊 4. 指标衡量

计算评估指标并输出结果。可以使用上述的评估指标对模型进行评估,并得出模型效果的结果。

🌟 在线测试:如何在推荐服务器内部实现A/B测试?

在推荐系统中,A/B测试是一种常见的测试方法,用来比较不同版本的推荐算法或推荐策略的效果。以下是如何在推荐服务器内部实现A/B测试的步骤:

🍊 1. 划分用户

将用户随机分配到不同的测试组中。每个测试组使用不同的算法或策略。

🍊 2. 实现对比

在推荐服务器中实现测试组的算法或策略,并对比测试组与控制组的效果。

🍊 3. 统计结果

统计测试结果,比较测试组和控制组的效果差异。可以使用各种评估指标来衡量效果,如上文提到的Precision、Recall等指标。

🍊 4. 结论和改进

根据测试结果得出结论,并进行系统优化。如果测试结果不尽如人意,可以根据测试结果对算法或策略进行改进。

🌟 评估体系:如何解决A/B测试资源紧张的窘境?

在推荐系统中实施A/B测试时,当资源有限并且测试组数量较多时,可能会出现资源紧张的窘境。以下是解决A/B测试资源紧张的方法:

🍊 1. 多臂老虎机算法

多臂老虎机算法是一种常见的解决A/B测试资源紧张的方法。这种算法可以对推荐算法进行连续优化,从而在不断优化算法的过程中减少资源开销。

🍊 2. 仿真技术

仿真技术可以用于推荐系统的A/B测试,通过模拟多种算法和策略的效果来减少资源消耗。

🍊 3. 分层测试

分层测试是将用户按照不同特征分为不同组,然后进行A/B测试。这种方法可以减少测试组数量,从而减少资源开销。

🍊 4. 统计学方法

在A/B测试中,使用统计学方法可以减少测试数量,从而减少资源开销。使用统计学方法可以确定需要测试的测试组数量,以便得出准确的结果。