什么是网络爬虫?

网络爬虫是一种自动化程序,用于从互联网上抓取信息。这些信息可以是文本、图像、视频、数据表格等各种形式的数据。爬虫程序通过模拟浏览器的行为,自动访问网页、抓取内容,并将其保存或处理。这对于数据挖掘、搜索引擎优化、市场分析和竞争情报等领域都非常有用。

当涉及到Python爬虫时,我们需要深入探讨这一领域的各个方面,从基础知识到高级技巧,以便有效地从互联网上采集数据。在本篇深度博客文章中,我们将详细讨论Python爬虫的各个方面,包括基础知识、工具和技术,以及一些最佳实践。

第一部分:Python爬虫基础

1.1 什么是网络爬虫?

网络爬虫是一种自动化程序,用于从互联网上抓取信息。这些信息可以是文本、图像、视频、数据表格等各种形式的数据。网络爬虫通过模拟浏览器的行为,自动访问网页、抓取内容,并将其保存或处理。它在数据挖掘、搜索引擎优化、市场分析和竞争情报等领域有着广泛的应用。

1.2 Python爬虫的基础工具

在Python中,有几个核心工具用于创建爬虫程序:

- Requests:用于发送HTTP请求,从网页获取数据。

- Beautiful Soup:用于解析HTML和XML文档,提取所需的数据。

- Scrapy:一个强大的爬虫框架,提供了广泛的工具和功能来创建高效的爬虫。

第二部分:Python爬虫进阶

2.1 网站结构分析

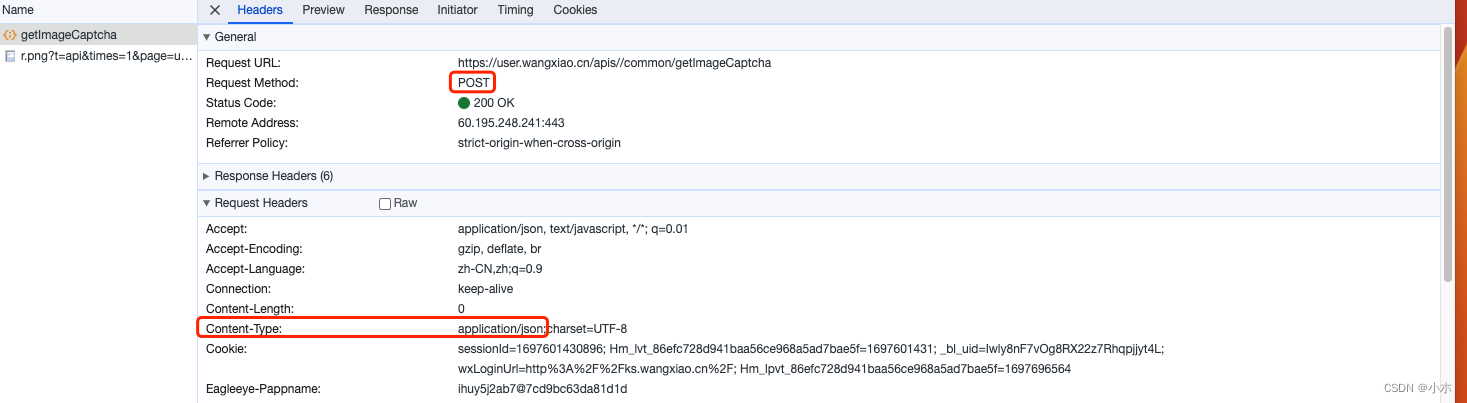

在创建一个爬虫之前,您需要仔细分析目标网站的结构。了解网页的HTML结构、URL模式以及网站的反爬虫机制是非常重要的。

2.2 数据解析与存储

一旦您获取到网页的内容,您需要解析它并提取所需的数据。这通常涉及使用Beautiful Soup或其他解析库。您还需要决定如何存储数据,可以选择存储在文本文件、数据库或云存储中。

2.3 处理动态页面

许多现代网站使用JavaScript来动态加载内容,这给爬虫带来了挑战。Selenium是一个用于模拟浏览器行为的工具,用于处理这类动态页面。

2.4 爬虫策略

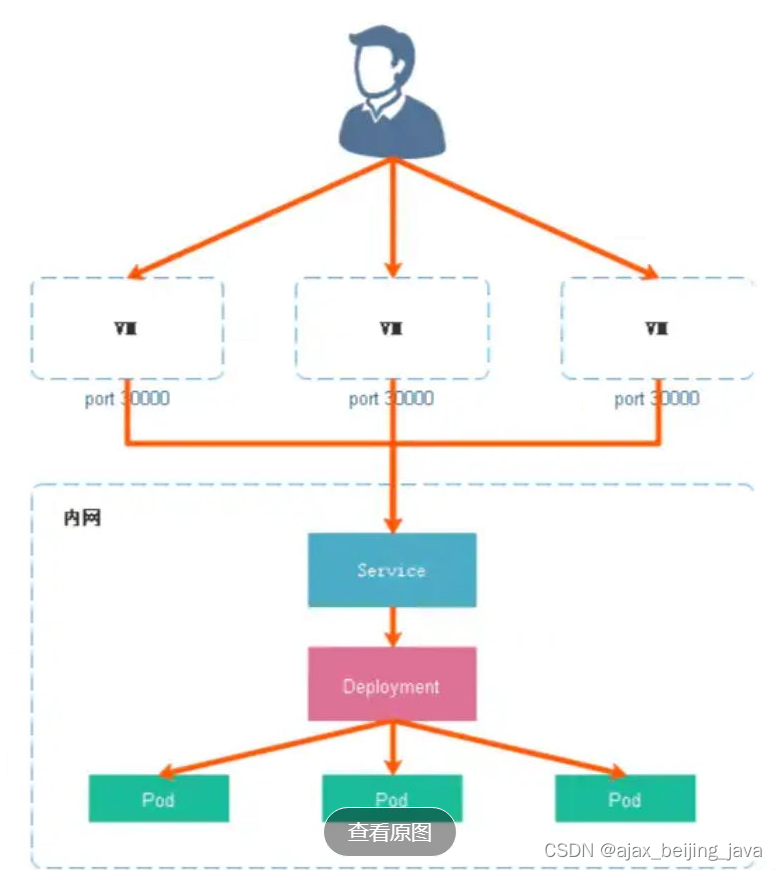

制定合适的爬虫策略对于避免被封禁和确保数据完整性至关重要。您可以设置爬虫的请求频率、使用代理IP以及实施随机性来模拟人类访问行为。

第三部分:Python爬虫最佳实践

3.1 尊重robots.txt文件

请始终尊重网站的robots.txt文件,以避免滥用和侵犯网站的规则。这有助于维护良好的网络道德。

3.2 处理异常情况

网络爬虫可能会遇到各种异常情况,例如404错误、连接超时等。您需要实施错误处理和重试机制,以确保爬虫的稳定性。

3.3 数据清洗与分析

一旦您收集到数据,通常需要进行数据清洗和分析。Python拥有丰富的数据处理和分析库,如Pandas和NumPy,可帮助您有效地处理数据。

3.4 安全与合法性

确保您只爬取和使用合法的数据,并遵守相关法律法规。不要滥用爬虫技术,以免引发法律问题。

第四部分:实际示例

在Python中,有几个库和框架,可用于创建爬虫程序。最流行的包括:

- Requests:用于发送HTTP请求,从网页获取数据。

- Beautiful Soup:用于解析HTML和XML文档,提取所需的数据。

- Scrapy:一个强大的爬虫框架,提供了广泛的工具和功能来创建高效的爬虫。

安装必要的库

首先,确保你已经安装了Python。然后,安装以下必要的库:

pip install requests

pip install beautifulsoup4

创建一个简单的Python爬虫

我们将创建一个简单的Python爬虫来从一个网站上抓取文章标题和链接。下面是一个示例代码:

import requests

from bs4 import BeautifulSoup# 定义要爬取的网页URL

url = "https://example.com"# 发送GET请求

response = requests.get(url)# 使用Beautiful Soup解析HTML内容

soup = BeautifulSoup(response.text, "html.parser")# 查找文章标题和链接

for article in soup.find_all("article"):title = article.find("h2").textlink = article.find("a")["href"]print(f"标题: {title}")print(f"链接: {link}")

这个示例代码首先使用requests库发送一个GET请求来获取网页的HTML内容,然后使用Beautiful Soup解析HTML文档。接下来,我们使用Beautiful Soup的方法来提取文章标题和链接,最后将它们打印出来。

注意事项

在使用Python爬虫时,有一些重要的注意事项:

-

网站的robots.txt文件:请始终尊重网站的robots.txt文件,以避免滥用和侵犯网站的规则。

-

请求频率:不要发送太频繁的请求,以免给网站带来过大的负担。您可以使用延迟和随机性来模拟人类访问的行为。

-

合法性:确保你只爬取和使用合法的数据,并遵守相关法律法规。

-

网站结构的变化:请注意,网站的结构可能会随时更改,这可能会破坏您的爬虫。因此,需要定期检查和更新您的爬虫程序。