目录

- Abstract

- Method

- Method

- nsU-Net中的特征金字塔

- 多尺度像素恢复

- 多尺度特征比较

- 从多剪切到下剪切

- 训练目标

- 总结

Abstract

现有方法及其缺点:最近的SSL方法大多是对比学习方法,它的目标是通过比较不同图像视图来保留潜在表示中的不变合判别语义,然而它主要保留高级语义信息,不包含足够的局部信息,局部信息对医学图像分析很有用。

提出的解决方法:提出将像素级恢复任务纳入,以将更多像素级信息显示编码到高级语义信息中。讨论了尺度信息保留,提出的框架可以表述为在特征金字塔上的多任务优化问题。

效果很好。

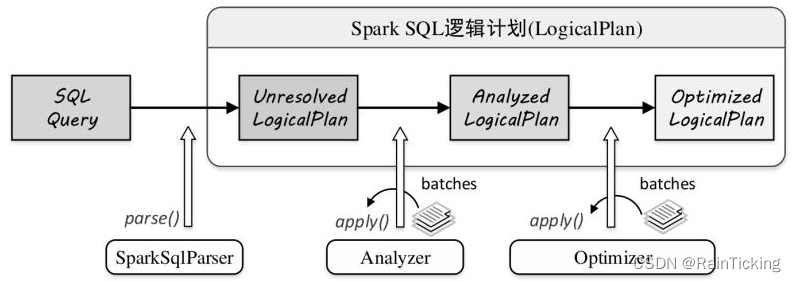

Method

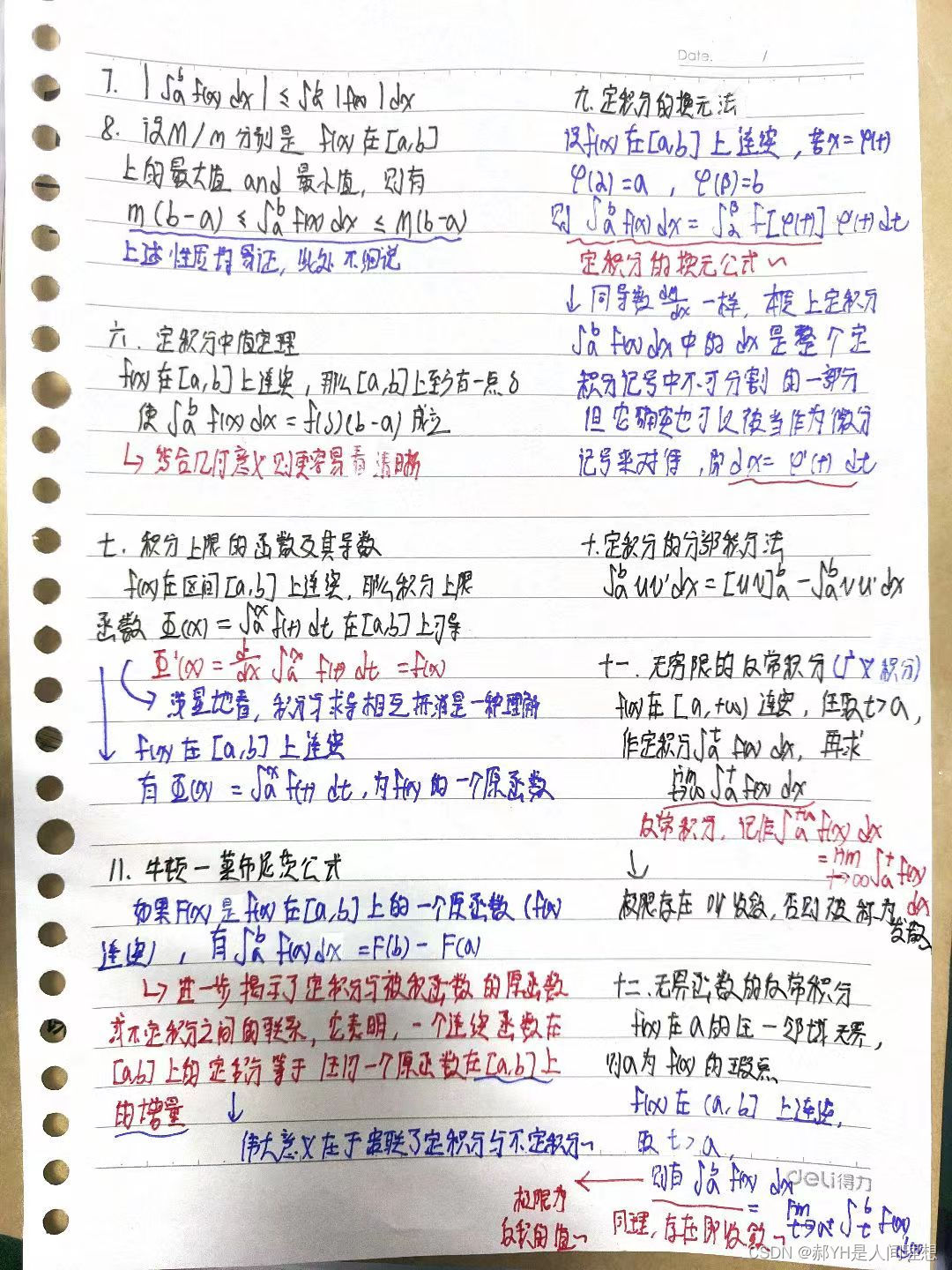

上面是动机插图。三层分别表示像素、尺度和语义。像素是图片的像素值,通过特征图重建生成(从特征图中恢复未损坏的输入,以保留像素级细节),特征是网络学习到的特征,语义信息是一维编码。这些在不同的尺度上进行像素恢复和特征比较(特征比较怎么做?)引入多尺度自监督潜在特征表示,以更好地迁移到下游任务。

贡献:

- 从像素、语义和尺度三个方面统一了潜在特征中视觉信息的保存。在不同特征尺度上进行像素恢复和特征比较。

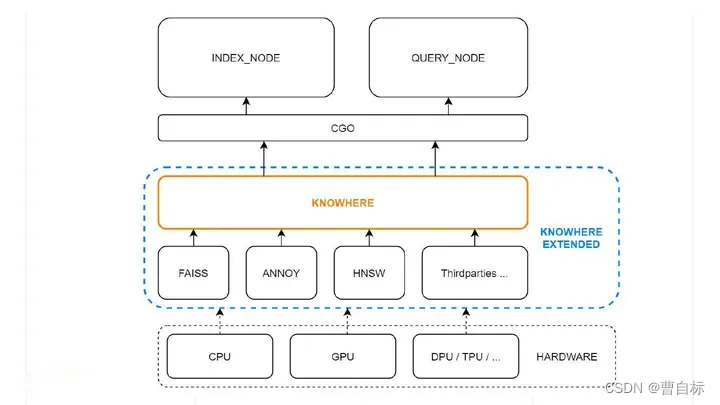

- 我们引入了非跳过U-Net(nsUNet)来构建特征金字塔。因防止跳跃连接踢狗学习的捷径,同时高级特征和低级特征直接组合不利于高级语义信息的提取。

- 受多剪切的启发,提出使用子剪切比较全局剪切块和局部剪切块。为了缓解 3D 空间中全局视图和局部视图之间互信息减少的问题,子裁剪限制了全局视图的 3D 最小边界框内的局部视图裁剪。

- 广泛全面的实验。

PCRLv1证明了通过对比学习获得的不便和判别语义之外,还包含更多像素级语义信息的好处。对PCRLv1进行实质性修改。改进主要包括不限于:

(i) 除了本地像素级和全局语义信息外,比例信息也保留在自监督视觉信息表示中。这证明可以提升在下游任务中的性能。

(ii) PCRLv2将PCLv1的注意力像素级恢复和混合特征对比操作简化为简洁的多任务问题。

(iii) 与PCELv1相比PCRLv2的引入了nsU-Net(非跳跃连接的U-Net)。

usU-Net好处如下:

a. nsU-Net的特征金字塔允许进行多尺度像素级上下文恢复和语义特征比较。像素、语义和比例的统一产生了更多可转移的视觉表示

b. 它可以避免产生捷径解决方案,与典型跳跃连接相比,性能明显提高。

(iv) 我们整合多剪切的想法到PCRLv2中。通过在全局视图中的3D最小边界框中随机剪切多个局部体积块来增加相互信息。

(v) 实验效果好。

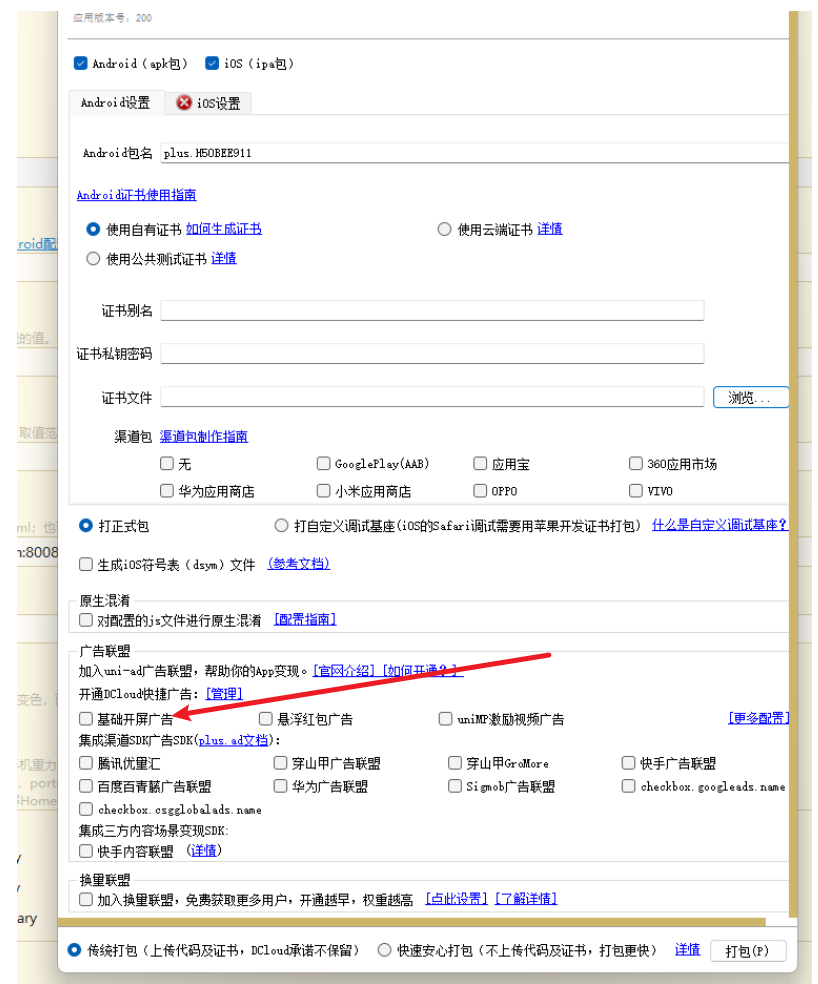

Method

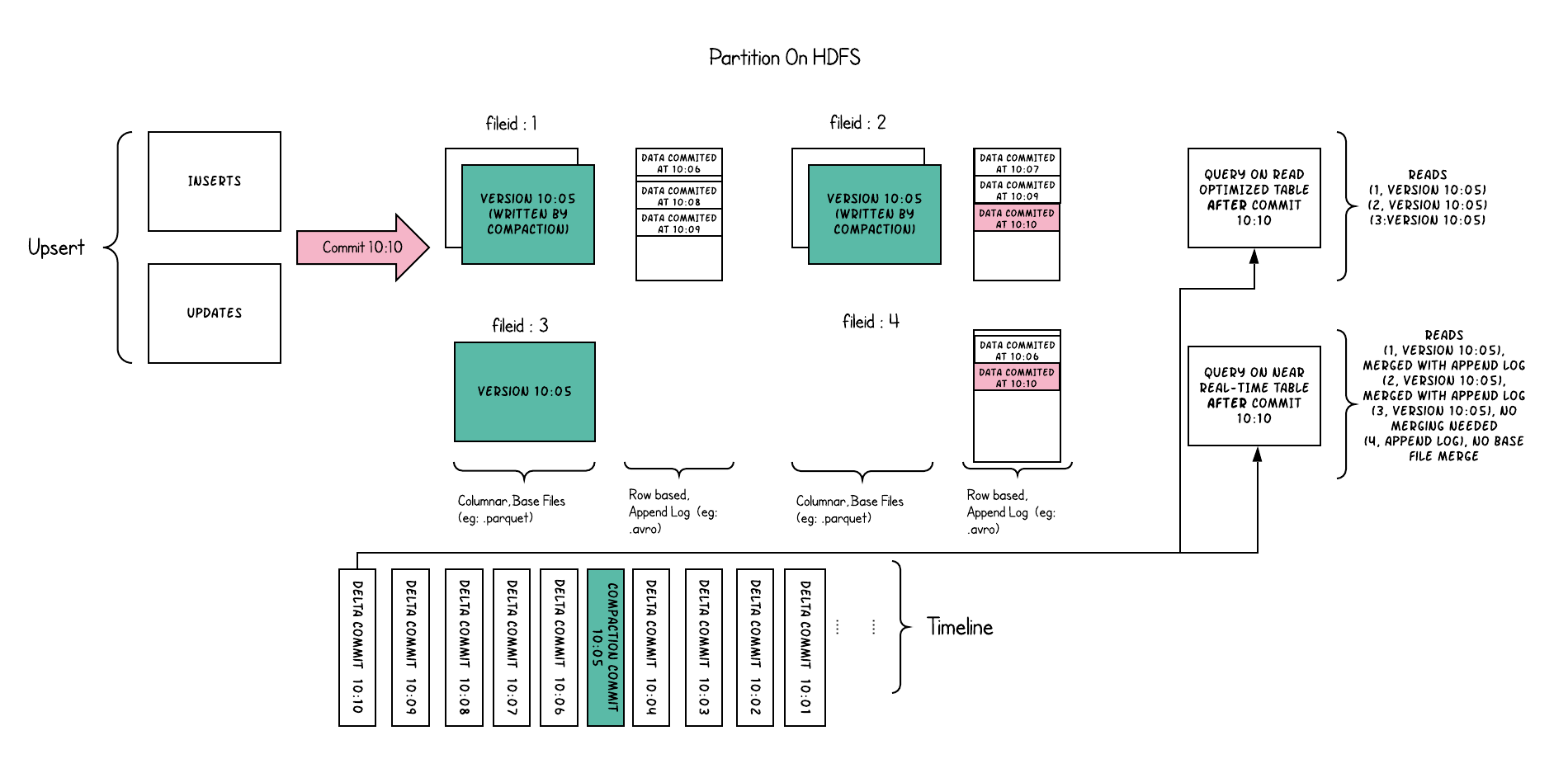

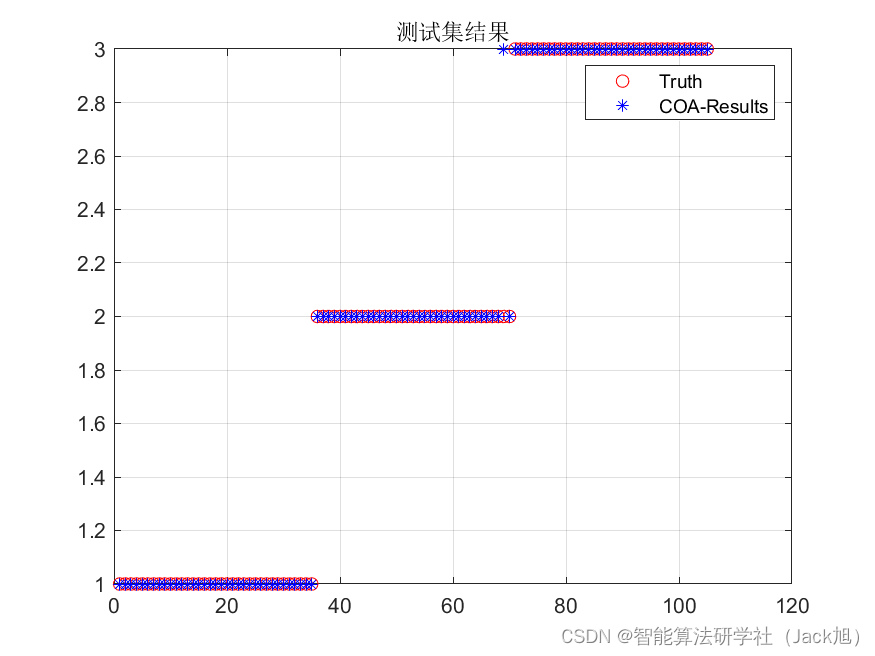

PCRLv2的整体结构。提出nsU-Net。nsU-Net由5个特征缩放组成删除了跳跃连接,防止网络找到恢复上下文信息的捷径解决方法。在nsU-Net基础上,提出将像素级、语义和尺度信息的保存解耦为两个任务 a.多尺度像素恢复 b.多尺度特征比较。原理将像素细节和语义合并到不同比例的特征图中。在训练阶段,从特征金字塔中随机选择一个特征尺度,在尺度上进行像素恢复和特征比较,x是一批输入图像,t1和t2表示两个不同的全局增强,t1’和t2’表示连续的局部增强。

全局增强t1,t2;例如翻转和旋转,目标是从全局角度扭曲输入图像的语义。局部增强t1’,t2’表示局部像素级的转变,像是随机噪声和高斯滤波,目的是扰乱局部语义。最后增强后的图像传递给siamese网络取进行像素恢复和特征比较,利用经过t1和t2操作从x得到的x1和x2作为像素恢复任务的实际目标。

在特征金字塔上执行SSL以编码多尺度视觉表示。两个nsU-Net产生的特征图进行比较,这就是特征比较。每次随机抽取其中一个尺度,在所选尺度上进行像素恢复和特征比较,这是尺度方面的学习。

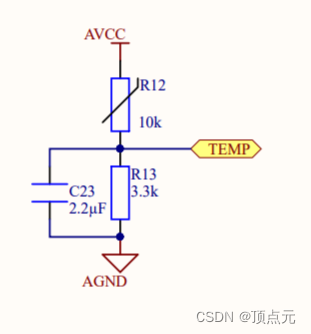

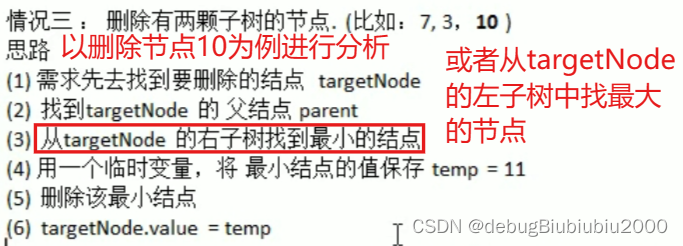

nsU-Net中的特征金字塔

上图是nsU-Net结构。彩色方块的是特征图。与之前的U-Net系列相比,nsUNet删除了跳过连接和关联的跳过特征映射,以防止像素恢复和特征比较任务的捷径解决方案。此外,nsUNet由五个级别的特征图(用不同的颜色表示)组成,其中进一步执行两个自我监督任务。

这里展示了特征提取的过程,特征图{F1,F2,F3,F4,F5}然后转发给后续任务相关头,分别并同时执行像素恢复和特征比较。

多尺度像素恢复

含义:旨在同时保留潜在视觉表示中的像素级和比例信息。

结构:下图(a)。

损失函数:每一个尺度都计算重建的2个特征图与x1,x2的MSE损失求和。

左边是像素恢复头的结构,右边是特征比较头的结构。没对特征图共享一个像素恢复头和特征比较头,不同的特征尺度使用不同的任务头。红线是比较。

多尺度特征比较

PCRLv2采用多尺度比较取代了PCRLv1中的混合对比策略。提出保留不同特征尺度的判别语义,这迫使模型保留多尺度自监督表示。

含义:旨在同时保留潜在视觉表示中的特征级和比例信息。

结构:上图(b)。

损失函数:我们将它们通过全局平均池化层和共享批量归一化层(如图4b所示)以获取一维表示vi就是红色双向箭头前面指到的地方,我们将 vi 转发给共享预测器 fP(·)预测器就是框起来的Predictor那部分,最后输出就是fp(vi)。下面那一个分支为 v i s v_i^s vis, f p ( v i s ) fp(v_i^s) fp(vis)。损失函数就是负的二分之一vi和 f p ( v i s ) f_p(v_i^s) fp(vis)计算cos相似度加上 v i s v_i^s vis和 f p ( v i ) f_p(v_i) fp(vi)计算cos相似度。

从多剪切到下剪切

多裁剪 [5] 被认为是提高自然图像中 SSL 性能的有用策略,它通过从原始输入中采样多个标准分辨率裁剪和更多低分辨率裁剪来增加输入视图的数量。多裁剪背后的一个关键见解是捕获场景或对象的各个部分之间的关系,而低分辨率视图可确保计算成本的可控增加。

在医学图像中多裁剪在2D X射线数据中效果好,单在3D体积数据中不收敛,根源是有限的输入大小与三维空间中许多候选剪切体积之间的矛盾。们负担不起大尺寸的 3D 输入,因为使用 3D 深度模型处理它们通常会花费巨大的 GPU 内存。另一方面,如果我们过度减小 3D 输入的大小,采样视图将过于分散,无法保证模型捕获局部-全局关联。

下裁剪主要包括三个步骤:

(i)在IoU约束下随机裁剪两个广泛的全局视图;

(ii) 在裁剪的全局补丁上找到最小的 3D 边界框;

(iii) 在 3D 边界框中随机裁剪多个局部补丁。

下裁剪中有两个关键操作:IoU 对全局视图的约束和最小边界框内的局部补丁采样。在实践中,第一个操作通过确保大于固定阈值的大型补丁之间的重叠来保证全局-全局关联。第二个操作缓解了局部视图的分散问题,并帮助模型发现局部-全局关系。

训练目标

LTotal有三个术语:LR(g1,g2),LC(g1,g2)和∑ m∈{1,2} ∑ˆ N k=1 LC(lk,gm)。第一项旨在保留多尺度学习表示中的像素级细节。第二个术语解决了将多尺度语义编码为潜在特征的重要性。最后一个术语旨在捕捉多尺度的全球-局部语义关系。

LR是像素恢复任务的损失,LC是特征比较任务的损失,特征比较的损失是比较特征之间语义差异用的负的cos相似度,最后一项比较的全局和局部的语义差异。

总结

我认为读了这篇论文收获就是尺度信息、特征信息、像素信息这三个它进行了细致的描述比较,因为这三种信息对下游任务都很重要,所以它设计了多任务来对三种信息进行学习。多尺度信息相比于像素、特征信息比较模糊,它使用金字塔结构,每次选择一个尺度进行学习,很好解决了这个问题。为了更好地提取多尺度特征,防止网络学到捷径,改进了U-Net为nsU-Net。然后设计了非常巧妙的损失函数。

我学习到了一般网络分为特征提取和任务头两部分,不知道理解对不对,然后特征提取很重要,要让提取的特征有泛化性、有代表性,任务头设计如何获取相应任务结果的同时,要设计合适的损失函数。

展望:未来,将继续探索如何将不同类型的信息以最佳方式集成到SSL中。(论文中的)