这篇文章详细介绍了全链接神经网络实现方法,以及卷积的实现方法。最后我们发现,卷积的实现方法与全链接大同小异,因为 torch 为我们做了很多工作,我们来看看这两个有什么区别。

我们使用 torch 框架来实现两种神经网络,来对图形进行分类。

NN

首先我们引入依赖包

import torch

from torchvision import datasets

from torchvision.transforms import ToTensor

from torch.utils.data import DataLoader

# from torch import nn

import torch.nn as nn

下载数据,ToTensor()是把PIL.Image转换为 tensor 格式数据

train_data = datasets.FashionMNIST(root='data',train=True,download=True,transform=ToTensor()

)

test_data = datasets.FashionMNIST(root='data',train=False,download=True,transform=ToTensor()

)

print(len(test_data))

使用 Dataloader 来处理数据

batch_size = 64

train_loader = DataLoader(dataset = train_data,batch_size = batch_size,shuffle = True

)

test_loader = DataLoader(dataset = test_data,batch_size = batch_size,shuffle = True

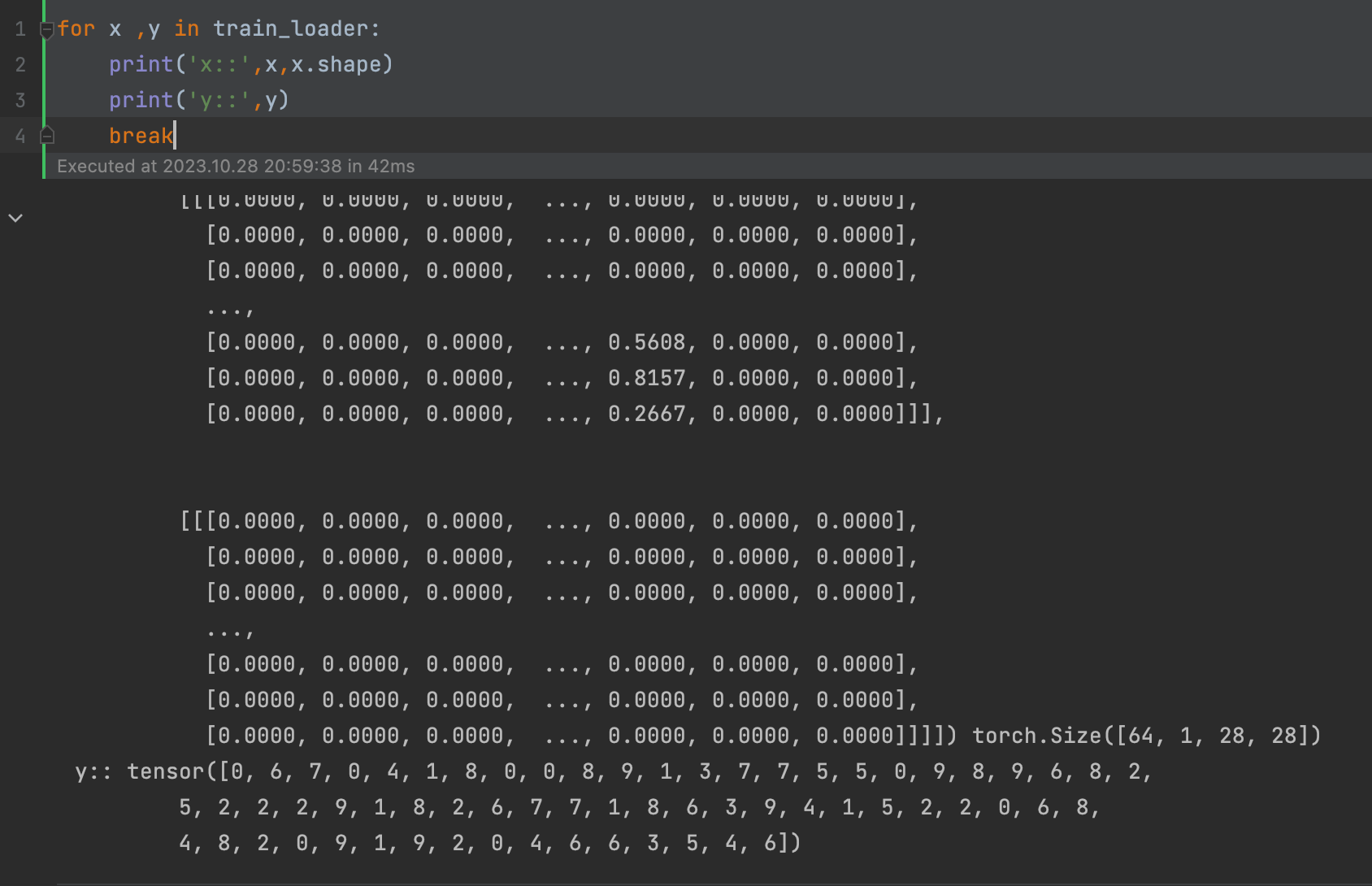

)我们来看看 train_loader 中的数据是什么格式

for x ,y in train_loader:print('x::',x,x.shape)print('y::',y)break

继承 nn.Moule,创建全链接神经网络,

第一层是784,第一个隐层未512,第二个隐层也为512,最后输出层为10(因为我们的图像数据是个10分类的数据)

class NN(nn.Module):def __init__(self):super().__init__()self.line = nn.Sequential(nn.Linear(28*28,512),nn.ReLU(),nn.Linear(512,512),nn.ReLU(),nn.Linear(512,10))def forward(self,x):x = nn.Flatten()(x)# print('x.shape::',x.shape)pred = self.line(x)return