就在外界传言马斯克正筹划成立新的研究实验室,以开发ChatGPT替代品的当口,北京时间3月2日,OpenAI在官方博客宣布开放ChatGPT和Whisper的模型 API。

马斯克入局、OpenAI开放,两件事情有着千丝万缕的联系——本质上,都是硅谷乃至全球科技力量在抢夺AI战场。

从OpenAI的角度,一边是竞争对手的追赶,一边是2023年赚取2亿美元营收目标的压力。尽管不少人对OpenAI此举表示“太快”、“太激进”,但选择在此时开放ChatGPT API或许是OpenAI预谋已久之事。

从模型层面来讲,开放API是模型经迭代优化,实现成本大幅下降后走向商业化的自然结果。从战略层面来讲,OpenAI为了延续前期形成的先发优势,通过开放API迅速搭建生态不失为一步好棋。

这一步棋落子后,给全球不同行业带来的影响却大相径庭。

对开发者来说,能够以更低的成本集成OpenAI的先进技术,开发自己的产品和服务,无疑是喜。但对那些可能被OpenAI打了个措手不及的竞争对手来说,恐怕是喜忧参半。受到影响的,也不仅仅是远在硅谷的公司和创业者。

本文将试图为读者解读以下问题:为什么开放ChatGPT和Whisper API是OpenAI早有预谋的计划?OpenAI开放API可能会对行业、竞争对手带来什么样的影响?

01 性能更好,价格却只有十分之一

Open AI开放的接口API,究竟是指什么?

支撑ChatGPT和Whisper API调用的分别是gpt-3.5-turbo模型和Whisper large-v2语音转文本模型。尽管OpenAI此次同时开放了两个API,但毋庸置疑,前段时间成为全球爆款的ChatGPT 的API受到了更多的关注。

据OpenAI介绍,gpt-3.5-turbo是目前最强大的GPT-3.5模型,将优化后的聊天成本降到了此前GPT-3.5模型的十分之一。目前的ChatGPT API定价为每1000个tokens 0.002美元,约750个单词。用户需要按照输入和输出的tokens总数来付费。

同时,OpenAI提供了专用实例选项,面向需要通过API运行大量数据,以及希望控制特定型号版本和系统性能的开发人员提供。这部分用户将按时间段支付,以分担预留计算基础设施的费用。

成本优势或许对于商业价值来说更加重要,但OpenAI或许并不满足于此。综合多方信息来看,gpt-3.5-turbo的响应速度也有了显著提升。2月9日,OpenAI面向ChatGPT Plus 计划用户提供了“Turbo(alpha)”模型,这也是Turbo模型与用户的首次见面。有用户在进行对比测试后发现,ChatGPT Turbo 比 ChatGPT Plus的响应速度平均快1.44倍。

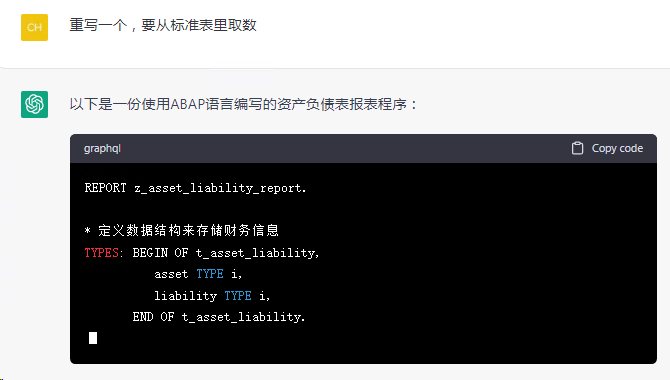

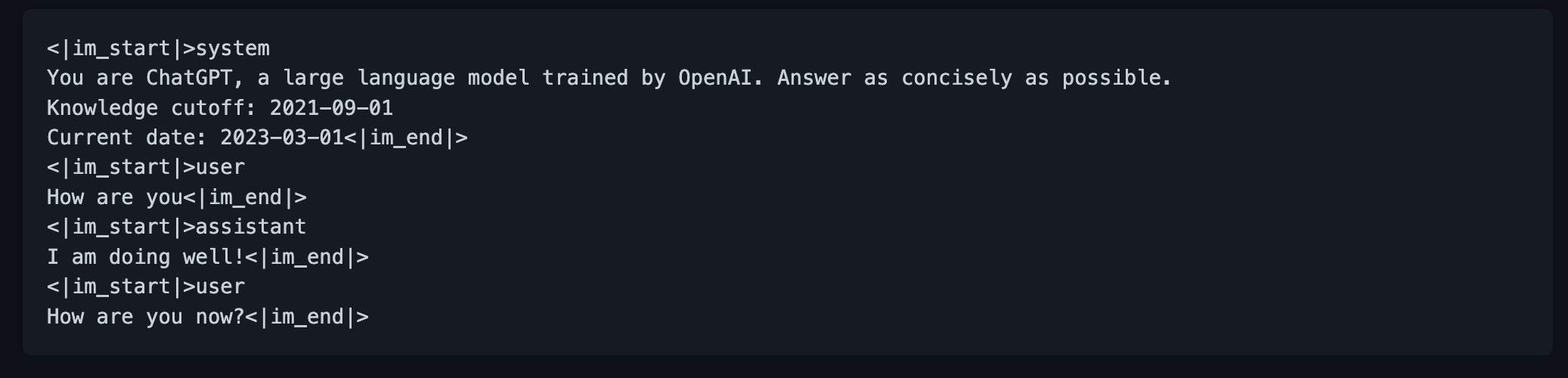

在模型API开放之外,OpenAI还创建了新的端点来和ChatGPT模型交互,即采用新的结构化的聊天标记语言(ChatML)。据介绍,标准的ChatGPT采用的是非结构化文本,需要使用一系列标记表示的原始文本。而ChatML将文本和元数据作为消息序列提供给ChatGPT API。开发人员可以在输入提示词时直接告诉ChatGPT“你是由OpenAI训练的大型语言模型。回答需要尽可能简洁”,以更好地过滤生成内容。同时,通过一些结构化的语言输入,模型可以分辨哪些指令来自开发人员、用户或AI本身。”

截图来自github.com

从OpenAI现任董事长Greg Brockman在接受Kyle Wiggers访谈时的对话内容可以看出,ChatML的采用或许是OpenAI针对此前肯尼亚血汗标注工厂事件的回应——寻求改善交互方式,缓解数据标注的压力。

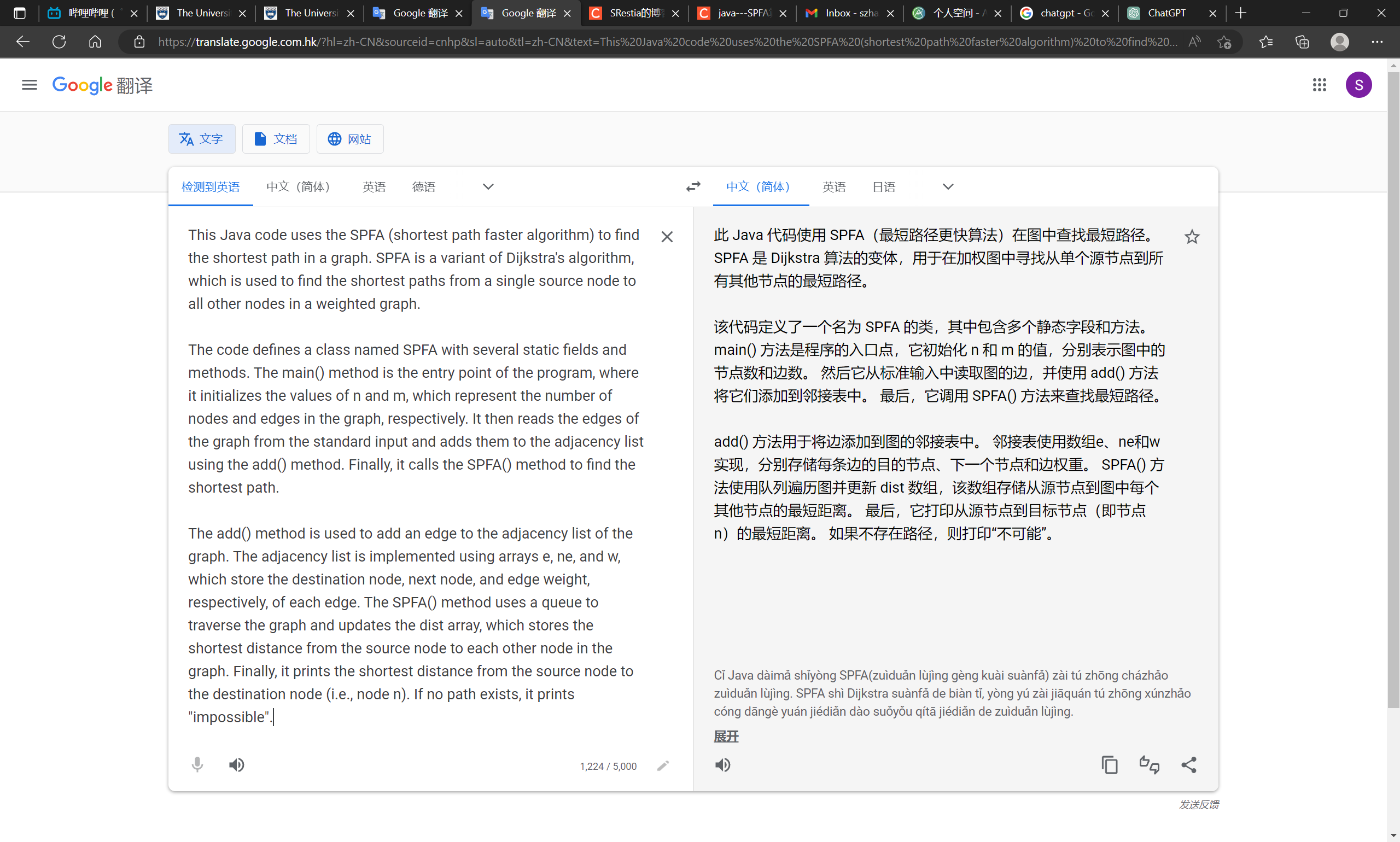

尽管Whisper没有ChatGPT那么明星,OpenAI也诚意十足。Whisper作为OpenAI 早在2022年9月就公布的开源语音转文本模型,可以实现多种语言的转录,并将这些语言翻译为英文,同时支持m4a、mp3、mp4、mpeg、mpga、wav、webm多种文件格式。

据悉,与谷歌、亚马逊等推出的现有语音识别系统相比,Whisper的优势主要在于对独特口音、背景噪声和技术术语的识别能力。这是由于OpenAI在模型训练过程中使用了从网络收集的 680,000 小时多语言和“多任务”数据。

优化后的Whisper large-v2 模型能够实现更快的服务响应,同时开发人员对API的调用也更加便利。目前,Whisper API 的定价为每分钟0.006 美元。

02 数月内多次迭代,OpenAI野心藏不住

事实上,本次“跳楼大降价”和产品迭代优化,已经并不是OpenAI的第一次行动了。

“极致优化”,在过去几个月频繁发生:

早在2月初推出ChatGPT Plus计划时,OpenAI就声称将在此后推出ChatGPT API。紧接着,在2月9日,OpenAI面向ChatGPT Plus 计划用户提供了“Turbo(alpha)”模型的选项,并表示将在后续面向所有用户推出Turbo。

OpenAI对ChatGPT的模型优化/功能更新,根据OpenAI官网整理

在产品性能的不断追求之外,让价格降低,也是商业上的最佳选择。

这次,OpenAI把ChatGPT模型API降至原本价格的十分之一,而原本的价格已经非常低了。从商业竞争的角度,OpenAI这次颇有前几年中国互联网的影子——大额融资、亏钱降价、扩大市场份额、挤压对手生存空间,最后试图形成垄断。

正如开头提到的,马斯克开始招兵买马,谷歌虎视眈眈,全球范围内创业公司比如Anthropic、A21 Labs也都在紧锣密鼓推出类似产品。对于OpenAI来说,必须要在其他对手尚未做出成绩时占领大部分市场。

恰好,微软投资的几十亿美元中,相当一部分是要以OpenAI使用微软服务器的形式提供。如Sam Altman所说,ChatGPT每次对话仅需要几美分,但随着使用人数和对话次数的增加,其总计算成本也是相当高的。但对于OpenAI来说,反正微软投资的部分资金拿不出来,只能在微软里消费,不如就不考虑成本,把用户端价格降下来。

但这步棋,除了OpenAI,其他对手谁都不敢做,也没钱做。

当然,此举一出,不少声音质疑OpenAI后续商业化之路怎么走,毕竟今年还有2亿营收的目标。据接近OpenAI的创业者分析,ChatGPT近期会推出一些提供给大B的私有化产品,客单价目前评估在几十万至百万美元级别,可以帮助公司创造更多现金价值。

总之,OpenAI选择低价开放ChatGPT API是按计划行事。而这一计划的背后,实则体现了OpenAI采取的一贯发展路线——极致优化。更加根本的驱动因素之一或许正是OpenAI成立之初的愿景——AGI,让更多的人使用AI技术,并从中获利。

如此一来,OpenAI或将延续其在AGI领域中已经形成的先发优势——通过领先于Google等竞争对手迅速构建生态。在该生态下,OpenAI既能通过更多的API调用赚取直接收入,也能在开发者授权的情况下,获得更多的来自全球的高质量数据。

更重要的是,未来面向终端用户提供各类垂直应用的头部玩家,可能很大部分是在OpenAI的平台中成长起来的。而OpenAI也将真正成为AGI时代的基础设施提供者。

03 全球AI格局因此巨变

OpenAl开放ChatGPT API会产生什么样的影响?我们可以以不同群体为分析视角。

一部分是有能力做出自己的大语言模型的公司,这些公司或许模型已经与OpenA差距并不大,或许正处在研发阶段,在硅谷外或许以色列、中国等都会存在——最直接影响或许是定价策略的制定。

有了OpenAl每1000个tokens 0.002美元的标杆定价,后来者要想制定更高的价格,必然会面临市场质疑——价格更高,模型性能也更好吗?

不仅如此,对一些企业来说,可能需要重新衡量,现阶段现金流是否能够支撑在高成本的基础上制定更低的价格。如果不能,那么开放API可能会路途漫漫,而这将会影响包括生态构建、通过b端先行获得收入等一系列策略的制定和执行。

尤其是对其中还在寻求融资的创业公司而言,投资人或许需要重新估计项目价值。毕竟,OpenAl能够压缩成本的重要原因——手握微软云计算“优惠券”,已经足以成为很多创业公司开放API的拦路虎。

但同时,OpenAl也为同行注入了强心剂:大模型成本降低的空间很大,实现同等水平的技术进步可能只是时间问题。

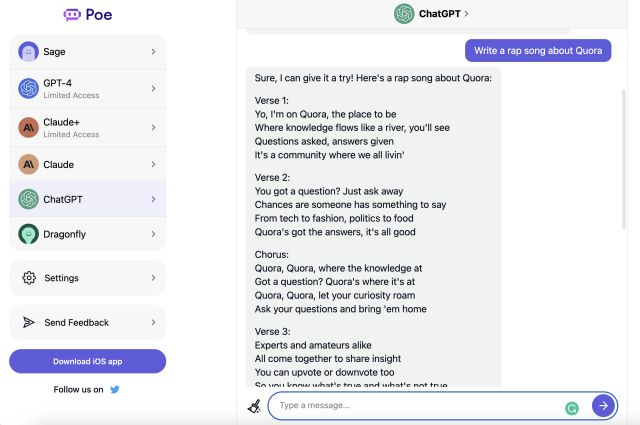

另一部分群体是想要从应用层发挥GPT模型价值的公司。OpenAl已经展示了部分使用ChatGPT和WhisperAPI的商业案例,包括全球学习平台Quizlet,美国生鲜配送独角兽Instacart,AI语言学习工具Speak,以及北美跨境电商头部玩家Shopify。同样使用GPT模型的营销场景应用公司Jasper已经被顶到了15亿估值。如果GPT价格更低,对于这些公司来说,成本自然更低。

可以预见,将有更多的创业者加速汇集到OpenAl的平台上。未来会涌现出各类垂直应用,衍生出各种创新的商业模式,促进AI技术落地到商业和生活的方方面面。

而新技术的商业化落地也会反哺技术的持续优化和创新。

最后一部分群体是正在努力追赶的中国公司,包括底层大语言模型公司和应用公司。目前,国内版本的大模型创业正在如火如荼,但至今没有一个可用的版本面世;应用侧的公司,也因为一直没有可靠的底层技术而难以发展。

对国内从业者来说,或许此时正是重新梳理思路的关键时刻——厘清自身的核心竞争力,制定切实可行的发展路线。如果跟进,那么关键就在于探索能够达成和gpt-3.5-turbo模型优化类似效果的技术路线。但是想要快速实现突破,或许需要考虑资源整合,而非各自为阵。