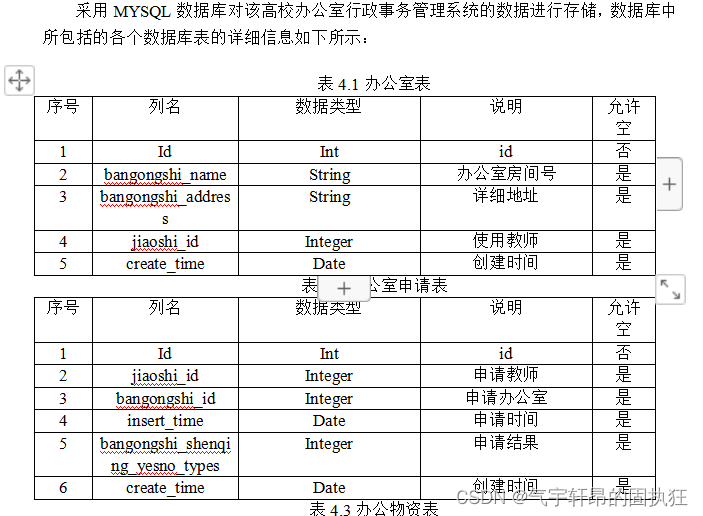

前言

好久没写博客了,最近大模型盛行,尤其是ChatGLM3上线,所以想部署试验一下。

本篇只是第一篇,仅仅只是部署而已,没有FINETUNE、没有Langchain更没有外挂知识库,所以从申请资源——>开通虚机——>部署GLM3全程只用了18分钟,后面试通其它步骤后,会继续写的。

本篇文章参考了 程序员树先生 的“免费部署一个开源大模型 MOSS”

同时也参考了GLM3的github说明

一、申请阿里云机器学习平台PAI

本来是想在本地部署学习的,但是笔记本电脑只是3060的消费显卡,又搞不到A100甚至A10都搞不到,正好阿里云有3个月免费的GPU资源可以体验,所以正好一试。

只要没有申请过 PAI-DSW 资源的新老用户皆可申请 5000CU 的免费额度,3个月内使用。

免费试用活动页: https://free.aliyun.com/

1、申请资源

具体申请步骤我就不多做阐述了,大家可以参考上面树先生的文章,虽然有一些小出入,但大体是一样的。

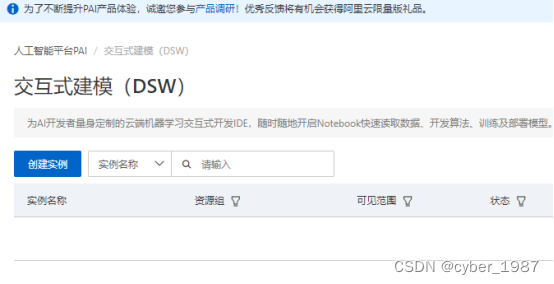

2、创建实例(大概率是容器)

注1:GPU规格可以选择V100的这个(A10资源很少,即使申请成功了,后面重启经常没资源)。

因为比较贵,如果一直开着的话,15天就用完了。好在阿里云有“闲置关机策略”,系统会不定期对实例进行闲置检测判断,对于闲置实例做自动关机处理。不过为了以防万一,仍然建议及时主动关机。

注2:因为GLM3对pytorch、cuda的版本有要求,所以建议选择官方镜像里的较新的版本,比如:

pytorch2.0.1tensorflow2.13.0-cpu-py38-ubunt,否则后面必定会报错,提示版本老旧等问题。

或者也可以使用镜像URL:dsw-registry-vpc.cn-hangzhou.cr.aliyuncs.com/pai/modelscope:1.9.5-pytorch2.0.1tensorflow2.13.0-gpu-py38-cu118-ubuntu20.04

二、部署GLM3

部署GLM3,包括其它类似的开源大模型,步骤都是差不多的,毕竟这些高校/大厂都帮大家封装好了,所以并没有特别繁琐的步骤。

在我看来,主要就是三步:1、环境搭建;2、git下载GLM3(如果要本地化部署,还要下载模型);3、修改路径并启用

1、环境搭建

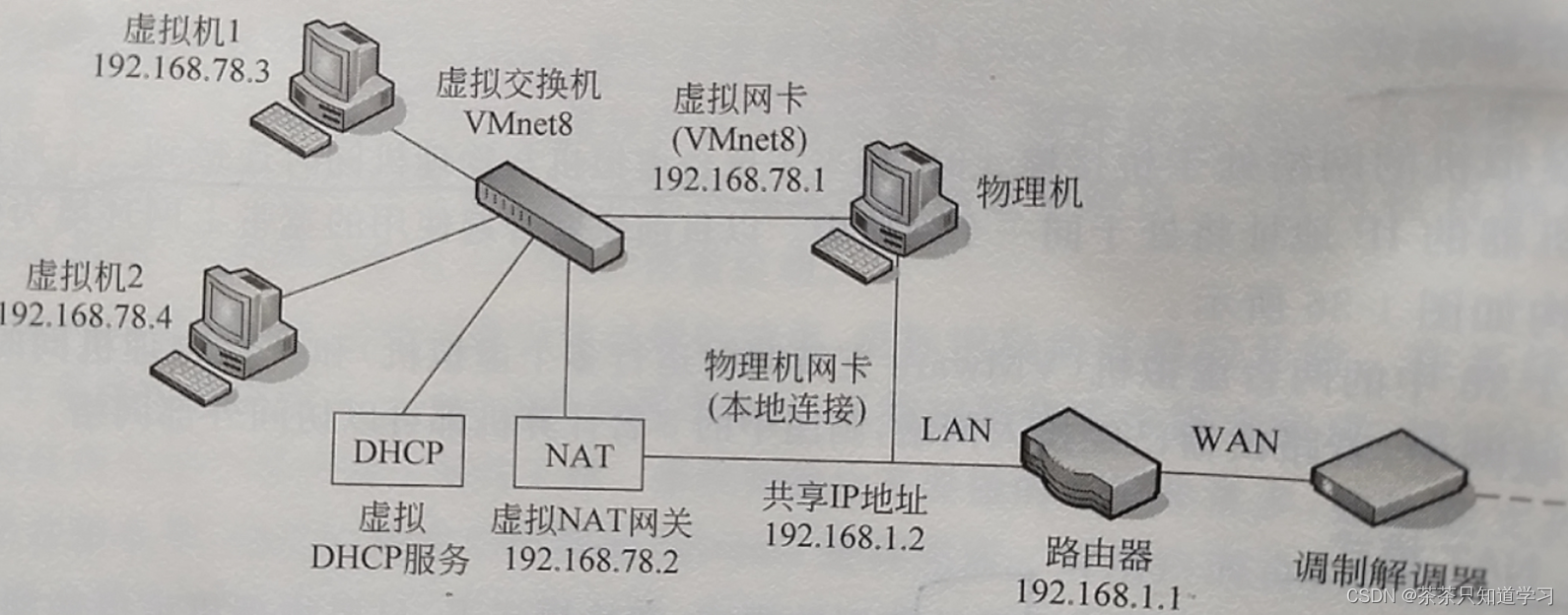

因为使用的是阿里云的PAI,默认已经帮我们配置好了环境变量、网络,装好了python甚至pytorch、tensorflow等等,所以这些正常比较麻烦的操作已经不需要我们再搞了。

进入虚机后,默认页面如下:

点击terminal进入,后面的步骤主要就是参考github上的GLM官方步骤了。

2、git下载GLM3(注:从这开始需要一点点的Linux基础)

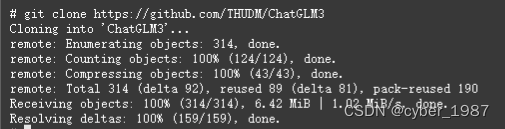

2.1 git clone下载GLM3仓库

2.1.1首先git clone下载GLM3仓库,并切换到这个文件夹下

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3

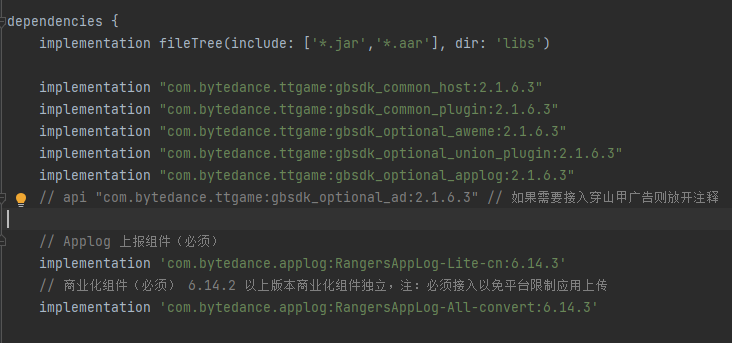

2.1.2 然后使用 pip 安装依赖:

pip install -r requirements.txt

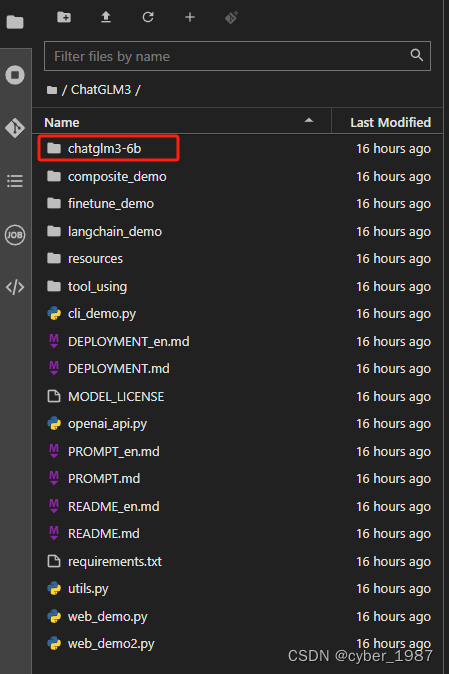

2.2 git 下载本地模型

因为模型很大(总共11.6GB),github上很难下下来,所以曲线救国,从modelscope上git下载

git lfs install

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

这样,就会在ChatGLM3这个文件夹下,新出来一个chatglm3-6b文件夹

3、修改变量路径并启用

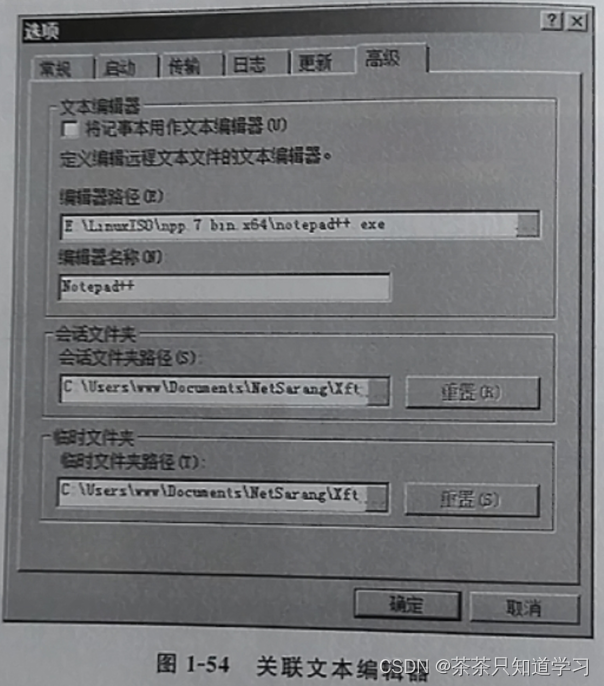

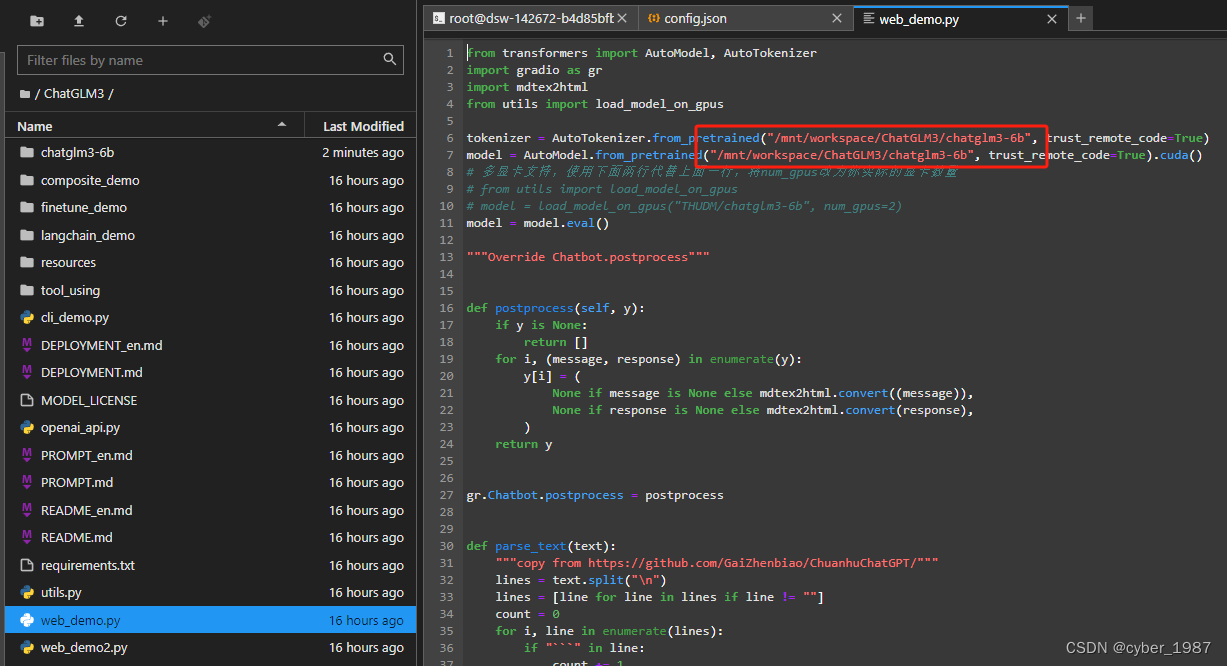

有2个文件需要修改变量路径,一个是ChatGLM3下的“web_demo.py”,另一个是chatgm3-6b下的“config.json”,都是把默认的“THUDM/”修改为“/mnt/workspace/”

这里的修改,可以使用vim,也可以直接左边栏双击打开文件修改(推荐)

3.1ChatGLM3/chatglm3-6b下的config.json

3.2 ChatGLM3下的web_demo.py

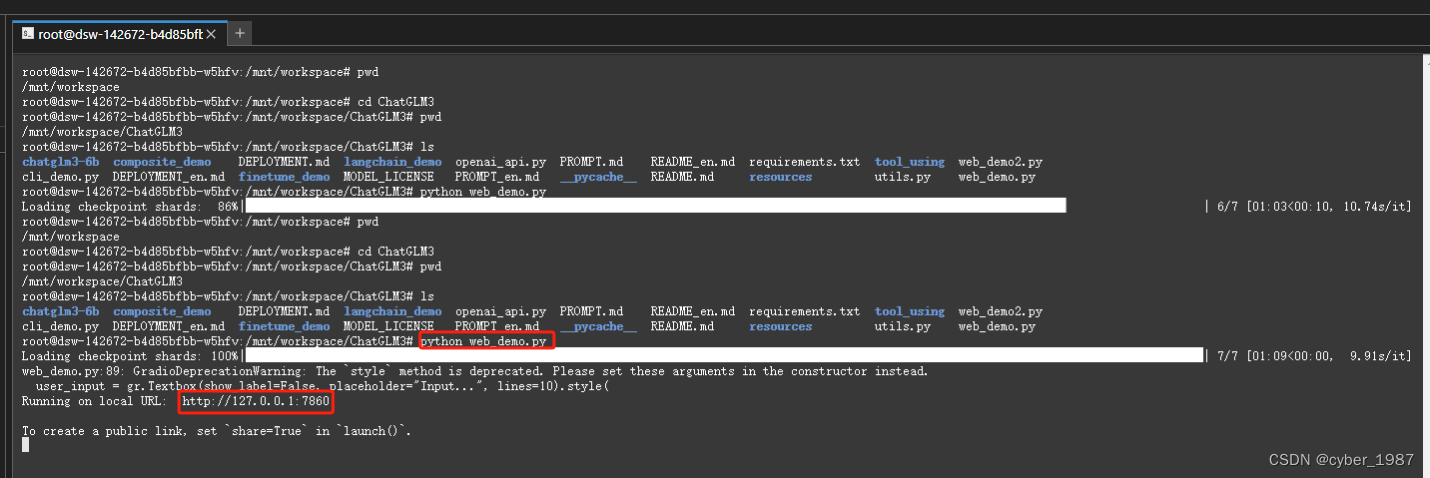

3.3 启动web_demo.py

在ChatGLM3目录下进行启动

python web_demo.py

直接点击上图第二个红框url,会跳转打开一个web UI,这样就完成了GLM3的大模型私有化部署

![[LeetCode]-225. 用队列实现栈-232. 用栈实现队列](https://img-blog.csdnimg.cn/6fe972f020854c14b111f172f0196d4e.png)