论文地址:https://arxiv.org/abs/2211.11167

代码地址:https://github.com/hhb072/STViT

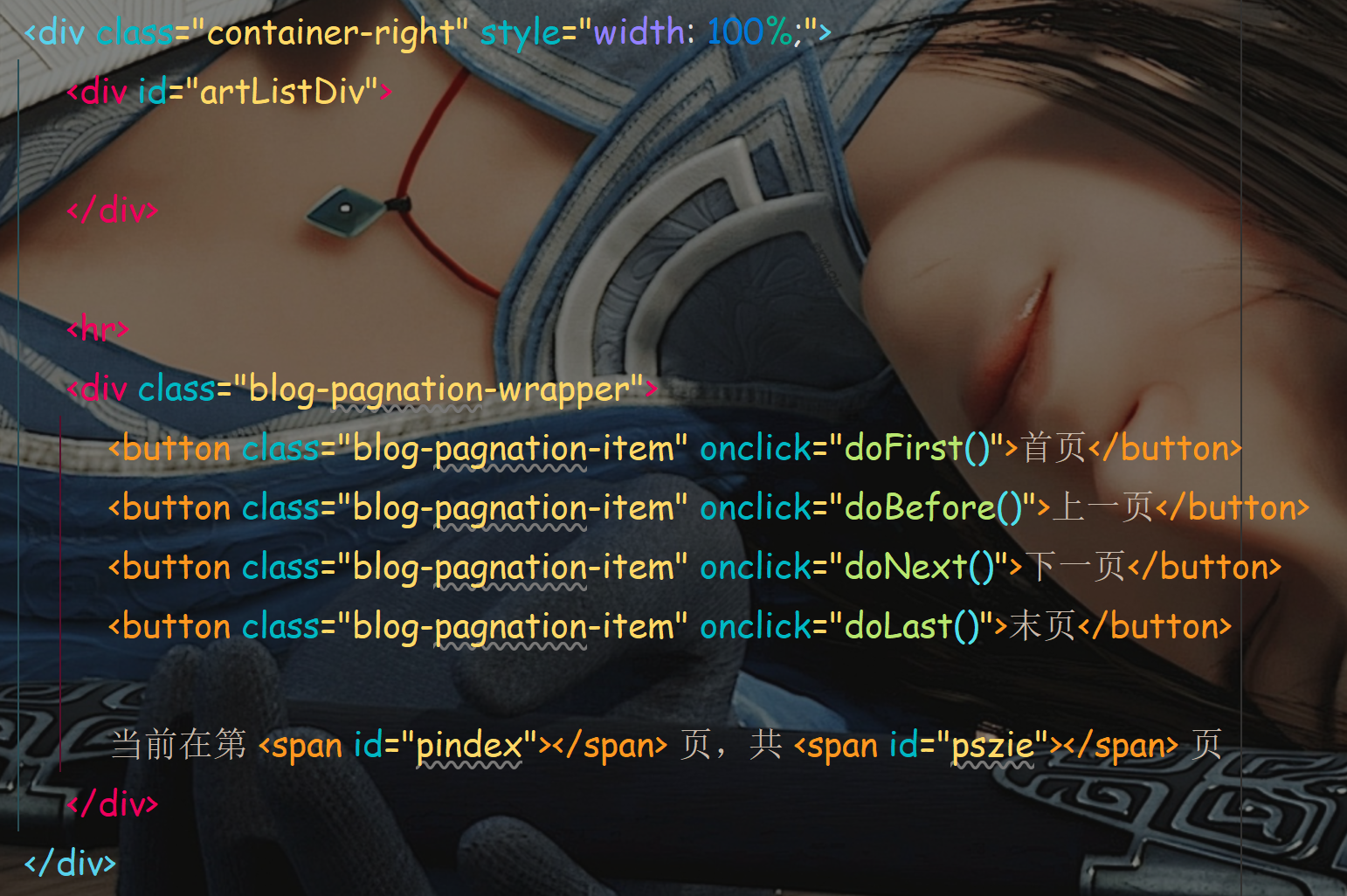

视觉变换器已经在许多视觉任务中取得了令人印象深刻的性能。然而,它在捕捉浅层的局部特征时可能会受到高度冗余的影响。因此,引入了局部自注意力或早期卷积,这些方法牺牲了捕捉长距离依赖性的能力。这引发了一个挑战:我们是否可以在神经网络的早期阶段实现高效且有效的全局上下文建模?为解决这个问题,我们从超像素的设计中汲取灵感,超像素可以减少后续处理中的图像基元数量,并将超级标记引入视觉变换器。超级标记试图提供视觉内容的语义有意义的分割,从而减少自注意中的标记数量,同时保留全局建模。具体而言,我们提出了一个简单而强大的超级标记注意力(STA)机制,包括三个步骤:首先通过稀疏关联学习从视觉标记中抽样超级标记,然后对超级标记执行自注意力,最后将它们映射回原始标记空间。STA将传统的全局注意力分解为稀疏关联图和低维度注意力的乘积,从而在捕捉全局依赖性方面具有高效性。基于STA,我们开发了分层视觉变换器。大量实验证明了它在各