大家好,我是微学AI,今天给大家介绍一下人工智能(pytorch)搭建模型22-基于pytorch搭建SimpleBaseline(人体关键点检测)模型,并详细介绍该网络模型与代码实现。本文将介绍关于SimpleBaseline模型的原理,以及利用pytorch框架搭建模型,以及它的应用场景。SimpleBaseline模型是一个用于人体关键点检测的深度学习模型。它可以用来检测人体姿势中的关键点,如头部、肩膀、手肘、手腕、臀部、膝盖和脚踝等关键点。SimpleBaseline模型结合了卷积神经网络(CNN)和残差网络(ResNet)的特点,通过端到端的学习来实现对人体姿势关键点的准确定位。这种模型在计算机视觉领域得到了广泛的应用,例如在人体动作识别、体育分析、医学影像分析等方面具有重要意义。

目录

- 引言

- SimpleBaseline模型的概述

- SimpleBaseline模型的结构和原理

- pytorch搭建SimpleBaseline模型

- SimpleBaseline模型的应用场景

- 结论

1. 引言

近年来,随着深度学习的发展和计算机视觉技术的进步,人体关键点检测成为了计算机视觉领域的一个重要研究方向。人体关键点检测旨在从图像或视频中准确地识别和定位人体的关键点,如头部、肩膀、手肘、手腕、臀部、膝盖和脚踝等。

它是一种用于人体关键点检测的深度学习模型,它以其简单而高效的架构而闻名。该模型的设计思想是通过利用卷积神经网络(CNN)和残差网络(ResNet)的结构特点,实现对人体姿势关键点的准确定位。

2. SimpleBaseline模型的概述

SimpleBaseline模型是一种用于人体关键点检测的模型,它由北京大学的研究团队提出。该模型以其简单的设计和出色的性能获得了广泛的关注。它基于深度学习技术,使用卷积神经网络(CNN)作为基础结构,以识别并预测人体的关键点。

SimpleBaseline模型的核心结构包括一个骨干网络(backbone network)和一个关键点回归器(keypoint regressor)。骨干网络负责从输入图像中提取有用的特征表示,并将这些特征传递给关键点回归器进行关键点的定位。关键点回归器通过学习一个映射函数,将骨干网络提取的特征映射到真实世界中的关键点位置。该模型的训练过程通常采用监督学习的方法,即通过提供标注好的人体关键点位置作为训练数据,利用损失函数来优化模型参数,使其能够准确地预测出人体关键点的位置。该模型具有多种优点。首先,它的网络结构简单而高效,不需要过多复杂的设计和计算资源。其次,该模型在各种复杂环境下都能表现出较好的性能,具有较强的泛化能力。另外,SimpleBaseline模型在速度和准确度之间取得了良好的平衡,适用于实时应用和大规模数据处理。

3. SimpleBaseline模型的结构和原理

SimpleBaseline模型的核心是一个基于残差网络(ResNet)的卷积神经网络。基于ResNet的设计,允许信息能够有效地在网络的各层之间传递,从而有助于深层网络的训练。

首先,图像通过ResNet,生成一系列的特征图。然后,将这些特征图通过三个连续的卷积层和上采样层进行处理,生成更精细的特征图。最后,使用一个1x1的卷积层将特征图转化成关键点热力图。

模型的训练过程采用了均方误差损失函数,该损失函数比较了预测的关键点热力图和真实的关键点热力图之间的差异,以此来优化模型的参数。

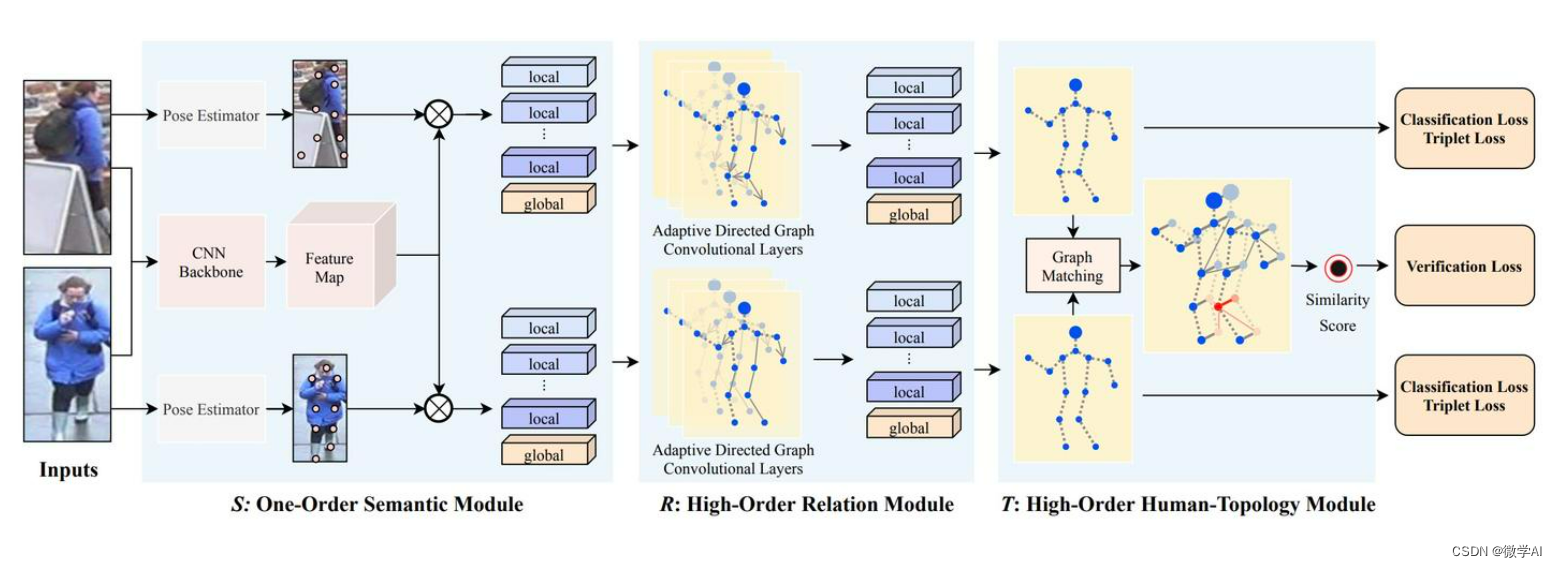

SimpleBaseline是一种基于卷积神经网络(CNN)的图像关键点检测模型。其分为以下几个部分:

1.CNN特征提取:SimpleBaseline使用了一个预训练的ResNet作为特征提取器,通过卷积和池化等操作将输入的图像转换为高维特征向量。

2.Hourglass模块:Hourglass模块是SimpleBaseline中的核心部分,用于对特征进行多层次的处理和融合,以提高关键点检测的准确性。Hourglass模块由多个重复的下采样和上采样步骤组成,其中下采样过程中使用了池化和卷积等操作,而上采样过程中则使用了反卷积和残差连接等技术。

3.关键点预测:在Hourglass模块处理后,SimpleBaseline使用了一个小的卷积神经网络来对每个关键点进行回归预测。这个子网络包含了多个卷积和全连接层,其输出结果即为关键点的坐标位置。

SimpleBaseline模型的原理可以概括为利用卷积神经网络进行特征提取,结合Hourglass模块进行多层次处理和融合,最终使用子网络对关键点进行回归预测。

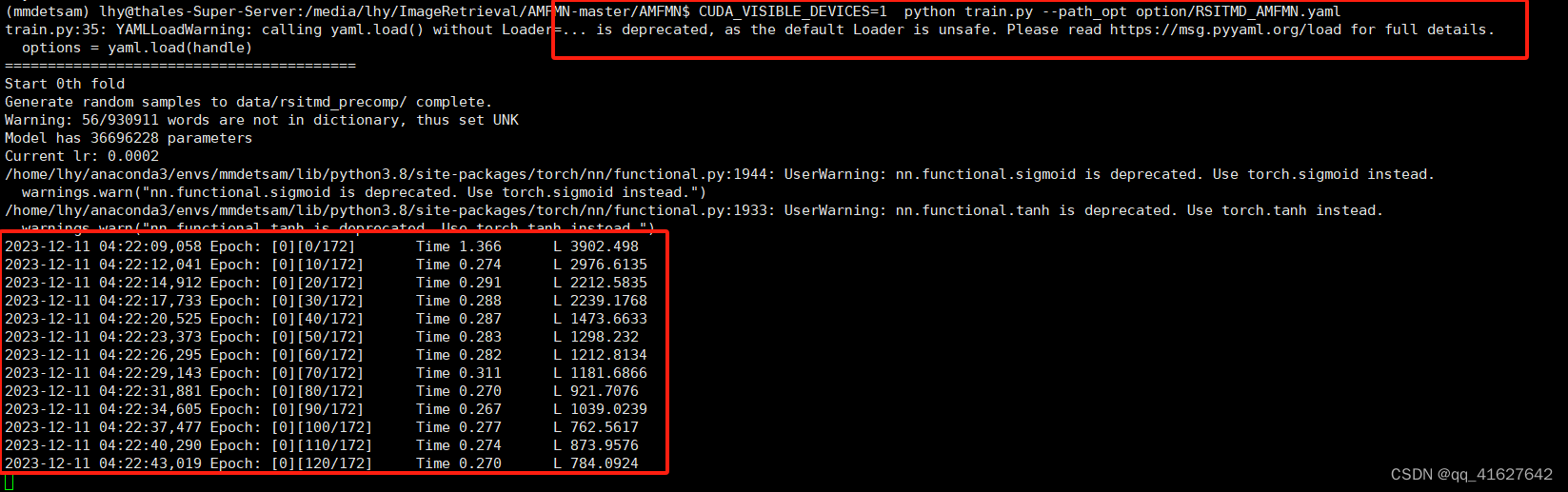

4. pytorch搭建SimpleBaseline模型

import torch

import torch.nn as nn

import torchvisionclass ResBlock(nn.Module):expansion = 4def __init__(self, inplanes, planes, stride=1, downsample=None):super(ResBlock, self).__init__()self.conv1 = nn.Conv2d(inplanes, planes, kernel_size=1, bias=False)self.bn1 = nn.BatchNorm2d(planes)self.conv2 = nn.Conv2d(planes, planes, kernel_size=3, stride=stride,padding=1, bias=False)self.bn2 = nn.BatchNorm2d(planes)self.conv3 = nn.Conv2d(planes, planes * self.expansion, kernel_size=1,bias=False)self.bn3 = nn.BatchNorm2d(planes * self.expansion)self.relu = nn.ReLU(inplace=True)self.downsample = downsampleself.stride = stridedef forward(self, x):residual = xout = self.relu(self.bn1(self.conv1(x)))out = self.relu(self.bn2(self.conv2(out)))out = self.bn3(self.conv3(out))if self.downsample is not None:residual = self.downsample(x)out += residualreturn self.relu(out)class SimpleBaseline(nn.Module):def __init__(self, nJoints):super(SimpleBaseline, self).__init__()self.inplanes = 64self.conv1 = nn.Conv2d(3, 64, kernel_size=7, stride=2, padding=3,bias=False)self.bn1 = nn.BatchNorm2d(64)self.relu = nn.ReLU(inplace=True)self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.layer1 = self._make_layer(ResBlock, 64, 3)self.layer2 = self._make_layer(ResBlock, 128, 4, stride=2)self.layer3 = self._make_layer(ResBlock, 256, 6, stride=2)self.layer4 = self._make_layer(ResBlock, 512, 3, stride=2)self.deconv_layers = self._make_deconv_layer()self.final_layer = nn.Conv2d(in_channels=256,out_channels=nJoints,kernel_size=1,stride=1,padding=0)def _make_layer(self, block, planes, blocks, stride=1):downsample = Noneif stride != 1 or self.inplanes != planes * block.expansion:downsample = nn.Sequential(nn.Conv2d(self.inplanes, planes * block.expansion,kernel_size=1, stride=stride, bias=False),nn.BatchNorm2d(planes * block.expansion),)layers = []layers.append(block(self.inplanes, planes, stride, downsample))self.inplanes = planes * block.expansionfor i in range(1, blocks):layers.append(block(self.inplanes, planes))return nn.Sequential(*layers)def _make_deconv_layer(self):layers = []for i in range(3):layers.append(nn.ConvTranspose2d(in_channels=self.inplanes,out_channels=256,kernel_size=4,stride=2,padding=1,output_padding=0,bias=False))layers.append(nn.BatchNorm2d(256))layers.append(nn.ReLU(inplace=True))self.inplanes = 256return nn.Sequential(*layers)def forward(self, x):x = self.conv1(x)x = self.bn1(x)x = self.relu(x)x = self.maxpool(x)x = self.layer1(x)x = self.layer2(x)x = self.layer3(x)x = self.layer4(x)x = self.deconv_layers(x)x = self.final_layer(x)return xif __name__ == '__main__':model = SimpleBaseline(nJoints=16)print(model)data = torch.randn(1,3,256,192)out = model(data)print(out.shape)5. SimpleBaseline模型的应用场景

SimpleBaseline模型的用途非常广泛,它可以在各种应用中进行人体关键点的检测。

1.体育分析:在体育比赛中,可以使用SimpleBaseline模型来追踪运动员的动作,从而进行更深入的运动分析。

2.健康监测:在医疗保健领域,可以通过分析人的行动来评估其健康状况。

3.游戏和娱乐:在视频游戏和增强现实应用中,可以使用该模型来捕捉玩家的动态,提供更富有沉浸感的体验。

4.安全监控:在安全监控中,可以通过分析行人的行为和动作,进行异常行为的检测。

5. 结论

SimpleBaseline模型是一种强大且易于实现的人体关键点检测模型。它利用深度学习技术,通过简单而有效的方法,实现了在各种应用场景中准确而高效的人体关键点检测。尽管该模型的结构相对简单,但其性能却与最先进的模型相媲美,这充分证明了其设计的优越性。

希望大家能从这篇文章中获得有关SimpleBaseline模型的深入理解,并在您的研究或应用中找到它的价值。