1、写作动机:

经过预训练的生成式语言模型更好地捕捉实体之间的结构和依赖关系,因为模板提供了额外的声明性信息。先前工作中模板的设计是依赖于语言的,这使得很难将其扩展到零样本跨语言转移设置。

2、主要贡献:

作者提出了一项研究,利用多语言预训练生成模型进行零样本跨语言事件论证提取,并提出了X-GEAR模型。

3、零样本跨语言事件论元抽取:

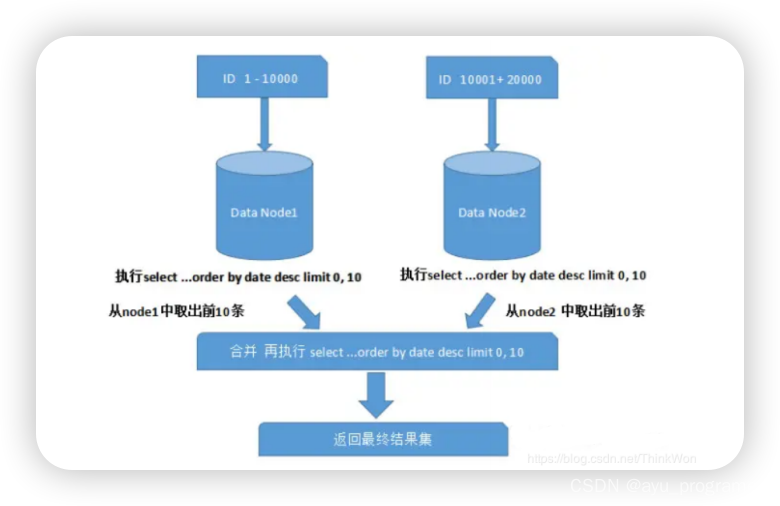

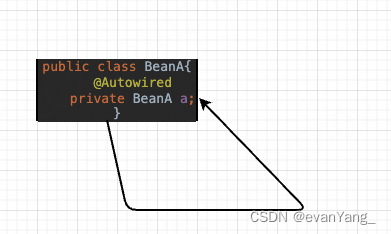

4、X-GEAR方法:

图如上所示。

所用模型:对 mBART-50/mT5进行微调,并且添加复制机制来更好地适应输入语言的变化。

4.1语言无关模板:

标记([None],<Agent>,</Agent>,<Victim>等)被编码为预训练模型从未见过的特殊标记,因此它们的表示需要从头开始学习。由于这些特殊标记与任何语言都不相关且没有经过预训练,因此它们被视为与语言无关。

4.2目标输出字符串:

4.3输入格式:

输入段落+提示

提示=触发器+语言无关模板

PS:提示中没有明确包含事件类型,因为模板隐含地包含了这个信息。

4.4训练:

初始目标函数:

添加复制机制:通过添加复制机制来增强多语言预训练生成模型,以帮助X-GEAR更好地适应跨语言情景。该方法将由多语言预训练生成模型Pgen计算的词汇分布和由复制分布Pcopy加权求和,其中wcopy ∈ [0,1]是通过将时间步i处的解码器隐藏状态传递给线性层来计算的复制概率。至于Pcopy,它是指由最后一个解码器层计算的(在时间步i处)的交叉注意力加权的输入标记上的概率。

5、实验:

数据集:ACE2005(英文、中文、阿拉伯文),ERE(英文、西班牙文)

比较模型:OneIE:一个基于分类的单语事件抽取模型。

CL-GCN:一个基于分类的跨语言事件论元角色标注模型。

GATE:基于分类的零样本跨语言事件论元角色标注的最新模型。

TANL:用于单语事件论元抽取的生成式模型。

X-GEAR:本文的模型,考虑三种不同的预训练生成语言模型:mBART-50-large、mT5-base和mT5-large。

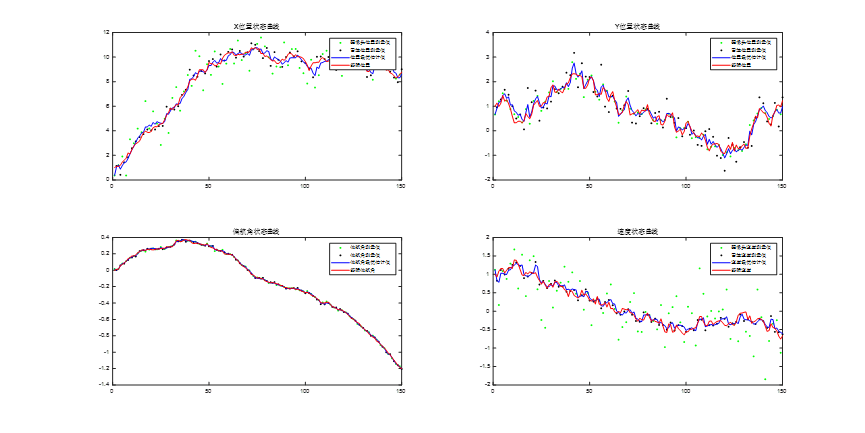

实验结果:

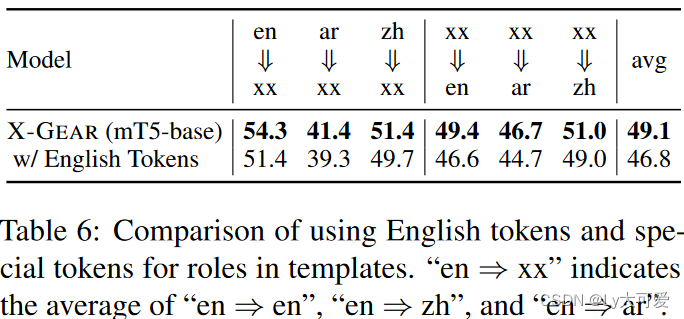

消融实验: