整理 | 杨阳

出品 | CSDN(ID:CSDNnews)

四年前,纽约大学教授Marcus为反驳深度学习三巨头之一Bengio的“有意识先验”和“解纠缠观念”理论,发表了一篇名为《Deep Learning: A Critical Appraisal》的论文,长达27页。

论文地址:

https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf

概括来说,就是针对Bengio和Lecun所认为的“深度学习是通向未来AI无可替代路径”的深度批判。

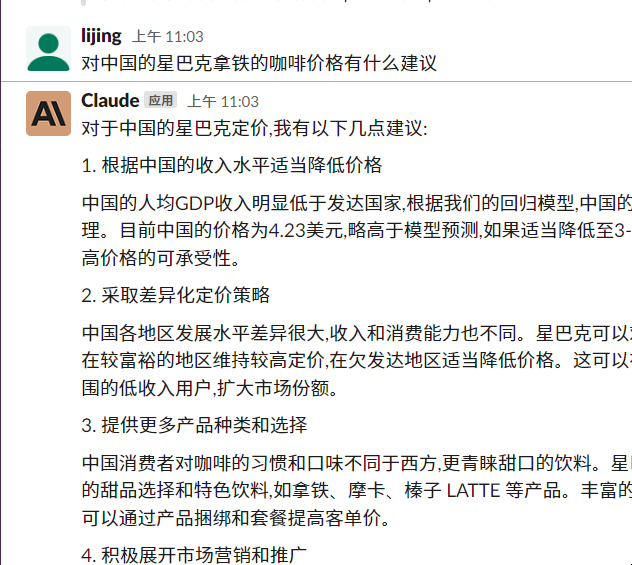

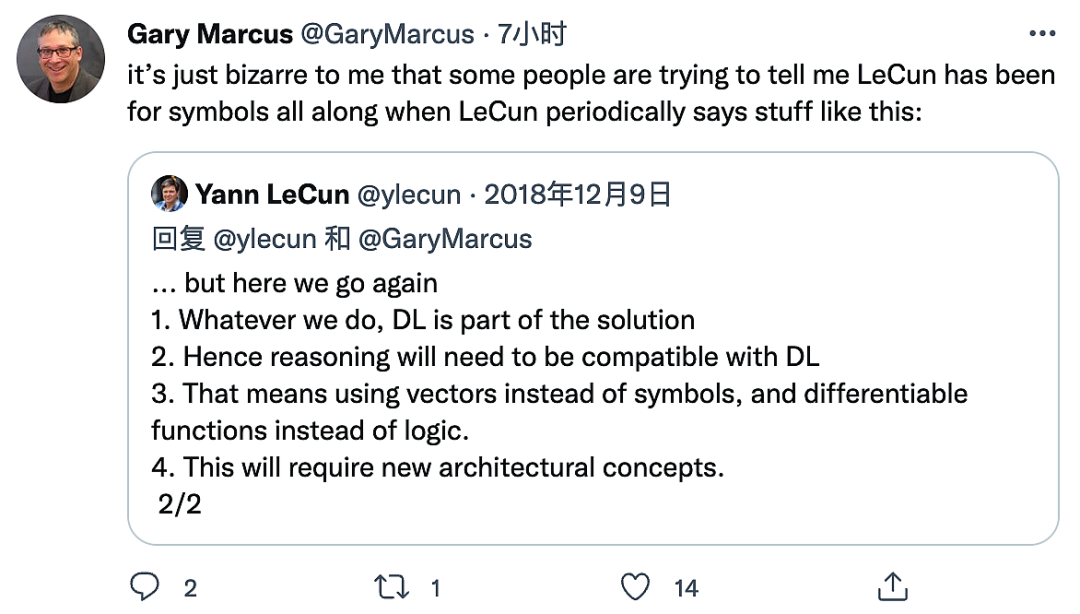

然而,就在Marcus笔迹未干之际,深度学习三巨头的另一位——Lecun就在推特上回怼:

“Thoughtful, perhaps. But mostly wrong nevertheless.(有想法,可能吧。但大部分都错了)。”在Yann Lecun看来,Gary混淆了“深度学习”和“监督学习”的概念,所以“mostly wrong”。

正因为这段话,有了他们的最新battle。针对近日LeCun在ZDNet的采访中的自我否定:“已放弃使用生成网络从这一帧预测视频下一帧的研究,这是一次彻底的失败”。看到昔日对手的自证失败,Marcus自然不能错过“自证清白”的机会,在他看来,LeCun现在说的都是他之前说过的,大部分内容都在上述论文中,但LeCun当时还嘲笑“mostly wrong”。

而在他发出此言论之前,Lecun已经在采访中对这位老对手发起了新一轮“攻击”:“Gary Marcus不是做AI的,而是一个心理学家,从未对人工智能做出任何贡献。”

Marcus当然也不能让他:“LeCun不想让别人发现他响应过我曾经的观点,也不对这些观点分享任何credit,这违反学术礼仪。另外,为了让别人不信任我,他在采访中对我进行了无端的、完全不实的抨击……”

大佬们吵得热闹,但他们究竟在吵什么?能够这样十年如一日地吵来吵去,究竟因为哪些原则问题必须如此当仁不让?

AI大佬怼怼怼不停的背后,暗藏流派玄机

在四年前的争论中,Marcus认为:“深度学习必须通过一些借鉴自经典符号系统的操作得到增强,也就是说需要充分利用经典人工智能技术(允许显式地表示层次结构和抽象规则)的混合模型,并将其同深度学习的优势相结合。”

事实上,符号学派的历史颇为悠久,如果说蒸汽机和发动机开启了第一次产业革命,内燃机和电动机发动了第二次产业革命。人工智能掀起的新一轮从模拟化到数字化的革命就是自符号学派开始的。从机器定理证明,到跳棋程序,再到LSP处理语言和通用问题S求解程序……继承了图灵测试的衣钵,符号学派最初认为人工智能的本质是对符号的逻辑运算——逻辑思维通过计算机中逻辑门的运算模拟出来,进而实现机械化的人类认知,形成人工智能。

在人工智能概念提出者McCarthy阐明其数理逻辑思维模式之后,Newell和Simon将他的观点进一步推演为“物理符号系统假说”,该假说进一步将数理逻辑的模式推导至物理模式也可能产生智能行为。和数理逻辑通过运算模拟不同,因为物理符号聚焦在人类思考的高级行为上,所以认为推理、规划、知识等都可以通过符号转化。

从符号学派的底层认知逻辑不难看出,Lecun为什么会认为Marcus是心理学家,所以大佬们的撕逼也是从认知的本体论出发的。既然断定通过人类思考的符号转化无法达成真正的人工智能,那又有哪路神仙可以点化呢?

时间回到1943年,神经科学家McCulloch和数学家Pitts合著论文《神经活动中内在思想的逻辑演算》,最早开启通过大脑神经元解释思维过程,并通过大量非线性并行处理器模拟人类神经元的实现方法。这一后来发展为连接学派的理论,从更为科学的人脑神经出发解释人类行为产生的动力机制。但理念诞生虽早,真正实现落地实践却是后话,这里只是埋下了伏笔。

上世纪60年代,随着机器翻译的宣告失败,符号学派在产业界逐渐式微。取而代之的是行为学派。这一派的早期代表人物是控制论创始人Wiener,在二战期间,他接受了一项与火力控制相关的研究工作。那时候他的研究主要基于如何让只有1/3000击中飞机概率的火炮提升精准度,在没有控制论概念的时代,机械思维的结果只能是无穷尽的提升零件的精度,思考维度大大限制了可达成的目标。

Wiener通过汽车的制动原理联想:我们在驾驶汽车的时候并不是瞄准一个方向就一头扎过去,那为什么发射出的炮弹不能通过微调一点点的到达指定目标呢?根据这样的想法,他和其他科学家一起设计了一系列的自动控制装置和系统,从而极大提高了火炮命中的精度。基于在二战中的尝试,控制论在1948年正式提出。

控制论的核心在于除了自身因素外,基于外界环境不断对各类输入信息进行反馈,从而达成系统控制的目的。这一理论的诞生,让我们现在所熟知的传感器开始应用,基于传感器的第一台智能机器人也在这个时候诞生。但因为感知性能过于简单,并没有开启AI的大规模应用。

到了80年代,神经网络开始登上AI的历史舞台,这时据早期通过处理器模拟人类神经元的设想已经过去了三十多年。而它得以重现江湖的重要原因在于,随着理论的不断完善,科学家们突然在某天发现神经网络居然具备自主的学习能力。

这一发现的标志性事件之一发生在1986年,美国心理学家Rumelhart和深度学习之父Hinton发展了由心理学家Werbos在十二年前提出的BP算法,发表一篇反向传播算法的论文。

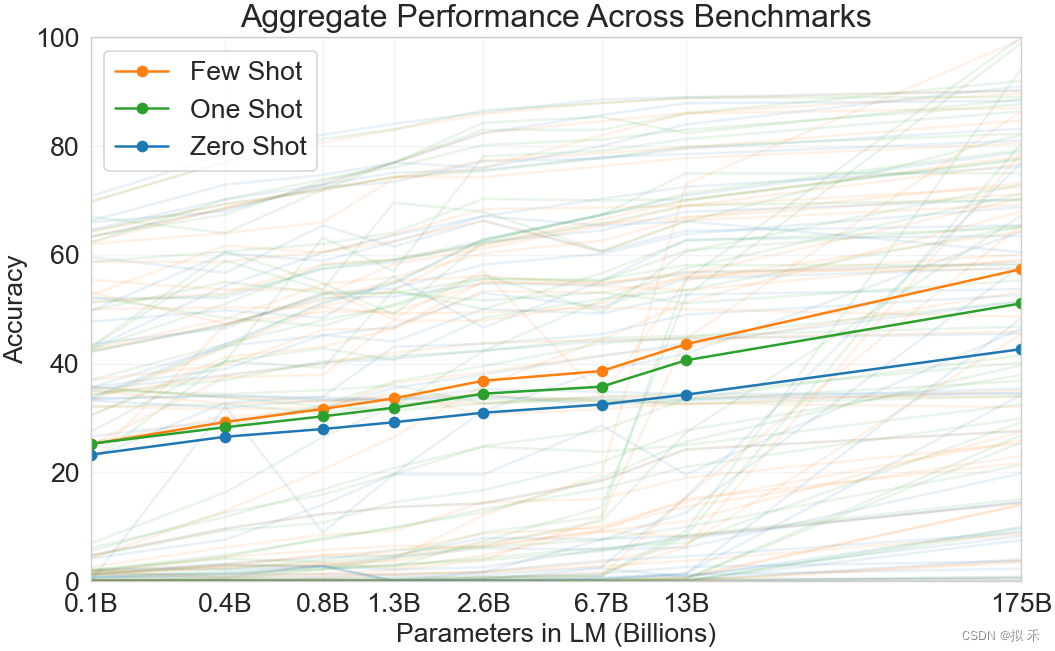

此后20年,Hinton将神经网络由一层改进为多层,深度学习进入实证。再后来,吴恩达通过机器学习训练识别猫,DeepMind的AlphaGo战胜世界围棋冠军,波士顿动力的Atlas和Spot……都是通过不断的深度学习实现视觉、认知、NLP和自主行动的一次次智能化突破。

而量子计算未来能够为人工智能带来多大能量,我们仍需拭目以待。

无论什么流派,本质还是对人的思考

不得不说,因为神经网络近二十年来在产业界所做出的杰出贡献,让这一领域的各路AI大佬大放异彩。但通过对人工智能各流派底层逻辑的梳理,我们或许不应该对哪个流派过度迷信,毕竟无论是符号、行为,还是连接学派,本质上都是对人的认知方式和行为方式,或基于器质,或基于意识的思考和实践。

最后,我们再来吃吃瓜。

其实吧,此次争论中被Lecun Cue到的递归神经网络之父Jürgen Schmidhuber也是AI界的怼怼红人了。上面我们提到Rumelhart和Hinton发展了BP算法这事,还有后续。2019年,Hinton因为在人工智能深度学习方法基础的反向传播算法上的贡献获得了本田奖。Schmidhuber便发文对究竟是谁原创反向传播提出了质疑,在他看来,“应该是Werbos在1982年明确提出了上述反向传播算法的首个面向神经网络的应用”。

与此同时,Schmidhuber还申诉:“他(Hinton)的深度前馈神经网络是我1991年类似工作的翻版;1993年我的方法已经能够解决先前一些无法解决的‘非常深度学习’任务。”

但Lecun显然是不认的,而且不仅现在说他是“插旗的”,还曾认为“Jürgen对众人的认可过于痴迷,总是说自己没有得到应得的很多东西。几乎是惯性地,总是在别人每次讲话结束时都要站起来,说刚刚提出的成果有他的功劳,大体上看,这种行为并不合理。”

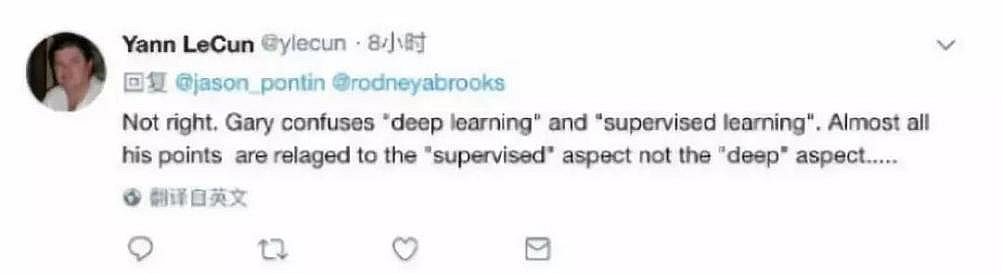

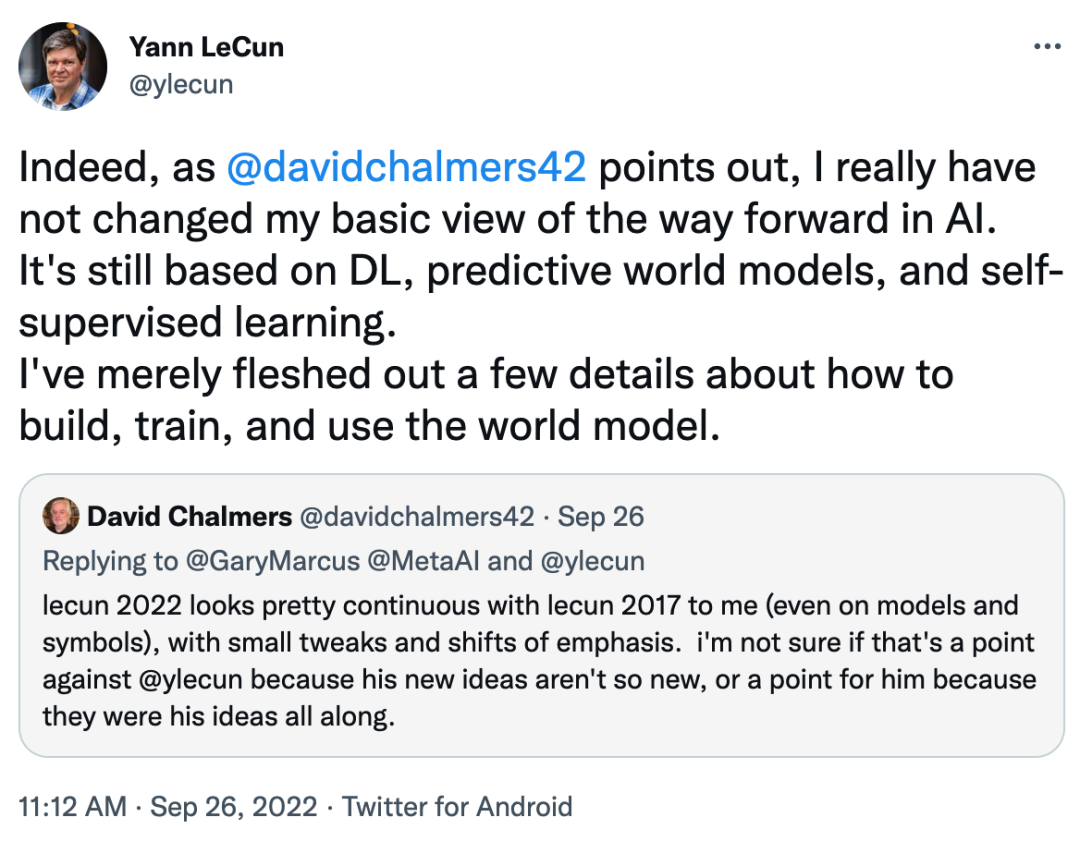

Lecun的最新回应:

“I really have not changed my basic view of the way forward in Al.

It's still based on DL, predictive world models, and self-supervised learning.”

“我真的没有改变对Al发展方向的基本看法。它仍然是基于DL(Deeplearning,深度学习),预测世界模型和自监督学习。”

实际上,无论是哪个时代,科学大佬们的撕扯都无处不在。遥想三百多年前,牛顿、胡克、莱布尼兹也因为引力、微积分的见解和知识产权归属问题争得不可开交,而科学也在他们的争论中不断拆解、重塑和进步。

所以,无论是四年前,还是四年后,大佬们的battle永远喋喋不休……

参考链接:

https://www.zdnet.com/article/metas-ai-guru-lecun-most-of-todays-ai-approaches-will-never-lead-to-true-intelligence/

https://garymarcus.substack.com/p/how-new-are-yann-lecuns-new-ideas?sd=pf

— 推荐阅读 —

☞1024 程序员节官方剧透:重磅大咖再聚,共话中国技术新生态

☞开源要正式写进法律了?

☞独家对话Python之父:人类大脑才是软件开发效率的天花板