点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

图机器学习、推荐系统与大语言模型的融合正成为新的前沿热点。图机器学习通过利用图结构数据,能够有效地捕捉和分析复杂关系和模式。同时,推荐系统正逐步成为我们日常生活的一部分,通过分析用户行为和偏好来提供个性化的内容推荐。当大语言模型与图机器学习、推荐系统结合时,它们能够提供更加深入、准确的洞察,从而在各种应用中提供更加丰富和个性化的用户体验,这为智能化技术的应用开拓了新的视角和可能性。

2023年12月26日,AI TIME “Global AI Lab”系列活动邀请了香港大学数据智能实验室,五位学者分享了他们在大模型领域的最新研究成果和深刻洞见。他们分别从不同的角度和领域出发,不仅涵盖了理论层面的深入探讨,也提出了实用的解决方案,为大模型的发展提供了重要见解和方法论。

01

黄超

Exploring the Power of Large Language Models (LLMs) for Graph Learning

黄超老师首先介绍了图学习的基本知识,图是描述和分析具有关系或交互的实体的通用语言,它专注于分析和处理图形结构的数据。图学习作为一种强大的数据分析工具,在多个领域中发挥着重要作用。在社交网络分析中,它帮助揭示用户间的关系和影响力模式;在推荐系统中,通过理解用户和物品间的复杂互动,能够提高推荐的准确性和个性化;在交通和物流领域,它也被用于优化路线规划和交通流量预测;在学术网络中,它可以帮助建模研究者与科研成果之间的连接关系;在生物信息学领域,图学习用于分析蛋白质网络和基因表达数据,促进新药发现和疾病机理研究;在知识图谱和自然语言处理中,它助力于构建更丰富、更准确的语义关系,推进智能问答和搜索系统的发展。

随后,黄老师分析了图学习面临的一些挑战和解决方案,比如,如何使模型在数据稀疏的条件下更好地学习到图的表征、让模型具有更好地泛化能力、弱化图结构中的“噪音”对模型的影响。黄老师指出,自监督学习为这些问题提供了一种有效的学习范式,它能够高效学习图的深层次表征,提升模型在未知数据上的泛化能力,并有效减弱噪音的影响。这种学习方式在处理未标注的大规模图数据时特别有价值,不仅提高了数据利用效率,还增加了模型的灵活性和适应性,甚至能够探索和揭示图中未知的结构和模式,为科学研究和实际应用提供新的洞察和知识。

最后,他还带领大家探索了大型语言模型(LLMs)在图学习领域的应用潜力,分析了大语言模型在理解和生成复杂语言结构方面的能力,展示了这些模型如何被应用于图学习,尤其是在提取和理解图结构数据中的语言信息方面的创新做法。

02

夏良昊

Towards Large Model for Graphs

夏良昊首先深入探讨了大型机器学习模型在处理图数据方面的独特优势和应用前景。他详细阐述了如何利用大模型处理复杂的图结构数据,特别是在社交网络分析、知识图谱构建以及推荐系统中的应用。随后,他为我们综述了大图模型的相关工作,包括Pretrained GNNs系列的GraphMAE、GraphPrompt,LLM for Graphs系列的GraphGPT、GraphLLM,LLM-enhanced GNNs系列的SimTeG、ENG,Graph Foundation Models系列的OFA、Ultra等。

他通过具体的案例工作,说明大图模型研究的挑战,比如在应用预训练的图神经网络(GNNs)处理图数据时,如何有效迁移和调整在大规模数据集上预训练的模型,以适应特定的图结构数据和任务。对于大型语言模型(LLM)在图数据中的应用,难点在于如何有效融合图结构的特性和语言模型的语义理解能力,特别是在处理图中复杂的节点和边关系时。在LLM增强的图神经网络中,挑战在于两种模型间的协同和优化,确保模型能够有效结合GNN的结构理解和LLM的语义处理能力,同时处理好模型的复杂性和计算效率问题。而引入Graph Foundation Models,这些挑战进一步扩展到如何构建一个通用、高效且可扩展的图模型框架,使得该框架能够适应各种类型的图数据和多样化的图任务。对于这些挑战,要求在模型架构、训练策略、数据表示和跨领域泛化能力上进行创新,以优化模型的性能和适应性。

03

杨雨豪

Large Languages Models for Sturctured Data in BioChem

大语言模型展现出强大的零样本和人类指令的跟随能力,吸引了众多研究者去探索,当结构化数据及图结构,与LLM相结合会产生怎样奇妙的化学反应?杨雨豪围绕该问题带领观众探索了如何利用LLM去处理复杂的生物化学中的图数据,包括分子的结构、蛋白质的序列和一些生物化学中的知识图谱等。

他首先分析了使用大语言模型来助力生物化学中图数据的原因,主要有三点:该领域药物的发现和预测是耗时耗力的,大语言模型可以加速该过程;整合LLM中知识库中的多样信息从而做出更加全面和准确的预测决策;利用LLM支持相关领域研究者的创新和合作从而促进更好的科学发现。其次他介绍了该领域目前取得的一些进展及LLM在分子任务等结构化数据上的应用,包括分子属性的预测、分子的结构描述、利用自然语言描述的分子生成、蛋白子的描述、蛋白质的反向折叠、蛋白质的性质预测等。最后,他也指出该领域面对的一些挑战和问题,如目前做分子结构数据化的工作并未自然地被嵌入到LLM中、目前关注生成的任务还处于初期,一些更具挑战性的任务还有待探索、迫切需要一个关注特定领域任务的基座模型等。

04

汤嘉斌

GraphGPT: Graph Instruction Tuning for Large Language Models

图神经网络 (GNN) 通过图节点之间的递归信息交换和聚合实现了先进的图结构理解。为了提高模型的鲁棒性,自监督学习 (SSL) 已成为数据增强的一种有前途的方法。然而,现有的生成预训练图嵌入的方法通常依赖于对特定下游任务标签进行微调,这限制了它们在标记数据稀缺或不可用的情况下的可用性。

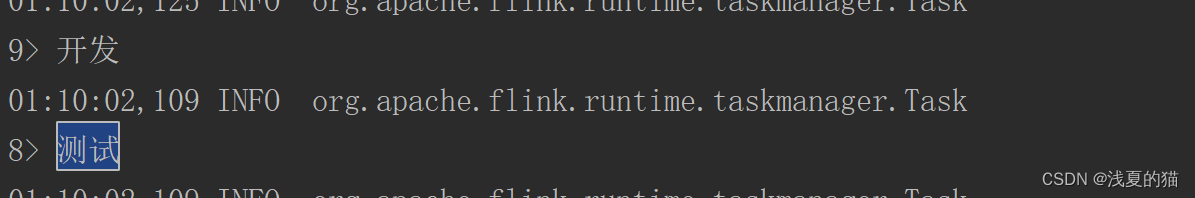

聚集上述问题,汤嘉斌对在具有挑战性的零样本学习场景中推进图模型的泛化能力进行研究。在报告中,他介绍了一种将 LLM 与图结构知识与图指令调整范式对齐的框架——GraphGPT。该框架通过利用一种简单而有效的图-文本对齐的方式,使得LLM能够理解和解释图的结构组件,加强了其在不同下游任务中的适应性,在不同的零样本图学习场景中验证了该框架的有效性与泛化性。

05

任旭滨

Enhancing Recommender Systems with Large Language Models

目前,学术界正在研究如何有效地将大语言模型的能力运用到图结构任务上,随着近年来图神经网络的发展,以及图网络在推荐系统领域的运用,图上的链路预测实际就等价于推荐系统的任务。任旭滨围绕该问题带领观众从两个方向(分别是基于LLM进行图数据增强以及图网络与LLM对齐)了解如何基于LLM来增强推荐系统的性能。

首先介绍的第一份工作是LLMRec(https://github.com/HKUDS/LLMRec)。在推荐算法所用到的传统图结构数据中,不但可能缺乏有效的节点特征数据,同时也会存在有噪音边。该算法首先引入了多模态的数据集来增强节点特征,并且利用LLM的文本理解能力通过推理用户商品的画像进行进一步的特征优化。此外,该算法通过利用LLM来对从图上采样的训练数据进行了增广,其基于语言模型的理解能力提供有效且高质量的训练数据以优化模型的训练。通过在真实世界多模态数据集上的实验以及消融实验,该工作有效地证明了其所提出的方法以及其中组件的有效性。

其次介绍的第二份工作是RLMRec(https://github.com/HKUDS/RLMRec)。该工作通过设计了一套高效且无偏的用户(商品)画像的生成策略,来对推荐图上的节点提供了丰富的文本描述,体现了其交互的偏好。而后利用互信息最大化的思想,从理论上有效地将协同过滤的特征表示和文本描述的特征表示进行对齐。具体实践时,本文提出了对比式对齐和生成式对齐,通过在真实世界的数据集上进行验证,两种方法分别在不同的任务场景上体现出了优势,例如对比式对齐的方式更加适用于推荐性能的优化,生成式对齐的方式更加适用于对推荐算法的预训练,均有不错的性能。

提醒

点击“阅读原文”跳转到00:00:01

可以查看回放哦!

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1600多位海内外讲者,举办了逾600场活动,超700万人次观看。

我知道你

在看

哦

~

点击 阅读原文 查看回放!