听歌识曲,顾名思义,用设备“听”歌曲,然后它要告诉你这是首什么歌。而且十之八九它还得把这首歌给你播放出来。这样的功能在QQ音乐等应用上早就出现了。我们今天来自己动手做一个自己的听歌识曲

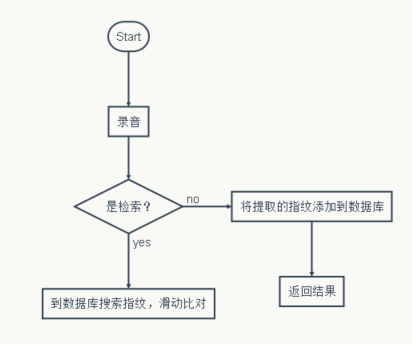

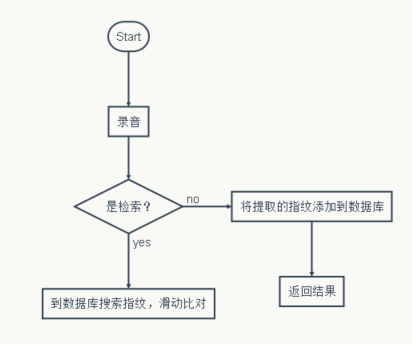

我们设计的总体流程图很简单:

-----

录音部分

-----

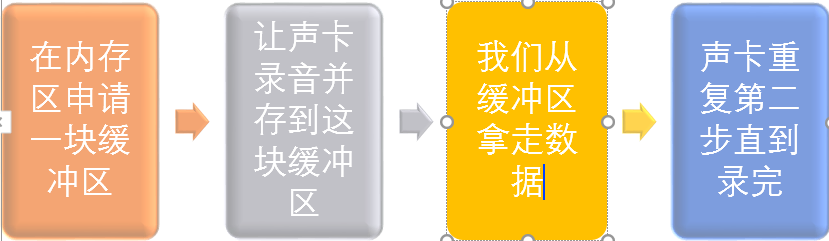

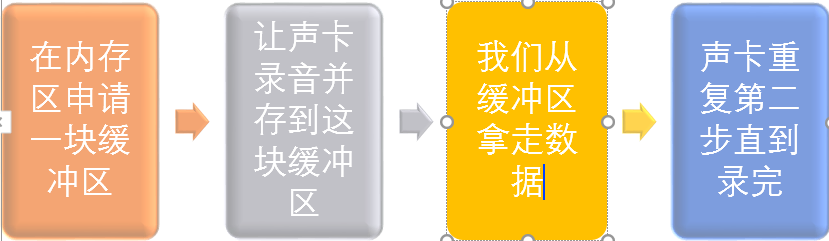

我们要想“听”,就必须先有录音的过程。在我们的实验中,我们的曲库也要用我们的录音代码来进行录音,然后提取特征存进数据库。我们用下面这样的思路来录音

?

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 | import wave import pyaudio class recode(): def recode( self , CHUNK = 44100 , FORMAT = pyaudio.paInt16, CHANNELS = 2 , RATE = 44100 , RECORD_SECONDS = 200 , WAVE_OUTPUT_FILENAME = "record.wav" ): p = pyaudio.PyAudio() stream = p. open ( format = FORMAT , channels = CHANNELS, rate = RATE, input = True , frames_per_buffer = CHUNK) frames = [] for i in range ( 0 , int (RATE / CHUNK * RECORD_SECONDS)): data = stream.read(CHUNK) frames.append(data) stream.stop_stream() stream.close() p.terminate() wf = wave. open (WAVE_OUTPUT_FILENAME, 'wb' ) wf.setnchannels(CHANNELS) wf.setsampwidth(p.get_sample_size( FORMAT )) wf.setframerate(RATE) wf.writeframes(''.join(frames)) wf.close() if __name__ = = '__main__' : a = recode() a.recode(RECORD_SECONDS = 30 , WAVE_OUTPUT_FILENAME = 'record_pianai.wav' ) |

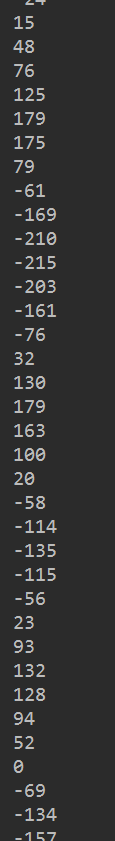

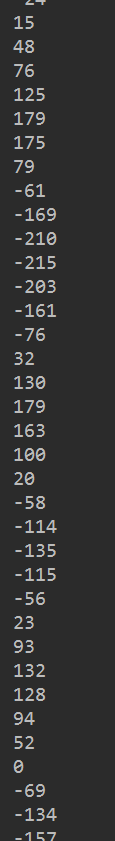

我们录完的歌曲是个什么形式?

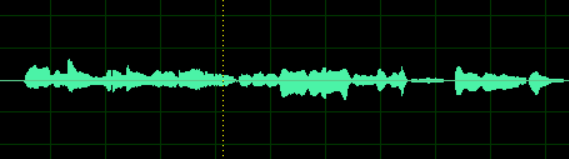

如果只看一个声道的话,他是一个一维数组,大概长成这个样子

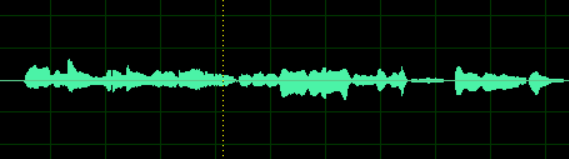

我们把他按照索引值为横轴画出来,就是我们常常看见的音频的形式。

音频处理部分

我们在这里要写我们的核心代码。关键的“如何识别歌曲”。想想我们人类如何区分歌曲? 是靠想上面那样的一维数组吗?是靠歌曲的响度吗?都不是。

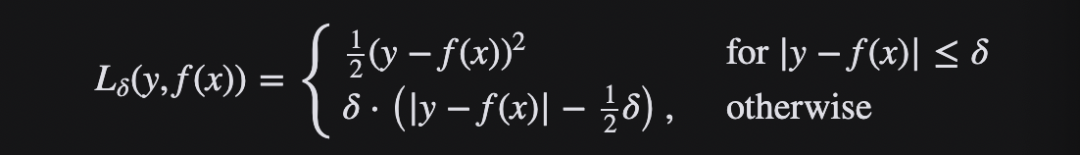

我们是通过耳朵所听到的特有的频率组成的序列来记忆歌曲的,所以我们想要写听歌识曲的话,就得在音频的频率序列上做文章。

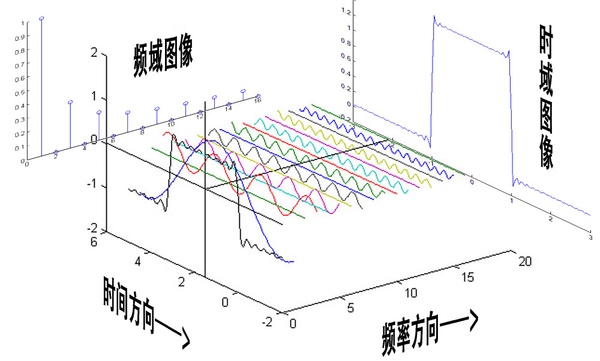

复习一下什么是傅里叶变换。博主的《信号与系统》的课上的挺水,不过在课上虽然没有记下来具体的变换形式,但是感性的理解还是有的。

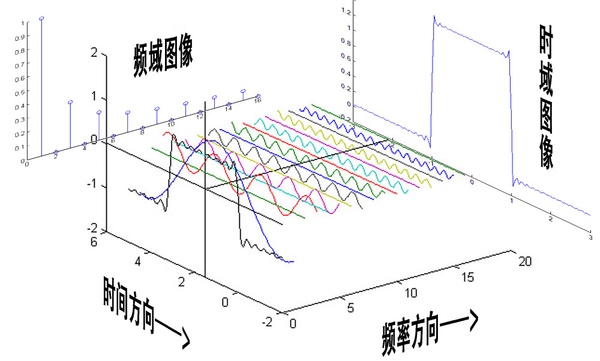

傅里叶变换的实质就是把时域信号变换成了频域信号。也就是原本X,Y轴分别是我们的数组下标和数组元素,现在变成了频率(这么说不准确,但在这里这样理解没错)和在这个频率上的分量大小。

怎么理解频域这个事情呢?对于我们信号处理不是很懂的人来说,最重要的就是改变对音频的构成的理解。我们原来认为音频就是如我们开始给出的波形那样,在每一个时间有一个幅值,不同的幅值序列构成了我们特定的声音。而现在,我们认为声音是不同的频率信号混合而成的,他们每一个信号都自始至终存在着。并且他们按照他们的投影分量做贡献。

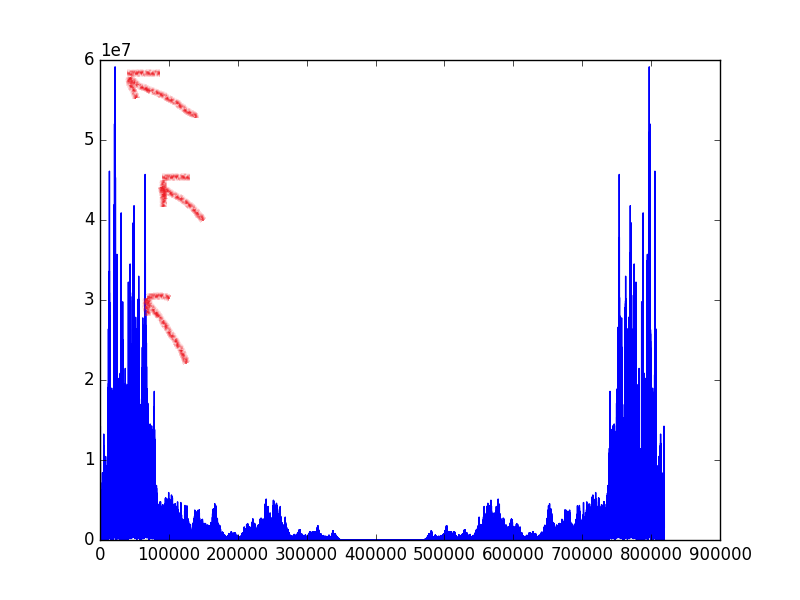

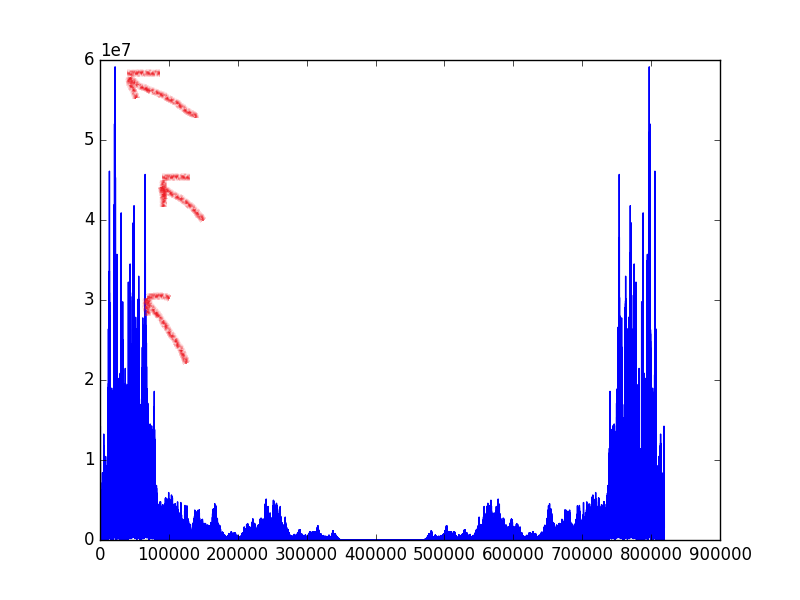

让我们看看把一首歌曲转化到频域是什么样子?

我们可以观察到这些频率的分量并不是平均的,差异是非常大的。我们可以在一定程度上认为在图中明显凸起的峰值是输出能量大的频率信号,代表着在这个音频中,这个信号占有很高的地位。于是我们就选择这样的信号来提取歌曲的特征。

但是别忘了,我们之前说的可是频率序列,傅里叶变换一套上,我们就只能知道整首歌曲的频率信息,那么我们就损失了时间的关系,我们说的“序列”也就无从谈起。所以我们采用的比较折中的方法,将音频按照时间分成一个个小块,在这里我每秒分出了40个块。

在这里留个问题:为什么要采用小块,而不是每秒一块这样的大块?

我们对每一个块进行傅里叶变换,然后对其求模,得到一个个数组。我们在下标值为(0,40),(40,80),(80,120),(120,180)这四个区间分别取其模长最大的下标,合成一个四元组,这就是我们最核心的音频“指纹”。

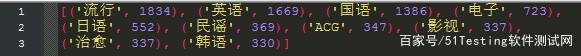

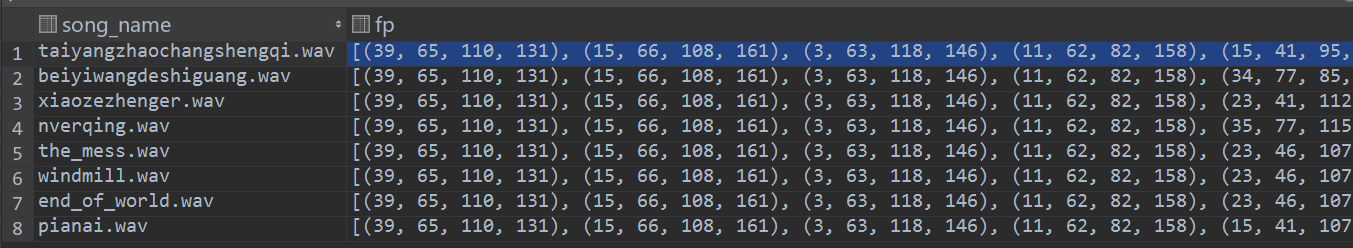

我们提取出来的“指纹”类似下面这样

(39, 65, 110, 131), (15, 66, 108, 161), (3, 63, 118, 146), (11, 62, 82, 158), (15, 41, 95, 140), (2, 71, 106, 143), (15, 44, 80, 133), (36, 43, 80, 135), (22, 58, 80, 120), (29, 52, 89, 126), (15, 59, 89, 126), (37, 59, 89, 126), (37, 59, 89, 126), (37, 67, 119, 126)

音频处理的类有三个方法:载入数据,傅里叶变换,播放音乐。

如下:

?

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 | import os import re import wave import numpy as np import pyaudio class voice(): def loaddata( self , filepath): if type (filepath) ! = str : print 'the type of filepath must be string' return False p1 = re. compile ( '\.wav' ) if p1.findall(filepath) is None : print 'the suffix of file must be .wav' return False try : f = wave. open (filepath, 'rb' ) params = f.getparams() self .nchannels, self .sampwidth, self .framerate, self .nframes = params[: 4 ] str_data = f.readframes( self .nframes) self .wave_data = np.fromstring(str_data, dtype = np.short) self .wave_data.shape = - 1 , self .sampwidth self .wave_data = self .wave_data.T f.close() self .name = os.path.basename(filepath) return True except : print 'File Error!' def fft( self , frames = 40 ): block = [] fft_blocks = [] self .high_point = [] blocks_size = self .framerate / frames blocks_num = self .nframes / blocks_size for i in xrange ( 0 , len ( self .wave_data[ 0 ]) - blocks_size, blocks_size): block.append( self .wave_data[ 0 ][i:i + blocks_size]) fft_blocks.append(np. abs (np.fft.fft( self .wave_data[ 0 ][i:i + blocks_size]))) self .high_point.append((np.argmax(fft_blocks[ - 1 ][: 40 ]), np.argmax(fft_blocks[ - 1 ][ 40 : 80 ]) + 40 , np.argmax(fft_blocks[ - 1 ][ 80 : 120 ]) + 80 , np.argmax(fft_blocks[ - 1 ][ 120 : 180 ]) + 120 , )) def play( self , filepath): chunk = 1024 wf = wave. open (filepath, 'rb' ) p = pyaudio.PyAudio() stream = p. open ( format = p.get_format_from_width(wf.getsampwidth()), channels = wf.getnchannels(), rate = wf.getframerate(), output = True ) while True : data = wf.readframes(chunk) if data = = "": break stream.write(data) stream.close() p.terminate() if __name__ = = '__main__' : p = voice() p.loaddata( 'record_beiyiwang.wav' ) p.fft() |

这里面的self.high_point是未来应用的核心数据。列表类型,里面的元素都是上面所解释过的指纹的形式。

数据存储和检索部分

因为我们是事先做好了曲库来等待检索,所以必须要有相应的持久化方法。我采用的是直接用mysql数据库来存储我们的歌曲对应的指纹,这样有一个好处:省写代码的时间

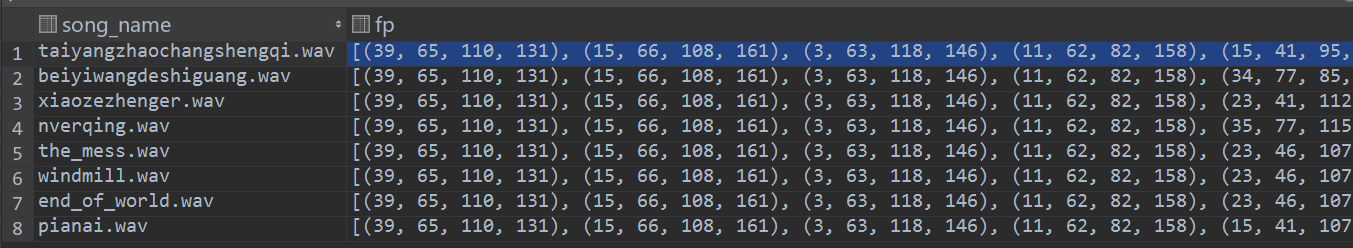

我们将指纹和歌曲存成这样的形式:

顺便一说:为什么各个歌曲前几个的指纹都一样?(当然,后面肯定是千差万别的)其实是音乐开始之前的时间段中没有什么能量较强的点,而由于我们44100的采样率比较高,就会导致开头会有很多重复,别担心。

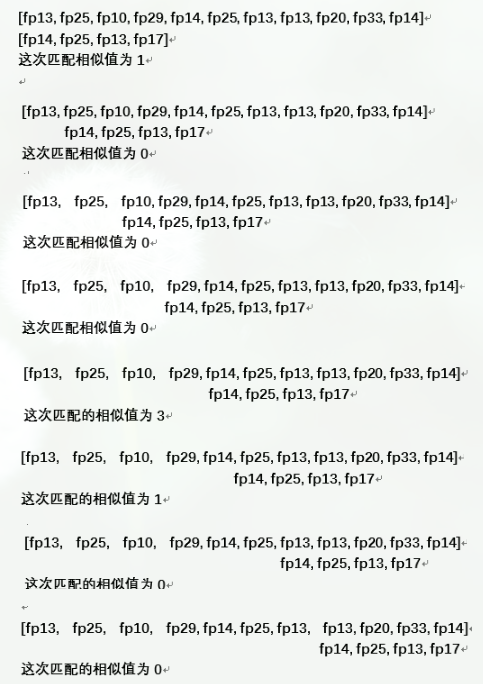

我们怎么来进行匹配呢?我们可以直接搜索音频指纹相同的数量,不过这样又损失了我们之前说的序列,我们必须要把时间序列用上。否则一首歌曲越长就越容易被匹配到,这种歌曲像野草一样疯狂的占据了所有搜索音频的结果排行榜中的第一名。而且从理论上说,音频所包含的信息就是在序列中体现,就像一句话是靠各个短语和词汇按照一定顺序才能表达出它自己的意思。单纯的看两个句子里的词汇重叠数是完全不能判定两句话是否相似的。我们采用的是下面的算法,不过我们这只是实验性的代码,算法设计的很简单,效率不高。建议想要做更好的结果的同学可以使用改进的DTW算法。

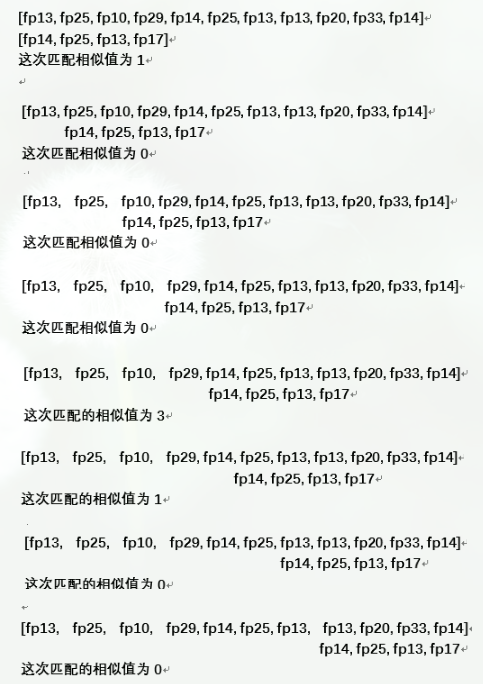

我们在匹配过程中滑动指纹序列,每次比对模式串和源串的对应子串,如果对应位置的指纹相同,则这次的比对相似值加一,我们把滑动过程中得到的最大相似值作为这两首歌的相似度。

举例:

曲库中的一首曲子的指纹序列:[fp13, fp20, fp10, fp29, fp14, fp25, fp13, fp13, fp20, fp33, fp14]

检索音乐的指纹序列: [fp14, fp25, fp13, fp17]

比对过程:

最终的匹配相似值为3

存储检索部分的实现代码

?

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 | import os import MySQLdb import my_audio class memory(): def __init__( self , host, port, user, passwd, db): self .host = host self .port = port self .user = user self .passwd = passwd self .db = db def addsong( self , path): if type (path) ! = str : print 'path need string' return None basename = os.path.basename(path) try : conn = MySQLdb.connect(host = self .host, port = self .port, user = self .user, passwd = self .passwd, db = self .db, charset = 'utf8' ) except : print 'DataBase error' return None cur = conn.cursor() namecount = cur.execute( "select * from fingerprint.musicdata WHERE song_name = '%s'" % basename) if namecount > 0 : print 'the song has been record!' return None v = my_audio.voice() v.loaddata(path) v.fft() cur.execute( "insert into fingerprint.musicdata VALUES('%s','%s')" % (basename, v.high_point.__str__())) conn.commit() cur.close() conn.close() def fp_compare( self , search_fp, match_fp): if len (search_fp) > len (match_fp): return 0 max_similar = 0 search_fp_len = len (search_fp) match_fp_len = len (match_fp) for i in range (match_fp_len - search_fp_len): temp = 0 for j in range (search_fp_len): if match_fp[i + j] = = search_fp[j]: temp + = 1 if temp > max_similar: max_similar = temp return max_similar def search( self , path): v = my_audio.voice() v.loaddata(path) v.fft() try : conn = MySQLdb.connect(host = self .host, port = self .port, user = self .user, passwd = self .passwd, db = self .db, charset = 'utf8' ) except : print 'DataBase error' return None cur = conn.cursor() cur.execute( "SELECT * FROM fingerprint.musicdata" ) result = cur.fetchall() compare_res = [] for i in result: compare_res.append(( self .fp_compare(v.high_point[: - 1 ], eval (i[ 1 ])), i[ 0 ])) compare_res.sort(reverse = True ) cur.close() conn.close() print compare_res return compare_res def search_and_play( self , path): v = my_audio.voice() v.loaddata(path) v.fft() try : conn = MySQLdb.connect(host = self .host, port = self .port, user = self .user, passwd = self .passwd, db = self .db, charset = 'utf8' ) except : print 'DataBase error' return None cur = conn.cursor() cur.execute( "SELECT * FROM fingerprint.musicdata" ) result = cur.fetchall() compare_res = [] for i in result: compare_res.append(( self .fp_compare(v.high_point[: - 1 ], eval (i[ 1 ])), i[ 0 ])) compare_res.sort(reverse = True ) cur.close() conn.close() print compare_res v.play(compare_res[ 0 ][ 1 ]) return compare_res if __name__ = = '__main__' : sss = memory( 'localhost' , 3306 , 'root' , 'root' , 'fingerprint' ) sss.addsong( 'taiyangzhaochangshengqi.wav' ) sss.addsong( 'beiyiwangdeshiguang.wav' ) sss.addsong( 'xiaozezhenger.wav' ) sss.addsong( 'nverqing.wav' ) sss.addsong( 'the_mess.wav' ) sss.addsong( 'windmill.wav' ) sss.addsong( 'end_of_world.wav' ) sss.addsong( 'pianai.wav' ) sss.search_and_play( 'record_beiyiwang.wav' ) |

总结

我们这个实验很多地方都很粗糙,核心的算法是从shazam公司提出的算法吸取的“指纹”的思想。希望读者可以提出宝贵建议。

本文转载于:http://www.cnblogs.com/chuxiuhong/p/6063602.html

From: http://www.jb51.net/article/97305.htm