槽位对齐(slot alignment)

在text2sql任务中,槽位对齐(slot alignment)通常指的是将自然语言问题中的关键信息(槽位)与数据库中的列名或API调用中的参数进行匹配的过程。这个过程中,模型需要理解问题中的词汇,并将其映射到数据库或API的相应部分。

在多模态的text2sql任务中,比如涉及到图表类型选择、API参数对齐的任务,槽位对齐可能还需要考虑如何将文本信息与图表数据、API调用所需的参数进行有效对齐。这意味着模型不仅要理解自然语言,还要能够处理和理解图表中的信息,以及如何将它们转换为正确的查询或API调用。

例如,如果用户提出了一个关于特定数据集的问题,模型需要识别出相关的槽位(如时间范围、产品类别等),然后根据这些槽位选择合适的图表类型,并确保API调用的参数与这些槽位正确对应。

OOD

在机器学习和数据科学领域,"OOD"代表"Out-of-Distribution",即分布外。分布外(Out-of-Distribution, OOD)情况指的是模型在处理那些不属于其训练数据分布的数据时所面临的问题。简单来说,就是模型遇到了它在训练过程中没有见过的新情况或数据。

在Task Classification任务中,如果考虑了OOD情况,模型就需要能够识别出那些不属于预定义分类的任务,并可能需要采取某种策略来处理这些未知或未预见的情况。例如,如果一个模型被训练来识别适合用柱状图、折线图、饼图、散点图和地图展示的五种任务类型,那么任何不适用于这五种图表类型的任务都会被视为OOD。

在实际情况中,OOD检测对于确保模型的鲁棒性和可靠性非常重要,因为它帮助模型识别并妥善处理未知或异常数据,而不是错误地分类或处理。这对于自动化系统尤其重要,因为错误地处理OOD情况可能会导致不准确的决策或意外的行为。

“TPM"问题

在数据可视化模块中,"TPM"问题通常指的是"Too Powerful Models"(过于强大的模型)问题。这个概念是指在使用大型语言模型(Large Language Models, LLMs)进行数据分析和可视化时,可能会出现的以下两个主要问题:

- 过度拟合:大型语言模型具有很高的参数量和容量,能够捕捉到数据中的复杂模式和关系。然而,这可能导致模型在训练数据上过度拟合,即模型不仅学习了数据中的真实模式,还学习到了训练数据中的噪声和特定特征。当模型应用于新的或未见过的数据时,过度拟合的模型可能无法很好地泛化,导致不准确或误导性的可视化结果。

- 缺乏可解释性:大型语言模型通常被视为"黑箱"模型,因为它们的内部决策过程和特征提取机制很难解释和理解。这导致很难解释为什么模型会生成特定的可视化结果,以及这些结果是否可靠和可信。缺乏可解释性可能会阻碍用户对模型输出结果的信任和采用。

因此,在使用大型语言模型进行数据可视化时,需要谨慎处理TPM问题,确保模型能够泛化和提供可解释的结果。这可能涉及到适当的模型正则化、验证和测试,以及开发可解释性工具和技术来解释模型的决策过程。

消融实验(Ablation Study)

消融实验(Ablation Study)是一种实验设计方法,用于评估模型或系统中各个组成部分的重要性。在消融实验中,研究者会逐步移除或“消融”模型的一部分组件或功能,然后评估这些变化对模型性能的影响。通过比较不同版本的模型性能,研究者可以确定哪些组件或功能对于模型的表现至关重要,哪些则不那么重要。

消融实验可以是通过对prompt中的问题表示进行修改,比如去掉外键信息,然后观察模型性能的变化。例如,如果原始问题包含关于数据库中表之间关系的信息(外键信息),那么在消融实验中,研究者可能会移除这些关系信息,然后评估模型在执行text2sql任务时的性能。

通过这种实验,研究者可以了解外键信息对模型性能的影响,从而得出结论,外键信息对于生成准确的SQL查询是否重要。如果去掉外键信息后模型性能显著下降,那么可以认为这些信息对于任务来说是关键因素。反之,如果性能下降不明显,则可能表明模型对其他信息更为依赖。

消融实验是理解复杂模型和系统中各个部分作用的一种有效方法,它有助于提高模型的可解释性,并指导模型改进和优化。

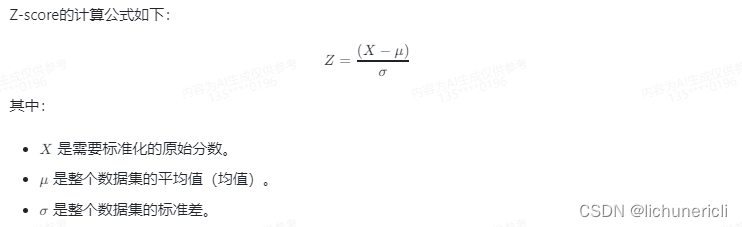

Z-score算法

Z-score算法,也称为标准分数(standard score)算法,是一种统计学上的方法,用于描述一个数值相对于整个数据集的平均值的位置。Z-score衡量的是原始分数和平均值之间的标准差的倍数。

通过计算Z-score,我们可以了解一个数值相对于整个数据集是处于高于平均值还是低于平均值,以及相差了多少个标准差。Z-score的一个重要作用是将不同分布的数据转换为标准正态分布(均值为0,标准差为1的分布),这样便于比较和统计分析。

例如,如果一个学生的某门课程的Z-score是2,那么这意味着该学生的分数比平均值高出2个标准差。Z-score也可以是负数,表示分数低于平均值。Z-score的绝对值越大,表示该分数在数据集中的位置越偏离平均值。

涌现能力

大模型的涌现能力通常指的是在训练过程中,随着模型参数的增加,模型会逐渐展现出一些之前不具备的能力。这些能力可能是在模型训练初期无法预测的,但随着模型规模的扩大和训练数据的增加,这些能力逐渐显现出来。

在深度学习领域,涌现能力是一个重要的研究方向,它涉及到模型设计、训练方法、数据集等多个方面。涌现能力的出现,一方面表明了深度学习模型的强大潜力,另一方面也给模型的解释性和可控性带来了挑战。

例如,在自然语言处理领域,随着模型规模的增加,模型在语言理解、文本生成等方面的能力得到了显著提升。这些能力在一定程度上超出了模型设计者最初的预期,体现了大模型的涌现能力。

UMAP 统一流形近似和投影

UMAP(Uniform Manifold Approximation and Projection)是一种非线性的降维技术,它可以将高维数据映射到低维空间,同时尽可能保持数据原有的几何结构。UMAP 以流形学习的理论为基础,通过构建数据的局部邻域图,并在低维空间中寻找这些邻域的均匀表示,从而实现数据的降维。与传统的线性降维方法(如主成分分析PCA)相比,UMAP 能更好地捕捉数据的非线性结构。

UMAP 降维技术的步骤大致如下:

- 构建邻接图:首先,UMAP 会计算数据点之间的距离,并找出每个点的近邻点,构建一个基于这些近邻关系的图。

- 估计局部连通性:接着,UMAP 会估计这个图上每条边的权重,这反映了点之间的局部连通性。

- 优化嵌入:然后,UMAP 通过优化过程寻找一个低维空间中的数据表示,以保持原始高维空间中的这些局部连通性。这一步通常涉及到寻找一个低维空间中的点集,使得这些点之间的距离最小化,同时保持原始邻接图上的边权重。

- 输出降维结果:最后,UMAP 输出低维空间中的数据坐标,这些坐标即为降维后的嵌入。在 Python 中,可以使用 `umap-learn` 库来实现 UMAP 降维。

import umap

from sklearn.datasets import load_digits# 加载数据集

digits = load_digits()

data = digits.data# 创建 UMAP 模型并拟合数据

umap_model = umap.UMAP(n_neighbors=5, min_dist=0.3, metric='correlation')

embedding = umap_model.fit_transform(data)# embedding 即为降维后的数据

print(embedding.shape) # 输出降维后的维度在这段代码中,`n_neighbors` 参数指定了每个点在构建邻接图时考虑的近邻点数量,`min_dist` 参数影响了降维后点之间的最小距离,`metric` 参数定义了用于计算点之间距离的度量标准。根据具体的数据集和需求,这些参数可能需要调整以获得最佳的降维效果。

Reciprocal Rank Fusion 互惠排名融合

"Reciprocal Rank Fusion",是一种用于结合多个排名列表的方法,通常用于信息检索、推荐系统或机器学习中的多任务学习场景。这种方法的基本思想是,如果两个排名列表中的元素在彼此的列表中都有较高的排名,那么这些元素应该是相关的。因此,这种方法通过考虑一个列表中的元素在另一个列表中的排名来提高排名的质量和准确性。

在多任务学习场景中,不同的模型可能会针对不同的任务生成排名列表。例如,一个模型可能会针对用户查询推荐新闻文章,而另一个模型可能会推荐相关的产品。Reciprocal Rank Fusion可以帮助提高这些模型的整体性能,因为它考虑了不同任务之间的相关性。

Reciprocal Rank Fusion这种方法的具体实现通常涉及以下步骤:

- 生成排名列表:首先,每个模型都会针对其任务生成一个排名列表。这些列表通常是由一组候选项(如文档、产品、用户等)根据它们的任务相关性进行排序的。

- 计算排名分数:对于列表中的每一对元素,计算它们在另一个列表中的排名。例如,如果有一个新闻推荐列表和一个产品推荐列表,那么对于列表中的每一篇新闻和每一个产品,计算这篇新闻在产品列表中的排名,以及这个产品在新闻列表中的排名。

- 融合排名分数:将计算出的排名分数结合起来,以生成一个新的排名列表。这个过程可能涉及加权平均、取最大值或其他融合技术。

- 优化:最后,可能需要对融合后的排名列表进行优化,以确保它们更好地满足所有相关任务的需求。

Reciprocal Rank Fusion是一种强大的方法,因为它可以利用不同模型之间的相关性,从而提高整体性能。然而,它的实现可能需要仔细考虑如何计算排名分数,以及如何融合这些分数,以生成高质量的排名列表。

IR 信息检索

IR 是(Information Retrieval)的缩写,它是一门研究如何高效地存储、组织、搜索和提取信息的学科。在设计和实现一个 IR 系统时,需要考虑以下几个关键的组成部分:

- 数据采集:首先需要收集和组织相关的数据。这些数据可以是从各种来源获取的,如文本、图像、音频和视频等。

- 数据处理:对采集到的数据进行预处理,包括清洗、去重、分词、词干提取、词形还原等步骤,以便更好地组织和管理数据。

- 索引构建:将处理后的数据构建成索引,以便快速检索。索引是一种数据结构,它将文档映射到与之相关的关键词上。

- 查询处理:接收用户的查询请求,并对其进行解析和处理,以便有效地从索引中检索相关信息。

- 排名和排序:根据相关性对检索到的结果进行排名和排序,以便用户能够快速找到最相关的信息。

- 用户交互:提供用户界面,使用户能够提交查询、浏览和检索结果。

- 性能评估:使用各种评估指标(如准确率、召回率、F1 分数等)来评估 IR 系统的性能。

- 更新和维护:定期更新索引和数据,以保持 IR 系统的准确性和可靠性。

设计一个高效的 IR 系统需要综合考虑这些组成部分,并选择合适的算法和技术来实现它们。此外,还需要考虑用户的需求和行为,以确保 IR 系统能够提供有价值和相关的检索结果。

PCA 主成分分析

PCA 是(Principal Component Analysis)的缩写,它是一种统计方法,用于通过正交变换将一组可能相关的变量转换为一组线性不相关的变量,这组变量称为主成分。PCA的目标是找出数据中的主要趋势和模式,以便可以简化数据集,同时尽可能保留原始数据中的信息。

PCA的主要步骤如下:

- 数据标准化:首先对数据进行标准化处理,以确保每个变量具有相同的尺度。

- 计算协方差矩阵:计算标准化数据集的协方差矩阵,以了解不同变量之间的关系。

- 计算特征值和特征向量:对协方差矩阵进行特征分解,找出最大的特征值和对应的特征向量。这些特征值和特征向量代表了数据中的主要方向,即主成分。

- 选择主成分:根据特征值的大小,选择最重要的几个主成分。这些主成分能够解释数据中的大部分方差。

- 重构数据:使用选定的主成分重构数据,得到简化后的数据集。

PCA广泛应用于数据降维、特征提取和数据可视化等领域。通过PCA,可以去除数据中的噪声,识别出最重要的变量,从而简化模型和提高预测性能。然而,PCA也有一些局限性,例如它不考虑变量之间的非线性关系,且在处理类别数据时需要特别的处理。

t-SNE t-分布随机邻域嵌入

t-SNE(t-Distributed Stochastic Neighbor Embedding)是一种非线性降维技术,由Laurens van der Maaten和Geoffrey Hinton于2008年提出。t-SNE旨在将高维数据投影到低维空间,同时保持数据点在低维空间中的相似性结构,类似于它们在高维空间中的分布。

t-SNE的工作原理如下:

- 相似性度量:t-SNE使用高维空间中的相似性度量(如欧氏距离)来评估数据点之间的相似性。

- 概率分布:t-SNE将高维空间中的每个数据点映射到低维空间中的一个点,并且认为这个低维点周围的点在某种程度上保留了高维空间中该点的邻居分布。为了实现这一点,t-SNE首先为每个高维数据点构建一个概率分布,表示该点与其邻居点之间的关系。

- 目标分布:然后,t-SNE为低维空间中的每个点也构建一个概率分布,这个分布反映了低维空间中点与点之间的相似性。t-SNE的目标是使这两个概率分布尽可能相似。

- 梯度下降:为了达到这个目标,t-SNE使用梯度下降方法来调整低维空间中点的坐标,以便更好地反映高维空间中的相似性结构。

t-SNE的一个关键特点是它使用了t-分布来模拟高维空间中的相似性分布,这使得它能够在非线性空间中捕捉到数据的局部结构。t-SNE通常用于可视化高维数据,但它也可以用于数据挖掘和机器学习中的特征提取。

t-SNE的一个主要缺点是计算成本较高,因为它需要计算和优化大量的概率分布和梯度。此外,t-SNE的结果可能对初始化敏感,且不保证找到全局最优解。尽管如此,t-SNE仍然是数据可视化和理解高维数据结构的一个非常有用的工具。

一、基础篇

1. 目前主流的开源模型体系有哪些?

- Transformer体系:由Google提出的Transformer模型及其变体,如BERT、GPT等。

- PyTorch Lightning:一个基于PyTorch的轻量级深度学习框架,用于快速原型设计和实验。

- TensorFlow Model Garden:TensorFlow官方提供的一系列预训练模型和模型架构。

- Hugging Face Transformers:一个流行的开源库,提供了大量预训练模型和工具,用于NLP任务。

2. prefix LM 和 causal LM 区别是什么?

- prefix LM(前缀语言模型):在输入序列的开头添加一个可学习的任务相关的前缀,然后使用这个前缀和输入序列一起生成输出。这种方法可以引导模型生成适应特定任务的输出。

- causal LM(因果语言模型):也称为自回归语言模型,它根据之前生成的 token 预测下一个 token。在生成文本时,模型只能根据已经生成的部分生成后续部分,不能访问未来的信息。

3. 涌现能力是啥原因?

涌现能力(Emergent Ability)是指模型在训练过程中突然表现出的新的、之前未曾预料到的能力。这种现象通常发生在大型模型中,原因是大型模型具有更高的表示能力和更多的参数,可以更好地捕捉数据中的模式和关联。随着模型规模的增加,它们能够自动学习到更复杂、更抽象的概念和规律,从而展现出涌现能力。

4. 大模型LLM的架构介绍?

大模型LLM(Large Language Models)通常采用基于Transformer的架构。Transformer模型由多个编码器或解码器层组成,每个层包含多头自注意力机制和前馈神经网络。这些层可以并行处理输入序列中的所有位置,捕获长距离依赖关系。大模型通常具有数十亿甚至数千亿个参数,可以处理大量的文本数据,并在各种NLP任务中表现出色。

前馈神经网络(Feedforward Neural Network)是一种最基础的神经网络类型,它的信息流动是单向的,从输入层经过一个或多个隐藏层,最终到达输出层。在前馈神经网络中,神经元之间的连接不会形成闭环,这意味着信号在前向传播过程中不会回溯。

前馈神经网络的基本组成单元是神经元,每个神经元都会对输入信号进行加权求和,然后通过一个激活函数产生输出。激活函数通常是非线性的,它决定了神经元的输出是否应该被激活,从而允许网络学习复杂和非线性的函数。

前馈神经网络在模式识别、函数逼近、分类、回归等多个领域都有应用。例如,在图像识别任务中,网络的输入层节点可能对应于图像的像素值,而输出层节点可能代表不同类别的概率分布。

训练前馈神经网络通常涉及反向传播(Backpropagation)算法,这是一种有效的学习算法,通过计算输出层的误差,并将这些误差信号沿网络反向传播,以调整连接权重。通过多次迭代这个过程,网络可以逐渐学习如何减少输出误差,从而实现对输入数据的正确分类或回归。

在设计和训练前馈神经网络时,需要考虑多个因素,包括网络的层数、每层的神经元数目、激活函数的选择、学习速率、正则化策略等,这些都对网络的性能有重要影响。

5. 你比较关注哪些主流的开源大模型?

- GPT系列:由OpenAI开发的生成式预训练模型,如GPT-3。

- BERT系列:由Google开发的转换式预训练模型,如BERT、RoBERTa等。

- T5系列:由Google开发的基于Transformer的编码器-解码器模型,如T5、mT5等。

6. 目前大模型模型结构都有哪些?

- Transformer:基于自注意力机制的模型,包括编码器、解码器和编码器-解码器结构。

- GPT系列:基于自注意力机制的生成式预训练模型,采用解码器结构。

- BERT系列:基于自注意力机制的转换式预训练模型,采用编码器结构。

- T5系列:基于Transformer的编码器-解码器模型。

7. prefix LM 和 causal LM、encoder-decoder 区别及各自有什么优缺点?

- prefix LM:通过在输入序列前添加可学习的任务相关前缀,引导模型生成适应特定任务的输出。优点是可以减少对预训练模型参数的修改,降低过拟合风险;缺点是可能受到前缀表示长度的限制,无法充分捕捉任务相关的信息。

- causal LM:根据之前生成的 token 预测下一个 token,可以生成连贯的文本。优点是可以生成灵活的文本,适应各种生成任务;缺点是无法访问未来的信息,可能生成不一致或有误的内容。

- encoder-decoder:由编码器和解码器组成,编码器将输入序列编码为固定长度的向量,解码器根据编码器的输出生成输出序列。优点是可以处理输入和输出序列不同长度的任务,如机器翻译;缺点是模型结构较为复杂,训练和推理计算量较大。

8. 模型幻觉是什么?业内解决方案是什么?

模型幻觉是指模型在生成文本时产生的不准确、无关或虚构的信息。这通常发生在模型在缺乏足够信息的情况下进行推理或生成时。业内的解决方案包括:

- 使用更多的数据和更高质量的训练数据来提高模型的泛化和准确性。

- 引入外部知识源,如知识库或事实检查工具,以提供额外的信息和支持。

- 强化模型的推理能力和逻辑推理,使其能够更好地处理复杂问题和避免幻觉。

9. 大模型的Tokenizer的实现方法及原理?

大模型的Tokenizer通常使用字节对编码(Byte-Pair Encoding,BPE)算法。BPE算法通过迭代地将最频繁出现的字节对合并成新的符号,来构建一个词汇表。在训练过程中,模型会学习这些符号的嵌入表示。Tokenizer将输入文本分割成符号序列,然后将其转换为模型可以处理的数字表示。这种方法可以有效地处理大量文本数据,并减少词汇表的规模。

10. ChatGLM3 的词表实现方法?

ChatGLM3使用了一种改进的词表实现方法。它首先使用字节对编码(BPE)算法构建一个基本的词表,然后在训练过程中通过不断更新词表来引入新的词汇。具体来说,ChatGLM3在训练过程中会根据输入数据动态地合并出现频率较高的字节对,从而形成新的词汇。这样可以有效地处理大量文本数据,并减少词汇表的规模。同时,ChatGLM3还使用了一种特殊的词表分割方法,将词表分为多个片段,并在训练过程中逐步更新这些片段,以提高模型的泛化能力和适应性。

11. GPT3、LLAMA、ChatGLM 的Layer Normalization 的区别是什么?各自的优缺点是什么?

- GPT3:采用了Post-Layer Normalization(后标准化)的结构,即先进行自注意力或前馈神经网络的计算,然后进行Layer Normalization。这种结构有助于稳定训练过程,提高模型性能。

- LLAMA:采用了Pre-Layer Normalization(前标准化)的结构,即先进行Layer Normalization,然后进行自注意力或前馈神经网络的计算。这种结构有助于提高模型的泛化能力和鲁棒性。

- ChatGLM:采用了Post-Layer Normalization的结构,类似于GPT3。这种结构可以提高模型的性能和稳定性。

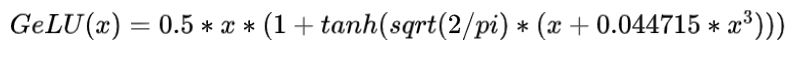

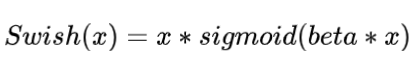

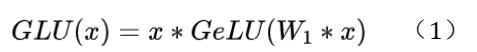

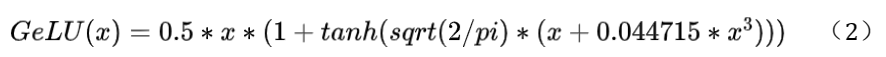

12. 大模型常用的激活函数有哪些?

- ReLU(Rectified Linear Unit):一种简单的激活函数,可以解决梯度消失问题,加快训练速度。

- GeLU(Gaussian Error Linear Unit):一种改进的ReLU函数,可以提供更好的性能和泛化能力。

- Swish:一种自门控激活函数,可以提供非线性变换,并具有平滑和非单调的特性。

13. Multi-query Attention 与 Grouped-query Attention 是否了解?区别是什么?

Multi-query Attention和Grouped-query Attention是两种不同的注意力机制变种,用于改进和扩展传统的自注意力机制。

- Multi-query Attention:在Multi-query Attention中,每个查询可以与多个键值对进行交互,从而捕捉更多的上下文信息。这种机制可以提高模型的表达能力和性能,特别是在处理长序列或复杂关系时。

- Grouped-query Attention:在Grouped-query Attention中,查询被分成多个组,每个组内的查询与对应的键值对进行交互。这种机制可以减少计算复杂度,提高效率,同时仍然保持较好的性能。

14. 多模态大模型是否有接触?落地案例?

多模态大模型是指可以处理和理解多种模态数据(如文本、图像、声音等)的模型。落地案例,例如:

- OpenAI的DALL-E和GPT-3:DALL-E是一个可以生成图像的模型,而GPT-3可以处理和理解文本。两者结合可以实现基于文本描述生成图像的功能。

- Google的Multimodal Transformer:这是一个可以同时处理文本和图像的模型,用于各种多模态任务,如图像字幕生成、视觉问答等。

二、大模型(LLMs)进阶

1. llama 输入句子长度理论上可以无限长吗?

LLaMA(Large Language Model Adaptation)模型的输入句子长度受到硬件资源和模型设计的限制。理论上,如果硬件资源足够,模型可以处理非常长的输入句子。然而,实际上,由于内存和处理能力的限制,输入句子长度通常是有限制的。在实际应用中,开发者会根据具体需求和硬件配置来确定合适的输入句子长度。

2. 什么是 LLMs 复读机问题?

LLMs 复读机问题是指在某些情况下,大型语言模型在生成文本时会重复之前已经生成的内容,导致生成的文本缺乏多样性和创造性。

3. 为什么会出现 LLMs 复读机问题?

LLMs 复读机问题可能由多种因素引起,包括模型训练数据中的重复模式、模型在处理长序列时的注意力机制失效、或者模型在生成文本时对过去信息的过度依赖等。

4. 如何缓解 LLMs 复读机问题?

- 数据增强:通过增加训练数据的多样性和复杂性,减少重复模式的出现。

- 模型改进:改进模型的结构和注意力机制,使其更好地处理长序列和避免过度依赖过去信息。

- 生成策略:在生成文本时采用多样化的策略,如抽样生成或引入随机性,以增加生成文本的多样性。

5. LLMs 复读机问题

6. llama 系列问题

7. 什么情况用Bert模型,什么情况用LLaMA、ChatGLM类大模型?

BERT 模型通常用于需要理解文本深层语义的任务,如文本分类、命名实体识别等。LLaMA 和 ChatGLM 类大模型则适用于需要生成文本或进行更复杂语言理解的任务,如对话系统、文本生成等。选择哪种模型取决于任务的需求和可用资源。

8. 各个专业领域是否需要各自的大模型来服务?

不同的专业领域需要特定的大模型来更好地服务。专业领域的大模型可以针对特定领域的语言和知识进行优化,提供更准确和相关的回答和生成文本。

9. 如何让大模型处理更长的文本?

- 使用模型架构,如Transformer,它可以有效地处理长序列。

- 使用内存机制,如外部记忆或缓存,来存储和检索长文本中的信息。

- 使用分块方法,将长文本分割成更小的部分,然后分别处理这些部分。

10. 大模型参数微调、训练、推理

11. 如果想要在某个模型基础上做全参数微调,究竟需要多少显存?

全参数微调(Full Fine-Tuning)通常需要大量的显存,因为这种方法涉及到更新模型的所有参数。显存的需求取决于模型的规模、批量大小、以及使用的硬件。例如,对于大型模型如GPT-3,可能需要多个GPU甚至TPU来分配显存,每个GPU或TPU可能需要几十GB的显存。在实际操作中,需要进行试错法来确定合适的批量大小和硬件配置。

12. 为什么SFT之后感觉LLM傻了?

指令微调(SFT,Supervised Fine-Tuning)之后感觉LLM“傻了”,可能是因为微调过程中出现了一些问题,例如过拟合、数据质量不佳、或者微调的强度不够。过拟合可能导致模型在训练数据上表现良好,但在未见过的数据上表现不佳。数据质量不佳可能导致模型学到了错误的模式或偏见。微调强度不够可能导致模型没有充分适应新的任务。

13. SFT 指令微调数据如何构建?

- 收集或生成与特定任务相关的指令和数据对,其中指令是描述任务或要求的文本,数据是对应的输入输出示例。

- 清洗和预处理数据,以确保数据的质量和一致性。

- 根据任务需求,对数据进行增强,如使用数据增强技术生成更多的训练样本。

- 将数据格式化为模型训练所需的格式,例如,对于语言模型,通常需要将文本转化为模型可以理解的数字编码。

14. 领域模型Continue PreTrain数据选取?

领域模型继续预训练(Continue Pre-Training)的数据选取应该基于领域内的文本特点和应用需求。通常,需要选取大量、高质量、多样化的领域文本数据。数据可以来自专业文献、行业报告、在线论坛、新闻文章等。数据选取时应该注意避免偏见和不平衡,确保数据能够全面地代表领域内的知识和语言使用。

15. 领域数据训练后,通用能力往往会有所下降,如何缓解模型遗忘通用能力?

- 多任务学习:在训练过程中同时包含领域内和通用的任务,使模型能够同时学习领域特定的和通用的知识。

- 控制微调强度:通过调整微调的学习率或训练轮数来控制模型对领域数据的适应程度。

- 定期回炉:在领域数据训练后,定期使用通用数据进行回炉训练,以保持模型的通用能力。

16. 领域模型Continue PreTrain ,如何让模型在预训练过程中就学习到更多的知识?

- 数据增强:使用数据增强技术如回译、掩码语言模型等来生成更多的训练样本。

- 知识注入:将领域特定的知识以文本、结构化数据或知识图谱的形式注入到预训练过程中。

- 多模态学习:如果适用,可以使用多模态数据(如文本和图像)进行预训练,以丰富模型的知识表示。

17. 进行SFT操作的时候,基座模型选用Chat还是Base?

在进行指令微调(SFT)操作时,选择基座模型(Chat或Base)取决于具体任务的需求和模型的性能。通常,如果任务需要生成对话或交互式响应,可以选择对话优化的模型(Chat)。如果任务更注重理解和生成文本的能力,可以选择基础模型(Base)。在实际应用中,可能需要根据实验结果和模型性能来选择最合适的基座模型。

18. 领域模型微调 指令&数据输入格式要求?

领域模型微调的指令和数据输入格式要求取决于所使用的模型和框架。一般来说,指令应该是清晰、具体的,能够指导模型完成特定的任务。数据输入格式通常需要与模型的输入接口相匹配,例如,对于文本模型,数据通常需要是字符串格式,并且可能需要经过特定的预处理,如分词、编码等。

19. 领域模型微调 领域评测集构建?

构建领域模型微调的领域评测集时,应该确保评测集能够全面、准确地反映领域内的任务需求和性能指标。通常,需要从领域内的真实数据中收集或生成评测样本,并确保样本的多样性和代表性。此外,可以根据任务需求设计定制的评价指标,以评估模型在领域内的性能。

20. 领域模型词表扩增是不是有必要的?

领域模型词表扩增通常是有必要的,尤其是当领域内有大量的专业术语或特定词汇时。词表扩增可以帮助模型更好地理解和生成领域内的文本,提高模型的领域适应性。然而,词表扩增也需要谨慎进行,以避免引入过多的噪音或不相关的词汇。

21. 如何训练自己的大模型?

- 选择合适的预训练目标和任务:确定模型将学习哪些通用的语言知识,以及针对哪些特定任务进行优化。

- 收集和准备数据:收集大量、多样化的数据,包括通用数据和特定领域的数据,进行清洗和预处理。

- 选择模型架构:选择一个适合的模型架构,如Transformer,并确定模型的规模和层数。

- 定义训练流程:设置训练参数,如学习率、批量大小、训练轮数等,并选择合适的优化器和损失函数。

- 训练模型:使用准备好的数据和训练流程开始训练模型,监控训练过程中的性能和资源使用。

- 评估和调优:在训练过程中定期评估模型的性能,并根据需要调整训练参数和模型架构。

- 微调和优化:在模型达到一定的性能后,进行微调以适应特定的应用场景和任务需求。

22. 训练中文大模型有啥经验?

- 使用大量高质量的中文数据,包括文本、对话、新闻、社交媒体帖子等。

- 考虑语言的特点,如词序、语法结构、多义性等,并设计相应的预训练任务。

- 使用适合中文的语言模型架构,如BERT或GPT,并进行适当的调整以优化性能。

- 考虑中文的特殊字符和标点,确保模型能够正确处理这些字符。

- 进行多任务学习,同时训练多个相关任务,以提高模型的泛化能力。

23. 指令微调的好处?

- 提高模型在特定任务上的性能,使其能够更好地理解和执行指令。

- 通过指令和示例数据的结合,使模型能够学习到更具体、更实用的知识。

- 减少了模型对大规模标注数据的依赖,通过少量的指令和示例数据就能进行有效的微调。

- 可以通过不同的指令和示例数据组合,快速适应不同的任务和应用场景。

24. 预训练和微调哪个阶段注入知识的?

在预训练阶段,模型通过大量的无监督数据学习通用的语言知识和模式。在微调阶段,模型通过与特定任务相关的监督数据学习特定领域的知识和任务特定的模式。因此,知识注入主要发生在微调阶段。

25. 想让模型学习某个领域或行业的知识,是应该预训练还是应该微调?

为了让模型学习某个领域或行业的知识,通常建议先进行预训练,以学习通用的语言知识和模式。预训练可以帮助模型建立强大的语言表示,并提高模型的泛化能力。然后,可以通过微调来注入特定领域或行业的知识,使模型能够更好地适应特定的任务和应用场景。

26. 多轮对话任务如何微调模型?

- 收集多轮对话数据,包括用户查询、系统回复、以及可能的中间交互。

- 对数据进行预处理,如分词、编码等,使其适合模型输入格式。

- 设计多轮对话的微调目标,如序列到序列学习、生成式对话等。

- 微调模型,使其能够生成连贯、自然的对话回复,并考虑到对话上下文和用户意图。

27. 微调后的模型出现能力劣化,灾难性遗忘是怎么回事?

微调后的模型出现能力劣化,灾难性遗忘可能是因为模型在微调过程中学习到了过多的特定任务的知识,而忽略了通用的语言知识。这可能导致模型在训练数据上表现良好,但在未见过的数据上表现不佳。为了解决这个问题,可以采取一些措施,如多任务学习、控制微调强度、定期使用通用数据进行回炉训练等。

28. 微调模型需要多大显存?

微调模型需要的显存取决于模型的规模、任务复杂度、数据量等因素。一般来说,微调模型需要的显存通常比预训练模型少,因为微调涉及到更新的参数较少。然而,具体需要的显存仍然需要根据实际情况进行评估和调整。

29. 大模型LLM进行SFT操作的时候在学习什么?

- 特定领域的语言模式和知识,包括专业术语、行业特定用语等。

- 针对特定任务的生成策略和响应模式。

- 对话上下文中的连贯性和逻辑性,对于多轮对话任务尤其重要。

- 指令理解和执行能力,使模型能够更准确地理解和执行用户的指令。

30. 预训练和SFT操作有什么不同?

预训练和SFT操作的主要区别在于目标和数据集。预训练通常是在大规模的无标签数据集上进行的,目的是让模型学习到通用的语言表示和模式。这个过程不需要人工标注数据,而是通过模型自己从数据中学习。SFT则是在有标签的数据集上进行的,目的是让模型适应特定的任务或领域。这个过程需要人工标注数据,以确保模型能够学习到正确的任务特定的模式和知识。

31. 样本量规模增大,训练出现OOM错,怎么解决?

当样本量规模增大时,训练出现OOM(Out of Memory)错误可能是由于显存不足导致的。为了解决这个问题,可以尝试以下方法:

- 增加训练设备的显存,如使用更高性能的GPU或增加GPU数量。

- 调整批量大小,减少每次训练时处理的样本数量。

- 使用模型并行或数据并行技术,将模型或数据分片到多个设备上进行训练。

- 使用动态批处理,根据可用显存动态调整批量大小。

32. 大模型LLM进行SFT 如何对样本进行优化?

- 数据增强:通过对原始数据进行转换,如文本回译、添加噪声等,生成更多的训练样本。

- 样本选择:选择与特定任务最相关的样本进行训练,以提高训练效率和性能。

- 样本权重:根据样本的难易程度或重要性为样本分配不同的权重,以优化训练过程。

- 平衡采样:在训练过程中,确保每个类别或子任务都有足够的样本被训练到。

33. 模型参数迭代实验步骤?

模型参数迭代实验是指在训练过程中,对模型的参数进行迭代调整和优化,以提高模型的性能。这通常涉及以下步骤:

- 选择一组初始参数。

- 在训练过程中,定期评估模型的性能。

- 根据评估结果,调整模型的参数,如学习率、批量大小、正则化参数等。

- 重复评估和调整参数,直到模型的性能达到预期的目标。

34. 为什么需要进行参选微调?参数微调的原因有哪些?

参数微调是指只对模型的一部分参数进行更新,以适应特定的任务或领域。进行参数微调的原因包括:

- 提高计算效率:参数微调通常比全量微调需要更少的计算资源,因为只有部分参数需要更新。

- 减少过拟合风险:只更新与特定任务相关的参数,可以减少模型对训练数据的过度依赖,降低过拟合的风险。

- 提高泛化能力:参数微调可以使模型在保持通用语言能力的同时,适应特定的任务需求。

35. 模型参数微调的方式有那些?你最常用哪些方法?

- 权重共享:在模型中,将部分参数设置为共享,这些参数同时用于多个任务或领域。

- 参数掩码:在模型中,将部分参数设置为不可训练,这些参数保持预训练时的值不变。

- 参数分解:将大型的参数矩阵分解为多个小型矩阵,只更新其中的部分矩阵。

- 参数共享微调:在模型中,将部分参数设置为共享,这些参数用于多个相关任务。

36. prompt tuning 和 prefix tuning 在微调上的区别是什么?

Prompt Tuning和Prefix Tuning都是参数高效的微调方法,它们通过在模型输入中添加特定的提示或前缀来引导模型生成适应特定任务的输出。区别在于:

- Prompt Tuning:在输入序列的末尾添加可学习的提示,提示可以是几个单词或短语,用于指导模型生成特定的输出。

- Prefix Tuning:在输入序列的开头添加可学习的连续前缀表示,前缀表示包含了任务特定的信息,用于引导模型生成适应特定任务的输出。

37. LLaMA-adapter 如何实现稳定训练?

LLaMA-adapter 是一种参数高效的微调方法,它通过在预训练模型的每个Transformer层中添加小型适配器模块来实现特定任务的适应。为了实现稳定训练,可以采取以下措施:

- 适配器初始化:使用预训练模型的参数作为适配器模块的初始化,以保持模型的稳定性。

- 适配器正则化:使用正则化技术,如权重衰减或dropout,来减少适配器模块的过拟合风险。

- 逐步学习:逐步调整适配器模块的参数,避免参数更新的幅度过大。

- 适配器优化:选择合适的优化器和训练策略,如使用较小的学习率、较长的训练周期等,以实现稳定的训练过程。

38. LoRA 原理与使用技巧有那些?

LoRA(Low-Rank Adaptation)是一种参数高效的微调方法,它通过引入低秩分解来减少需要更新的参数数量。LoRA的工作原理是将预训练模型的注意力矩阵或前馈网络矩阵分解为两个低秩矩阵的乘积,其中这两个低秩矩阵被视为可学习的任务特定参数。

使用LoRA的技巧包括:

- 适配器初始化:使用预训练模型的参数作为LoRA适配器模块的初始化,以保持模型的稳定性。

- 低秩分解:选择合适的低秩分解方法,如奇异值分解(SVD)或随机矩阵分解,以实现低秩分解。

- 逐步学习:逐步调整LoRA适配器模块的参数,避免参数更新的幅度过大。

- 适配器正则化:使用正则化技术,如权重衰减或dropout,来减少LoRA适配器模块的过拟合风险。

39. LoRA 微调优点是什么?

- 参数高效:LoRA只更新少量的低秩矩阵,相比全量微调,可以显著减少需要更新的参数数量。

- 计算效率:由于只更新少量的低秩矩阵,LoRA可以减少计算资源的需求,提高训练和推理的效率。

- 模型稳定性:LoRA适配器模块可以保持预训练模型的稳定性,减少过拟合风险。

- 性能提升:LoRA微调可以在不牺牲太多性能的情况下实现参数高效的微调。

40. AdaLoRA 的思路是怎么样的?

AdaLoRA是一种自适应的LoRA方法,它可以根据任务的需求和模型的性能动态调整LoRA适配器模块的参数。AdaLoRA的思路是:

- 初始化LoRA适配器模块的参数,使用预训练模型的参数作为初始化。

- 在训练过程中,根据模型的性能和任务需求,动态调整LoRA适配器模块的参数。

- 通过调整LoRA适配器模块的参数,使模型能够更好地适应特定的任务需求。

41. LoRA 权重合入chatglm模型的方法?

- 在chatGLM模型的每个Transformer层中添加LoRA适配器模块。

- 使用预训练模型的参数作为LoRA适配器模块的初始化。

- 在训练过程中,更新LoRA适配器模块的参数,以适应特定的任务需求。

- 保持预训练模型的参数不变,避免对预训练模型产生负面影响。

42. P-tuning 讲一下?与 P-tuning v2 区别在哪里?优点与缺点?

P-tuning是一种参数高效的微调方法,它通过在模型输入中添加可学习的连续前缀来引导模型生成适应特定任务的输出。P-tuning v2是P-tuning的改进版本,它使用了更多的连续前缀表示来引导模型生成适应特定任务的输出。

P-tuning与P-tuning v2的区别在于:

- P-tuning:在输入序列的开头添加一个可学习的连续前缀,前缀的长度较短。

- P-tuning v2:在输入序列的开头添加多个可学习的连续前缀,前缀的长度较长。

P-tuning的优点是参数高效,计算资源需求较低,可以快速实现模型微调。P-tuning的缺点是可能受到前缀表示长度的限制,无法充分捕捉任务相关的信息。P-tuning v2通过使用更多的连续前缀,可以更充分地捕捉任务相关的信息,但可能需要更多的计算资源来更新多个前缀的参数。

43. 为什么SFT之后感觉LLM傻了?

SFT(Supervised Fine-Tuning)之后感觉LLM(Large Language Model)"傻了",可能是因为微调过程中出现了以下问题:

- 过拟合:模型可能过度适应训练数据,导致在新数据上的泛化能力下降。

- 数据质量:如果训练数据质量不高,模型可能学到了错误的模式或偏见。

- 微调强度:微调的强度可能不够,导致模型没有充分适应新的任务。在这种情况下,模型可能没有学习到足够的特定领域的知识,因此在执行相关任务时表现不佳。

44. 垂直领域数据训练后,通用能力往往会有所下降,如何缓解模型遗忘通用能力?

- 多任务学习:在训练过程中同时包含通用任务和领域特定任务,使模型能够同时学习通用和特定领域的知识。

- 控制微调强度:通过调整学习率、正则化参数等,控制模型对领域数据的适应程度。

- 定期回炉:在领域数据训练后,定期使用通用数据进行回炉训练,以保持模型的通用能力。

- 知识蒸馏:使用一个预训练的通用模型来指导领域模型,帮助模型保持通用知识。

45. 进行SFT操作的时候,基座模型选用Chat还是Base?

在进行SFT(Supervised Fine-Tuning)操作时,选择基座模型(Chat或Base)取决于具体任务的需求和模型的性能。通常,如果任务需要生成对话或交互式响应,可以选择对话优化的模型(Chat)。如果任务更注重理解和生成文本的能力,可以选择基础模型(Base)。在实际应用中,可能需要根据实验结果和模型性能来选择最合适的基座模型。

46. 领域模型词表扩增是不是有必要的?

领域模型词表扩增通常是有必要的,尤其是当领域内有大量的专业术语或特定词汇时。词表扩增可以帮助模型更好地理解和生成领域内的文本,提高模型的领域适应性。然而,词表扩增也需要谨慎进行,以避免引入过多的噪音或不相关的词汇。

47. 训练中文大模型的经验和方法?

- 使用大量高质量的中文数据,包括文本、对话、新闻、社交媒体帖子等。

- 考虑语言的特点,如词序、语法结构、多义性等,并设计相应的预训练任务。

- 使用适合中文的语言模型架构,如BERT或GPT,并进行适当的调整以优化性能。

- 考虑中文的特殊字符和标点,确保模型能够正确处理这些字符。

- 进行多任务学习,同时训练多个相关任务,以提高模型的泛化能力。

48. 模型微调用的什么模型?模型参数是多少?微调模型需要多大显存?

模型微调使用的模型和模型参数取决于具体任务的需求和可用资源。模型可以是任何预训练的语言模型,如BERT、GPT、LLaMA等,参数数量可以从几千万到数十亿不等。微调模型需要的显存取决于模型的规模、任务复杂度、数据量等因素。一般来说,微调模型需要的显存通常比预训练模型少,因为微调涉及到更新的参数较少。然而,具体需要的显存仍然需要根据实际情况进行评估和调整。

49. 预训练和SFT操作有什么不同?

预训练和SFT操作的主要区别在于目标和数据集。预训练通常是在大规模的无标签数据集上进行的,目的是让模型学习到通用的语言表示和模式。这个过程不需要人工标注数据,而是通过模型自己从数据中学习。SFT则是在有标签的数据集上进行的,目的是让模型适应特定的任务或领域。这个过程需要人工标注数据,以确保模型能够学习到正确的任务特定的模式和知识。

50. 训练一个通用大模型的流程有那些?

- 数据收集:收集大量的、多样化的、无标签的文本数据。

- 数据预处理:对收集的数据进行清洗、分词、编码等预处理步骤。

- 模型设计:选择合适的模型架构,如Transformer,并确定模型的规模和层数。

- 预训练目标:设计预训练任务,如语言建模、掩码语言模型、句子对齐等。

- 训练模型:使用预训练数据集和预训练目标开始训练模型。

- 评估性能:在预训练过程中定期评估模型的性能,并根据需要调整训练参数。

- 微调和优化:在预训练完成后,使用有标签的数据集进行微调,以适应特定的任务或领域。

51. DDO 与 DPO 的区别是什么?

DDO(Dual Data Objectives)和DPO(Dual Prompt Objectives)是两种不同的训练策略,用于提高大型语言模型的性能。

- DDO:在训练过程中,同时优化两个数据集的目标,一个是通用数据集,另一个是特定领域数据集。这样可以让模型同时学习通用知识和特定领域的知识,提高模型的泛化能力和领域适应性。

- DPO:在训练过程中,同时使用两个提示(prompt),一个是通用提示,另一个是特定领域提示。这样可以让模型在执行任务时,同时利用通用知识和特定领域的知识,提高模型在特定任务上的性能。

52. 是否接触过 embeding 模型的微调方法?

嵌入模型微调通常涉及调整模型中的嵌入层,以适应特定的任务或领域。这可能包括:

- 初始化:使用特定领域的数据来初始化嵌入层,以便更好地捕捉领域特定的信息。

- 调整:通过训练或优化嵌入层的参数,使其能够适应特定任务或领域的需求。

- 知识注入:将领域特定的知识以向量的形式注入到嵌入层中,以增强模型对领域知识的理解和应用。

53. 有哪些省内存的大语言模型训练/微调/推理方法?

- 模型剪枝:通过移除模型中的冗余结构和参数,减少模型的内存占用。

- 知识蒸馏:使用一个大型教师模型来指导一个小型学生模型,使学生模型能够学习到教师模型的知识,同时减少内存占用。

- 量化:将模型的权重和激活从浮点数转换为低精度整数,减少模型的内存占用和计算需求。

- 模型并行:将大型模型分割到多个设备上进行训练和推理,减少单个设备的内存需求。

- 数据并行:将训练数据分割到多个设备上,每个设备训练模型的一个副本,减少单个设备的内存需求。

- 动态批处理:根据可用内存动态调整批量大小,以适应内存限制。

54. 大模型(LLMs)评测有那些方法?如何衡量大模型的效果?

大模型(LLMs)的评测方法通常包括:

- 准确性:评估模型在特定任务上的预测准确性。

- 泛化能力:评估模型在未见过的数据上的表现。

- 计算效率:评估模型训练和推理的速度和资源需求。

- 安全性:评估模型在对抗性输入下的稳定性和鲁棒性。

- 多样性和创造性:评估模型生成文本的多样性和创造性。

- 人类评估:通过人工评估来衡量模型的性能,特别是在对话和生成任务中。

衡量大模型效果的方法包括:

- 自动评估指标:使用如BLEU、ROUGE、METEOR等自动评估指标来衡量模型的语言生成和理解能力。

- 任务特定的指标:使用任务特定的指标来衡量模型在特定任务上的性能,如准确率、F1分数等。

- 用户反馈:收集用户对模型生成内容的反馈,以评估模型的实际应用效果。

55. 如何解决三个阶段的训练(SFT->RM->PPO)过程较长,更新迭代较慢问题?

- 减少训练数据量:如果训练数据量过大,可以考虑减少数据量,以加快训练速度。

- 优化训练流程:优化训练流程,如使用更高效的训练算法、调整训练参数等,以加快训练速度。

- 并行训练:使用多GPU或多服务器并行训练模型,以加快训练速度。

- 提前停止:在训练过程中,如果模型性能不再提高,可以提前停止训练,以节省时间。

- 知识蒸馏:使用一个大型教师模型来指导一个小型学生模型,使学生模型能够快速学习到教师模型的知识。

56. 模型训练的数据集问题:一般数据集哪里找?

- 公开数据集:许多研究机构和组织会发布公开数据集,如IMDb、Wikipedia、Common Crawl等。

- 特定领域数据集:针对特定领域的数据集,如医疗、金融、法律等,通常需要从相关的专业文献、报告、论坛等渠道获取。

- 合成数据:通过自动化或半自动化方法生成数据,如文本合成、数据增强等。

- 用户生成数据:通过众包、调查、游戏等方式收集用户生成的数据。

- 商业数据:从商业公司或服务中获取数据,通常需要遵守相关的数据使用协议和隐私政策。

57. 为什么需要进行模型量化及原理?

模型量化是将模型中的权重和激活从高精度浮点数转换为低精度整数(如INT8、INT4、FP16等)的过程,目的是减少模型的大小、提高计算效率并降低内存需求。模型量化的原理在于,低精度数值格式可以提供足够的精度来保持模型性能,同时显著减少数值的位数,从而减少存储和计算资源的使用。

58. 大模型词表扩充的方法及工具?

大模型词表扩充的方法包括:

- 新增词汇:手动添加领域特定的术语和词汇到词表中。

- 数据驱动:通过分析大量文本数据自动识别和添加高频出现的词汇。

- 词汇映射:将特定领域的词汇映射到现有的词表中,或者创建新的词汇条目。

工具方面,一些流行的词表管理工具和库包括:

- Hugging Face Transformers:提供了一个预训练模型和词表管理的接口。

- SentencePiece:一个用于构建词汇表的工具,支持BPE和其他子词分割方法。

- Moses:一个开源的自然语言处理工具,包括用于词表构建和分词的工具。

59. 大模型应用框架及其功能?

大模型应用框架提供了一组工具和库,用于构建、训练和部署大型语言模型。这些框架通常包括以下功能:

- 模型加载和保存:支持加载预训练模型和保存微调后的模型。

- 数据处理:提供数据预处理、分词、编码等工具。

- 模型训练:支持模型训练、评估和调试。

- 模型部署:支持将模型部署到不同的环境和平台,如服务器、移动设备等。

- API接口:提供模型预测的API接口,方便集成到其他应用中。

一些流行的大模型应用框架包括:

- Hugging Face Transformers:一个流行的NLP研究工具,提供了大量预训练模型和工具。

- PyTorch:一个开源的深度学习框架,支持大型语言模型的训练和部署。

- TensorFlow:另一个流行的深度学习框架,也支持大型语言模型的训练和部署。

60. 搭建大模型应用遇到过那些问题?如何解决的?

搭建大模型应用时可能会遇到以下问题:

- 资源限制:计算资源不足,如显存不足、计算时间受限等。

- 模型稳定性:模型在训练或部署过程中出现不稳定的行为。

- 数据质量:训练数据质量不高,导致模型性能不佳。

- 模型部署:将模型部署到生产环境中的技术挑战。

解决这些问题的方法可能包括:

- 资源优化:使用更高效的训练算法、调整训练参数、使用模型并行或数据并行技术。

- 模型调试:使用调试工具和技术来分析模型行为,找出问题的根源。

- 数据处理:进行数据清洗、增强和预处理,以提高数据质量。

- 部署策略:选择合适的部署策略,如使用模型压缩技术、优化模型结构等。

61. 如何提升大模型的检索效果?

- 优化索引:使用更高效的索引结构,如倒排索引、BM25等。

- 特征工程:提取和利用有效的特征,如文本向量、词频等。

- 模型选择:选择合适的检索模型,如基于向量的相似度计算、基于排序的模型等。

- 训练策略:使用训练策略,如多任务学习、知识蒸馏等,来提高模型的性能。

- 评估指标:使用更准确的评估指标,如MAP、NDCG等,来衡量检索效果。

62. 是否了解上下文压缩方法?

上下文压缩是一种减少模型参数数量和计算复杂度的技术,同时尽量保持模型的性能。这种方法通常涉及:

- 模型剪枝:移除模型中的冗余结构和参数。

- 知识蒸馏:使用一个大型教师模型来指导一个小型学生模型,使学生模型能够学习到教师模型的知识。

- 权重共享:在模型中,将部分参数设置为共享,这些参数同时用于多个任务或领域。

- 低秩分解:将大型参数矩阵分解为多个小型矩阵,只更新其中的部分矩阵。

63. 如何实现窗口上下文检索?

窗口上下文检索是一种在给定文本片段的上下文中检索相关信息的方法。实现窗口上下文检索通常涉及以下步骤:

- 文本分块:将长文本分割成多个较小的文本块,这些文本块被称为窗口。

- 索引构建:为每个文本块构建索引,以便快速检索相关信息。

- 查询处理:将查询文本与索引中的文本块进行匹配,找到与查询最相关的文本块。

- 上下文检索:在找到的相关文本块中,检索与查询相关的信息。这可能涉及到计算文本块与查询的相似度,并根据相似度排序文本块。

- 结果生成:根据检索结果生成答案或摘要。

64. 开源的 RAG 框架有哪些,你比较了解?

RAG(Retrieval-Augmented Generation)是一种结合了检索和生成的框架,用于提高大型语言模型生成文本的质量和相关性。开源的RAG框架包括:

- Hugging Face's RAG:一个结合了检索增强生成的开源框架,支持多种任务,如文本生成、摘要等。

- Google's Retrieval-Augmented Generator(RAG)TensorFlow实现:一个基于TensorFlow的RAG实现,用于支持大规模的文本生成任务。

- Microsoft's RAG:一个结合了检索和生成的框架,用于支持多轮对话和知识密集型任务。

65. 大模型应用框架 LangChain 和 LlamaIndex 各自的优势有那些?

LangChain和LlamaIndex是大模型应用框架,它们提供了构建、训练和部署大型语言模型的工具和库。这些框架的优势包括:

- 易用性:提供了一组易于使用的工具和库,简化了大模型应用的开发和部署过程。

- 灵活性:支持多种模型架构和任务,能够适应不同的应用场景和需求。

- 高效性:提供了高效的训练和推理算法,减少了计算资源的需求。

- 集成性:与其他工具和框架具有良好的集成,如数据处理、模型评估等。

- 社区支持:拥有活跃的社区,提供了大量的教程、文档和讨论,帮助用户解决问题和提高技能。

66. 向量库有那些?各自优点与区别?

- TensorFlow:一个开源的深度学习框架,提供了向量操作和计算的支持。

- PyTorch:另一个流行的深度学习框架,也提供了向量操作和计算的支持。

- NumPy:一个用于数值计算的Python库,提供了向量操作和矩阵运算的支持。

- SciPy:基于NumPy的Python库,提供了用于科学计算的向量操作和函数。

这些向量库的优点包括:

- 高效性:提供了高效的向量操作和矩阵运算,能够快速处理大规模数据。

- 灵活性:支持多种数据类型和操作,能够适应不同的应用场景和需求。

- 社区支持:拥有活跃的社区,提供了大量的教程、文档和讨论,帮助用户解决问题和提高技能。

区别在于它们的设计哲学、API接口和使用场景。例如,TensorFlow和PyTorch都是深度学习框架,提供了全面的神经网络构建和训练功能,而NumPy和SciPy更专注于数值计算和科学计算。

66-1. 向量数据库有那些?各自优点与区别?

向量数据库是一种数据库,专门设计用于存储和查询向量数据,常用于机器学习和数据科学领域。向量数据库可以高效地处理高维空间数据的相似性搜索,这在图像识别、文本搜索、推荐系统等应用中非常重要。以下是一些流行的向量数据库及其优缺点:

1. Milvus

- 优点:Milvus 是一个开源的向量数据库,支持多种类型的向量索引,如IVF、HNSW、Flat等。它提供了可扩展的架构,可以处理大量数据,并支持云原生部署。

- 缺点:由于是较新的项目,社区和文档可能不如一些老牌数据库成熟。

2. Faiss

- 优点:Faiss 是由Facebook AI团队开发的高效相似性搜索和密集向量聚类库。它提供了多种向量索引算法,性能极高。

- 缺点:作为一个库而不是完整的数据库系统,Faiss 不提供完整的数据管理功能,需要用户自己集成到应用中。

3. Vespa

- 优点:Vespa 是由Yahoo开发的一个高性能分布式数据存储和查询系统,支持向量相似性搜索和实时数据摄入。

- 缺点:Vespa 的配置和使用相对复杂,可能需要较深的系统知识。

4. Pinecone

- 优点:Pinecone 是一个托管的向量数据库服务,易于设置和使用,提供了强大的相似性搜索功能。

- 缺点:作为一个商业服务,Pinecone的成本可能比开源解决方案要高。

5. Weaviate

- 优点:Weaviate 是一个开源的向量搜索引擎,支持多种数据类型,包括文本、图像和向量,并提供了易于使用的REST API。

- 缺点:相对于其他一些解决方案,Weaviate 可能还不够成熟,社区较小。

67. 使用外部知识数据库时需要对文档进行分块,如何科学的设置文档块的大小?

- 查询需求:根据查询的需求和上下文长度来确定文档块的大小。

- 检索效率:较小的文档块可以提高检索效率,但过小的块可能导致信息的碎片化。

- 存储和计算资源:考虑存储和计算资源的需求,确定文档块的大小以平衡效率和资源使用。

- 用户体验:确保文档块的大小适合用户的阅读和理解需求。

一种科学的方法是进行实验和评估,通过比较不同文档块大小对检索效果、效率和用户体验的影响,来确定最佳的分块大小。

68. LLMs 受到上下文长度的限制,如果检索到的文档带有太多噪声,该如何解决这样的问题?

- 上下文修剪:使用摘要或摘要生成技术来提取文档的关键部分,减少噪声。

- 知识蒸馏:使用一个大型教师模型来指导一个小型学生模型,使学生模型能够学习到教师模型的知识,从而提高模型的鲁棒性。

- 过滤和去噪:使用文本过滤和去噪技术,如文本清洗、去重、去除无关信息等,来减少噪声。

- 强化学习:通过强化学习训练模型,使其能够自动识别和忽略噪声信息,专注于相关和有用的信息。

- 数据增强:通过对原始数据进行转换,如文本回译(将文本翻译成另一种语言再翻译回来)、添加噪声等,生成更多的训练样本,从而提高模型对噪声的鲁棒性。

知识蒸馏是一种模型压缩技术,其中一个大型的、表现良好的模型(教师模型)被用来训练一个小型的模型(学生模型)。这个过程涉及到将教师模型的知识转移到学生模型中,通常通过模仿教师模型的输出或中间层的表示。学生模型因此能够学习到如何处理噪声,同时保持较小的模型大小,这有助于在有限的上下文长度内工作。

69. RAG(检索增强生成)对于大模型来说,有什么好处?

- 提高生成质量:通过结合检索到的相关信息,RAG可以帮助大型语言模型生成更准确、更相关和更高质量的文本。

- 增强上下文关联性:检索到的信息可以为模型提供更多的上下文信息,使生成的文本更加符合上下文语境。

- 提高模型鲁棒性:通过结合检索到的信息,模型可以更好地处理不完整或噪声的输入,提高模型的鲁棒性。

- 减少训练数据需求:RAG可以通过检索相关信息来增强模型的知识,从而减少对大规模标注数据的依赖。

- 提高模型泛化能力:RAG可以帮助模型学习到更广泛的知识,提高模型的泛化能力,使其能够更好地适应不同的任务和领域。

70. Self-attention的公式及参数量?为什么用多头?为什么要除以根号d?

Self-attention 模型在对当前位置的信息进行编码时,会过度的将注意力集中于自身的位置,因此作者提出了通过多头注意力机制来解决这一问题。同时,使用多头注意力机制还能够给予注意力层的输出包含有不同子空间中的编码表示信息,从而增强模型的表达能力。

这是因为点积的数量级增长很大,因此将 softmax 函数推向了梯度极小的区域。

Self-attention(自注意力)机制是Transformer模型的核心组成部分,它允许模型在处理序列数据时,为序列中的每个元素(如词或标记)分配不同的注意力权重,从而捕捉序列内的依赖关系。

Self-attention的基本公式如下:

1. **计算Query(Q)、Key(K)和Value(V)**:

这些矩阵是通过将输入序列的嵌入(或隐藏状态)与三个不同的权重矩阵(Wq、Wk、Wv)相乘得到的。这三个权重矩阵是模型需要学习的参数。

- Q = X * Wq

- K = X * Wk

- V = X * Wv

其中,X是输入序列的嵌入矩阵,维度为\(NXD\),N是序列长度,D是嵌入维度。

2. **计算注意力得分**:

使用Query和Key计算注意力得分,这反映了序列中每个元素对其他元素的重要性。

- 得分 = Q * K^T

3. **应用softmax函数**:

将得分通过softmax函数转换为概率分布,确保所有注意力权重的总和为1。

- 概率分布 = softmax(得分 / √D)

4. **计算加权的Value**:

将Value与softmax得到的概率分布相乘,得到加权后的Value,这是考虑了序列中其他元素的上下文信息的新表示。

- 加权Value = 概率分布 * V

5. **输出**:

将加权Value相加,得到最终的输出,这是序列中每个元素的上下文表示。

- 输出 = 加权Value之和

参数量的计算:

- 每个权重矩阵(Wq、Wk、Wv)的参数量为\(DXD\),因此总共有3个权重矩阵,参数量为\(3XD^2\)。

为什么用多头(Multi-Head)注意力:

- 多头注意力允许模型在不同的表示子空间中学习信息,这样可以让模型同时关注不同的信息维度。每个头学习到的信息可以独立地编码输入序列的不同方面,然后将这些信息综合起来,得到更丰富的表示。

为什么要除以根号D:

- 将得分除以根号D(得分归一化)可以防止内积过大导致softmax函数梯度变得非常小,这有助于数值稳定性,使得学习过程更加稳定。此外,它还可以看作是一种缩放因子,帮助模型在不同维度上保持一致的性能。

三、大模型(LLMs)LangChain

1. 什么是 LangChain?

LangChain 是一个用于构建和运行大型语言模型应用的开源框架。它提供了一套工具和组件,帮助开发者将大型语言模型(如 GPT-3)与其他工具和API结合,以完成更复杂的任务。

2. LangChain 包含哪些核心概念?

- Components: 可重用的模块,例如API调用、数据库查询等。

- Chains: 将多个Components链接在一起以完成特定任务的流程。

- Prompt Templates: 用于指导语言模型生成输出的文本模板。

- Output Parsers: 解析语言模型输出的工具。

- Indexes and Retrievers: 用于存储和检索信息的索引和数据检索器。

- Agents and Toolkits: 提供特定领域功能的代理和工具集。

3. 什么是 LangChain Agent?

LangChain Agent是一种可以执行一系列操作以完成复杂任务的程序。它可以根据给定的输入和上下文,选择合适的工具和策略来生成响应或执行操作。

4. 如何使用 LangChain?

- 定义Components:创建或集成各种API和工具。

- 构建Chains:将Components组合成完成特定任务的流程。

- 设置Prompt Templates:定义用于指导语言模型的文本模板。

- 配置Output Parsers:解析和提取语言模型的输出。

- 部署和运行:将构建的应用部署到服务器或云平台,并进行测试和优化。

5. LangChain 支持哪些功能?

- 集成和调用外部API。

- 查询和操作数据库。

- 文本生成和编辑。

- 信息检索和问答。

- 多步骤任务执行和决策。

6. 什么是 LangChain model?

LangChain model指的是在LangChain框架中使用的大型语言模型,如GPT-3或类似的模型。这些模型通常用于生成文本、回答问题或执行特定的语言任务。

7. LangChain 包含哪些特点?

- 开源和可扩展:易于集成和扩展新功能。

- 模块化和可重用:Components和Chains可以重用和组合。

- 灵活和可定制:可以自定义Prompt Templates和Output Parsers。

- 支持多种语言模型:可以集成和使用不同的语言模型。

8. LangChain 如何使用?

- 定义Components:创建或集成各种API和工具。

- 构建Chains:将Components组合成完成特定任务的流程。

- 设置Prompt Templates:定义用于指导语言模型的文本模板。

- 配置Output Parsers:解析和提取语言模型的输出。

- 部署和运行:将构建的应用部署到服务器或云平台,并进行测试和优化。

9. LangChain 存在哪些问题及方法方案?

- 低效的令牌使用问题:可以通过优化Prompt Templates和减少不必要的API调用来解决。

- 文档的问题:可以通过改进文档和提供更多的示例来帮助开发者理解和使用LangChain。

- 太多概念容易混淆:可以通过提供更清晰的解释和更直观的API设计来解决。

- 行为不一致并且隐藏细节问题:可以通过提供更一致和透明的API和行为来解决。

- 缺乏标准的可互操作数据类型问题:可以通过定义和使用标准的数据格式和协议来解决。

低效的令牌使用问题:

- 在语言模型应用中,令牌是模型处理文本的单位,通常与成本挂钩。如果Prompt Templates设计不当或API调用频繁,可能会导致令牌的浪费,增加成本。

- 解决方案:优化Prompt Templates,确保它们尽可能高效地传达信息,减少冗余。同时,减少不必要的API调用,例如通过批量处理数据或合并多个请求。

文档的问题:

- 如果LangChain的文档不清晰或不完整,开发者可能难以理解如何使用框架,或者可能无法充分利用其功能。

- 解决方案:改进文档的质量,提供详细的API参考、教程和最佳实践指南。增加更多的示例代码和应用场景,帮助开发者更快地上手。

太多概念容易混淆:

- LangChain可能引入了许多新的概念和抽象,对于新用户来说,这可能难以理解和区分。

- 解决方案:提供清晰的解释和定义,使用户能够理解每个概念的目的和作用。设计更直观的API,使其易于理解和使用。

行为不一致并且隐藏细节问题:

- 如果API的行为不一致,开发者可能难以预测其结果,这会导致错误和混淆。隐藏细节可能会让开发者难以调试和优化他们的应用。

- 解决方案:确保API的行为一致,并提供清晰的错误消息和文档。避免隐藏太多细节,而是提供适当的抽象级别,同时允许高级用户访问底层实现。

缺乏标准的可互操作数据类型问题:

- 如果LangChain没有定义和使用标准的数据格式和协议,那么在不同的系统和服务之间进行数据交换可能会很困难。

- 解决方案:定义和使用标准的数据格式(如JSON、CSV)和协议(如REST、gRPC),以确保不同组件和服务之间的互操作性。

10. LangChain 替代方案?

LangChain的替代方案包括其他用于构建和运行大型语言模型应用的开源框架,例如Hugging Face的Transformers库、OpenAI的GPT-3 API等。

11. LangChain 中 Components and Chains 是什么?

Components是可重用的模块,例如API调用、数据库查询等。Chains是将多个Components链接在一起以完成特定任务的流程。

12. LangChain 中 Prompt Templates and Values 是什么?

Prompt Templates是用于指导语言模型生成输出的文本模板。Values是填充Prompt Templates中的变量的实际值。

13. LangChain 中 Example Selectors 是什么?

Example Selectors是从一组示例中选择一个或多个示例的工具。它们可以用于提供上下文或示例,以帮助语言模型生成更准确的输出。

- 上下文关联:当模型需要根据特定的上下文或场景生成回答时,Example Selectors可以帮助选择与当前上下文最相关的示例。

- 数据过滤:在处理大量数据时,Example Selectors可以根据特定的标准和条件过滤数据,以便模型仅处理最相关的信息。

- 个性化回答:Example Selectors可以根据用户的需求和偏好选择示例,从而生成更加个性化的回答。

14. LangChain 中 Output Parsers 是什么?

Output Parsers是解析和提取语言模型输出的工具。它们可以将语言模型的输出转换为更结构化和有用的形式。

15. LangChain 中 Indexes and Retrievers 是什么?

Indexes and Retrievers是用于存储和检索信息的索引和数据检索器。它们可以用于提供上下文或从大量数据中检索相关信息。

16. LangChain 中 Chat Message History 是什么?

Chat Message History是存储和跟踪聊天消息历史的工具。它可以用于维护对话的上下文,以便在多轮对话中提供连贯的响应。

17. LangChain 中 Agents and Toolkits 是什么?

Agents and Toolkits是提供特定领域功能的代理和工具集。Agents是一系列可以执行的操作,而Toolkits则是为这些操作提供接口和实现的工具集合。

18. LangChain 如何调用 LLMs 生成回复?

LangChain通过定义好的Prompt Templates向LLMs发送指令,LLMs根据这些指令生成文本回复。LangChain还可以使用Output Parsers来解析和格式化LLMs的输出。

19. LangChain 如何修改提示模板?

在LangChain中,可以通过修改Prompt Templates的文本内容或变量来定制提示。

20. LangChain 如何链接多个组件处理一个特定的下游任务?

LangChain通过构建Chains来链接多个Components。每个Component执行一个特定的任务,然后将输出传递给链中的下一个Component,直到完成整个任务。

21. LangChain 如何Embedding & vector store?

LangChain可以使用嵌入函数将文本数据转换为向量,并将这些向量存储在向量存储库中。这样做的目的是为了能够高效地检索和查询文本数据。

四、大模型分布式训练

1. 大模型进行训练,用的是什么框架?

- TensorFlow是一个由Google开发的开源机器学习框架,它提供了强大的分布式训练功能。TensorFlow支持数据并行、模型并行和分布式策略等多种分布式训练方法。

- PyTorch是一个由Facebook的AI研究团队开发的流行的开源机器学习库。它提供了分布式包(torch.distributed),支持分布式训练,并且可以通过使用torch.nn.parallel.DistributedDataParallel(DDP)或torch.nn.DataParallel来实现数据并行。

- Horovod是由Uber开源的分布式训练框架,它基于MPI(Message Passing Interface)并提供了一种简单的方法来并行化TensorFlow、Keras、PyTorch和Apache MXNet等框架的训练。Horovod特别适合于大规模的深度学习模型训练。

- Ray是一个开源的分布式框架,用于构建和运行分布式应用程序。Ray提供了Ray Tune(用于超参数调优)和Ray Serve(用于模型服务),并且可以与TensorFlow、PyTorch和MXNet等深度学习库集成。

- Hugging Face的Accelerate库是为了简化PyTorch模型的分布式训练而设计的。它提供了一个简单的API来启动分布式训练,并支持使用单个或多个GPU以及TPU。

- DeepSpeed是微软开发的一个开源库,用于加速PyTorch模型的训练。它提供了各种优化技术,如ZeRO(Zero Redundancy Optimizer)和模型并行性,以支持大规模模型的训练。

2. 业内常用的分布式AI框架?

- Horovod:由Uber开发,基于MPI的分布式训练框架。

- Ray:用于构建和运行分布式应用程序的开放源代码框架。

- DeepSpeed:由微软开发,用于加速深度学习训练的库,它提供了数据并行、张量并行和模型并行等多种并行策略。

- FairScale:由Facebook开发,提供了类似于DeepSpeed的功能。

3. 数据并行、张量并行、流水线并行的原理及区别?

- 数据并行:在数据并行中,模型的不同副本在不同的设备上运行,每个设备处理输入数据的不同部分。每个设备独立地进行前向传播和反向传播,但参数更新是同步的。数据并行的主要优点是简单且易于实现。

- 张量并行:在张量并行中,模型的单个层或参数被切分成多个部分,每个部分在不同的设备上运行。张量并行通常用于训练非常大型的模型,因为它可以减少每个设备的内存需求。

- 流水线并行:在流水线并行中,模型的不同层被放置在不同的设备上,每个设备负责模型的一部分。输入数据在设备之间按顺序流动,每个设备完成自己的计算后将数据传递给下一个设备。流水线并行可以减少每个设备的内存需求,并提高训练速度。

4. 推理优化技术 Flash Attention 的作用是什么?

Flash Attention是一种用于加速自然语言处理模型中自注意力机制的推理过程的优化技术。它通过减少计算量和内存需求,使得在有限的资源下能够处理更长的序列。Flash Attention使用了一种有效的矩阵乘法算法,可以在不牺牲准确性的情况下提高推理速度。

5. 推理优化技术 Paged Attention 的作用是什么?

Paged Attention是一种用于处理长序列的优化技术。它将注意力矩阵分页,使得只有当前页的注意力分数被计算和存储,从而大大减少了内存需求。这种方法可以在不增加计算成本的情况下处理比内存容量更大的序列。

Flash Attention 是一种高效的注意力机制实现,旨在提高大规模模型训练的速度和内存效率。它通过减少GPU内存使用和增加计算吞吐量来实现这一点。

Flash Attention 利用 GPU 上的特定优化,如共享张量核心和高效的内存使用,以减少内存占用并提高计算速度。这种方法特别适用于具有长序列和大型模型参数的场景,例如自然语言处理和推荐系统。

Paged Attention 是一种用于处理超长序列的注意力机制。在标准的注意力机制中,序列的长度受到GPU内存的限制。

Paged Attention 通过将序列分割成多个较小的部分(页面)来克服这个问题,只将当前需要计算的部分加载到内存中。这种方法允许模型处理比单个GPU内存更大的序列,同时保持较高的计算效率。Paged Attention 对于需要处理极长序列的应用场景(例如长文档处理、音频处理等)非常有用。

6. CPU-offload,ZeRO-offload 了解?

- CPU-offload:在深度学习训练中,将一些计算或数据从GPU转移到CPU上,以减轻GPU的负担。这通常用于减少GPU内存使用,提高GPU利用率。

- ZeRO-offload:是DeepSpeed中的一种优化技术,它将模型的参数、梯度和优化器状态分散存储在CPU内存或NVMe存储中,从而减少GPU内存的使用。ZeRO-offload是ZeRO(零冗余优化器)策略的一部分,旨在提高训练大规模模型的能力。

7. ZeRO,零冗余优化器的三个阶段?

- ZeRO-Stage 1:将优化器状态分割到不同设备上,减少内存占用。

- ZeRO-Stage 2:除了优化器状态,还将模型参数分割到不同设备上。

- ZeRO-Stage 3:将梯度和优化器状态也分割到不同设备上,实现最大的内存节省。

8. 混合精度训练的优点是什么?可能带来什么问题?

- 优点:混合精度训练使用不同精度(例如,FP16和FP32)的数字来执行计算,可以提高训练速度,减少内存使用,并可能减少能源消耗。它利用了现代GPU对FP16运算的支持,同时使用FP32进行关键的计算,以保持准确性。

- 可能的问题:混合精度训练可能会导致数值不稳定,特别是在模型梯度非常小或非常大时。此外,它可能需要额外的校准步骤来确保FP16计算的准确性。

9. Megatron-DeepSpeed 方法?

Megatron-DeepSpeed是结合了Megatron-LM和DeepSpeed的技术,用于训练超大型语言模型。它利用了Megatron-LM的模型并行技术和DeepSpeed的数据并行和优化器技术,以实现高效的训练。

10. Megatron-LM 方法?

Megatron-LM是一种由NVIDIA开发的用于训练大规模语言模型的模型并行技术。它通过将模型的不同部分分布在多个GPU上,以及使用张量并行和流水线并行等技术,来减少每个GPU的内存需求,并提高训练速度。Megatron-LM已经成功训练了数十亿参数的语言模型。

11. DeepSpeed 方法?

DeepSpeed 是一个开源的库,由微软开发,用于加速大规模模型训练。DeepSpeed 通过多种技术实现了这一点,包括:

- 数据并行:通过在不同的 GPU 上分配不同的数据批次,来并行处理数据,从而加速训练过程。

- 模型并行:通过在不同的 GPU 上分配模型的各个部分,来并行处理模型,从而可以训练更大的模型。

- 管道并行:通过将模型的不同层分配到不同的 GPU 上,并在这些 GPU 之间创建数据流管道,来进一步加速训练过程。

- 优化器并行:通过将模型的参数分为多个部分,并在不同的 GPU 上并行计算每个部分的梯度更新,来加速优化器步骤。

- 零冗余优化器(ZeRO):通过将模型的参数、梯度和优化器状态分割存储在多个 GPU 上,并消除冗余存储,来减少内存使用并提高训练效率。

五、大模型(LLMs)推理

1. 为什么大模型推理时显存涨的那么多还一直占着?

- 模型大小:大模型本身具有更多的参数和计算需求,这直接导致了显存的增加。

- 推理过程中的激活和梯度:在推理时,模型的前向传播会产生激活,这些激活需要存储在显存中,尤其是在执行动态计算或需要中间结果的情况下。

- 优化器状态:即使是在推理模式下,某些框架可能会默认加载优化器状态,这也会占用显存空间。

- 内存泄漏:有时代码中的内存泄漏会导致显存一直被占用,而不是在推理完成后释放。

要解决显存占用问题,可以采用的技术包括使用内存分析工具来检测泄漏,优化模型结构,或者使用如TensorFlow的内存管理功能来显式释放不再需要的内存。

2. 大模型在GPU和CPU上推理速度如何?

大模型在GPU上的推理速度通常远快于CPU,因为GPU专门为并行计算设计,具有更多的计算核心和更高的浮点运算能力。例如,NVIDIA的GPU使用CUDA核心,可以同时处理多个任务,这使得它们在执行深度学习推理时非常高效。

CPU虽然也可以执行深度学习推理任务,但由于其核心数量和浮点运算能力通常不及GPU,因此速度会慢得多。然而,CPU在处理单线程任务时可能更高效,且在某些特定场景下,如边缘计算设备上,CPU可能是唯一可用的计算资源。

3. 推理速度上,int8和fp16比起来怎么样?

INT8(8位整数)和FP16(16位浮点数)都是低精度格式,用于减少模型的大小和提高推理速度。INT8提供更高的压缩比,可以显著减少模型的内存占用和带宽需求,但由于量化过程中的信息损失,可能会对模型的准确性产生一定影响。FP16提供比INT8更高的精度,通常对模型的准确性影响较小,但相比INT16或FP32,它的速度和内存效率仍然有所提高。

在实际应用中,INT8和FP16的推理速度取决于具体的模型和硬件。一般来说,INT8可能会提供更高的吞吐量,但FP16可能会提供更好的延迟和准确性。例如,NVIDIA的Tensor Cores支持FP16和INT8运算,可以显著提高这两种格式的推理性能。

4. 大模型有推理能力吗?

大模型(LLMs)具有推理能力。推理能力不仅限于回答事实性问题,还包括理解复杂语境、生成连贯文本、执行文本分类、翻译等任务。例如,GPT-3是一个大模型,它能够生成文章、故事、诗歌,甚至编写代码。

5. 大模型生成时的参数怎么设置?

大模型生成时的参数设置取决于具体的任务和模型。一些常见的参数包括:

- 温度(Temperature):控制生成的文本的随机性。较低的温度值将导致生成更保守的文本,而较高的温度值将导致更多样化的文本。

- Top-k采样:仅从概率最高的k个词中采样,以减少生成文本的随机性。

- Top-p采样:从累积概率超过p的词中进行采样,这有助于生成更相关的文本。

- 最大生成长度:指定生成文本的最大长度。

例如,使用GPT-3生成文本时,可以设置温度为0.7,top-k为50,最大生成长度为100个词。

6. 有哪些省内存的大语言模型训练/微调/推理方法?

- 模型并行:将模型的不同部分分布在多个设备上。

- 张量切片:将模型的权重和激活分割成较小的块。

- 混合精度训练:使用FP16和INT8精度进行训练和推理。

- 优化器状态分割:如ZeRO技术,将优化器状态分割到不同设备上。

- 梯度累积:通过累积多个批次的梯度来减少每个批次的内存需求。

在机器学习中,优化器状态是指在训练模型时优化器所维护的关于模型参数更新的额外信息。这些信息对于执行梯度下降算法的变体(如Adam、RMSprop、SGD等)至关重要,因为它们帮助优化器更有效地调整模型参数。

优化器状态通常包括以下几个关键组件:

- 梯度:在反向传播过程中计算的权重参数的梯度,指示了损失函数相对于每个参数的斜率。

- 动量:某些优化器(如SGD with Momentum、Adam等)会使用动量来平滑参数更新,这可以帮助优化器在相关方向上加速学习,并减少震荡。

- 平方梯度:某些优化器(如RMSprop、Adam)会保存每个参数梯度的平方的移动平均,这有助于调整学习率并稳定训练过程。

- 学习率:优化器可能会根据训练的进度或某些其他信号调整每个参数的学习率。

- 其他统计量:某些优化器可能会使用其他统计量,如Adam优化器会维护梯度的一阶和二阶矩的估计。

优化器状态对于实现高效的参数更新至关重要。在训练过程中,优化器会根据这些状态信息来计算每个迭代步骤中参数的更新量。在分布式训练设置中,如DeepSpeed中的ZeRO优化器,优化器状态的管理变得尤为重要,因为它们需要跨多个GPU或节点高效地分配和同步。

7. 如何让大模型输出合规化?

- 过滤不当内容:使用内容过滤器来识别和过滤掉不当的语言或敏感内容。

- 指导性提示:提供明确的提示,指导模型生成符合特定标准和偏好的输出。

- 后处理:对模型的输出进行后处理,例如使用语法检查器和修正工具来提高文本的质量。

- 强化学习:使用强化学习来训练模型,使其偏好生成符合特定标准的输出。

8. 应用模式变更

应用模式变更是指在部署模型时,根据实际应用的需求和环境,对模型的配置、部署策略或使用方式进行调整。例如,一个在云端运行的模型可能需要调整其资源分配以适应不同的负载,或者在边缘设备上运行的模型可能需要减少其内存和计算需求以适应有限的资源。

应用模式变更可能包括:

- 资源调整:根据需求增加或减少用于运行模型的计算资源。

- 模型压缩:使用模型压缩技术如剪枝、量化来减少模型大小。

- 动态部署:根据负载动态地扩展或缩小模型服务的实例数量。

- 缓存策略:实施缓存机制来存储常用查询的响应,减少重复计算的次数。

- 性能优化:对模型进行性能分析,并优化其运行效率,例如通过批处理输入数据来提高吞吐量。

举例来说,如果一个大型语言模型在云平台上运行,当用户查询量增加时,可以通过增加服务器的数量或使用更高效的硬件来扩展其能力。相反,如果模型需要在嵌入式设备上运行,可能需要将模型压缩到更小的尺寸,并优化其运行时的内存使用,以确保模型可以在资源有限的设备上顺利运行。

在实际操作中,应用模式变更通常需要综合考虑模型的性能、成本、可扩展性和业务需求,以找到最佳的平衡点。

1. 前缀微调(Prefix-Tuning)

前缀微调是一种针对预训练模型的微调方法,通过在模型输入前添加特定任务相关的连续前缀表示,从而引导模型生成适应特定任务的输出。在微调过程中,只更新前缀表示的参数,而预训练模型的参数保持不变。

微调方法:首先,为每个任务设计一个可学习的前缀表示。然后,将这个前缀表示与输入序列进行拼接,输入到预训练模型中。最后,通过优化前缀表示的参数,使得模型能够生成适应特定任务的输出。

优点:前缀微调可以减少对预训练模型参数的修改,降低过拟合风险;同时,由于只更新前缀表示的参数,因此计算资源需求较低。

缺点:可能受到前缀表示长度的限制,无法充分捕捉任务相关的信息;此外,对于不同任务,可能需要设计不同的前缀表示,增加了人工成本。

2. 指令微调(Instruction Tuning)

指令微调是一种针对预训练模型的微调方法,通过在训练数据中添加指令来指导模型完成特定任务。在微调过程中,模型需要学习如何根据指令生成适应特定任务的输出。

微调方法:首先,在训练数据中添加包含任务描述的指令。然后,将这些指令与输入序列进行拼接,输入到预训练模型中。最后,通过优化模型参数,使得模型能够根据指令生成适应特定任务的输出。

优点:指令微调可以提高模型在遵循指令方面的能力,从而提高模型在特定任务上的性能。

缺点:可能需要对训练数据进行修改,增加了数据预处理的工作量;此外,对于不同任务,可能需要设计不同的指令,增加了人工成本。

3. p-tuning

p-tuning是一种针对预训练模型的微调方法,通过在模型输入前添加可学习的连续表示,从而引导模型生成适应特定任务的输出。在微调过程中,只更新这些连续表示的参数,而预训练模型的参数保持不变。

微调方法:首先,为每个任务设计一个可学习的连续表示。然后,将这个连续表示与输入序列进行拼接,输入到预训练模型中。最后,通过优化连续表示的参数,使得模型能够生成适应特定任务的输出。

优点:p-tuning可以减少对预训练模型参数的修改,降低过拟合风险;同时,由于只更新连续表示的参数,因此计算资源需求较低。

缺点:可能受到连续表示长度的限制,无法充分捕捉任务相关的信息;此外,对于不同任务,可能需要设计不同的连续表示,增加了人工成本。

4. p-tuning V2

p-tuning V2是p-tuning的改进版本,通过使用更多的连续表示来引导模型生成适应特定任务的输出。在微调过程中,只更新这些连续表示的参数,而预训练模型的参数保持不变。

微调方法:首先,为每个任务设计多个可学习的连续表示。然后,将这些连续表示与输入序列进行拼接,输入到预训练模型中。最后,通过优化连续表示的参数,使得模型能够生成适应特定任务的输出。

优点:p-tuning V2可以进一步减少对预训练模型参数的修改,降低过拟合风险;同时,由于使用了更多的连续表示,可以更充分地捕捉任务相关的信息。

缺点:可能需要更多的计算资源来更新多个连续表示的参数;此外,对于不同任务,可能需要设计不同的连续表示,增加了人工成本。

5. 参数高效微调(Parameter-Efficient Fine-Tuning,PEFT)

参数高效微调是一种针对预训练模型的微调方法,通过仅更新模型参数的一小部分来实现特定任务的适应。在微调过程中,大部分预训练模型的参数保持不变,只更新与特定任务相关的参数。

微调方法:首先,确定与特定任务相关的模型参数。然后,在微调过程中,只更新这些特定参数,而其他参数保持不变。

优点:参数高效微调可以减少计算资源的需求,降低过拟合风险;同时,由于只更新部分参数,因此可以更快地实现模型微调。

缺点:可能无法充分利用预训练模型的特征表示能力;此外,对于不同任务,可能需要确定不同的特定参数,增加了人工成本。

6. prompt微调

prompt微调是一种针对预训练模型的微调方法,通过设计特定的提示(prompt)来引导模型生成适应特定任务的输出。在微调过程中,模型需要学习如何根据提示生成适应特定任务的输出。

微调方法:首先,为每个任务设计一个特定的提示。然后,将这个提示与输入序列进行拼接,输入到预训练模型中。最后,通过优化模型参数,使得模型能够根据提示生成适应特定任务的输出。

优点:prompt微调可以提高模型在遵循提示方面的能力,从而提高模型在特定任务上的性能。

缺点:可能需要对训练数据进行修改,增加了数据预处理的工作量;

7. 领域模型微调(Domain Adaptation)

领域模型微调是一种针对预训练模型的微调方法,用于适应特定领域的任务。当预训练模型需要在特定领域(如医学、法律等)进行应用时,领域模型微调可以通过在领域特定的数据集上对模型进行微调,以适应该领域的特点。

微调方法:首先,准备一个包含领域特定数据的训练集。然后,在这个训练集上对预训练模型进行微调,更新模型的参数以更好地适应领域特定的语言和任务需求。

优点:领域模型微调可以使模型更好地适应特定领域的语言和任务需求,提高在领域内的性能。

缺点:可能需要大量的领域特定数据进行微调,而且微调后的模型可能只在特定领域有效,泛化能力可能减弱。

8. 适配器微调(Adapter-tuning)

适配器微调是一种参数高效的微调方法,它通过在预训练模型的每个Transformer层中添加小型适配器模块,来引入任务特定的参数。

微调方法:首先,在预训练模型的每个Transformer层中添加一对适配器模块,通常由两个全连接层组成。然后,在微调过程中,只更新这些适配器模块的参数,而预训练模型的原始参数保持不变。

优点:适配器微调不需要更新大量的模型参数,因此计算资源需求较低,训练速度较快。同时,适配器模块可以轻松地添加到预训练模型中,不会影响模型的原始性能。

缺点:适配器微调可能无法达到与全量微调相同的性能水平,因为适配器模块的参数量远小于整个模型。此外,适配器模块可能会引入额外的计算开销。

9. LoRA (Low-Rank Adaptation)

LoRA是一种参数高效的微调方法,它通过引入低秩分解来减少需要更新的参数数量。在LoRA中,预训练模型的注意力矩阵或前馈网络矩阵被分解为两个低秩矩阵的乘积,其中这两个低秩矩阵被视为可学习的任务特定参数。

微调方法:首先,将预训练模型的注意力矩阵或前馈网络矩阵分解为两个低秩矩阵。然后,在微调过程中,只更新这两个低秩矩阵的参数,而预训练模型的原始参数保持不变。

优点:LoRA可以显著减少需要更新的参数数量,从而减少计算资源的需求,并加快训练速度。同时,LoRA可以在不牺牲太多性能的情况下实现参数高效的微调。

缺点:LoRA的性能可能略低于全量微调,尤其是在处理非常复杂的任务时。此外,LoRA需要对预训练模型进行一定的修改,以实现矩阵的分解和参数的更新。

10. 全量微调(Full Fine-Tuning)

全量微调是一种传统的微调方法,它涉及更新预训练模型的所有参数以适应特定任务。

微调方法:首先,准备一个包含任务特定数据的训练集。然后,在这个训练集上对预训练模型的参数进行更新,包括Transformer层的权重和输出层的权重。

优点:全量微调通常能够达到最佳的性能,因为它允许模型完全适应特定任务的数据分布。

缺点:全量微调需要大量的计算资源,尤其是在处理大型预训练模型时。此外,全量微调可能会导致过拟合,尤其是在训练数据有限的情况下。

大模型基础

-

主流的开源大模型有哪些?

- GPT-3:由 OpenAI 开发,GPT-3 是一个巨大的自回归语言模型,拥有1750亿个参数。它可以生成文本、回答问题、翻译文本等。

- GPT-Neo:由 EleutherAI 开发,GPT-Neo 是一个开源的、基于 GPT 架构的语言模型,拥有数十亿到百亿级的参数。

- GPT-J:也是由 EleutherAI 开发的,GPT-J 是一个拥有 60亿参数的开源语言模型。

- PaLM (Pathways Language Model):由谷歌开发,PaLM 是一个大型语言模型,拥有5400亿个参数,用于处理自然语言处理任务。

- LaMDA:也是由谷歌开发,LaMDA 是一个对话应用程序的语言模型,旨在生成安全、有事实依据的响应。

- ERNIE 3.0:由百度开发,ERNIE 3.0 是一个大型预训练语言模型,用于处理自然语言处理任务。

- ChatGLM:由智谱 AI 公司开发,ChatGLM 是一个大型语言模型,用于处理自然语言处理任务。

- OPT (Open Pre-trained Transformer):由斯坦福大学和 Meta AI 开发,OPT 是一个大型语言模型,拥有1750亿个参数。

-

目前大模型模型结构有哪些?

目前大型模型的结构主要基于 Transformer 架构,这是因为 Transformer 能够有效地处理长距离依赖关系,并且在并行计算方面具有优势。以下是一些常见的大模型结构:

1. **Transformer**:原始的 Transformer 架构是由 Vaswani 等人在 2017 年提出的,它包含自注意力机制和前馈神经网络。这种结构已经被广泛应用在语言模型、机器翻译、文本生成等任务中。

2. **BERT (Bidirectional Encoder Representations from Transformers)**:BERT 是一种双向 Transformer 结构,它在预训练阶段使用掩码语言建模和下一句预测任务来学习语言表示。BERT 及其变体(如 RoBERTa、ALBERT)在多种自然语言处理任务中取得了突破性的性能。

3. **GPT (Generative Pre-trained Transformer)**:GPT 是一种自回归 Transformer 结构,它在预训练阶段使用传统的语言建模任务来学习语言表示。GPT 及其变体(如 GPT-2、GPT-3)在文本生成和零样本学习等任务中表现出色。

4. **T5 (Text-to-Text Transfer Transformer)**:T5 是一种基于 Transformer 的统一框架,它将所有自然语言处理任务都转化为文本到文本的格式。T5 及其变体(如 mT5、ByT5)在多种语言和任务中表现良好。

5. **XLNet**:XLNet 是一种基于自回归语言建模和双向 Transformer 的模型,它使用排列语言建模目标来捕捉上下文信息。XLNet 在多项自然语言处理任务中取得了出色的性能。

6. **Switch Transformer**:Switch Transformer 是一种使用稀疏注意力机制的 Transformer 结构,它通过将注意力集中在最重要的部分来减少计算复杂度。Switch Transformer 在处理超大型模型时非常有效。

7. **指令微调(Instruction Tuning)模型**:这类模型在预训练后通过指令微调来适应特定的任务或领域。例如,Flan-T5 和 FLAN 是在多种任务和指令上进行了微调的模型,它们在遵循指令和少样本学习方面表现良好。

这些模型结构在不同的应用场景中可能会有所变化,例如通过调整层数、隐藏单元数量、注意力头的数量等来适应不同的需求和资源限制。随着研究的进展,还可能出现新的模型结构和改进方法。

-

Prefix LM 和 causal LM、encoder-decoder 的区别及各自有什么优缺点?

Prefix LM、causal LM(也称为自回归LM)和encoder-decoder是三种不同的语言模型架构,它们在结构、训练方式和应用场景上有所区别。下面是它们的区别及各自的优缺点:

1. **Prefix LM**:

- Prefix LM是一种语言模型架构,它在每个时间步都考虑之前生成的所有文本作为上下文。这意味着模型在生成下一个词时可以使用到目前为止生成的整个序列的信息。

- **优点**:

- 能够利用更长的上下文信息,生成更连贯、上下文相关的文本。

- 在某些任务上,如文本续写或问答,能够提供更准确的回答。

- **缺点**:

- 计算成本较高,因为每个时间步都需要处理整个上下文。

- 可能更容易产生重复的文本。

2. **Causal LM(自回归LM)**:

- Causal LM是一种语言模型架构,它在生成文本时只考虑之前生成的词,而不是整个上下文。这意味着模型在生成下一个词时只能使用之前生成的词的信息。

- **优点**:

- 计算效率较高,因为每个时间步只需要处理之前生成的词。

- 在生成自然语言文本方面表现良好,如对话、文章等。

- **缺点**:

- 可能无法充分利用长距离的上下文信息。

- 在需要长距离上下文信息的任务上,性能可能不如Prefix LM。

3. **Encoder-Decoder**:

- Encoder-Decoder是一种包含编码器和解码器的模型结构,编码器处理输入数据,而解码器生成输出。这种结构常用于机器翻译、文本摘要等任务。

- **优点**:

- 能够处理更复杂的输入输出关系,如机器翻译中的源语言和目标语言。

- 可以通过编码器和解码器的设计来引入额外的约束或先验知识。

- **缺点**:

- 训练和推理速度通常较慢,因为需要分别处理编码器和解码器。

- 模型复杂度较高,需要更多的参数和计算资源。

总的来说,选择哪种架构取决于具体的应用场景和任务需求。例如,如果需要生成连贯的对话或文章,自回归LM可能是一个好选择;如果需要处理复杂的输入输出关系,如机器翻译,则可能需要使用Encoder-Decoder结构。

-

模型幻觉是什么?业内解决方案是什么?

模型幻觉(Model Hallucination)是指模型在生成文本或做出预测时产生的不准确、虚构或误导性的信息。这种现象通常发生在大型语言模型中,尤其是当模型基于不完整或模糊的信息进行推理时。模型幻觉可能是由于模型在训练数据中学习到的模式不准确,或者是因为模型过于自信地推广了有限的上下文信息。

### 解决方案:

1. **数据清洗和增强**:

- 确保训练数据的质量和多样性,减少错误信息的暴露。

- 使用数据增强技术,如回译(back-translation)、文本简化等,以提高模型的泛化能力。

2. **知识蒸馏**:

- 将大型模型的知识蒸馏到较小的模型中,同时尽量保留其性能,以减少模型的复杂性,从而可能减少幻觉。

3. **外部知识库**:

- 集成外部知识库或事实数据库,使模型在生成文本时能够引用准确的事实信息。

4. **事实检查和验证**:

- 在模型输出后,使用事实检查机制来验证其准确性。

- 开发专门的验证模型或工具,用于检测和纠正幻觉。

5. **改进模型架构**:

- 设计更复杂的模型架构,如多模态模型,以提高模型对上下文的理解能力。

- 引入注意力机制或其他机制来提高模型对关键信息的关注。

6. **模型微调**:

- 对模型进行特定领域的微调,以适应特定任务或领域的需求。

7. **用户交互**:

- 设计用户界面,允许用户与模型互动,提供反馈,从而帮助模型改进其输出。

8. **透明度和可解释性**:

- 提高模型决策的透明度和可解释性,使用户能够理解模型的推理过程。

9. **合规性和伦理**:

- 遵守相关的合规性和伦理标准,确保模型的输出不违反法律法规或伦理准则。

10. **持续监控和更新**:

- 持续监控模型的性能和输出,定期更新模型以反映新的数据和知识。

这些解决方案通常需要结合使用,以有效地减少模型幻觉。随着技术的发展,还可能出现新的技术和方法来进一步解决这个问题。

-

大模型的 Tokenizer 的实现方法及原理?

Tokenizer 是自然语言处理中的一个关键组件,它负责将原始文本转换为模型能够理解的数字表示(如词嵌入)。在大模型中,Tokenizer 的实现通常采用以下几种方法:

1. **字节对编码(Byte Pair Encoding,BPE)**:

- BPE 是一种基于字符的分割方法,它通过迭代地合并最常见的字节对来创建一个词汇表。这种方法可以有效地处理未知词汇和稀有词汇,同时减少词汇表的大小。

- BPE 的原理是首先将文本分割成单个字符,然后统计字符对的出现频率,并按照频率从高到低的顺序合并字符对。这个过程一直重复,直到达到预定的词汇表大小或合并次数。

2. **WordPiece**:

- WordPiece 是一种类似的基于频率的分割方法,它将文本分割成子词单元。WordPiece 不同于 BPE 的地方在于它可能会将单个字符作为子词的一部分进行合并。

- WordPiece 的原理是从单个字符开始,然后寻找能够最大化语料库中单词覆盖率的词块进行合并。

3. **Unigram Language Model**:

- Unigram Language Model 是一种基于概率的分割方法,它使用一个语言模型来评估不同的子词分割方式,并选择最可能的分割。

- 这种方法的原理是训练一个语言模型来预测单词的下一个字符,然后使用这个模型来找到最佳的子词边界。

4. **SentencePiece**:

- SentencePiece 是一种将句子作为单元进行编码的方法,它将整个句子编码为一个连续的整数序列,而不需要空格或分隔符。

- SentencePiece 的原理是将文本分割成句子片段,然后使用 BPE 或 Unigram LM 等方法来创建一个词汇表,最后将句子片段编码为整数序列。

在大模型中,Tokenizer 的选择和实现对于模型的性能和效率至关重要。一个良好的 Tokenizer 应该能够处理多种语言的复杂性,包括未知词汇、稀有词汇和成语等。此外,Tokenizer 还应该能够处理不同的文本输入,如长文本、短文本和噪声文本。

-

ChatGLM3 的词表实现方法?

ChatGLM3 是一个大型的自然语言处理模型,它使用了一种称为“词嵌入”(word embeddings)的技术来将文本数据转化为模型可以理解和处理的数值形式。在词嵌入中,每个单词都被分配一个唯一的向量,这个向量捕捉了单词的语义信息。

词表(vocabulary)是实现词嵌入的关键组成部分。词表是一个包含所有可能单词的列表,每个单词在列表中都有一个唯一的索引。模型使用这个索引来查找每个单词对应的向量。

以下是 ChatGLM3 的词表实现方法的一般步骤:

- 数据预处理:首先,需要对原始文本数据进行预处理,包括分词、去除停用词、文本清洗等。分词是将文本切分成单个单词或词组的过程,这是构建词表的基础。

- 构建词表:从预处理后的文本数据中,提取所有唯一的单词,并按照一定的顺序(如字母顺序)构建词表。词表中的每个单词都有一个唯一的索引。

- 生成词嵌入矩阵:根据词表的大小,生成一个词嵌入矩阵。矩阵的每一行都对应词表中的一个单词,表示该单词的词嵌入向量。这些向量可以通过无监督学习方法(如 Word2Vec、GloVe 等)从大量文本数据中学习得到。

- 文本编码:在模型训练或推理时,将输入的文本数据转换为词表中的索引序列。这通常通过查找每个单词在词表中的索引来实现。然后,将这些索引转换为对应的词嵌入向量,作为模型的输入。

需要注意的是,由于 ChatGLM3 是一个大型模型,其词表可能包含数十万甚至上百万个单词。因此,对于不在词表中的单词(即未知词),模型通常会采用一些特殊的处理方法,如将其映射到一个特定的“未知词”标记,或者使用某种策略来生成这些词的词嵌入向量。

此外,为了提高模型的性能和效率,词嵌入矩阵通常会采用一些优化策略,如量化、压缩等。这些策略可以在减少模型存储和计算需求的同时,保持模型的性能。

-

GPT3、LLAMA、Chatglm 的Layer Normalization的区别是什么?各自的优缺点是什么?

GPT-3、LLAMA 和 ChatGLM 是不同公司开发的大型语言模型,它们在 Layer Normalization 的实现上可能会有所不同。Layer Normalization 是一种在深度学习模型中常用的归一化技术,旨在稳定模型的训练过程。下面是它们在 Layer Normalization 方面的可能区别以及各自的优缺点:

1. **GPT-3**:

- GPT-3 是由 OpenAI 开发的,它使用了 Post-Layer Normalization 技术。

- **优点**:Post-Layer Normalization 可以提高模型训练的稳定性,尤其是在处理深层网络时。

- **缺点**:可能会增加计算复杂度,因为归一化是在每个层的激活函数之后进行的。

2. **LLAMA**:

- LLAMA 是由 Meta AI 开发的,关于其 Layer Normalization 的具体实现细节不太清楚,但通常大型模型会采用类似于 GPT-3 的 Layer Normalization 技术。

- **优点**:如果 LLAMA 采用 Post-Layer Normalization,那么它也可能享受到训练稳定性的提升。

- **缺点**:同样可能会面临计算复杂度增加的问题。

3. **ChatGLM**:

- ChatGLM 是由智谱 AI 公司开发的,关于其 Layer Normalization 的具体实现细节也不太清楚。不过,考虑到它是针对中文语言特点进行优化的模型,它可能会采用一些特定的技术来提高处理中文文本的效率。

- **优点**:如果 ChatGLM 对 Layer Normalization 进行了优化,那么它可能会在处理中文文本时表现得更好。

- **缺点**:特定的优化可能会限制模型在其他语言或任务上的泛化能力。

总的来说,Layer Normalization 在这些大型语言模型中起着关键作用,有助于提高训练稳定性和模型性能。不同的实现方法可能会在计算复杂度、训练稳定性以及模型泛化能力方面有所不同。具体的选择取决于模型的特定需求和设计目标。

-

大模型常用的激活函数有那些?

1. **ReLU (Rectified Linear Unit)**:

- 公式:f(x) = max(0, x)

- 优点:计算简单,收敛速度快,解决了梯度消失问题。

- 缺点:可能导致“死神经元”现象,即神经元输出恒为0。

2. **Leaky ReLU**:

- 公式:f(x) = max(0.01x, x)

- 优点:解决了ReLU中“死神经元”的问题,允许较小的负值激活。

- 缺点:需要额外调整泄漏系数。

3. **ELU (Exponential Linear Unit)**:

- 公式:f(x) = { x, if x > 0; α(exp(x) - 1), otherwise }

- 优点:具有ReLU的优点,同时能够减少梯度消失问题,提供负值激活。

- 缺点:计算复杂度稍高,需要调整超参数α。

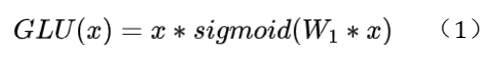

4. **Swish**:

- 公式:f(x) = x * sigmoid(x)

- 优点:无上界有下界,平滑,减少了梯度消失问题。

- 缺点:计算稍微复杂,因为包含sigmoid函数。

5. **GeLU (Gaussian Error Linear Unit)**:

- 公式:f(x) = x * Φ(x),其中Φ(x)是高斯分布的累积分布函数。

- 优点:在Transformer模型中表现良好,能够提高模型性能。

- 缺点:计算比ReLU和Swish复杂。

6. **SELU (Scaled Exponential Linear Unit)**:

- 公式:f(x) = λ { x, if x > 0; α(exp(x) - 1), otherwise }

- 优点:自归一化(self-normalizing),有助于稳定训练。

- 缺点:需要调整超参数λ和α。

7. **Softmax**:

- 公式:f(xi) = exp(xi) / sum(exp(xj)) for all j

- 优点:常用于多分类问题的输出层,输出概率分布。

- 缺点:只适用于输出层,不适用于隐藏层。

-

Multi-query Attention 与 Grouped-query Attention 是什么?区别是什么?

Multi-query Attention 和 Grouped-query Attention 是注意力机制(Attention Mechanism)的两种不同变种,它们在处理输入数据时有所不同。下面是它们的区别:

1. **Multi-query Attention**:

- Multi-query Attention 是一种注意力机制,其中每个注意力头可以关注输入数据的不同部分。这意味着每个头可以独立地学习不同的表示,从而提高模型的表达能力。

- 在 Multi-query Attention 中,每个头通常有不同的权重矩阵,使得每个头可以关注不同的特征或模式。

- **优点**:提高了模型的表达能力,允许模型同时关注多个不同的方面。

- **缺点**:可能会增加计算复杂度,因为需要对每个头分别计算注意力权重。

2. **Grouped-query Attention**:

- Grouped-query Attention 是一种注意力机制的变种,其中多个头被分组,每组头关注输入数据的不同部分。这种方法的目的是提高计算效率,通过减少注意力头的数量来减少计算复杂度。

- 在 Grouped-query Attention 中,每组头共享相同的查询(query)权重矩阵,这意味着它们关注的是输入数据的相同部分,但可能有不同的关键信息。

- **优点**:减少了计算复杂度,特别是在处理大型模型或大量数据时。

- **缺点**:可能降低了模型的表达能力,因为减少了头的数量和多样性。

总的来说,Multi-query Attention 和 Grouped-query Attention 是两种不同的注意力机制变种,它们在模型的表达能力和计算效率之间做出了不同的权衡。具体的选择取决于特定任务的需求和可用的计算资源。

-

多模态大模型有哪些?

多模态大模型是指能够处理和理解多种不同模态数据(如文本、图像、声音等)的模型。这些模型通常具有更复杂的架构,能够将不同模态的数据转换为统一的表示,从而在多种任务上表现出色。以下是一些多模态大模型的落地案例:

1. **OpenAI的DALL-E和CLIP**:

- DALL-E是一个能够根据文本描述生成图像的多模态模型。

- CLIP是一个能够将图像和文本关联起来的多模态模型,用于图像分类和检索。

2. **谷歌的PaLM**:

- PaLM是一个大型多模态模型,能够处理文本、图像和声音等多种模态的数据。

3. **百度的ERNIE-ViL**:

- ERNIE-ViL是一个多模态预训练模型,它能够同时理解文本和图像内容,用于视觉问答等任务。

这些多模态大模型在多种应用场景中展现了强大的能力,例如图像生成、图像分类、视觉问答等。它们的出现标志着人工智能领域向更广泛的应用和更高的智能化水平迈进。

大模型参数微调、训练、推理

-

为什么需要进行参选微调?参数微调的优点有哪些?

参数微调(Fine-tuning)是深度学习中的一个重要概念,特别是在自然语言处理和计算机视觉等领域。它涉及使用一个已经在大规模数据集上训练好的模型,然后在一个特定的任务上进一步训练这个模型,以便使其能够更好地解决这个特定的问题。下面是参数微调的一些优点:

1. **节省计算资源**:使用预训练模型可以节省大量的计算资源。预训练模型通常在大规模的数据集上进行了数周甚至数月的训练,如果从头开始训练一个模型,将需要同样多的时间和资源。

2. **提高性能**:预训练模型已经学到了大量关于语言或图像的一般性知识。通过在特定任务上进行微调,可以利用这些知识,通常能获得比从头开始训练更好的性能。

3. **减少过拟合风险**:对于许多特定任务,由于数据量有限,从头开始训练模型容易导致过拟合。预训练模型已经在大规模数据上学习,因此过拟合的风险较小。

4. **适应性强**:预训练模型通常能够快速适应新的任务,尤其是在与预训练任务相似的任务上。

5. **便于迁移学习**:通过微调,可以将一个模型的知识迁移到相关的任务上,这对于那些数据稀疏或者标注困难的领域尤其有用。

6. **时间效率**:微调通常只需要相对较少的时间,就可以达到令人满意的性能,这对于快速开发和部署模型非常有帮助。

参数微调是一个强大的工具,使得深度学习模型能够更加灵活和有效地应用于各种实际问题。

-

模型参数微调的方式有哪些?

模型参数微调(Fine-tuning)是深度学习中的一个重要技术,它允许我们利用在大型数据集上预训练的模型,并在特定任务或领域上进行调整以获得更好的性能。微调的方式通常有以下几种:

1. **特征提取微调**:在这种方式中,我们冻结预训练模型的绝大部分层,只微调顶部的几层或输出层。这是因为预训练模型学习到的特征在多个领域都是通用的,而顶部的层更特定于原始任务的细节。

2. **全模型微调**:与特征提取微调相反,全模型微调会调整模型的所有层。这种方法在目标数据集较大,且与预训练数据集相似时效果较好。

3. **差异学习率微调**:这种方法中,模型的不同层会有不同的学习率。通常,接近输入的层会有更低的学习率,而接近输出的层会有更高的学习率。这样可以保持模型在早期学习到的通用特征,同时允许模型针对特定任务调整其输出层。

4. **渐进式微调**:在这种技术中,首先只微调模型的顶部层,然后逐渐解冻更多的层,并调整这些层的参数。

5. **迁移学习微调**:在迁移学习中,模型在一个任务上微调后,其学到的知识被用来提高在另一个相关任务上的性能。

-

prompt tuning 和 prefix tuning 在微调上的区别是什么?

Prompt Tuning 和 Prefix Tuning 是两种针对预训练语言模型(如 GPT-3)的微调方法,它们旨在通过最小的参数调整来改善模型在特定任务上的性能。这两种方法的主要区别在于它们调整模型的方式。

**Prompt Tuning:**

Prompt Tuning 的核心思想是将下游任务重新构造为语言模型的任务,即生成任务。在 Prompt Tuning 中,模型被用来预测一系列固定的 "prompt" tokens,这些 tokens 被设计用来引导模型生成正确的输出。只有这些 prompt tokens 的参数会被更新,而预训练模型的其余部分保持不变。这种方法大大减少了需要调整的参数数量,从而降低了过拟合的风险,并使得在较小的数据集上进行微调成为可能。

**Prefix Tuning:**

Prefix Tuning 与 Prompt Tuning 类似,也是通过添加额外的 tokens 来引导模型生成正确的输出。但是,与 Prompt Tuning 不同的是,Prefix Tuning 不只是更新这些额外的 tokens,而是引入了一个可训练的连续性 "prefix" 状态,这个状态会被输入到每一层的 Transformer 自注意力模块中。这个 prefix 状态可以看作是模型的一种提示,它指导模型如何处理随后的输入。由于 prefix 状态与模型的其余部分是分离的,因此 Prefix Tuning 同样可以减少需要调整的参数数量。

**区别总结:**

- **参数更新**:Prompt Tuning 只更新 prompt tokens 的参数,而 Prefix Tuning 更新的是一个连续性的 prefix 状态。

- **参数数量**:Prompt Tuning 通常需要更新的参数更少,因为它只关注于少量的 prompt tokens。Prefix Tuning 可能需要更多的参数,取决于 prefix 状态的设计。

- **适用性**:两种方法都适用于小型数据集,但 Prefix Tuning 可能更灵活,因为它可以为每一层引入不同的 prefix 状态,而 Prompt Tuning 通常只在输入层添加 prompt tokens。

- **效果**:实验表明,Prefix Tuning 在某些任务上可能比 Prompt Tuning 更有效,尤其是在需要更深层次提示的任务上。

总的来说,Prompt Tuning 和 Prefix Tuning 都是为了减少微调时需要更新的参数数量,从而在小数据集上也能获得良好的性能。它们的主要区别在于如何构造和更新这些提示信息。

-

LLaMA-adapter 如何实现稳定训练?

LLaMA-adapter 是一种用于语言模型的微调方法,旨在通过引入少量的参数来提高模型在特定任务上的性能,同时保持预训练模型的参数大部分不变。这种方法有助于减少在少量数据上进行微调时可能出现的过拟合问题。

为了实现稳定训练,LLaMA-adapter 采用了以下策略:

1. **参数效率**:LLaMA-adapter 引入了一个小型适配器模块,该模块包含相对较少的参数。这些适配器模块被插入到预训练模型的 Transformer 层之间,使得模型可以在不大幅改变原始预训练参数的情况下适应新任务。

2. **梯度裁剪**:在训练过程中,梯度裁剪可以帮助控制模型参数的更新幅度,防止梯度爆炸,从而提高训练的稳定性。

3. **学习率调度**:使用适当的学习率调度策略,如预热(warm-up)和衰减(decay),可以帮助模型在训练初期稳定地调整参数,并在训练后期精细调整。

4. **正则化**:应用正则化技术,如权重衰减(weight decay)或dropout,可以减少模型复杂度,避免过拟合,并提高泛化能力。

5. **适配器冻结**:在训练过程中,可以先将预训练模型的参数冻结,只训练适配器模块。一旦适配器模块开始收敛,可以逐步解冻部分预训练模型的层,进行联合训练。

6. **数据增强**:使用数据增强技术,如词替换、回译等,可以增加训练数据的多样性,提高模型对变化的适应性。

7. **多任务学习**:在多任务学习的设置中,模型同时学习多个相关任务,这可以帮助模型捕获更通用的特征,提高其在单个任务上的性能。

8. **评估和早停**:在训练过程中定期评估模型在验证集上的性能,并根据验证损失或指标实现早停,以防止过拟合。

通过上述策略,LLaMA-adapter 旨在实现稳定且高效的训练,使得预训练模型能够在保持大部分参数不变的情况下,快速适应新的任务。这种方法特别适合于数据稀缺的场景,因为它减少了微调时对大量标注数据的依赖。

-

LoRA 原理与使用技巧有哪些?

LoRA微调(LoRA Tuning)是一种用于自然语言处理(NLP)任务的模型微调方法,特别是针对大型语言模型(LLMs)的微调。这种方法由Hugging Face的研究人员在2022年提出,旨在通过引入低秩适配(Low-Rank Adaptation)来提高大型语言模型的微调效率和性能。

### LoRA微调原理:

1. **低秩适配**:LoRA微调的核心思想是假设模型参数的更新可以被分解为一个低秩的矩阵和一个稀疏的向量。这样,就可以只更新这个低秩的矩阵,从而减少需要更新的参数数量。

2. **稀疏性**:在LoRA微调中,稀疏性是指只更新模型参数中的一小部分,这些部分对模型性能的提升最为关键。

3. **LoRA适配器**:LoRA微调引入了LoRA适配器,这是一种特殊的神经网络结构,用于学习低秩的参数更新矩阵。适配器通常包含两个全连接层,其中一个用于生成低秩矩阵,另一个用于生成稀疏向量。

### 使用技巧:

1. **适配器配置**:LoRA微调的关键是适配器的配置。适配器的数量、隐藏层大小和激活函数的选择都会影响微调的效果。需要根据具体的任务和模型进行调整。

2. **稀疏性控制**:LoRA微调允许通过控制稀疏性来平衡计算效率和性能。增加稀疏性可以减少需要更新的参数数量,从而提高计算效率,但可能会降低性能。

3. **正则化**:由于LoRA微调引入了额外的参数,可能需要使用正则化技术来防止过拟合。常用的正则化技术包括Dropout、权重衰减等。

4. **学习率调整**:LoRA微调可能需要调整学习率,以适应其特有的参数更新方式。可以使用较小的学习率,或者使用学习率调度策略。

5. **集成学习**:LoRA微调可以与其他微调方法结合使用,例如知识蒸馏、模型集成等,以进一步提高性能。

总的来说,LoRA微调是一种有效的模型微调方法,尤其适用于大型语言模型的微调。通过合理的配置和使用技巧,可以提高微调的效率和性能。

-

LoRA 微调优点是什么?

LoRA (Low-Rank Adaptation) 是一种用于微调预训练模型的高效方法,其主要优点包括:

1. **参数效率**:LoRA 通过引入额外的低秩矩阵来调整预训练模型的注意力层和前馈网络层,而不是直接更新原始模型的参数。这些低秩矩阵的参数数量远小于原始模型,因此可以显著减少需要训练的参数数量。

2. **减少过拟合**:由于只更新少量的参数,LoRA 可以减少在小型数据集上微调时出现的过拟合问题。这意味着模型可以在只有少量标注数据的情况下仍然保持良好的泛化能力。

3. **训练速度**:由于需要更新的参数较少,LoRA 的训练速度通常比传统的全模型微调要快。这有助于节省计算资源,并允许研究人员和工程师更快地迭代模型。

4. **易于部署**:LoRA 微调后的模型可以很容易地与原始预训练模型结合,部署时只需替换或添加少量的参数,而不需要重新部署整个模型。

5. **灵活性**:LoRA 可以灵活地应用于不同类型的预训练模型,包括 Transformer 架构的模型。它还可以轻松地与多任务学习和其他微调方法结合使用。

6. **可解释性**:LoRA 的低秩分解可以提供一定的可解释性,因为它可以被视为对原始权重矩阵的分解,其中低秩矩阵捕捉了主要的适应变化。

7. **内存效率**:由于只需要存储和更新少量的额外参数,LoRA 相比于全模型微调具有更高的内存效率。

总之,LoRA 微调方法提供了一种在保持预训练模型大部分参数不变的情况下,高效、稳定地适应新任务的途径。这种方法特别适合于资源受限的环境,如有限的标注数据、计算能力和存储资源。

-

AdaLoRA 的思路是怎么样的?

AdaLoRA(Adaptive Low-Rank Approximation)是一种优化技术,其思路在于通过自适应的低秩近似来改进深度学习模型。其核心思想是在训练过程中,根据每个参数的重要程度自动为其分配可微调参数的预算。这样,AdaLoRA能够在减少计算复杂度和内存消耗的同时,保持模型的性能。

具体来说,AdaLoRA采用奇异值分解(SVD)的形式进行参数化增量更新。SVD是一种矩阵分解技术,可以将一个矩阵分解为三个矩阵的乘积,其中一个矩阵是对角矩阵,对角线上的元素称为奇异值。在AdaLoRA中,通过对增量更新进行SVD分解,可以高效裁剪不重要更新中的奇异值,从而降低增量过程中的资源消耗。

此外,AdaLoRA还通过优化低秩近似的秩选择策略,进一步提高了算法的性能。它根据参数的重要性动态调整秩的大小,使得模型在训练过程中能够更好地适应数据的变化。

总的来说,AdaLoRA的思路是通过自适应的低秩近似和优化的秩选择策略,降低深度学习模型的计算复杂度和内存消耗,同时保持模型的性能。这种方法可以应用于各种深度学习模型,如卷积神经网络(CNN)、循环神经网络(RNN)等,有助于提高模型的训练效率和性能。

-

LoRA 权重合入chatglm模型的方法?

要将 LoRA 微调的权重合入 ChatGLM 模型,你需要遵循以下步骤:

1. **理解 ChatGLM 模型结构**:首先,你需要了解 ChatGLM 模型的架构,包括其层的类型、参数名称和连接方式。这可以通过查看模型的配置文件或源代码来实现。

2. **获取 LoRA 微调权重**:在进行 LoRA 微调后,你会得到一组新的权重,这些权重通常包括注意力层的 query、key 和 value 权重,以及前馈网络层的权重。这些权重应该是低秩分解后的结果。

3. **修改模型配置**:根据 LoRA 微调的权重,你可能需要修改 ChatGLM 模型的配置文件,以确保模型能够正确加载和使用这些权重。这可能包括添加新的层或修改现有层的参数。

4. **更新模型权重**:将 LoRA 微调得到的权重合并到 ChatGLM 模型中。这可能涉及到将低秩矩阵与原始权重矩阵相乘,然后将结果赋值给相应的模型参数。

5. **保存和加载模型**:在合并了 LoRA 微调权重后,保存更新后的模型,并确保模型可以正确加载。你可能需要编写自定义的加载逻辑来处理 LoRA 微调权重的特殊格式。

6. **测试模型性能**:在合并了 LoRA 微调权重后,你应该在验证集上测试模型的性能,以确保合并过程没有引入错误,并且模型仍然能够很好地执行任务。

请注意,这个过程可能需要你具备一定的编程技能,以及对 ChatGLM 模型和 LoRA 微调方法的深入理解。如果你不熟悉这些概念,你可能需要寻求一个有经验的开发者或研究人员的帮助。

-

P-tuning 与 P-tuning v2 区别在哪里?优点与缺点?

P-tuning是一种用于自然语言处理(NLP)任务的参数微调方法,特别是在处理Few-Shot学习场景时,即训练数据非常有限的情况下。P-tuning是由微软研究院的研究人员在2020年提出的,旨在通过引入一系列可学习的上下文参数(Prompt Tokens)来改善预训练语言模型(如GPT)的适应性。

### P-tuning的原理:

P-tuning的核心思想是将下游任务的输入转化为预训练模型能够处理的自然语言提示(Prompt)。这些提示通常是一些模板化的句子,其中包含了任务的具体信息和一些可学习的参数(Prompt Tokens)。通过微调这些Prompt Tokens,模型能够更好地理解任务并给出正确的输出。

### P-tuning v2:

P-tuning v2是P-tuning的改进版本,由同一研究团队在2021年提出。P-tuning v2在原版的基础上做了一些优化,以提高模型在Few-Shot学习场景下的性能。

#### P-tuning v2的改进:

1. **连续提示**:P-tuning v2使用连续的向量作为提示,而不是离散的Prompt Tokens。这些向量是通过一个小型的神经网络生成的,使得提示更加灵活和丰富。

2. **参数效率**:由于使用了连续的向量,P-tuning v2通常需要更少的参数来达到与P-tuning相似或更好的性能。

3. **更好的泛化能力**:连续提示可以更好地捕捉到任务之间的关联性,从而提高模型在未见过的任务上的泛化能力。

### 优点:

- **灵活性**:P-tuning和P-tuning v2都提供了灵活的提示机制,使预训练模型能够适应不同的任务。

- **性能提升**:在Few-Shot场景下,这两种方法都能显著提高模型的性能。

- **减少对大量标注数据的依赖**:通过精心设计的提示,可以在没有大量标注数据的情况下训练模型。

### 缺点:

- **提示设计**:提示的设计对性能有很大影响,需要专业知识来设计有效的提示。

- **计算成本**:虽然P-tuning v2在参数效率上有所改进,但生成连续提示的额外神经网络可能会增加计算成本。

- **模型复杂性**:引入额外的可学习参数可能会增加模型的复杂性,使得训练和调试更加困难。

总的来说,P-tuning和P-tuning v2都是针对Few-Shot学习场景的有力工具,它们通过改进预训练模型的适应性来提高其在有限数据上的性能。P-tuning v2在P-tuning的基础上进一步提高了参数效率和泛化能力,但同时也带来了一些额外的计算成本和模型复杂性。

-

为什么SFT之后感觉LLM表现变差?

在进行了监督微调(Supervised Fine-Tuning,SFT)之后,如果感觉大型语言模型(Large Language Models,LLMs)的表现变差,可能是由以下几个原因造成的:

1. **过拟合**:SFT通常是在一个比预训练数据集小得多的特定任务数据集上进行的。这可能会导致模型过拟合,即模型学会了特定数据集的细节,而失去了泛化到新数据或不同任务的能力。过拟合的模型在训练数据上表现良好,但在未见过的数据上表现不佳。

2. **数据质量**:SFT的效果很大程度上取决于微调时使用的数据质量。如果微调数据包含错误、噪声或不相关的信息,模型可能会学习这些不良模式,从而导致性能下降。

3. **数据分布偏移**:如果微调数据与模型预训练时使用的数据分布不一致,模型可能难以适应新的分布。这种分布偏移会导致模型在新数据上的性能下降。

4. **灾难性遗忘**:在SFT过程中,模型可能会“忘记”在预训练阶段学到的知识,尤其是当微调数据量较小或与预训练任务差异很大时。这种现象被称为灾难性遗忘。

5. **微调策略不当**:微调策略,包括学习率、批次大小、训练轮数等,都需要根据具体任务和数据集进行调整。如果微调策略选择不当,可能会导致模型性能下降。

6. **模型复杂性**:对于非常复杂的模型,微调可能需要更多的数据和更精细的调整策略。如果这些条件没有得到满足,模型可能会出现性能下降的情况。

为了解决这些问题,可以尝试以下方法:

- **使用更多的数据**:增加微调数据量可以帮助模型更好地泛化。

- **数据增强**:通过数据增强技术,如回译、同义词替换等,可以增加数据的多样性。

- **正则化技术**:应用正则化,如权重衰减、dropout等,可以减少过拟合。

- **学习率调度**:使用适当的学习率调度策略,如预热和衰减,可以帮助模型更好地收敛。

- **微调策略调整**:根据任务和数据集的特点调整微调策略。

- **模型集成**:使用多个模型的集成可能有助于提高性能。

总之,SFT之后模型性能下降可能是由于多种因素造成的。理解这些因素并采取相应的措施可以帮助改善模型的表现。

-

垂直领域数据训练后,通用能力往往会有所下降,如何缓解模型遗忘通用能力?

在垂直领域数据上训练模型后,确实可能会出现模型在通用领域的能力下降的现象,这被称为“灾难性遗忘”(catastrophic forgetting)。为了缓解这一问题,可以采取以下几种策略:

1. **连续学习(Continual Learning)**:

- **弹性权重共享(Elastic Weight Consolidation, EWC)**:通过在模型更新时施加惩罚,保留对旧任务重要的权重。

- **经验重放(Experience Replay)**:存储旧任务的样本并在学习新任务时重放,以保持模型对旧任务的能力。

- **梯度裁剪(Gradient Clipping)**:限制梯度的大小,以减少对旧任务参数的影响。

2. **多任务学习(Multi-Task Learning)**:

- 同时训练模型在多个任务上表现良好,这样模型可以学习到不同任务之间的通用特征。

3. **参数隔离(Parameter Isolation)**:

- 为不同任务或领域分配不同的模型参数,确保在一个领域上的更新不会影响到其他领域。

4. **动态扩展(Dynamic Expansion)**:

- 随着新任务的加入,动态增加模型的容量,以容纳新的知识和保持旧知识。

5. **任务特定适配器(Task-Specific Adapters)**:

- 在预训练模型的顶部添加小的适配器模块,这些适配器专门为新任务学习,而不改变预训练模型的参数。

6. **提示引导(Prompt Tuning)**:

- 使用提示工程来引导模型在新任务上的表现,同时保持其通用能力。

7. **知识蒸馏(Knowledge Distillation)**:

- 将大型模型的知识蒸馏到一个小型模型中,这样小型模型可以保留大型模型的大部分能力。

8. **周期性复习(Periodic Review)**:

- 定期在通用数据上对模型进行微调,以刷新其通用知识。

9. **领域自适应(Domain Adaptation)**:

- 使用领域自适应技术,如对抗性训练,使模型能够在新领域上泛化,同时保留在源领域上学到的知识。

10. **元学习(Meta-Learning)**:

- 通过元学习训练模型,使其能够快速适应新任务,同时保持对旧任务的知识。

选择哪种策略取决于具体的应用场景、可用的数据和资源。在实际应用中,可能需要组合多种策略以达到最佳效果。

-

进行SFT操作的时候,基座模型选用Chat还是Base?

在进行监督微调(Supervised Fine-Tuning,SFT)操作时,选择基座模型(backbone model)的版本(如 Chat 或 Base)取决于多个因素,包括你的具体任务需求、可用资源、以及对模型性能的期望。以下是一些选择基座模型时可能考虑的因素:

1. **性能需求**:如果任务需要更高的语言理解能力和生成质量,通常选择更大、更先进的模型版本(如 Chat)。这些模型通常在更多的数据上进行了预训练,并可能包含了一些额外的训练技巧或架构改进。

2. **计算资源**:较大的模型需要更多的计算资源进行微调。如果你的计算资源有限,选择一个较小的 Base 版本可能更合适。这将减少训练时间和成本,同时也可能减少过拟合的风险。

3. **数据量**:如果你的微调数据集较小,使用一个较小的 Base 模型可能更合适,因为较大的模型可能会在小型数据集上过拟合。

4. **泛化能力**:在某些情况下,较小的 Base 模型可能具有更好的泛化能力,尤其是在预训练数据和微调数据之间存在较大分布偏移时。

5. **应用场景**:考虑你的应用场景。如果模型将在对生成质量要求不高的场景中使用,如聊天机器人或简单的文本分类任务,Base 模型可能就足够了。如果应用场景要求更高的语言理解能力和创造性,如撰写文章或生成代码,则可能需要 Chat 版本。

6. **成本和预算**:较大的模型可能需要更高的运行成本,包括计算资源和能源消耗。如果你的预算有限,这可能会影响你的选择。

在实际操作中,你可能需要根据上述因素进行权衡,并可能需要通过实验来确定哪个版本的模型在你的特定任务上表现最佳。通常,从 Base 版本开始进行初步实验是一个不错的选择,因为它的资源需求较低。如果你发现 Base 版本无法满足你的性能需求,再考虑升级到 Chat 版本。

-

领域模型词表扩增是不是有必要?

领域模型词表扩增是一个根据特定应用场景需求来决定的过程。在某些情况下,扩增词表是有必要的,而在其他情况下则可能不是必需的。以下是一些考虑因素:

### 需要进行词表扩增的情况:

1. **领域特定词汇**:如果模型需要处理特定领域的文本,如医学、法律或工程等专业领域,其中包含大量的专业术语和缩写,那么扩增词表以确保模型能够理解这些术语是有益的。

2. **新词或流行词汇**:随着时间的推移,新的词汇和流行词汇会不断出现。对于需要处理最新数据的模型,更新词表以包含这些新词是必要的。

3. **多语言或方言**:对于需要处理多种语言或方言的模型,扩增词表以包含不同语言和方言的词汇是重要的。

4. **提高准确性**:在某些情况下,扩增词表可以提高模型的准确性,尤其是在处理那些具有大量未知词汇的文本时。

### 不需要进行词表扩增的情况:

1. **通用模型**:如果模型是为了处理通用的日常语言而设计的,且已经包含了足够丰富的词汇量,那么扩增词表可能不是必要的。

2. **资源限制**:扩增词表可能会增加模型的复杂性和资源需求,如内存和处理时间。如果资源有限,可能需要权衡是否扩增词表。

3. **数据分布**:如果训练数据和实际应用场景中的数据分布相似,且已经包含了所有必要的词汇,那么扩增词表可能不是必需的。

### 词表扩增的方法:

如果决定扩增词表,可以采用以下方法:

- **基于频率的筛选**:根据领域数据中的词汇频率,选择出现频率较高的词汇加入词表。

- **专业词典和术语库**:利用专业词典和术语库来扩增词表,确保覆盖领域内的专业术语。

- **用户反馈**:根据用户的反馈和实际应用中的错误来识别缺失的词汇,并动态地更新词表。

总之,是否进行领域模型词表扩增取决于模型的应用场景和需求。在做出决定时,需要权衡模型的性能、资源限制和实际应用中的数据分布。

-

训练中文大模型的经验和方法

训练中文大型模型需要大量的数据、计算资源和精细的工程实践。以下是一些训练中文大型模型的经验和方法:

1. **数据收集与处理**:

- **数据质量**:确保训练数据的质量。低质量或错误的数据可能会导致模型学习不良模式。

- **数据多样性**:使用来自不同来源、不同风格和不同主题的数据,以提高模型的泛化能力。

- **数据清洗**:去除噪声、重复和无关的内容,以及可能的敏感信息。

- **数据平衡**:确保数据在不同类别或任务上平衡,以避免模型偏向某一类别。

2. **模型选择**:

- **预训练模型**:可以选择一个已经在大量中文数据上预训练的模型作为起点,如BERT、GPT等。

- **模型架构**:根据任务需求选择合适的模型架构,如Transformer、RNN等。

3. **训练策略**:

- **学习率调度**:使用适当的学习率调度策略,如预热、衰减等,以帮助模型稳定收敛。

- **正则化**:应用正则化技术,如权重衰减、dropout等,以减少过拟合。

- **梯度裁剪**:对于非常深的模型,梯度裁剪有助于稳定训练过程。

- **批量大小**:根据GPU内存和模型大小选择合适的批量大小。

4. **评估与调试**:

- **监控训练指标**:定期评估模型在验证集上的性能,以便及时发现潜在的过拟合或其他问题。

- **错误分析**:分析模型在验证集上的错误,以指导后续的训练和调整。

5. **资源管理**:

- **分布式训练**:使用分布式训练技术,如数据并行、模型并行等,以加快训练速度和处理大型模型。

- **硬件选择**:根据模型大小和预算选择合适的硬件,如GPU或TPU。

6. **微调与适应**:

- **任务特定微调**:在特定任务上对模型进行微调,以提高其在特定领域的性能。

- **迁移学习**:利用在相关任务上预训练的模型,通过迁移学习来提高模型在新任务上的性能。

7. **合规性与伦理**:

- **数据合规性**:确保训练数据的使用符合相关法律法规和伦理标准。

- **模型输出控制**:采取措施确保模型输出不会产生有害或不适当的内容。

训练中文大型模型是一个复杂的过程,需要跨学科的知识和技能。在实践中,可能需要多次实验和调整,以找到最佳的训练策略和模型配置。此外,随着技术的发展,新的训练技术和方法也在不断涌现,因此保持对新技术的关注和学习也是提高模型性能的关键。

-

模型微调用的什么模型?模型参数是多少?微调模型需要多大显存?

模型微调通常是指在预训练模型的基础上,使用特定领域的数据对模型进行进一步的训练,以适应特定的任务或领域。微调使用的模型类型和参数数量取决于多种因素,包括预训练模型的选择、目标任务的需求、可用的计算资源等。

### 常用的预训练模型:

1. **BERT (Bidirectional Encoder Representations from Transformers)**:Google开发的预训练模型,有多种尺寸,如BERT-Base有1.1亿参数,BERT-Large有3.4亿参数。

2. **RoBERTa (A Robustly Optimized BERT Pretraining Approach)**:Facebook开发的BERT变体,也有多种尺寸,如RoBERTa-Base有1.35亿参数,RoBERTa-Large有3.5亿参数。

3. **GPT (Generative Pretrained Transformer)**:OpenAI开发的生成型预训练模型,GPT-3是其第三代,有1750亿参数。

4. **XLNet (Generalized Autoregressive Pretraining for Language Understanding)**:CMU和Google开发的模型,XLNet-Large有2.25亿参数。

5. **ALBERT (A Lite BERT)**:Google开发的轻量级BERT变体,ALBERT-xxlarge有12亿参数。

### 微调模型需要的显存:

显存需求取决于以下几个因素:

1. **模型大小**:更大的模型需要更多的显存来存储模型参数和中间激活。

2. **批量大小(Batch Size)**:批量大小决定了每次迭代中处理的样本数量,批量越大,显存需求越高。

3. **序列长度(Sequence Length)**:输入序列越长,显存需求也越高。

4. **显存优化技术**:如梯度累积、混合精度训练等可以减少显存使用。

例如,微调一个BERT-Base模型,如果使用批量大小为32,序列长度为128,那么在单精度浮点数(FP32)下,大约需要4-6GB的显存。如果是BERT-Large模型,同样的设置可能需要12-16GB的显存。这些估计值是大致数字,实际显存需求可能会根据具体的实现细节和深度学习框架有所不同。

为了确保微调过程顺利进行,建议使用具有足够显存的显卡,并根据实际情况调整批量大小和序列长度,或者采用显存优化技术来降低显存需求。

-

预训练和SFT操作有什么不同?

预训练(Pre-training)和监督微调(Supervised Fine-Tuning,SFT)是深度学习模型训练中的两个不同阶段,它们在目标、数据使用和训练方法上有所区别:

1. **目标**:

- **预训练**:预训练的目的是让模型学习到通用的语言特征和知识,以便在后续的任务中能够快速适应。预训练通常在大规模、多样化的语料库上进行,如维基百科、书籍、新闻文章等。

- **SFT**:监督微调的目标是针对特定的任务或领域,对预训练模型进行进一步的训练,使其能够更好地解决这些具体的问题。SFT通常在特定任务的有标签数据集上进行。

2. **数据使用**:

- **预训练**:使用的是无标签或弱标签的数据,模型通过自监督学习任务(如语言建模、掩码语言建模、下一句预测等)来学习语言规律。

- **SFT**:使用的是与特定任务相关的有标签数据,模型通过有监督的学习来优化针对该任务的性能。

3. **训练方法**:

- **预训练**:模型从随机初始化开始,通过大量的数据学习语言的深层表示。这个阶段的训练通常需要大量的计算资源和时间。

- **SFT**:模型基于预训练的权重进行微调,只需要调整模型的部分参数,通常在较小的数据集上进行训练。这个阶段的训练计算成本较低,时间也相对较短。

4. **模型调整**:

- **预训练**:模型可能会经历多个阶段的预训练,每个阶段都可能会调整模型结构或训练目标。

- **SFT**:在微调阶段,模型的架构通常保持不变,但最后一层或几层的输出层会根据任务的特定需求进行调整,如分类任务的输出层神经元数量会与类别数相匹配。

总结来说,预训练是让模型学习通用知识的过程,而SFT是在特定任务上对模型进行定制化的过程。预训练提供了模型泛化的基础,而SFT则优化了模型在特定任务上的性能。在实际应用中,这两个阶段通常是相互补充的,预训练模型通过SFT来适应各种下游任务。

-

训练一个通用大模型的流程有哪些?

训练一个通用大模型(如BERT、GPT等)是一个复杂的过程,涉及到大量的数据预处理、模型设计、训练、评估和调优。以下是训练通用大模型的一般流程:

1. **需求分析**:

- 确定模型的目标应用场景和性能指标。

- 分析所需的计算资源和预计的训练时间。

2. **数据收集**:

- 收集大量的文本数据,这些数据通常来自互联网,包括书籍、文章、网页等。

- 确保数据多样性和质量,避免偏见和版权问题。

3. **数据预处理**:

- 清洗数据:去除噪声、错误和不相关的信息。

- 分词:将文本分割成单词、子词或字符。

- 标记化:将文本转换为模型可以理解的数字表示形式。

- 数据增强:通过诸如词替换、句子重组等方法增加数据的多样性。

4. **模型设计**:

- 选择合适的模型架构,如Transformer。

- 确定模型的超参数,如层数、隐藏单元数、注意力头的数量等。

5. **预训练**:

- 使用无监督或自监督学习方法对模型进行预训练。

- 选择预训练任务,如掩码语言模型(MLM)、下一句预测(NSP)等。

- 在大型计算集群上训练模型,这可能需要几天到几周的时间。

6. **模型评估**:

- 在预训练完成后,使用一组标准的评估任务来评估模型的性能。

- 评估指标可能包括语言理解、文本生成、句子分类等。

7. **微调**:

- 使用特定领域的标注数据对模型进行微调,以适应特定的任务。

- 微调可能涉及到调整模型的部分层或添加新的输出层。

8. **模型调优**:

- 根据微调的结果调整超参数和训练策略。

- 使用交叉验证、网格搜索等方法找到最佳的超参数组合。

9. **模型部署**:

- 将训练好的模型部署到生产环境中。

- 实现模型的推理接口,以便在实际应用中使用。

10. **监控和维护**:

- 监控模型的性能和稳定性。

- 定期使用新数据对模型进行再训练或微调,以保持模型的时效性。

训练通用大模型是一个迭代的过程,可能需要多次调整和优化才能达到满意的性能。此外,由于训练大模型需要大量的计算资源,因此通常需要使用分布式训练和高效的计算技术来加速训练过程。

-

DDO 与 DPO 的区别是什么?

DDO 和 DPO 是两个不同的概念,分别代表数据驱动运营(Data-Driven Operations)和数据保护官(Data Protection Officer)。

**数据驱动运营(DDO)**:

数据驱动运营是一种管理实践,它依赖于数据分析来指导业务决策和运营流程。在这种模式下,组织使用数据来优化流程、提高效率、降低成本、增强客户体验和增加收入。数据驱动运营通常涉及以下几个方面:

- 数据收集:从各种来源收集相关数据。

- 数据分析:使用统计分析、数据挖掘和机器学习技术来分析数据。

- 决策支持:基于数据分析的结果来做出更明智的决策。

- 执行与优化:根据数据分析的洞察来执行操作并不断优化流程。

**数据保护官(DPO)**:

数据保护官是欧盟通用数据保护条例(GDPR)引入的一个角色,主要负责确保组织在处理个人数据时遵守相关的数据保护法规。DPO的职责包括:

- 监督和指导组织的数据保护合规工作。

- 为组织提供关于数据保护法律和政策的专业建议。

- 管理个人数据泄露的响应和通知过程。

- 作为监管机构和数据主体之间的联络点。

总结来说,DDO关注的是如何利用数据来改善业务运营和决策,而DPO则是一个法律合规角色,负责确保组织在处理个人数据时遵守相关的数据保护法规。两者都与数据相关,但关注的焦点和应用领域不同。

-

embeding 模型的微调方法

嵌入模型(embedding models)的微调是自然语言处理(NLP)和推荐系统等领域的常见做法。嵌入模型通常用于将单词、句子、文档或其他类型的数据映射到高维空间中的低维向量,其中相似的实体在向量空间中彼此靠近。

嵌入模型的微调方法通常包括以下步骤:

1. **预训练嵌入**:

- 使用大规模语料库通过无监督学习(如Word2Vec、GloVe)或预训练模型(如BERT)来训练嵌入。

2. **初始化模型**:

- 使用预训练的嵌入作为模型的一部分来初始化,例如,将单词嵌入作为神经网络的第一层。

3. **冻结嵌入**:

- 在微调过程的初期,可能选择冻结嵌入层,让模型的其他部分适应特定任务。

- 这有助于避免在训练数据较少时过拟合,并利用预训练嵌入的通用性。

4. **部分微调**:

- 在某些情况下,可以选择只微调嵌入层的一部分,而不是所有的嵌入。

- 这可以通过设置不同的学习率或在某些嵌入上应用更小的权重更新来实现。

5. **完全微调**:

- 如果有足够的训练数据和计算资源,可以选择微调所有的嵌入,包括预训练的嵌入。

- 这允许模型调整嵌入以更好地适应特定任务。

6. **动态更新**:

- 对于一些在线学习场景,模型可能会动态地更新嵌入,以反映新的数据和趋势。

7. **评估和迭代**:

- 定期评估模型的性能,并根据需要调整微调策略。

- 可能需要多次迭代来找到最佳的微调方法。

微调嵌入模型的关键是找到预训练嵌入的通用性和特定任务数据之间的平衡。微调的目的是调整嵌入,使其在特定任务上表现更好,同时保留其在通用语言理解方面的优势。

-

有哪些节省内存的大语言模型训练/微调/推理方法?

在处理大型语言模型时,内存使用是一个重要的考虑因素。以下是一些减少内存使用的方法,这些方法可以应用于模型的训练、微调和推理阶段:

1. **模型剪枝**:

- **权重剪枝**:去除模型中不重要的权重,减少模型的参数数量。

- **注意力头剪枝**:在 Transformer 模型中,剪除一些注意力头。

2. **知识蒸馏**:

- 将一个大型模型(教师模型)的知识蒸馏到一个较小的模型(学生模型)中,从而减少内存占用。

3. **参数共享**:

- 在模型的不同部分之间共享参数,减少总体参数数量。

4. **低秩分解**:

- 使用低秩分解技术来减少参数的数量,例如 LoRA 微调方法。

5. **量化**:

- 将模型的权重和激活从浮点数转换为低比特宽度的整数,减少内存使用并可能加速推理。

6. **使用高效的模型架构**:

- 选择内存效率更高的模型架构,如 Longformer 或 Reformer,它们设计了特定的机制来减少注意力机制的内存和计算成本。

7. **层叠式训练**:

- 先训练模型的一部分,然后冻结这些参数,再训练其他部分。

8. **梯度检查点**:

- 在训练过程中,通过重新计算而非存储中间激活来节省内存。

9. **使用分布式训练**:

- 通过将模型分布在多个设备上,可以减少单个设备上的内存压力。

10. **动态推理**:

- 在推理时,根据输入动态调整模型的计算,例如,只处理输入文本的相关部分。

11. **优化数据加载和批处理**:

- 在训练时,优化数据加载和批处理过程,减少内存峰值。

12. **使用更高效的库和工具**:

- 使用为内存效率设计的深度学习库和工具,如 PyTorch 的内存优化功能。

13. **模型架构搜索(NAS)**:

- 使用自动化的方法来搜索内存效率更高的模型架构。

这些方法可以单独使用,也可以组合使用,以达到更好的内存优化效果。在实际应用中,选择哪种方法取决于具体的需求、资源和任务目标。

-

大模型(LLMs)评测有那些方法?如何衡量大模型的效果?

大模型(Large Language Models,LLMs)的评测通常涉及多个维度,包括模型的性能、泛化能力、鲁棒性、效率以及伦理和安全性等方面。以下是一些常用的评测方法和衡量效果的方式:

1. **性能指标**:

- **准确率**:对于分类任务,衡量模型正确分类的比例。

- **损失函数**:使用交叉熵损失、均方误差等来衡量模型输出与真实值之间的差距。

- **困惑度(Perplexity)**:衡量模型对语言数据的建模能力,通常用于语言模型。

2. **泛化能力**:

- **零样本学习(Zero-shot learning)**:评估模型在不提供特定任务样本的情况下处理新任务的能力。

- **少样本学习(Few-shot learning)**:评估模型在只提供少量样本的情况下学习新任务的能力。

- **跨领域泛化**:评估模型在不同领域数据上的表现。

3. **鲁棒性**:

- **对抗性测试**:评估模型对输入数据微小扰动的抵抗力。

- **稳健性**:评估模型在处理噪声数据、错误数据或异常值时的性能。

4. **效率指标**:

- **计算成本**:评估模型训练和推理所需的计算资源。

- **参数效率**:衡量模型性能与参数数量之间的关系。

- **推理速度**:评估模型处理单个样本的速度。

5. **伦理和安全性**:

- **偏见和公平性**:评估模型输出是否存在性别、种族、文化等偏见。

- **隐私保护**:评估模型在处理敏感数据时的隐私保护措施。

- **可解释性和透明度**:评估模型的决策过程是否可解释和透明。

6. **人类评估**:

- **人工评审**:使用人类评估者来评估模型的输出质量。

- **用户研究**:通过用户实验来评估模型在实际应用中的表现。

7. **标准和基准测试**:

- **GLUE (General Language Understanding Evaluation)**:一套用于评估自然语言理解能力的基准测试。

- **SuperGLUE (Super General Language Understanding Evaluation)**:GLUE的升级版,包含更具挑战性的任务。

- **SQuAD (Stanford Question Answering Dataset)**:用于评估机器阅读理解和问答能力的基准。

8. **特定任务评估**:

- **文本生成**:使用评价指标如BLEU、ROUGE、METEOR等来衡量生成文本的质量。

- **机器翻译**:使用评价指标如BLEU、TER (Translation Edit Rate)等来评估翻译质量。

衡量大模型的效果通常需要综合使用上述多种方法,并根据具体的应用场景和任务需求来选择合适的评价指标。此外,随着大模型的发展,新的评测方法和标准也在不断出现,以适应模型的进步和应用的多样化。

-

如何解决三个阶段的训练(SFT->RM->PPO)过程较长,更新迭代较慢问题?

三个阶段的训练流程——监督微调(Supervised Fine-Tuning,SFT)、奖励建模(Reward Modeling,RM)和近端策略优化(Proximal Policy Optimization,PPO)——是一个典型的强化学习(RL)任务流程,其中每个阶段都有其特定的目的和挑战。如果你发现这个过程较长,更新迭代较慢,可以考虑以下策略来加速训练:

1. **并行处理**:

- 在多个环境中并行运行模型,收集更多的数据用于训练。

- 使用并行计算资源,如GPU或TPU集群,来加速模型的训练和推理。

2. **批量训练**:

- 增加训练批次的大小,以利用现代GPU的并行处理能力。

3. **高效模型架构**:

- 使用内存和计算效率更高的模型架构,如Transformer的变体Longformer或Reformer。

4. **迁移学习和微调**:

- 使用预训练的模型作为起点,而不是从头开始训练,可以节省时间。

- 在新数据上微调模型,而不是完全重新训练。

5. **早期停止**:

- 实施早期停止策略,当模型性能不再显著提升时停止训练。

6. **周期性训练**:

- 定期对模型进行训练,而不是连续不断地训练,可以将训练时间分散到多个时间段。

7. **动态调整学习率**:

- 使用自适应学习率调整策略,如学习率衰减或循环学习率,以加速收敛。

8. **模型剪枝和量化**:

- 剪枝和量化模型可以减少模型的大小和计算需求,从而加速训练和推理。

9. **使用高效的优化器**:

- 选择合适的优化器,如AdamW或Adamax,它们可能比传统的SGD更快地收敛。

10. **数据预处理和增强**:

- 在训练前对数据进行预处理和增强,以提高模型的泛化能力和训练效率。

11. **分布式训练**:

- 使用分布式训练框架,如Ray或PyTorch Distributed,来同时训练多个模型或并行处理数据。

12. **选择性更新**:

- 只更新模型的一部分,而不是整个模型,可以减少每次迭代的计算量。

13. **使用预定义的任务和模板**:

- 对于特定的RL任务,使用预定义的任务和模板可以减少设计新任务所需的时间。

通过上述策略,你可以优化三个阶段的训练流程,减少每个阶段的训练时间,从而加快模型的更新和迭代速度。在实际应用中,可能需要根据具体的任务需求和可用资源,组合使用多种策略来达到最佳的训练效果。

-

模型训练的数据集问题:一般数据集哪里找?

获取模型训练数据集的途径有很多,具体取决于数据集的类型和应用领域。以下是一些常见的数据集来源:

1. **公共数据集**:

- **政府机构和学术机构**:许多政府机构和学术机构会公开大量的数据集,例如美国国家标准与技术研究院(NIST)、欧盟的开放数据门户等。

- **开放数据平台**:如Kaggle、Google Dataset Search、UCI Machine Learning Repository、AWS Public Dataset Program等提供各种领域的开放数据集。

2. **专业领域数据集**:

- **科研论文**:科研论文中经常包含数据集的描述和链接,尤其是那些发表在顶级会议和期刊上的论文。

- **专业社区和论坛**:如GitHub、ResearchGate等,研究人员和从业者会分享他们的数据和代码。

3. **社交媒体和网络爬虫**:

- **社交媒体平台**:如Twitter、Facebook等提供API接口,可以用于获取公共数据。

- **网络爬虫**:可以使用爬虫工具如Scrapy、BeautifulSoup等,从网站上爬取数据。

4. **商业数据集**:

- **数据交易平台**:如Acxiom、Experian等提供商业数据。

- **API服务**:如Twitter API、YouTube API等,提供丰富的数据资源。

5. **合作伙伴和私有数据**:

- **企业内部数据**:企业可能拥有自己的数据集,可以用于训练模型。

- **合作伙伴数据**:与其他公司或组织合作,共同开发数据集。

6. **数据竞赛和挑战**:

- **Kaggle、Drivendata等平台**:举办各种数据科学和机器学习竞赛,提供数据集供参赛者使用。

7. **开源项目**:

- **GitHub**:许多开源项目会附带数据集,或者提供获取数据集的指南。

在选择数据集时,需要考虑数据的质量、大小、多样性、覆盖范围、标注情况以及使用许可等因素。此外,还需要确保数据的使用符合相关的法律法规和伦理标准。对于特定的研究领域或应用场景,可能还需要对数据集进行进一步的预处理和清洗以满足模型训练的需求。

-

为什么需要进行模型量化及原理?

模型量化是一种将模型的权重和/或激活从浮点数(通常是32位或16位浮点数)转换为低比特宽度的整数(如8位、4位或2位整数)的技术。这种转换可以显著减少模型的内存占用和计算成本,同时在保持可接受性能的情况下,提高模型的推理速度。以下是一些进行模型量化的原因和基本原理:

### 为什么要进行模型量化?

1. **减少内存占用**:

- 量化可以减少模型的大小,因为整数占用的空间比浮点数少。这对于需要在内存受限的设备上部署模型非常有用。

2. **提高推理速度**:

- 整数运算通常比浮点运算快,尤其是在没有专门浮点运算单元的硬件上。量化后的模型可以在更短的时间内完成推理。

3. **降低功耗**:

- 低比特宽度的整数运算通常需要更少的能量,这使得量化模型在移动设备上更加节能。

4. **硬件优化**:

- 一些硬件平台(如ASIC、FPGA)针对整数运算进行了优化,量化可以使模型更好地利用这些平台的性能。

### 模型量化的原理

模型量化基于以下原理:

1. **数值范围限定**:

- 通过将浮点数的范围映射到整数范围,例如将[-1, 1]区间映射到[-128, 127](对于8位量化)。

2. **量化级别**:

- 量化级别定义了可表示的值的数量。例如,8位量化有256个不同的值,而16位量化有65536个不同的值。

3. **量化粒度**:

- 量化粒度是两个可表示值之间的差值。在8位量化中,量化粒度是1/256。

4. **量化误差**:

- 量化引入了量化误差,因为浮点数被近似为最接近的整数。量化误差的管理是量化过程中的关键。

5. **校准**:

- 在量化之前,通常需要进行校准步骤,以确定最佳的量化参数,如缩放因子和零点偏移。

6. **对称与非对称量化**:

- 对称量化将零点设置在量化范围的中间,而非对称量化允许零点不在中间,这可以提供更好的数值表示。

模型量化可以在训练后或训练过程中进行。后训练量化(Post-Training Quantization,PTQ)是在模型训练完成后进行的,而量化感知训练(Quantization-Aware Training,QAT)是在训练过程中结合量化操作进行的,以优化模型的量化性能。

总之,模型量化是一种有效的技术,可以在不显著牺牲性能的情况下,减少模型的内存占用和推理延迟,使其更适合在资源受限的环境中部署。

-

大模型词表扩充的方法及工具?

大模型的词表扩充是一个重要的步骤,尤其是在处理特定领域的文本或新词、流行词时。以下是一些常用的方法和工具:

### 方法:

1. **频率筛选**:

- 从大量文本中统计单词的频率,选择出现频率较高的单词加入词表。

2. **专业词典和术语库**:

- 利用专业领域的词典和术语库,将专业术语添加到词表中。

3. **用户反馈和错误分析**:

- 根据用户的反馈和模型在实际应用中的错误,识别缺失的词汇并更新词表。

4. **在线词表和语料库**:

- 利用在线词表和语料库,如WordNet、HowNet等,来扩充词表。

5. **子词和字符分割**:

- 对于未知单词,可以将其分解为子词或字符,以便模型能够处理。

### 工具:

1. **Hugging Face Transformers**:

- Hugging Face的Transformers库提供了词表扩充的功能,可以通过简单的API调用实现。

2. **spaCy**:

- spaCy是一个自然语言处理库,它提供了自定义词表的工具,可以方便地添加新词。

3. **NLTK (Natural Language Toolkit)**:

- NLTK是一个自然语言处理平台,提供了丰富的文本处理功能,包括词表扩充。

4. **gensim**:

- gensim是一个用于主题建模和词向量处理的Python库,它可以用来扩充词表。

5. **Vocabulary Builder**:

- 一些专门的词汇构建工具,可以帮助从文本中提取和分析词汇,用于词表扩充。

6. **自定义脚本**:

- 编写自定义的Python脚本,使用正则表达式、文本处理库(如re、BeautifulSoup)等来识别和提取新词。

在实际操作中,词表扩充通常需要结合多种方法和工具,以实现最佳的扩充效果。同时,需要注意词表的大小和模型的能力,过大的词表可能会导致模型效率降低。

大模型应用框架

-

什么是 LangChain?

LangChain 是一个开源的框架,旨在帮助开发者和企业构建、部署和运行基于语言模型的应用程序。它提供了一套工具和接口,用于轻松地整合大型语言模型(如 GPT-3、ChatGPT、LLaMA 等)和其他数据源(如数据库、API、文档等),以创建复杂的、交互式的语言应用。

LangChain 的主要特点包括:

1. **模型集成**:LangChain 支持多种语言模型的集成,包括 OpenAI 的 GPT-3、Hugging Face 的模型、以及自定义模型。

2. **工具集成**:LangChain 可以与各种工具和数据库集成,使得语言模型能够利用外部信息来生成更准确和有用的回答。

3. **链式思考**:LangChain 支持链式思考,即模型可以分步执行任务,每次只处理一部分信息,然后将结果传递给下一步,这在处理复杂任务时非常有用。

4. **内存管理**:LangChain 提供了内存管理功能,允许模型在对话中保持上下文记忆,这对于保持对话的一致性和连贯性至关重要。

5. **可扩展性**:LangChain 设计为可扩展的,开发者可以根据需要添加自定义功能或集成其他系统。

6. **易于部署**:LangChain 提供了简单的部署选项,支持在本地、云服务器或容器化环境中运行模型应用程序。

7. **开源社区**:作为一个开源项目,LangChain 拥有一个活跃的社区,提供大量的教程、示例和文档,以帮助开发者快速上手和使用。

LangChain 适用于各种应用场景,如聊天机器人、客户支持、数据分析、内容创作等,它简化了构建基于语言模型的应用程序的过程,使得开发者能够更加专注于应用的功能和用户体验。

-

什么是 LangChain Agent?

LangChain Agent是一个开源的框架,旨在将大型语言模型(如 GPT-3、GPT-4 等)与各种工具和API连接起来,以执行更复杂的任务。LangChain Agent通过自然语言与用户交互,并能够使用工具来获取信息、进行计算或执行其他操作,从而更好地理解用户的请求并给出更准确的回答。

LangChain Agent的核心思想是将语言模型作为决策者(agent),使用外部工具来增强其能力。例如,如果用户询问某个数据点的信息,LangChain Agent可以调用相应的API来获取数据,而不是仅依靠语言模型本身的知识。

LangChain Agent的主要特点包括:

1. **工具集成**:可以轻松地将各种工具和API集成到语言模型中,使其能够利用这些工具来执行任务。

2. **自然语言处理**:与用户的交互完全通过自然语言进行,用户无需了解任何特定的命令或查询格式。

3. **灵活性和可扩展性**:用户可以根据需要添加或自定义工具,以适应不同的应用场景。

4. **上下文保持**:LangChain Agent能够在对话中保持上下文,这意味着它可以记住之前的交互并在此基础上进行后续的操作。

5. **开源和社区支持**:作为一个开源项目,LangChain Agent拥有一个活跃的社区,用户可以共享和贡献新的工具、模型和改进。

总的来说,LangChain Agent是一个强大的框架,它将大型语言模型与外部工具和API结合起来,使其能够执行更复杂的任务,并为用户提供更丰富和准确的信息。

-

什么是 LangChain model?

"LangChain model" 可能是指在使用 LangChain 框架时所使用的语言模型。

LangChain 是一个开源框架,用于构建和运行基于语言模型的应用程序。在这个框架中,你可以使用各种语言模型,如 OpenAI 的 GPT-3、GPT-3.5、GPT-4,或者 Hugging Face 的transformers库中的模型。这些模型可以是预训练的模型,也可以是经过特定任务微调的模型。

在 LangChain 中,你可以将语言模型与其他工具和数据库集成,以创建能够执行复杂任务的应用程序。例如,你可以使用语言模型来分析文本数据,然后使用其他工具来根据分析结果执行特定操作。

总之,"LangChain model" 可能指的是在 LangChain 框架中使用的大型语言模型,用于处理和生成文本数据。这些模型可以是开源的,也可以是商业的,具体取决于你的应用需求和资源。

-

除了 LangChain 外的其他框架?

除了LangChain,还有其他几个框架和平台也致力于将大型语言模型(LLMs)与外部工具和API结合起来,以提高模型的实用性和执行复杂任务的能力。以下是一些其他著名的框架:

1. **AgentGPT**:

- AgentGPT是一个开源项目,它允许用户创建自主的AI代理,这些代理可以使用互联网上的工具和资源来执行任务。AgentGPT利用GPT-3.5模型来生成自然语言指令,并使用这些指令与工具交互。

2. **OpenAI Gym**:

- OpenAI Gym是一个用于开发和比较强化学习算法的工具包。它提供了多种环境,其中一些环境可以与语言模型结合使用,以训练模型在特定任务中的行为。

3. **AutoGPT**:

- AutoGPT是一个实验性的开源项目,它旨在创建一个具有高级推理能力的自主AI代理。AutoGPT使用GPT-4模型来规划、执行和评估行动,以实现特定的目标。

4. **Hex**:

- Hex是一个由DeepMind开发的语言模型指令微调框架,它允许模型通过自然语言与外部工具交互。Hex使用强化学习来训练模型,使其能够有效地使用工具来解决复杂问题。

5. **Toolformer**:

- Toolformer是一种新型的语言模型架构,它集成了对工具的使用。Toolformer在模型内部直接嵌入工具,使模型能够自主地决定何时使用哪些工具来辅助回答问题。

这些框架和平台各有特点,但它们都共享一个目标:通过将语言模型与外部工具和API结合使用,提高模型的实用性和执行复杂任务的能力。用户可以根据具体的需求和偏好选择合适的框架。

-

基于LangChain 搭建大模型应用的经验

LangChain 是一个开源的框架,用于构建和运行基于语言模型的应用程序。以下是一些基于 LangChain 搭建大模型应用的经验和建议:

1. **选择合适的模型**: