在操作系统和计算机系统中,前端进程 和 后端进程 是两类不同的进程类型,主要根据进程的交互方式和运行特点来分类。

前端进程

前端进程 是指直接与用户交互的进程,通常负责处理用户输入、显示输出结果。它们通常运行在前台,用户可以清楚地看到其操作界面并与之交互。

特点:

- 用户交互性:前端进程需要直接响应用户的输入(如鼠标点击、键盘输入),输出结果通常会显示在屏幕上。

- 通常运行在前台,占据用户的终端或窗口;用户可以通过终端直接启动或关闭前端进程。

- 前端进程的优先级通常较高,以保证及时响应用户的请求。

- 示例:图形用户界面(GUI)程序:如浏览器、文本编辑器、媒体播放器;命令行程序:如

vim、nano、top等。

浏览器前端程序接收用户的点击事件,并将请求发送给后端服务器。在命令行终端中运行的程序直接显示用户请求的结果。

前端进程会阻塞当前终端,直到进程退出:

python myscript.py# 此时,终端会被占用,直到 Python 脚本执行完毕。

后端进程

后端进程 是指在后台运行的进程,通常不直接与用户交互,而是为前端进程或其他系统组件提供支持和服务,它们通常运行在后台,用户不可见。

特点:

- 无用户交互:后端进程通常不需要直接响应用户输入,也不会输出内容到用户界面。它们通过文件、网络或其他系统接口与前端进程或其他服务交互。

- 通常以 守护进程(Daemon) 或服务的形式运行。用户可以通过命令让进程在后台运行,不占用终端。

- 后端进程的优先级可能较低,以便为前端进程让出更多资源。但某些关键后端进程(如数据库服务)可能会有较高优先级。

- 示例:Web 服务器:如

Apache、Nginx。数据库服务:如MySQL、PostgreSQL。后台任务处理程序:如cron、systemd服务。

后端 Web 服务处理来自前端(如浏览器)发送的 HTTP 请求,并返回数据;守护进程定期执行任务,例如定时备份或日志清理。

启动一个后端进程,让其在后台运行(通过 & 符号):

python myscript.py &# 此时,脚本会在后台运行,终端仍然可用。

查看后台运行的进程:

jobs

二者的区别

| 属性 | 前端进程 | 后端进程 |

|---|---|---|

| 用户交互 | 直接与用户交互,响应输入并显示输出。 | 不直接与用户交互,通常为前端进程或其他服务提供支持。 |

| 运行模式 | 运行在前台,占用用户终端或界面。 | 运行在后台,不占用用户终端。 |

| 优先级 | 优先级较高,及时响应用户请求。 | 优先级可能较低,通常作为辅助服务运行。 |

| 典型示例 | 浏览器、媒体播放器、文本编辑器、命令行程序。 | Web 服务器、数据库服务、守护进程、任务调度器。 |

| 启动方式 | 通常由用户手动启动,例如通过命令行或桌面图标。 | 通常自动启动,例如系统启动时启动服务。 |

| 终端占用 | 占用终端,运行时无法输入其他命令。 | 不占用终端,可以在后台运行。 |

使用场景

现代计算系统通常是前端进程和后端进程协同工作的结果:

Web 应用

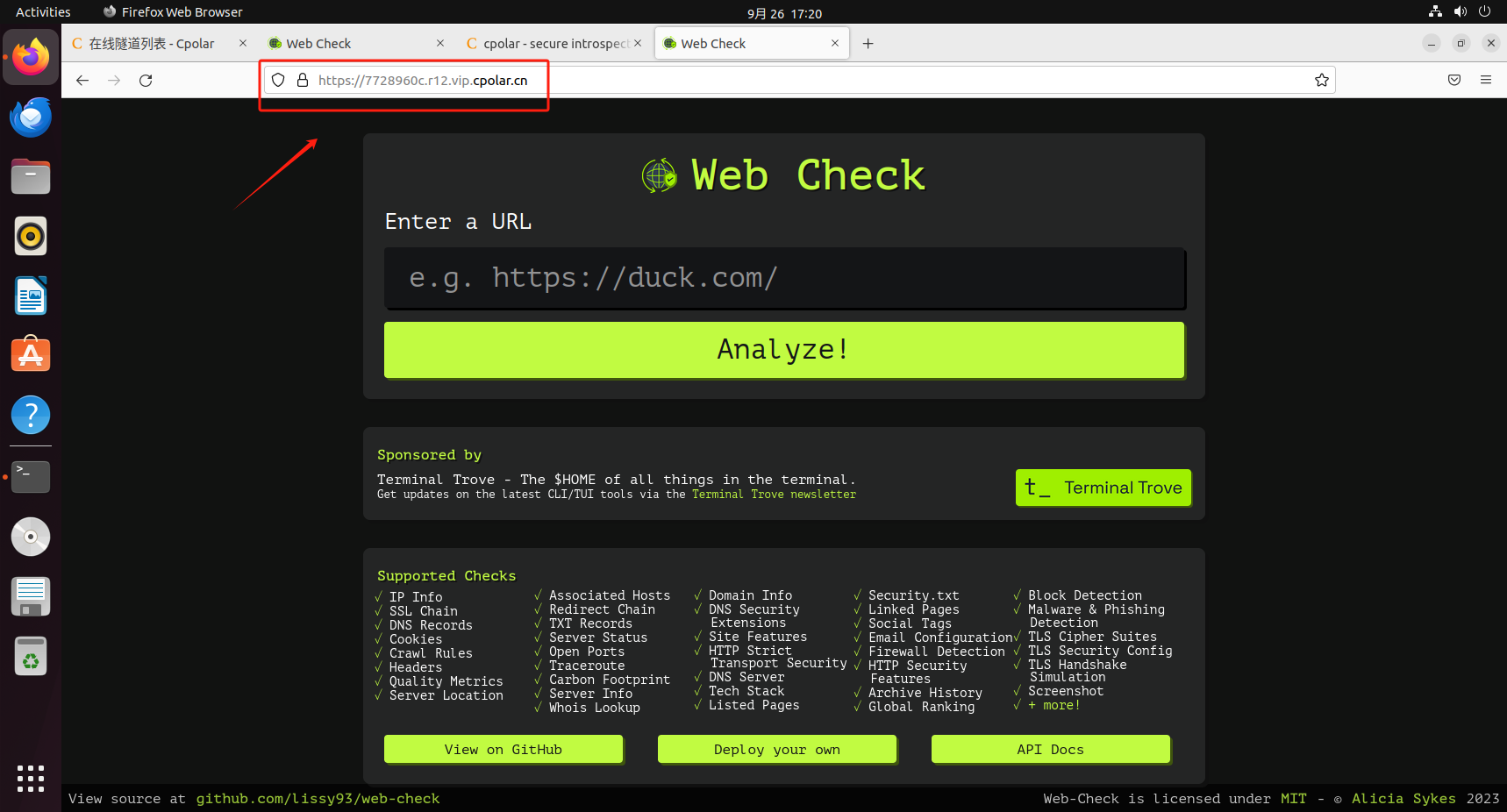

- 前端进程:浏览器(如

Chrome、Firefox)运行在用户的计算机上,处理用户输入并显示 Web 页面。 - 后端进程:

- Web 服务器(如

Nginx或Apache)运行在服务器上,处理来自前端的 HTTP 请求。 - 数据库服务(如

MySQL、PostgreSQL)负责存储和管理数据,为 Web 服务器提供支持。

- Web 服务器(如

多媒体处理

- 前端进程:视频播放器(如

VLC)在用户界面上显示视频,并允许用户控制播放进度。 - 后端进程:解码服务或进程在后台解码视频文件或流媒体数据,为前端播放器提供解码后的内容。

任务调度

- 前端进程:用户通过图形界面或命令行设置定时任务(如

crontab)。 - 后端进程:

cron守护进程在后台定时检查任务表,并在指定时间启动任务。

终端管理

前端进程的管理

前端进程通常由用户直接启动,可以通过终端或任务管理器(如 Linux 的 top 或 Windows 的任务管理器)查看和终止。

后端进程的管理

后端进程通常作为服务运行,需使用专用命令管理:

# 启动服务:

systemctl start <服务名># 停止服务:

systemctl stop <服务名># 查看服务状态:

systemctl status <服务名>

前端进程与后端进程的通信方式(常见方式,并非所有)

(仅列出大纲介绍 — 每一个的具体详情需要逐一单独用文章来写)

前端进程和后端进程经常需要通信以完成用户请求、数据处理等任务,通信方式因场景和系统架构而异。

| 通信方式 | 适用场景 | 特点 |

|---|---|---|

| 进程间通信(IPC) | 同一台机器上的前端进程与后端进程通信。 | 适用于本地通信,效率高。 |

| 网络通信(Socket) | 前端进程与后端进程可能在同一台机器或不同机器上(如客户端与服务器)。 | 适用于分布式系统,支持跨网络通信。 |

| 消息队列(Message Queue) | 前端和后端通过队列交换数据,适合解耦通信和异步处理场景。 | 适用于需要异步通信或高并发的数据传递场景。 |

| 文件系统 | 前端和后端通过文件共享信息(如日志文件或数据文件)。 | 简单但效率较低,适用于低频率通信。 |

| 共享内存 | 前端与后端进程共享同一片内存区域进行快速通信(通常在同一机器上)。 | 高速通信,但需要同步机制避免冲突。 |

| 信号(Signal) | 用于简单的通知或控制,比如让后端进程执行某些操作。 | 适用于轻量级通知,但不适合传递大数据。 |

前端进程和后端进程是计算机系统中不可或缺的部分。前端进程负责与用户交互,后端进程则专注于后台任务处理。二者协同工作是现代操作系统和应用软件取得高效运行的关键。

以上。仅供学习与分享交流,请勿用于商业用途!转载需提前说明。

我是一个十分热爱技术的程序员,希望这篇文章能够对您有帮助,也希望认识更多热爱程序开发的小伙伴。

感谢!