文章目录

- 1、RQ安装

- 2、RQ基本概念

- 2.1、Queue

- 2.2、Job

- 2.3、Worker

- 3、RQ 高级用法

- 3.1、自定义任务失败处理

- 3.2、任务依赖关系

- 3.3、定时任务

- 4、RQ web 界面

- 5、查看任务结果

- 6、RQ 与 celery 对比

- 7、总结

Python RQ(Redis Queue)是一个轻量级的异步任务队列库,它基于Redis构建,并使用Python编写。RQ的主要功能是帮助开发者将长时间运行的任务(如发送邮件、处理大数据等)放入队列中,然后由后台进程异步处理,以提高应用程序的性能和响应能力。

1、RQ安装

通过 pip 可以直接安装它

$ pip install rq

或者如果你想尝新的话,从 github 安装开发版:

$ pip install -e git+git@github.com:nvie/rq.git@master#egg=rq

2、RQ基本概念

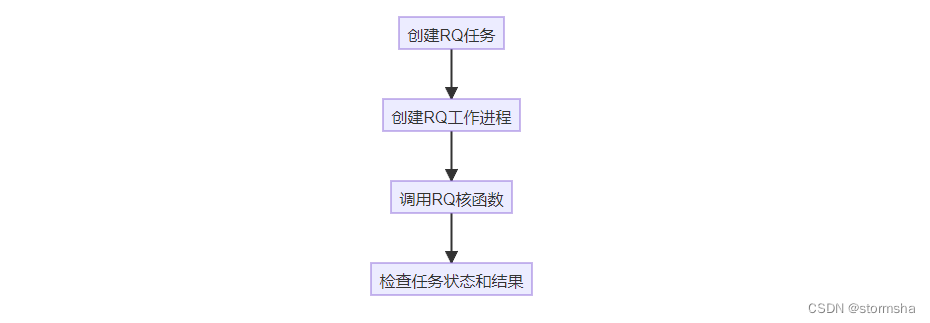

在 Python 的 RQ 库中,有三个核心概念:队列(Queue)、工作者(Worker)和任务(Job)。下面我将详细介绍它们的概念,并且给出相应的示例说明。

2.1、Queue

在 RQ 中,队列是用来存储待处理任务的地方。当您想要执行一个耗时的任务时,可以将该任务放入队列中,然后由Worker来异步执行。

示例:

from rq import Queue

from redis import Redis# 连接到 Redis 服务器

redis_conn = Redis()# 创建一个队列

q = Queue('default', connection=redis_conn) # 第一个参数是Queue的名称,可以不传,默认为default

2.2、Job

任务是需要执行的具体操作,可以是函数、方法或任何可调用的对象。当任务被放入队列后,工作者会从队列中取出任务并执行它。

示例:

from rq import Queue

from redis import Redis# 定义一个需要执行的任务函数

def my_task(x, y):return x + y# 将任务放入队列并执行

redis_conn = Redis()

q = Queue(connection=redis_conn)

job = q.enqueue(my_task, 1, 2)

2.3、Worker

worker 是 RQ 中负责执行队列中任务的组件。worker 会从队列中取出任务并执行,从而实现任务的异步处理。

worker 是一个完全独立的进程,通过命令行来启动它

示例:

$ rq worker

这会启动一个名为 “default” 的工作者,它会从默认队列中获取任务并执行。

若在实际使用中,有多个队列,队列之间的任务有优先级,可以在启动 worker 时,将这个优先级顺序传入,比如下面这个例子,排在前面的Queue里面的Job将优先被运行(low > high > default)

$ rq worker low high default

3、RQ 高级用法

除了基本用法之外,Python RQ 还提供了一些高级功能和选项,以满足更复杂的任务队列管理需求。

3.1、自定义任务失败处理

如果任务执行失败,RQ 可以自定义处理失败任务的方式。可以创建一个自定义的失败处理函数,并将其传递给 enqueue 方法的 failure 参数。

# main.pydef custom_failure_handler(job, exc_type, exc_value, traceback):# 在任务执行失败时执行自定义操作print(f"Job failed: {job.id}")print(f"Exception Type: {exc_type}")print(f"Exception Value: {exc_value}")print(f"Traceback: {traceback}")# 向队列中添加任务,并设置自定义失败处理函数

job = queue.enqueue(fibonacci, 10, failure=custom_failure_handler)

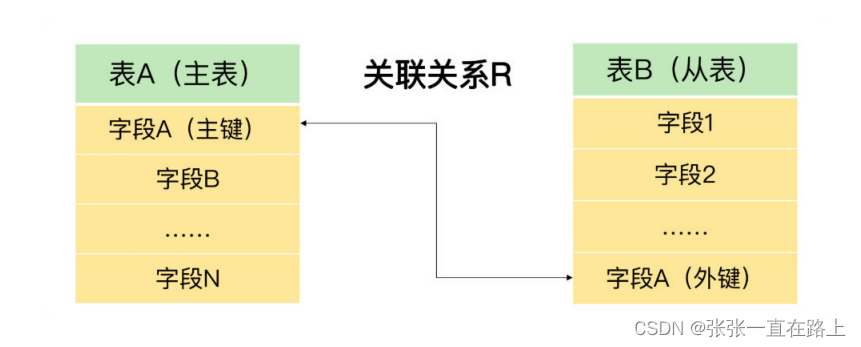

3.2、任务依赖关系

有时,任务之间存在依赖关系,其中一个任务需要等待另一个任务完成后才能执行。RQ 可以管理任务的依赖关系。

# main.py# 创建多个任务

job1 = queue.enqueue(fibonacci, 5)

job2 = queue.enqueue(fibonacci, 10)

job3 = queue.enqueue(fibonacci, 15)# 设置任务依赖关系

job2.dependency = job1

job3.dependency = job2

3.3、定时任务

如果需要执行定时任务,RQ 提供了一个方便的方式来处理定时任务。可以使用 schedule 模块来安排任务的执行时间。

# main.pyfrom rq import get_scheduler# 创建任务调度器

scheduler = get_scheduler(connection=redis_conn)# 向任务调度器添加定时任务

job = scheduler.schedule(scheduled_time=datetime.now() + timedelta(minutes=30),func=fibonacci,args=[10],

)

在这个示例中,首先创建了一个任务调度器,然后使用 schedule 方法来安排任务在未来的某个时间执行。

4、RQ web 界面

RQ 还提供了一个 Web 界面,可用于监控和管理任务队列。您可以通过以下方式启动 Web 界面:

$ rq-dashboard

然后访问 http://localhost:9181 查看队列状态和任务执行情况。

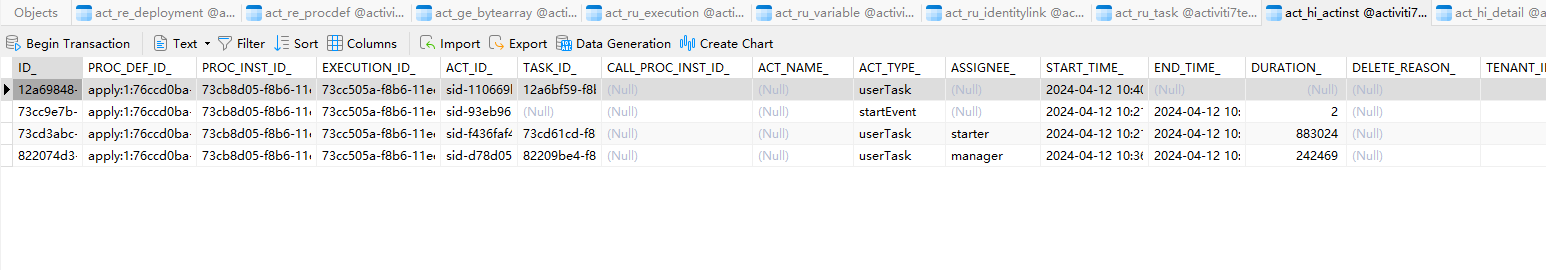

5、查看任务结果

在 RQ 中,您可以通过多种方式查看任务的执行情况。

方法一

job.get_status():查询任务的当前状态。该方法将返回一个字符串,表示任务的状态。任务状态可能是 “queued”(等待执行)、“started”(已开始)、“finished”(已完成)或 “failed”(失败)。

from rq import Queue

from redis import Redis# 定义一个需要执行的任务函数

def my_task(x, y):return x + y# 将任务放入队列并执行

redis_conn = Redis()

q = Queue(connection=redis_conn)

job = q.enqueue(my_task, 1, 2)# 查询任务状态

status = job.get_status()

print(f"Task status: {status}")

方法二

job.result:获取任务的执行结果。如果任务还没有执行完毕,该属性将会阻塞直到任务执行完毕并返回结果。

需要注意的是,如果任务还没有执行完成,调用 job.result 将会阻塞当前线程。

from rq import Queue

from redis import Redis# 定义一个需要执行的任务函数

def my_task(x, y):return x + y# 将任务放入队列并执行

redis_conn = Redis()

q = Queue(connection=redis_conn)

job = q.enqueue(my_task, 1, 2)# 获取任务结果

result = job.result

print(f"Task result: {result}")

6、RQ 与 celery 对比

与 RQ 相比, Celery 可能更加知名一点,它们都是 Python 中常用的用于处理异步任务的库,它们在实现异步任务处理的方式和功能特性上有一些区别。

RQ

- 简单易用:RQ 设计简单,易于上手,适合小型项目或对任务处理需求不复杂的场景。

- 基于 Redis:RQ 使用 Redis 作为后端存储队列,利用 Redis 的数据结构来管理任务队列。

- 轻量级:由于设计简单,RQ 相对较轻量,适合快速集成和使用。

- 监控和管理:RQ 提供了简单的 Web 界面和命令行工具,用于监控和管理任务队列。

Celery

- 功能强大:Celery 是一个功能丰富的分布式任务队列,支持延迟任务、定时任务、优先级队列等高级特性。

- 可扩展性:Celery 提供了丰富的插件和扩展机制,可以满足复杂的任务处理需求。

- 多后端支持:Celery 支持多种消息中间件作为任务队列后端,如 Redis、RabbitMQ、Amazon SQS 等。

- 社区活跃:Celery 拥有庞大的社区支持和文档资源,适合在复杂项目中使用。

在选择 RQ 还是 Celery 时,可以自身情况进行选择:

- 项目规模:对于小型项目或简单的任务处理需求,RQ可能是一个更轻量级和直观的选择;而对于复杂的任务处理需求或大型项目,Celery提供的功能和扩展性更适合。

- 技术栈:如果已经在项目中使用了 Redis,并且对任务处理需求不复杂,可以考虑选择 RQ;如果需要更复杂的任务调度和处理功能,或者需要与其他消息中间件集成,可以选择 Celery。

7、总结

Python RQ 是一个强大而简单的任务队列管理库,用于管理和执行后台任务。无论是开发 Web 应用程序、数据处理管道还是其他类型的应用,RQ 都可以轻松管理和执行任务,提高应用程序的性能和可维护性。希望本文的介绍和示例能够帮助大家入门 Python RQ,并开始在项目中使用分布式任务队列。