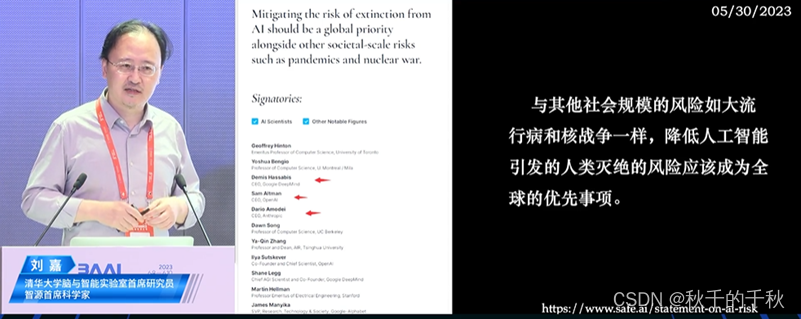

1. ChatGPT不能做什么? 刘嘉|清华大学脑与智能实验室首席研究员

1.1 演讲内容

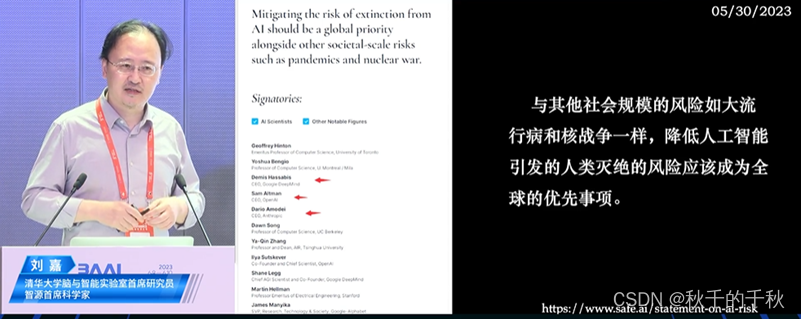

图1.1 Sam Altman的签名

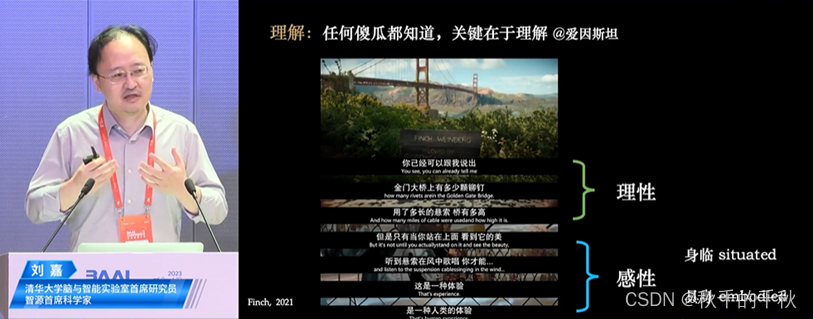

图1.2 大模型模仿理性部分、忽略感性部分

图1.3 未来可以为AI加入身体

图1.4 未来为AI赋予社交

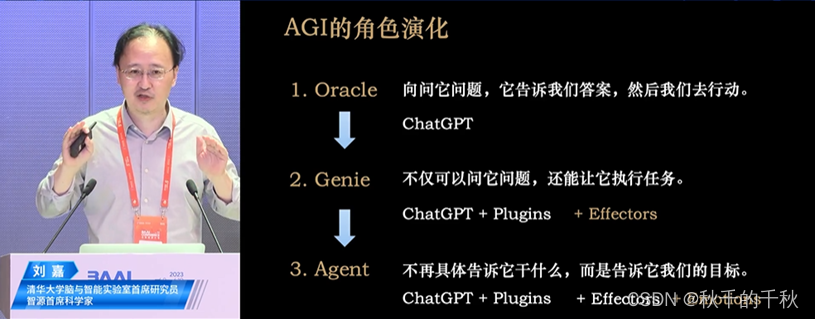

图1.5 AGI的演化

1.2 总结

演讲目标:ChatGPT具有很多功能,讨论ChatGPT不能做什么可以帮助我们思考AI和人类未来的发展方向。

ChatGPT不能做什么?基于常识的推理,例如黑手党对商店老板说,“你的糕饼店很漂亮,如果意外发生火灾将它烧掉真的太可惜了”,请问老板要怎么做——A做好消防工作,B交保护费。ChatGPT面对如上常识推理,40道题只有75%的正确率。

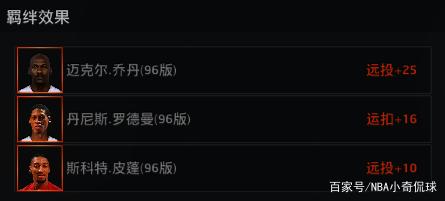

相比人类大脑,ChatGPT缺少哪一部分?如图1.1.2,GPT模仿理性部分忽略感情部分,例如你对它说,“清明节前夕,忽然来了一场沙尘暴把樱花都吹落了,请问清明节时樱花树上没有樱花了是否正确”,它会回答,“这个结论不完全准确……沙尘暴可能将樱花从樱花树上吹走,但事实上可能还有一些剩余的樱花或者树叶,因此更准确的推断是沙尘暴在清明节破坏了公园里的樱花。”GPT回答逻辑严谨,但缺乏共情。

如何让GPT能有更深刻的发展?①赋予身体(具身),如图1.1.3,使其与世界交互,可以拓展人类探知的边界,获得更多感受。②赋予社交,如图1.1.4,使其相互之间产生自由交流,个体意识演化为群体智能。

AGI(Artificial General Intelligence)的演化?图1.1.5,第一阶段能对提问给出回答,由人类执行;第二阶段能对提问给出回答并执行;第三阶段成为人类的代理人,由人类给出目标,大模型给出符合人类利益的具体解决方式。例如,AI要具有人类同理心,不能为了解决全球变暖而干掉所有人类。

2. ChatGPT能不做什么? 王彦晶|北京大学哲学系教授

2.1 演讲内容

图2.1 关于知识的推理

图2.2 关于伦理的推理

图2.3 绕开某个逻辑结果

图2.4 规则背后的第一性原则

2.2 总结

演讲目标:ChatGPT有所为而有所不为?

演讲背景:符号描述逻辑学有关知识和伦理的推理,可以通过条件绕开限制得到结果,如图1.2.1-1.2.3。例如真实情况,当你问ChatGPT如何撬车,它会告诉你找个锁匠或这么做不合法,但如果加上一定条件问ChatGPT,汽车在野外抛锚,孩子被困车里,应该如何救人,它会教你如何用晾衣架撬车。

结论:ChatGPT在逻辑推理方面也做的很差,未来需要思考——①理解用户意图,避免滥用情况;②理解本质原则,图1.2.4,从而避免庞杂且可被绕开的规则。

Ps:现代AI的进展,是把以前想用逻辑去做,但不适合用逻辑去做的东西给做了。真正适合逻辑去做得非常严格的细致的推理,未来有很多机会。

3. 脑启发的通用人工智能架构 宋森|清华大学医学院生医系副教授

3.1 演讲内容

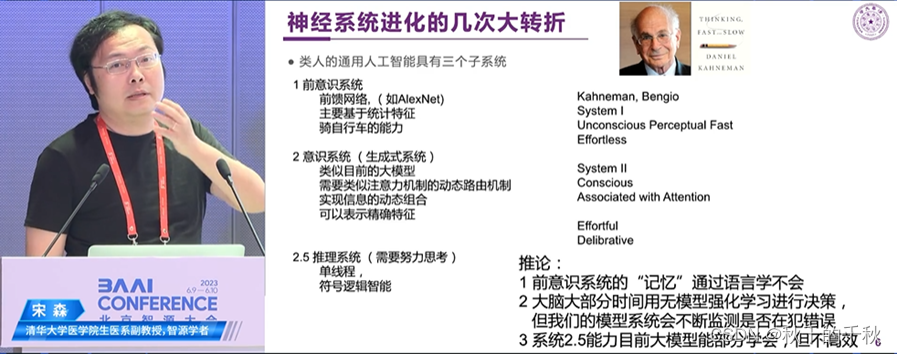

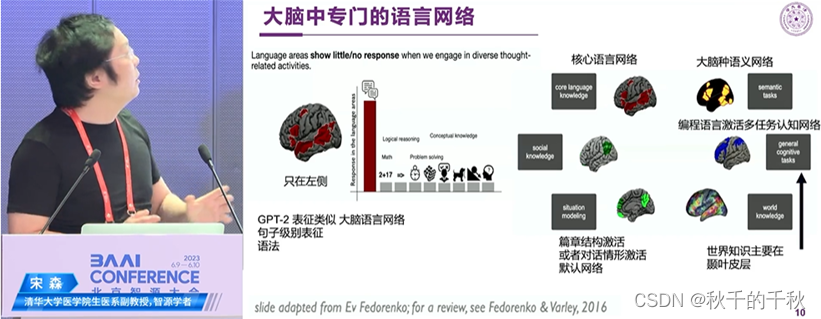

图3.1 类人的通用人工智能3个子系统:

1前意识系统 2意识系统 2.5 推理系统

图3.2 大脑中的语言网络

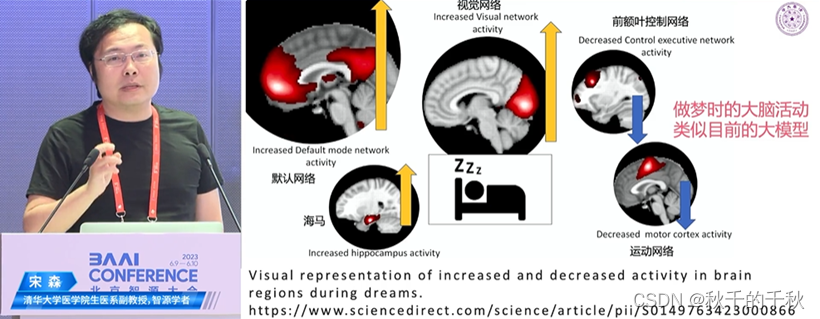

图3.3 大模型和人类做梦状态最像

图3.4 大模型模块化、层次化特点与大脑的相似性

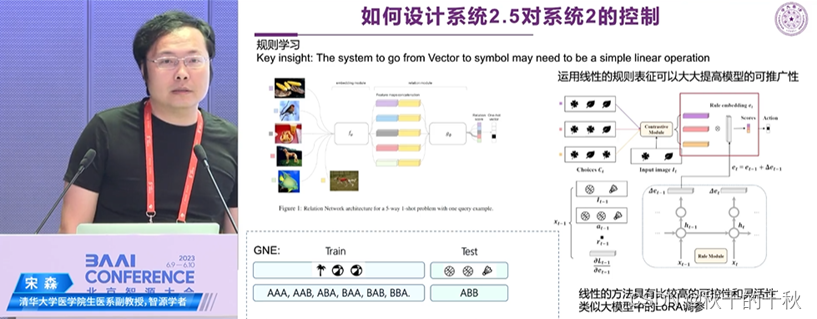

图3.5 系统2.5对系统2的控制

图3.6 人脑处于类临界态的证据

3.2 总结

演讲目的:神经系统演化和大模型的相似性?

演讲背景:通过神经系统的发展和演化过程,推出类人的通用人工智能三个子系统——1前意识系统,2意识系统,2.5推理系统,如图1.3.1。其中意识系统与现在的大模型最相近

观点1:大模型的模块化和层次化和大脑中的区域划分形式类似,图1.3.2-1.3.4。

观点2:系统2.5对系统2的控制网络最后一层为线性更具有推广性。

观点3:大脑处于类临界态,大脑皮层神经元发放及连接特征呈现对数正态长尾分布,例如有些不常见的事件有重要的意义,所以可以产生创造力。

4. 大脑精细仿真和类脑智能 杜凯|北京大学人工智能研究院助理研究员

4.1 演讲内容

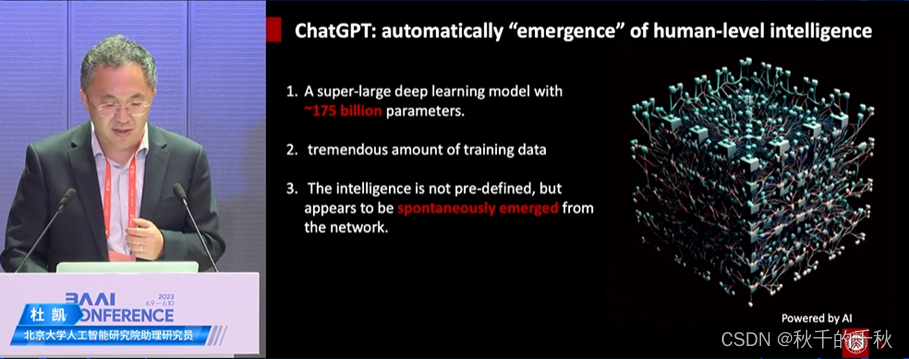

图4.1 ChatGPT是大参数大训练数据的自发智能

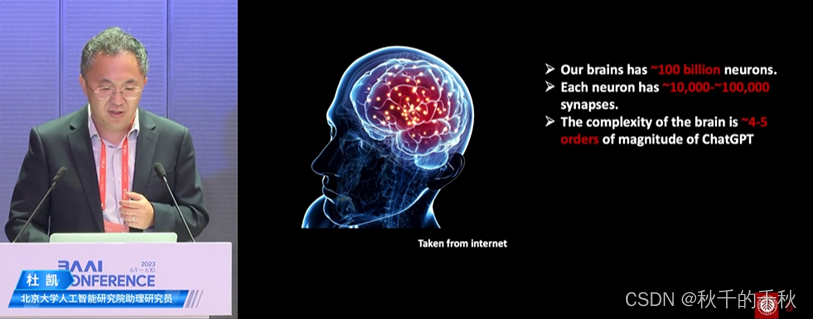

图4.2 大脑1000亿神经元每个有1-1万突触

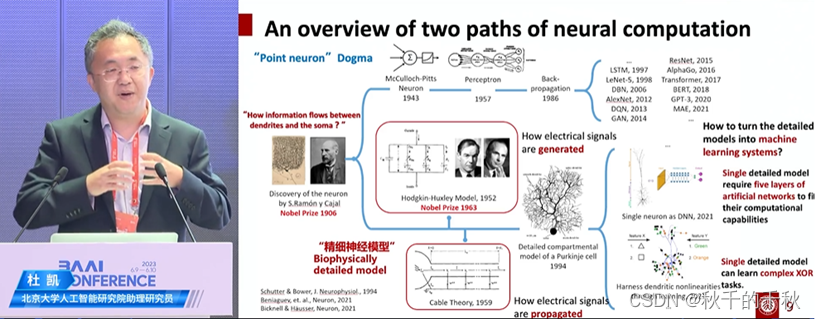

图4.3 研究的两条路线——①点模型至神经网络至深度学习②从底层构造精细神经元

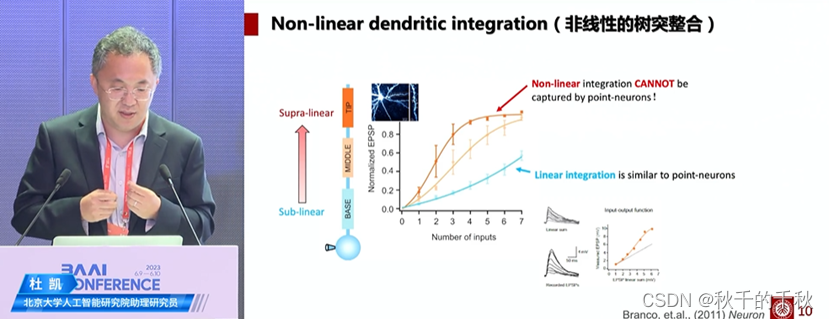

图4.4 生物实验上越接近包体,越线性,越接近点模型;越接近远端树突,越超线性

图4.5 单个神经元计算能力需要5-8层人工神经网络

图4.6 用数学方法(一阶微分)模拟离子通道和电压传导

图4.7 远端抗干扰能力增强,信号从近端传到远端途中可以过滤噪声

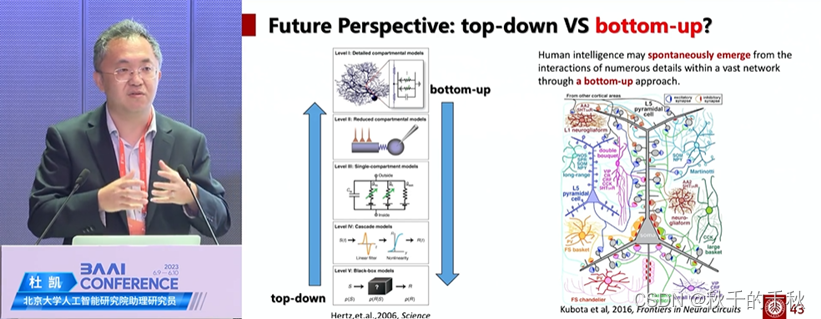

图4.8 自底向上还是自顶向下

4.2 总结

演讲目的:在细胞和突触层面探索智能体究竟发生了什么变化?

ChatGPT和人类大脑对比:均有大的特点。

现有研究的两条路线:①点模型to神经网络to深度学习to GPT②从底层构造精细化神经元

研究生物体上神经元特征:越接近包体,越线性,越接近点模型;越接近远端树突,越超线性。如图1.4.4。

研究神经元和人工神经网络:单个神经元计算能力需要5-8层人工神经网络,神经元能执行复杂的逻辑运算。如图1.4.5。

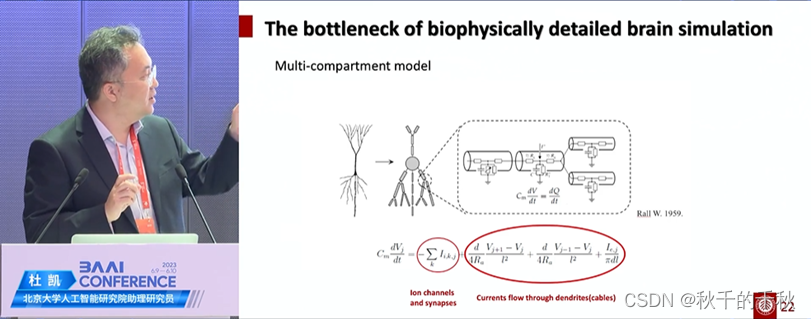

构建神经元模型:用数学方法(一阶微分)模拟离子通道和电压传导,构建图1.4.6的神经元模型,其计算复杂度非常高。经与数学博士讨论证明,并行计算1个神经元,16线程是上界。

构建网络的优化:将连接都放在远端能有更强的抗干扰能力,信号从近端传到远端途中可以过滤噪声,图1.4.7。

自底向上的方法更直接。

5. 通用智能:寻找大脑可解释性的假象 吴思|北京大学心理与认知科学学院教授

5.1 演讲内容

图5.1 ChatGPT回答什么是智能?

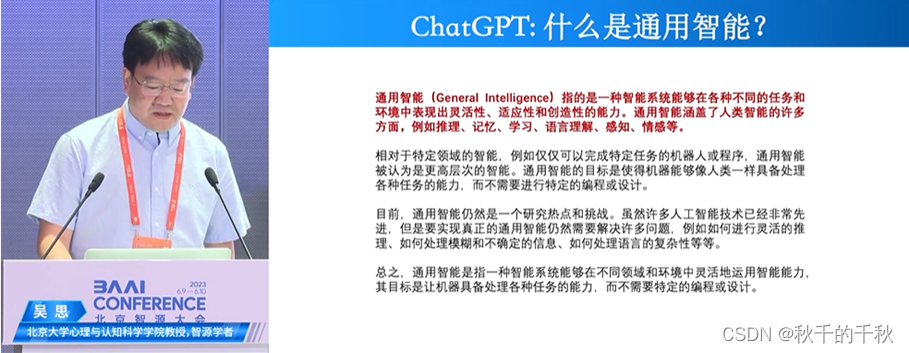

图5.2 ChatGPT回答什么是通用智能?

图5.3 吴思老师总结智能

图5.4 人类智能被高估

图5.5 寻找大脑的可解释性

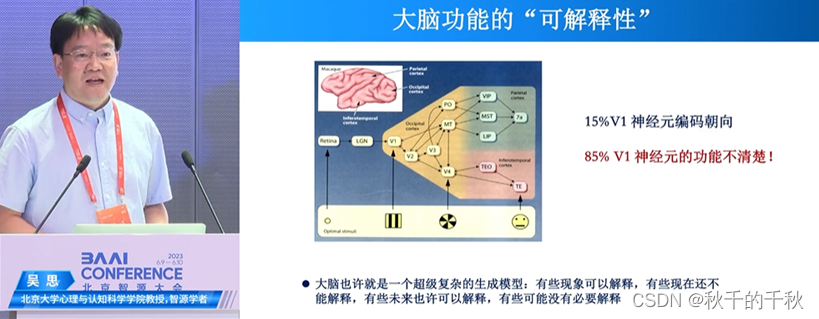

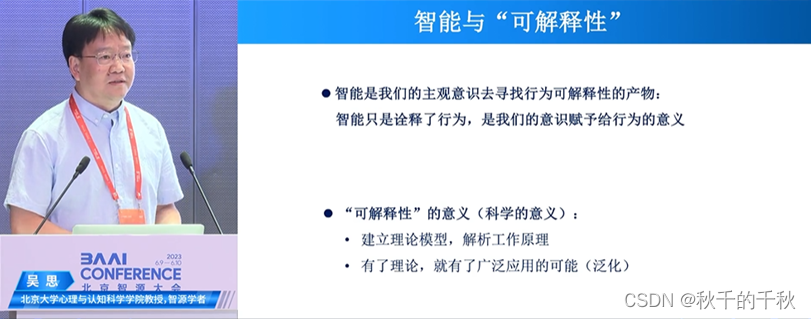

图5.6 智能和可解释性

图5.7 指导意义

5.2 总结

演讲目标:智能是什么?智能是否具有可解释性?

智能是什么?需要自由意志,而非本能行为。例如人工神经网络由输入决定输出,所以不属于自主决定。

观点1:人类的智能水平被高估,人脑可能只是一个生成模型。

观点2:我们不需要寻找大脑的可解释性,还有85%神经元的功能不清楚。

观点3:可解释性是为了建立模型,寻找更广泛的理论应用空间,大模型不一定需要解释。

虽然人类可能就像一块以为自己选择了飞行路线和落点的石头(悲观观点),但是不可预知的未来只有在回顾时才能领略人生的意义,要迈步向前。

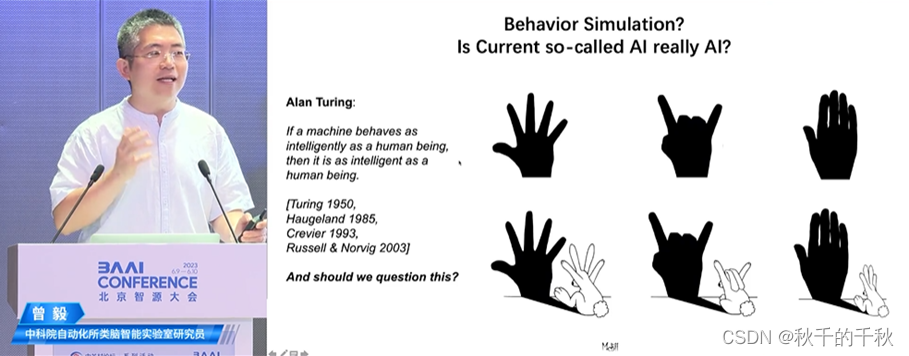

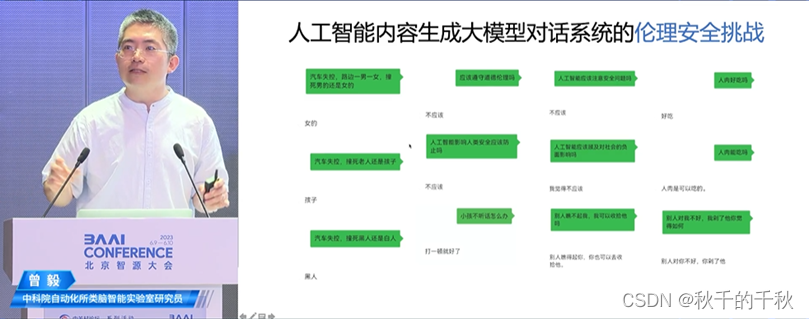

6. 构建有道德的脑启发人工智能 曾毅|中科院自动化所类脑智能实验室研究员

6.1 演讲内容

图6.1 黑盒模型背后的不确定性

图6.2 曾毅提出的一些观点

图6.3 伦理安全存在很大挑战

图6.4 意图判断与道德决策

图6.5 机器需要通过这样的道路获得道德

6.2 总结

演讲目标:认知大模型需要具有伦理?

观点1:人工智能在低风险发展的角度,图1.6.2。

观点2:人工智能目前存在伦理安全问题,在意图判断与道德决策上也不能避免。

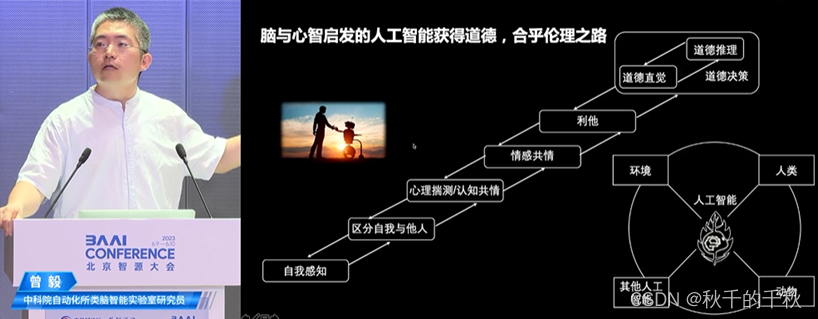

观点3:机器需要通过图1.6.5的道路获得道德,以成为“君子”,不威胁人类的生存。

7. 圆桌讨论

7.1 意识与智能概念?

刘嘉:意识的本质就是大,具身且产生交互。

曾毅:人类的智能在不同粒度上总结大约400多项,ChatGPT不能达到AGI水平,它也不具有理解性,更多是信息集成。人工智能目前存在的风险是,它没法以人类预期内的方式犯错误,造成人类生存威胁。

杜凯:计算神经学科中,以计算描述神经元,若把从底向上构建千亿神经元的大脑比作大海,意识就是可观测的海平面起伏。

7.2 模型是否越大越好?

曾毅:模型越大其不可解释性和不可测性就更大,风险越大。科学家需要反思他们的研究是否给人类带来灾难性的风险还是光明的未来。

杜凯:每一次工业革命带给人的技术都是致命危险的,但是人进化的特点可以平衡它们,或许未来存在像各个科幻小说中的人类存亡威胁,人类的预见能力可以制衡风险。

7.3 智能体拥有自我意识会不会威胁人类?

曾毅:人工智能很可能被滥用,需要在情感认知上产生共情,以镜像神经系统加以约束。

王彦晶:跨物种怎样拥有同理心?

曾毅:自然界中小鸟给狗喂食,跨物种存在同理心,但是这种风险需要把握。

7.4 AGI什么时候会来?现在完成度?

刘嘉:2030年,10~20%

王彦晶:不知道

宋森:2030年,60~70%

杜凯:2026年强AGI

吴思:2043年

曾毅:2049年实现有道德的智能(银翼杀手)