【Linux学习笔记】Linux基本指令分析和权限的概念

🔥个人主页:大白的编程日记

🔥专栏:Linux学习笔记

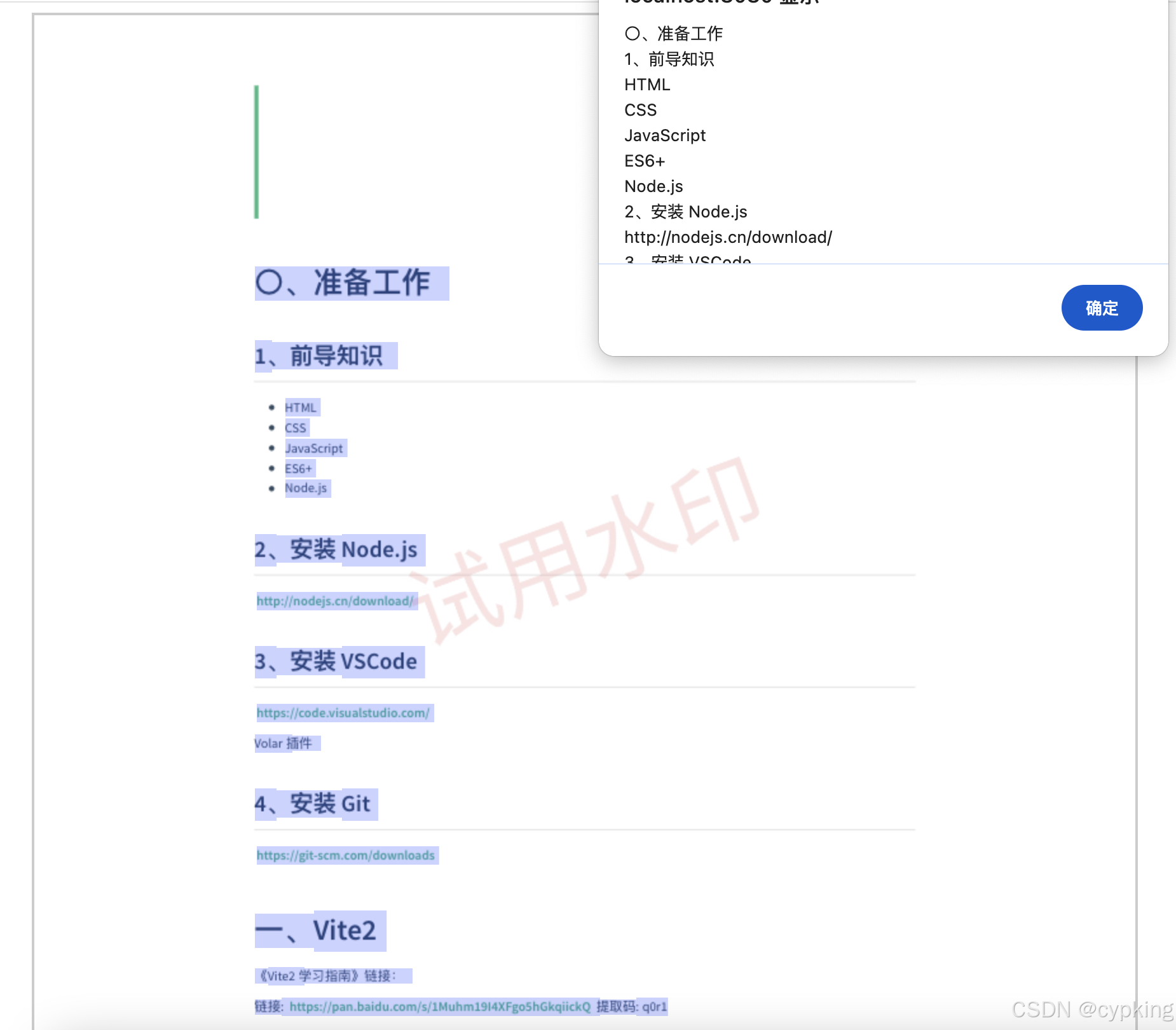

文章目录

- 【Linux学习笔记】Linux基本指令分析和权限的概念

- 前言

- 一. 指令的分析

- 1.1 alias 指令

- 1.2 grep 指令

- 1.3 zip/unzip 指令

- 1.4 tar指令(重要)

- 1.5 bc指令

- 1.6 uname-r指令

- 1.7 关机

- 二.shell命令以及运行原理

- 三.Linux权限的概念

- 后言

前言

哈喽,各位小伙伴大家好!上期我们讲了Linux基本指令及其分析(二) 今天我们讲的是Linux基本指令分析和权限的概念。话不多说,我们进入正题!向大厂冲锋!

一. 指令的分析

1.1 alias 指令

功能: 设置命令的别名

举例:

[qcj@bite - alicloud test] $ alias hello = 'ls -a -l -n'

[qcj@bite - alicloud test]$ which hello

alias hello = 'ls -a -l -n'

/ usr / bin / ls

[qcj@bite - alicloud test]$ hello

total 36

drwxrwxr - x 2 1003 1003 4096 Jan 11 17:59 .

drwx------ 22 1003 1003 4096 Jan 11 17 : 57 ..

- rw - rw - r-- 1 1003 1003 28667 Jan 11 18 : 29 temp.txt

1.2 grep 指令

语法: grep [选项] 搜寻字符串 文件

功能: 在文件中搜索字符串,将找到的行打印出来

常用选项:

- -i:忽略大小写的不同,所以大小写视为相同

- n:顺便输出行号

- v:反向选择,亦即显示出没有’搜寻字符串’内容的那一行

# ⽂件内容

[whb@bite - alicloud test]$ cat temp.txt

abcd

ABCD

hello

bite

1234

#基本查找

[whb@bite - alicloud test]$ grep "abcd" temp.txt

abcd

# 忽略⼤⼩写的不同,所以⼤⼩写视为相同

[whb@bite - alicloud test]$ grep - i "abcd" temp.txt

abcd

ABCD

# 顺便输出⾏号

[whb@bite - alicloud test]$ grep - n "abcd" temp.txt

1:abcd

[whb@bite - alicloud test]$ grep - ni "abcd" temp.txt

1 : abcd

2 : ABCD

# 反向选择,亦即显⽰出没有'搜寻字符串' 内容的那⼀⾏

[whb@bite - alicloud test]$ grep - v "abcd" temp.txt

ABCD

hello

bite

1234

[whb@bite - alicloud test]$ grep - vn "abcd" temp.txt

2:ABCD

3 : hello

4 : bite

5 : 1234

[whb@bite - alicloud test]$ grep - vni "abcd" temp.txt

3 : hello

4 : bite

5 : 1234

1.3 zip/unzip 指令

语法: zip 压缩文件.zip 目录或文件

功能: 将目录或文件压缩成zip格式

常用选项

- r:递归处理,将指定目录下的所有文件和子目录一并处理

举例

将test2目录压缩:zip test2.zip test2/*

解压到tmp目录:unzip test2.zip -d /tmp

关于 rzsz

这个工具用于 windows 机器和远端的 Linux机器通过 XShell 传输文件,安装完毕之后可以通过拖拽的方式将文件上传过去

sudo yum/apt install -y lrzlz

现场演示windows和Linux如何互传文件

1.4 tar指令(重要)

打包/解包,不打开它,直接看内容

语法: tar[-cxtzjvf] 文件与目录 …

参数:

- c:建立一个压缩文件的参数指令(create 的意思);

- x:解开一个压缩文件的参数指令!

- t:查看 tarfile 里面的文件!

- z:是否同时具有 gzip 的属性?亦即是否需要用 gzip 压缩?

- j:是否同时具有 bzip2 的属性?亦即是否需要用 bzip2 压缩?

- v:压缩的过程中显示文件!这个常用,但不建议用在背景执行过程!

- f:使用档名,请留意,在f之后要立即接档名喔!不要再加参数!

- C:解压到指定目录

案例:

范例一:将整个/etc目录下的文件全部打包成为’/tmp/etc.tar

[root@linux ~] $ tar - cvf / tmp / etc.tar / etc <= =仅打包,不压缩!

[root@linux ~]$ tar - zcvf / tmp / etc.tar.gz / etc <= =打包后,以gzip压缩

[root@linux ~]$ tar - jcvf / tmp / etc.tar.bz2 / etc <= =打包后,以bzip2压缩

特别注意,在参数f之后的文件档名是自己取的,我们习惯上都用.tar 来作为辨识。

如果加z参数,则以.tar.gz或.tgz来代表 gzip 压缩过的 tar file ~

如果加j参数,则以 .tar.bz2 来作为附档名啊~

上述指令在执行的时候,会显示一个警告讯息:

Г`tar: Removingleading`/"from member names`』那是关于绝对路径的特殊设定。

范例二:查阅上述 /tmp/etc.tar.gz文件内有哪些文件?

[root@linux ~]$ tar -ztvf /tmp/etc.tar.gz

由于我们使用 gzip 压缩,所以要查阅该 tar file 内的文件时,就得要加上z这个参数了!这很重要的!

范例三:将 /tmp/etc.tar.gz文件解压缩在 /usr/local/src 底下

[root@linux ~]$ cd /usr/local/src[root@linux src]$ tar -zxvf /tmp/etc.tar.gz

在预设的情况下,我们可以将压缩档在任何地方解开的!以这个范例来说,我先将工作目录变换到/usr/local/src 底下,并且解开 /tmp/etc.tar.gz,则解开的目录会在/usr/local/src/etc呢!另外,如果您进入/usr/local/src/etc

则会发现,该目录下的文件属性与 /etc/可能会有所不同喔!

范例四:在 /tmp 底下,我只想要将/tmp/etc.tar.gz内的 etc/passwd 解开而已

[root@linux ~]$ cd /tmp[root@linux tmp]$ tar -zxvf /tmp/etc.tar.gz etc/passwd

我可以透过 tar -ztvf 来查阅 tarfile 内的文件名称,如果单只要一个文件,就可以透过这个方式来下达!注意到! etc.tar.gz内的根目录/是被拿掉了!

范例五:将 /etc/内的所有文件备份下来,并且保存其权限!

[root@linux ~]$ tar -zxvpf /tmp/etc.tar.gz /etc# 这个 -p 的属性是很重要的,尤其是当您要保留原本⽂件的属性时!

范例六:在/home 当中,比2005/06/01新的文件才备份

[root@linux ~]$ tar -N "2005/06/01" -zcvf home.tar.gz /home

范例七:我要备份/home,/etc,但不要/home/dmtsai

[root@linux ~]$ tar --exclude /home/dmtsai -zcvf myfile.tar.gz /home/* /etc

范例八:将/etc/打包后直接解开在 /tmp 底下,而不产生文件!

[root@linux ~]$ cd /tmp[root@linux tmp]$ tar -cvf - /etc | tar -xvf

这个动作有点像是 cp -r/etc /tmp 啦~依旧是有其有用途的!

要注意的地方在于输出档变成-而输入档也变成-,又有一个存在~

这分别代表 standard output,standard input 与管线命令啦!

现场演示如何在Linux和Linux之间互传压缩包

1.5 bc指令

bc命令可以很方便的进行浮点运算

1.6 uname-r指令

语法: uname[选项]

功能: uname用来获取电脑和操作系统的相关信息。

补充说明: uname可显示linux主机所用的操作系统的版本、硬件的名称等基本信息。

常用选项:

- a或-all 详细输出所有信息,依次为内核名称,主机名,内核版本号,内核版本,硬件名,处理器类型,硬件平台类型,操作系统名称

重要的几个热键[Tab],[ctrl]-c,[ctrl]-d

[Tab]按键—具有『命令补全』和『档案补齐』的功能

[Ctrl]-c按键—让当前的程序『停掉」

[Ctrl]-d按键—通常代表着:『键盘输入结束(End Of File,EOF 戒 End Oflnput)』的意思;另外,他也可以用来取代exit

1.7 关机

语法: shutdown[选项

常见选项:

- h:将系统的服务停掉后,立即关机。

- r:在将系统的服务停掉之后就重新启动

- tsec:-t后面加秒数,亦即『过几秒后关机』的意思

以下命令作为扩展

- 安装和登录命令:login、shutdown、halt、reboot、install、mount、umount、chsh、exit、 last;

- 文件处理命令:file、mkdir、grep、dd、find、mv、ls、diff、cat、ln;

- 系统管理相关命令:df、top、free、quota、at、lp、adduser、groupadd、kill、crontab;

- 网络操作命令:ifconfig、ip、ping、netstat、telnet、ftp、route、rlogin、rcp、finger、

mail、nslookup; - 系统安全相关命令:passwd、su、umask、chgrp、chmod、chown、chattr、sudo ps、who;

- 其它命令:tar、unzip、gunzip、unarj、mtools、man、unendcode、uudecode。

二.shell命令以及运行原理

Linux严格意义上说的是一个操作系统,我们称之为“核心(kernel),但我们一般用户,不能直接使用kernel。而是通过kernel的“外壳”程序,也就是所谓的shell,来与kernel沟通。如何理解?为什么不能直接使用kernel?

从技术角度,Shell的最简单定义:命令行解释器(commandInterpreter)主要包含:

- 将使用者的命令翻译给核心(kernel)处理。

- 同时,将核心的处理结果翻译给使用者。

对比windowsGUl,我们操作windows不是直接操作windows内核,而是通过图形接口,点击,从而完成我们的操作(比如进入D盘的操作,我们通常是双击D盘盘符.或者运行起来一个应用程序)

shell对于Linux,有相同的作用,主要是对我们的指令进行解析,解析指令给Linux内核。反馈结果在通过内核运行出结果,通过shell解析给用户。帮助理解:如果说你是一个闷骚且害羞的程序员,那shell就像媒婆,操作系统内核就是你们村头漂亮的且有让你心动的MM小花。你看上了小花,但是有不好意思直接表白,那就让你你家人找媒婆帮你提亲,所有的事情你都直接跟媒婆沟通,由媒婆转达你的意思给小花,而我们找到媒婆姓王,所以我们叫它王婆,它对应我们常使用的bash。

三.Linux权限的概念

Linux下有两种用户:超级用户(root)、普通用户。

- 超级用户:可以再linux系统下做任何事情,不受限制

- 普通用户:在linux下做有限的事情。

- 超级用户的命令提示符是“#”,普通用户的命令提示符是“$”。

命令: su[用户名]

功能: 切换用户。

例如,要从root用户切换到普通用户user,则使用suuser。要从普通用户user切换到root用户则使用suroot(root可以省略),此时系统会提示输入root用户的口令。

后言

这就是Linux基本指令分析和权限的概念。大家自己好好消化!今天就分享到这!

感谢各位的耐心垂阅!咱们下期见!拜拜~

![[网络爬虫] 动态网页抓取 — Selenium 元素定位](https://i-blog.csdnimg.cn/direct/1ab11c5d089349399688e60382ab0bdb.jpeg)