Spark概述

Spark-RDD概述

1.为什么会需要广播变量?

-

广播变量是为了在分布式计算环境中有效地向集群中的所有节点广播大型只读数据集而设计的。

-

在分布式环境中,通常会遇到需要在所有节点上使用相同的数据集的情况,但是将这些数据集复制到每个节点可能会导致网络开销过大和内存消耗过多。这时就可以使用广播变量来解决这个问题。

-

广播变量只会被序列化一次,然后将其发送到集群中的每个节点,而不是在每个任务中重新发送。

-

这样,每个节点只需要在本地保存一份数据,而不需要在每个任务中重新复制。

-

这大大减少了网络传输和内存开销,提高了性能。

因此,广播变量特别适用于以下情况:

- 1.当需要在所有节点上使用相同的大型只读数据集时,如机器学习模型的参数。

- 2.当需要避免在每个任务中重复传输相同数据时,以减少网络开销和内存消耗。

2. 广播变量的工作原理:

当需要在Spark作业中广播(Broadcast)一个变量时,通常是因为这个变量需要在集群中的每个任务中被使用,但是又不希望每个任务都去拷贝这个变量的副本。

广播变量能够有效地在集群中共享大型的只读数据集,以提高作业的性能和效率。

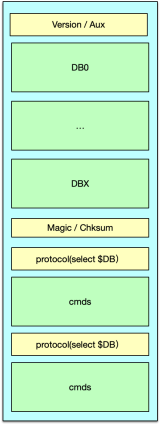

- 1.数据分发:首先,Spark会将要广播的变量拆分成多个数据块,然后将这些数据块分发给集群中的每个Executor。

- 2.Executor内存缓存:每个Executor会在其内存中缓存这些数据块,以供后续任务使用。

- 3.任务使用:当任务需要访问广播变量时,它们会从本地的Executor内存中获取数据,而不是从Driver或其他Executor复制数据。

3. 广播变量的特点:

-

只读性:广播变量是只读的,一旦广播之后,就不能再对其进行修改。确保在并行操作中不引起不一致性或不确定性。

-

内存共享:广播变量的数据在Executor内存中被共享,避免了在每个任务中复制数据的开销。

-

跨任务共享:广播变量可以被作业中的所有任务共享,无论这些任务在集群中的哪个节点上执行。

4. 广播变量的使用方法:

- 创建广播变量:通过调用sc.broadcast()方法来创建广播变量,传入要广播的数据集。

- 访问广播变量:在任务中通过广播变量的.value属性来访问广播的数据。

示例

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.broadcast.Broadcast;

import org.apache.spark.SparkConf;import java.util.Arrays;

import java.util.List;public class BroadcastExample {public static void main(String[] args) {// 创建Spark配置SparkConf conf = new SparkConf().setAppName("BroadcastExample").setMaster("local");// 创建Spark上下文JavaSparkContext sc = new JavaSparkContext(conf);// 要广播的数据List<Integer> data = Arrays.asList(1, 2, 3, 4, 5);// 创建RDDJavaRDD<Integer> rdd = sc.parallelize(data);// 创建并广播变量final Broadcast<List<Integer>> broadcastVar = sc.broadcast(data);// 在任务中访问广播变量rdd.foreach(x -> {List<Integer> broadcastData = broadcastVar.value();for (Integer item : broadcastData) {// 处理数据System.out.println(item * x);}});// 关闭Spark上下文sc.close();}

}5. 注意事项:

- 广播变量的大小:要谨慎选择需要广播的变量大小,不要将过大的数据集广播到集群中,以免占用过多的内存资源。

- 广播变量的生命周期:广播变量的生命周期会跟随Spark作业的执行,作业执行完毕后会自动释放广播变量。

- 避免频繁广播:尽量避免在循环中频繁地创建和广播变量,这样会增加集群的通信开销。