许久未见,甚是想念,今日好运,为你带好运。ok,废话不多说,希望这门案例能带你直接快速了解并运用。🎁💖

基础流程

第一步:安装需要用到的requests库,命令如下

pip install requests第二步:随意找个目标网址

url = '目标网址'第三步:发送请求get响应

req = requests.get(url)第四步:打印响应信息

print(req_text)完整代码如下

import requests #导入库

url = 'http://gitbook.cn/' #目标网址

req = requests.get(url) #发送请求

print(req.text) #打印信息输出结果

ok,这四步流程就是走完了,接下来就是怎么把爬取的数据保存下来,那么继续往下看。

存储数据

存储数据的格式有很多种,例如csv、html、spl、xls等,全看个人意愿选择。基本代码如下

with open('./文件名称路径', '文件操作模式', encoding = '编码格式') as fp:fp.write(page_text) #括号内容为变量,包含要写入的文本内容最终代码如下

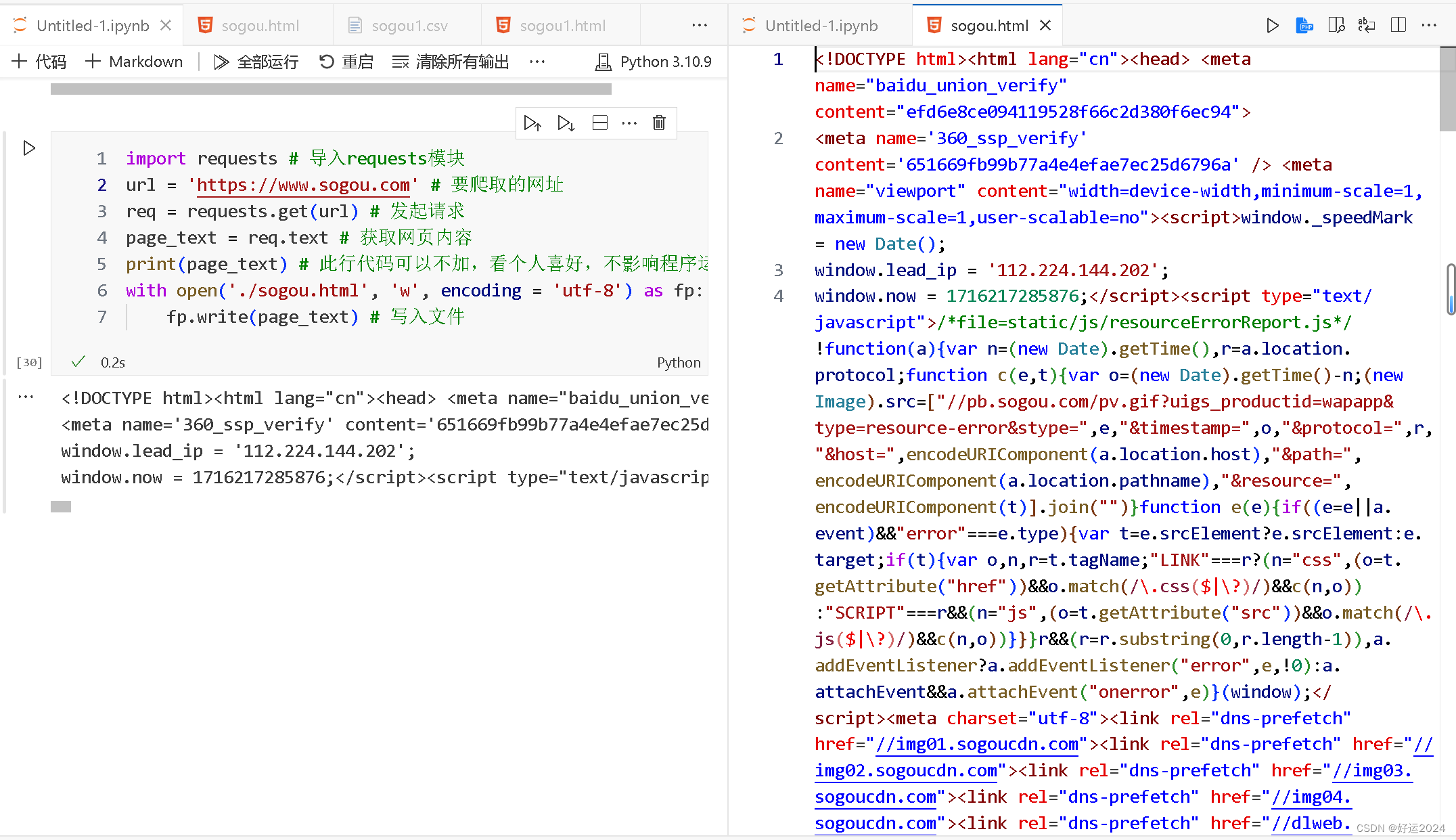

import requests # 导入requests模块

url = 'https://www.sogou.com' # 要爬取的网址

req = requests.get(url) # 发起请求

page_text = req.text # 获取网页内容

print(page_text) # 此行代码可以不加,看个人喜好,不影响程序运行

with open('./sogou.html', 'w', encoding = 'utf-8') as fp: # 保存网页内容到本地fp.write(page_text) # 写入文件输出结果:

这些简单的爬虫流程我们从爬取数据到存储数据就是做完了,是不是很简单啊,当然,对任何事物还是要保持敬畏之心和上进之心。

我是好运,想要好运,今日分享,到此一游