☀️教程:霹雳吧啦Wz

☀️链接:https://www.bilibili.com/video/BV1af4y1m7iL?p=1&vd_source=c7e390079ff3e10b79e23fb333bea49d

一、R-CNN

R-CNN(Region with CNN feature)是由Ross Girshick在2014年提出的,在PASCAL VOC目标检测竞赛中获得冠军,是利用深度学习进行目标检测的开山之作。

1.1 R-CNN算法流程

(1)候选区域的生成

(2)深度网络提取候选框特征

得到的特征图展平后不经过全连接层

(3)将特征向量送入所有的SVM分类器,判定类别

SVM分类器是一个二分类的分类器,所以每一个分类器只能判定一个类别,对于PASCAL VOC来说一共20个类别,所以共20个SVM分类器。

得到的2000×20的矩阵,每一行表示一个候选框,每一列代表是某个类别的概率。

利用非极大值抑止(NMS)算法,剔除重叠建议框:

其中,IoU是交并比(A与B的交集除以A与B的并集),交并比越大,重叠部分越多。

NMS算法是根据每一个类别来应用到所有的候选框上的,举例,第一个类别是猫,那么就对所有候选框预测为猫的概率值进行NMS,第二个类别是狗,那么就对所有候选框预测为狗的概率值进行NMS,如下图所示,是按照每一列来依次进行处理的:

NMS算法的流程是:

- 寻找该类得分最高的目标

- 计算其他目标与该目标的IoU值

- 删除所有IoU值大于给定阈值的目标

这样下来,每一个类别都会剩下N个候选框。

(4)使用回归器精细修正候选框位置

对NMS处理后的建议框进一步筛选,我的理解是接着剔除掉那些概率低的候选框,原论文中说的是保留那些与真实边界框(Ground Truth)有相交并且IoU大于某个阈值的候选框。

接下来同样使用CNN提取所有候选框的特征向量,对其进行回归,得到偏移量。

1.2 R-CNN框架

1.3 R-CNN存在的问题

针对第二点,训练速度慢,是因为四个部分的训练是相互独立的,进而导致了第三点训练所需空间大的问题。

二、Fast R-CNN

Fast R-CNN是在2015年Ross Girshick继R-CNN后的又一力作。同样使用VGG16作为backbone,与R-CNN相比训练时间快了9倍,推理时间快213倍,准确率从62%提升到66%(在PASCAL VOC数据集)

2.1 Fast R-CNN算法流程

(1)候选区域的生成

与R-CNN方法相同

(2)一次性计算整张图像的特征,并根据候选框的区域来投射到特征图上获得相应特征矩阵

关于数据采样的问题:

在Fast R-CNN训练过程中,并不是使用SS算法提供的全部候选框,而是使用其中的一小部分,而且对采样的数据分正负样本,正样本存在我们想要检测的东西,负样本可以理解为背景,里面没有想要检测的目标。这样的做法是防止网络在训练过程中偏向于正样本的结果(数据不平衡导致的)。

论文中的方法是对于每张图片,从2K个候选框中采样64个候选区域,64个候选区域中一部分是正样本一部分是负样本。正样本的定义是候选框与真实框的IoU大于0.5,负样本的定义是与所有真实框IoU值最大在0.1-0.5之间的候选框。

(3)采样完样本之后,对于每个样本,将其区域投射到整张图像特征图中得到其区域特征图,再经过RoI Pooling层调整到统一的7×7尺寸,输入进分类网络和回归网络完成该候选框的分类和预测。

RoI Pooling Layer的实现原理:

其实就是将候选框划分为7×7的49个区域,再对这些区域进行最大池化,完成特征尺寸的调整。这样一来就不限制候选框图像的输入尺寸了(R-CNN需要将输入图像调整到227×227再进行操作)。

接下来,将最大池化后的特征图经过两个全连接层得到RoI Feature Vector,再输入进分类器与回归器(两个是并联的)

针对分类器:实际上是一个全连接层

分类器将会输出N+1个类别的概率,多出来的1预测的是背景概率。

针对边界框回归器:实际上是一个全连接层

针对每一个类别都将输出一个边界框回归参数。每一个边界框回归参数由中心点坐标x,y与宽和高w,h组成。所以最终输出的是(N+1)×4个值。

这个边界框回归参数是你要根据这些参数去调整候选框的位置的,而不是直接预测出来最终的边界框位置。

针对根据边界框回归参数修正候选框:

2.2 Fast R-CNN损失计算

其中,分类损失使用的就是交叉熵损失函数:

其中,边界框回归损失:

λ \lambda λ是一个权衡分类损失与边界框回归损失的系数。

[ u > = 1 ] [u>=1] [u>=1]表示当 u u u小于1的时候,代表这是背景(即负样本),没有边界框回归损失,取值为0。当 u u u大于等于1的时候,代表检测类别,计算边界框回归损失,取值为1。

其中: L l o c ( t u , v ) = ∑ i = x , y , w , h s m o o t h L i ( t i u − v i ) L_{loc}(t^u,v)=\sum_{i={x,y,w,h}}smooth_{L_i}(t_i^u-v_i) Lloc(tu,v)=∑i=x,y,w,hsmoothLi(tiu−vi),实际上表示:

L l o c ( t u , v ) = s m o o t h L x ( t x u − v x ) + s m o o t h L y ( t y u − v y ) + s m o o t h L w ( t w u − v w ) + s m o o t h L h ( t h u − v h ) L_{loc}(t^u,v)=smooth_{L_x}(t_x^u-v_x)+smooth_{L_y}(t_y^u-v_y)+smooth_{L_w}(t_w^u-v_w)+smooth_{L_h}(t_h^u-v_h) Lloc(tu,v)=smoothLx(txu−vx)+smoothLy(tyu−vy)+smoothLw(twu−vw)+smoothLh(thu−vh)

2.3 Fast R-CNN框架

与R-CNN不同的是,分类和回归不再使用传统机器学习方法来做了,全部使用的是CNN来做的。

2.4 Fast R-CNN存在的问题

SS算法划分候选框需要大约2s左右,还是很费时间

并且要想办法把它们融合到一个网络中,使其可以端对端进行训练

三、Faster R-CNN

Faster R-CNN是Ross Girshick继Fast R-CNN之后的又一力作,同样使用VGG16作为backbone,总的推理速度在GPU上达到了5fps,准确率也有进一步提升,在2015年的LSVRC与COCO竞赛中的多个项目都获得了第一名。

Faster R-CNN最主要的改进就是丢弃了SS而使用RPN(Region Proposal NetWork)来生成候选框。

可以说 Faster R-CNN = RPN + Fast R-CNN

3.1 Faster R-CNN算法流程

RPN网络结构:

其中,256-d代表的是一个展平的特征向量,其大小为256,与所使用backbone最后输出的通道数相同,使用ZF为256,使用VGG16为512。

首先介绍一下什么是Anchor Boxes(锚点):

RPN是在图像的特征图上进行操作的,针对该特征图,应用一个3×3的滑动窗口,该窗口滑动到每一个区域上时,需要根据该区域的中心点,找到其在原图上对应的位置,找的方法很简单,即使用中心点的x坐标乘以x轴的stride(x轴的stride即原图的宽除以特征图的宽,再取整),然后使用中心点的y坐标乘以y轴的stride(y轴的stride即原图的高除以特征图的高,再取整),这样就能找到该中心点对应原图的中心点坐标了,接下来,**锚框是目标检测中预设的多种尺寸和比例的矩形框,用于作为模型预测物体位置和尺寸的参照点,**这样根据原图中找到的那个中心点和预设的不同尺寸大小的锚框,就生成了几个候选框。

接下来,介绍滑动窗口对应区域生成的一维向量256-d通过cls层和reg层生成的值是如何影响锚框的。

假如预设了k个锚框,那么通过cls层将生成2k个预测概率,其中两个为一组,分别代表为背景的概率与为前景的概率。通过reg层将生成4k个边界框回归参数,其中四个为一组,代表对锚框的调整参数。

在论文中,作者给出了三个尺度和三个比例共9个Anchor:

关于感受野的问题:

对于ZF来说,一个3×3的滑动窗口对应到原图中会拥有171的感受野

对于VGG来说,一个3×3的滑动窗口对应到原图中会拥有228的感受野

那么我们的锚框大小为256和512时,感受野比锚框小会存在问题吗?作者在论文中解释到根据经验,看到物体的一部分也是可以对其进行预测的,所以这是可以的。

附感受野的计算过程:

对于9个Anchor来说,使用一张1000×600×3的图像会生成大概6k个Anchor:

注意,生成的Anchor经过reg层预测的边界框回归参数调整之后才得到的是候选框。

RPN的实现原理:

针对图像的特征图来,使用一个3×3的卷积核,padding和stride都设置为1,确实是为了保持输出特征图的高度和宽度与输入相同。这样的设置可以确保特征图中每个位置都能被覆盖,并保持空间分辨率。

我们一共要使用256个3×3的卷积(假设是ZF网络),这意味着这个3×3卷积层的输出特征图将有256个通道。对于每个位置在256通道的特征图上,RPN并行地应用两个不同的1×1卷积层。一个用于对象类别(cls,即类别)预测,另一个用于边界框(reg,即回归)预测。

cls层的卷积核数量是2k,其中k是锚框(anchor boxes)的数量。这是因为每个锚框对应两个输出:一个是为前景的概率,另一个是为背景的概率。因此,如果有k个锚框,就需要2k个输出。1×1卷积在这里主要作用是从256维的特征空间映射到一个新的特征空间(例如,对于cls层来说,是2k维,k是锚框的数量)

reg层的卷积核数量是4k,1×1卷积在这里主要作用是从256维的特征空间映射到一个新的特征空间(例如,对于reg层来说,是4k维,k是锚框的数量)

RPN所采用的正负样本:

使用一张1000×600×3的图像会生成大概6k个Anchor,但这些Anchor不是都用来训练网络的,论文中是采用在这些Anchor里采样256个Anchor,其中正负样本比例为1∶1。

其中,指定正样本的方式有两种:

- 该Anchor与Ground Truth的IoU大于0.7

- 与Ground Truth所相交的Anchor中IoU最大的那一个

因为使用第二个条件的话,可能找不够正样本,所以使用第一个条件来补充。

其中,指定负样本的方式:

- 与所有的Ground Truth的IoU值都小于0.3

3.2 RPN损失计算

其中, p i ∗ p_i^* pi∗就相当于给第i个Anchor打了一个真实标签。 N r e g N_{reg} Nreg是Anchor的位置的个数,也就是特征图的尺寸60×40。

在实现的时候其实 λ 1 N r e g \lambda\frac{1}{N_{reg}} λNreg1可以直接替换为 1 N c l s \frac{1}{N_{cls}} Ncls1,因为论文中 λ \lambda λ设置的为10,这样化简下来两个差不多。

对于分类损失,实际上使用的还是多类别的交叉熵损失:

例如,针对第一个Anchor,其真实标签为1,那么他的损失就是 − l o g 0.9 -log0.9 −log0.9,针对第二个Anchor,其真实标签为0,那么他的损失就是 − l o g 0.2 -log0.2 −log0.2。

对于边界框回归损失:

它与Fast R-CNN的边界框回归损失一样。

3.3 Faster R-CNN损失计算

Faster R-CNN的损失 = RPN的损失 + Fast R-CNN的损失

3.4 Faster R-CNN的训练

3.5 Faster R-CNN框架

3.6 总结

四、目标检测评价指标

4.1 AP(Average Precision)

在目标检测任务中,AP(Average Precision)是一种常用的评估指标,用于衡量模型在检测特定类别对象上的性能。AP主要考虑了模型预测的准确性和查全率,结合了精度(precision)和召回率(recall)两个指标:

- 精度(Precision):在所有预测为正类的样本中,真正正类的比例。

- 召回率(Recall):在所有真实正类的样本中,被预测为正类的比例。

Precision-Recall 曲线:

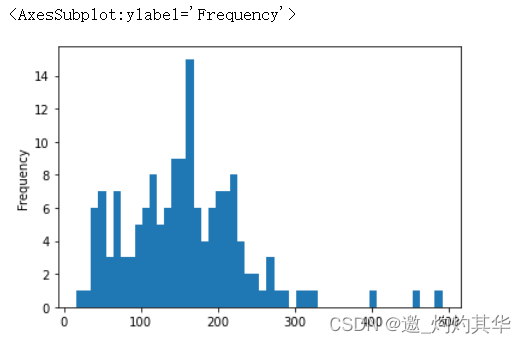

对于目标检测模型,通常会计算在不同置信度阈值下的精度和召回率,从而绘制出一个Precision-Recall曲线。

AP的计算:

AP是这个Precision-Recall曲线下面积的一个度量,通常采用数值积分方法来近似计算。理想的目标检测模型会尽可能接近右上角,即具有高精度和高召回率。

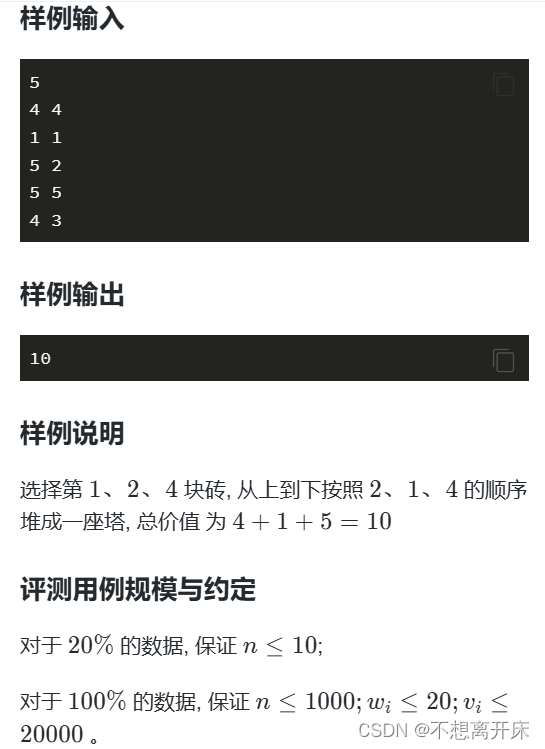

举例理解:

AP(Average Precision)通常是针对目标检测中的某一个特定类别来计算的。比如在一个包含多种物体的图像中,如果我们要评估检测“猫”的效果,就会单独计算检测“猫”这一类别的AP。

当目标检测系统在图像中识别目标(比如猫)时,它不仅会标记出它认为猫所在的位置(通常是一个边框),还会给出一个“自信度”分数。这个分数表示系统有多确信这个边框内确实有猫。在处理完一批图像后,我们会得到很多这样的预测。为了计算AP,我们首先需要将这些预测按照自信度从高到低进行排序。这样做的目的是先评估那些系统最确信的预测。

从自信度最高的预测开始,我们逐一检查每个预测:

- 准确性(精度):这是指到目前为止所有被认为是正类(即猫)的预测中,正确预测(真正类)的比例。例如,如果前十个最高自信度的预测中有九个是正确的,那么准确性为90%。

- 查全率(召回率):这是指系统找到的正确预测占所有真实猫的比例。假设总共有100只猫在图像中,如果系统正确标记出了50只,那么查全率为50%。

随着我们继续检查更多预测,精度和查全率会不断变化。通常,随着我们检查越来越多的预测,查全率会增加(因为找到更多正确的猫),但精度可能会下降(因为可能会开始加入更多错误的预测)。

将这些精度和查全率点连接起来,就形成了一个Precision-Recall曲线。AP就是这条曲线下的面积,它提供了一个单一的数值来综合评估检测性能,越接近1表示性能越好。

4.2 mAP

在多类目标检测任务中,会计算每个类别的AP,然后取所有类别AP的平均值,称为mAP。这是目标检测领域中一个非常重要的指标,用于评价模型在所有类别上的整体性能。

五、FPN网络

FRN(Feature Pyramid NetWorks):Faster R-CNN与特征金字塔网络(FPN)的结合,可以极大地提升对不同尺寸物体的检测能力。这种结合的核心是利用FPN来增强Faster R-CNN中的特征提取能力,使其能够更有效地处理各种尺寸的物体。

5.1 FRN的引入

(a)在传统的图像预测的时候,我们采用的是将图片缩放成图片金字塔,让后对每张图片得到其特征图,分别对每个特征图进行预测。这样的操作有助于网络对大目标和小目标都能识别的很好。

(b)这是Faster R-CNN的预测方式,即将图片卷积成一个特征图,对其进行预测,这样的方式针对小目标的检测不太好

(c)这种方式表示针对图像卷积过程中得到的每一个特征图,都对其进行预测。

(d)FPN所使用的方式,不只是简单的像c图一样对backbone卷积的过程中得到的特征图直接进行预测,而是采取了不同特征图上的特征进行融合后预测的方式。实验结果表明,这样做确实有助于提升检测效果。

5.2 特征融合方式

特征图融合方式:

首先,每一层卷积其卷积后得到的特征图尺寸要求都是2的倍数,即逐渐缩小2倍。

1×1的卷积保证的是不同层的特征图进行融合的时候其通道数是一样的。

在上面一层的特征图与下面的特征图进行融合之前,要对上层特征图做2倍上采样处理。

更完整的FPN结构如下图:

这张图展示了,再每一层的特征图都完成融合之后,还会再接一个3×3的卷积层,做进一步的融合,得到特征图才来做预测。除此之外,在最上层的特征图融合完毕之后,还会采取一个最大池化下采样来进行预测。

5.3 FPN + Faster R-CNN

在FPN和Faster R-CNN结合的时候,P6只用于RPN,即生成候选框的时候,使用五个特征图来生成RoI。而在Fast R-CNN,即在RoI映射的时候,只会映射到P2到P5上。具体意思如下:

在Faster R-CNN中,RPN用于生成候选区域(region proposals)。在结合了FPN之后,RPN不再只在最顶层的特征图上运行,而是在多个尺度的特征图上运行。这样,每个尺度的特征图都可以独立地生成适合其尺度的候选区域。例如,较大的物体在较低层(更大尺寸的特征图)上检测,而较小的物体在较高层(更小尺寸的特征图)上检测。

接下来到了Fast R-CNN,在传统的Fast R-CNN中,所有的RoI(Region of Interest)都是从同一个尺度的特征图上提取特征。而在FPN结构中,每个RoI可以从不同尺度的特征图上提取特征(因为backbone产生了多个特征图),这是根据其大小和比例自动选择的。这样做可以确保更适合RoI的特征表示,因为较小的物体在高分辨率的特征图上能够保留更多细节,而较大的物体则在语义信息更丰富的低分辨率特征图上进行处理。

注意:由于使用了FRN,产生的特征图不止一个了,所以针对不同尺度的特征图,会采用不同尺寸和比例的Anchor来生成RoI。

注意:针对不同的预测特征层,RPN和Fast RCNN的权重是共享的。

针对从不同尺度的预测特征层上预测的RoI来说,会根据下图的方式,来选择将其投影到哪一个特征层上获得其特征图: