大模型InstructBLIP进行指令微调

- 一、引言

- 二、InstructBLIP模型介绍

- 三、指令微调训练通用视觉语言模型的应用潜力

- 四、InstructBLIP的指令微调训练步骤

- 五、实验结果与讨论

- 六、结论与展望

一、引言

随着人工智能技术的快速发展,视觉语言模型(Vision-Language Models, VLMs)成为了解决多模态任务的重要工具。在这些模型中,InstructBLIP凭借其独特的架构和强大的性能,成为了近期研究的热点。本文旨在探讨如何使用大模型InstructBLIP进行指令微调训练,以构建通用视觉语言模型,并详细阐述其应用潜力和具体的训练步骤。

二、InstructBLIP模型介绍

InstructBLIP是基于BLIP-2模型进行指令微调训练得到的视觉语言模型。它结合了自然语言处理(NLP)和计算机视觉(CV)的技术,旨在处理和理解图像与文本之间的关联。InstructBLIP通过引入指令微调(Instruction Tuning)技术,使得模型能够理解和遵循自然语言指令,从而在处理多模态任务时更加灵活和准确。

三、指令微调训练通用视觉语言模型的应用潜力

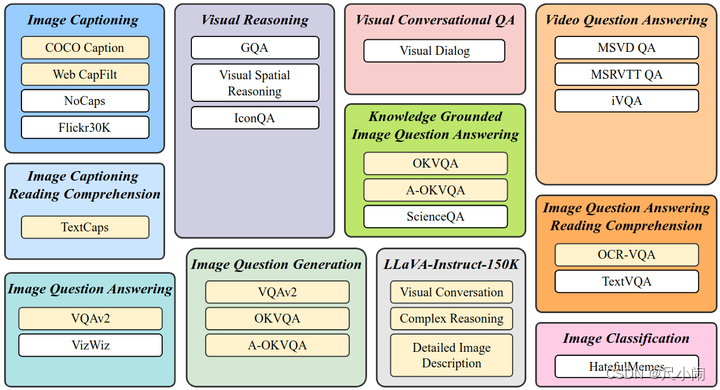

指令微调训练使得InstructBLIP模型具有处理各种多模态任务的能力,包括图像描述生成、视觉问答、跨模态文本到图像的生成等。这种通用性使得InstructBLIP在多个领域都具有广泛的应用潜力,如教育、医疗、娱乐等。

四、InstructBLIP的指令微调训练步骤

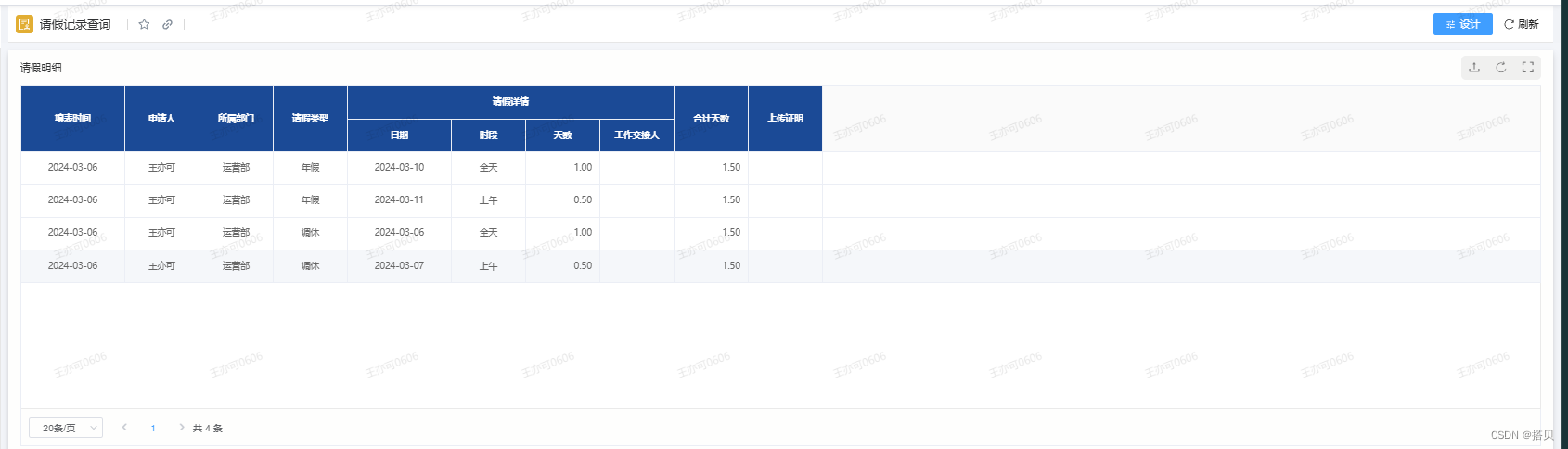

1.数据准备

首先,需要收集包含图像和文本对的大规模数据集。这些数据集应涵盖多种多模态任务,以便模型能够学习到丰富的视觉和语言关联。同时,为了进行指令微调训练,还需要将数据集转换为指令格式,即每个样本都包含一个自然语言指令和对应的图像文本对。

2.模型参数设置

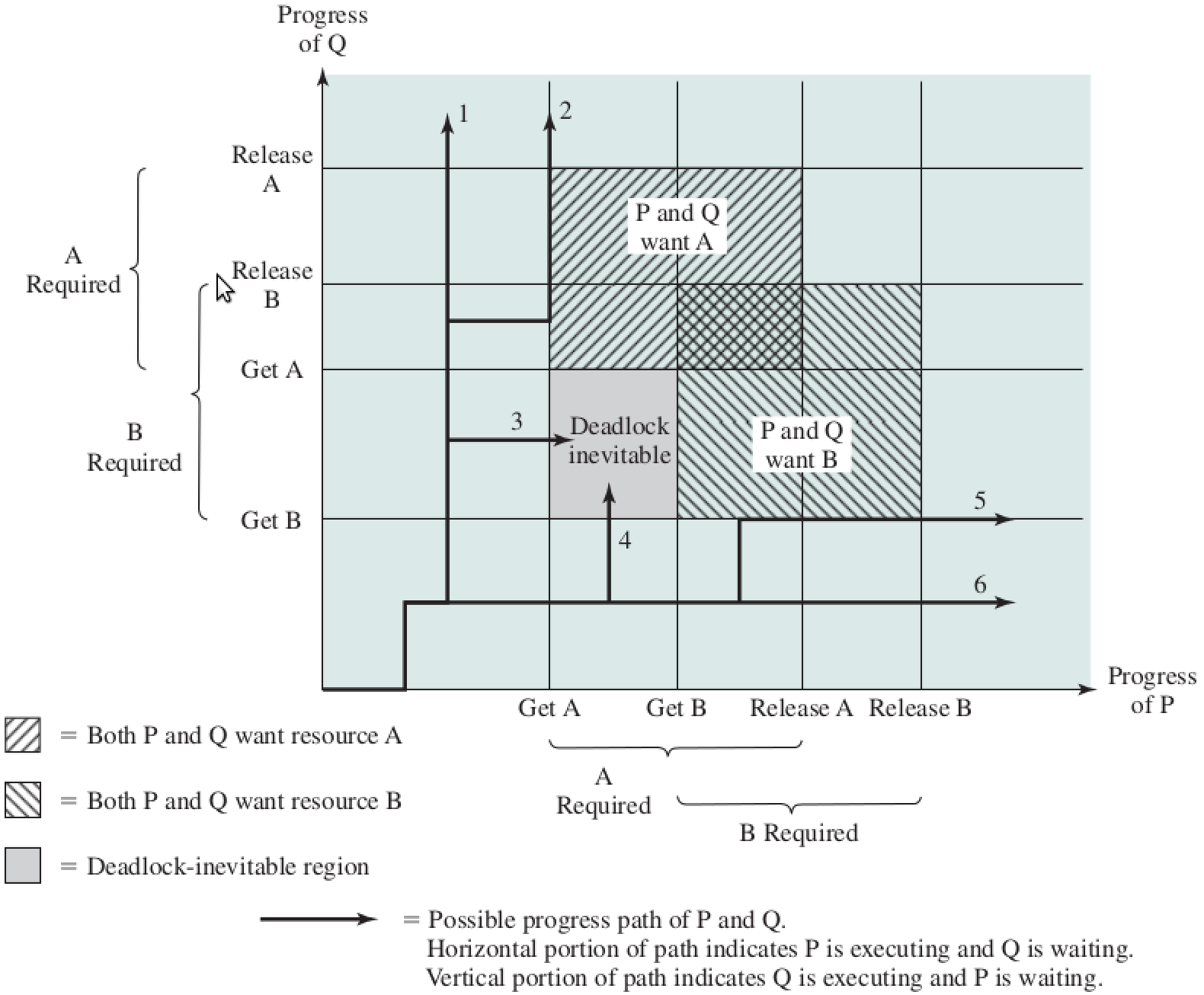

在训练之前,需要设置InstructBLIP模型的参数。这包括学习率、批次大小、训练轮数等超参数。此外,还需要确定在指令微调期间要训练的模型组件。在InstructBLIP中,通常只训练Q-Former部分,而冻结图像编码器和LLM的参数。

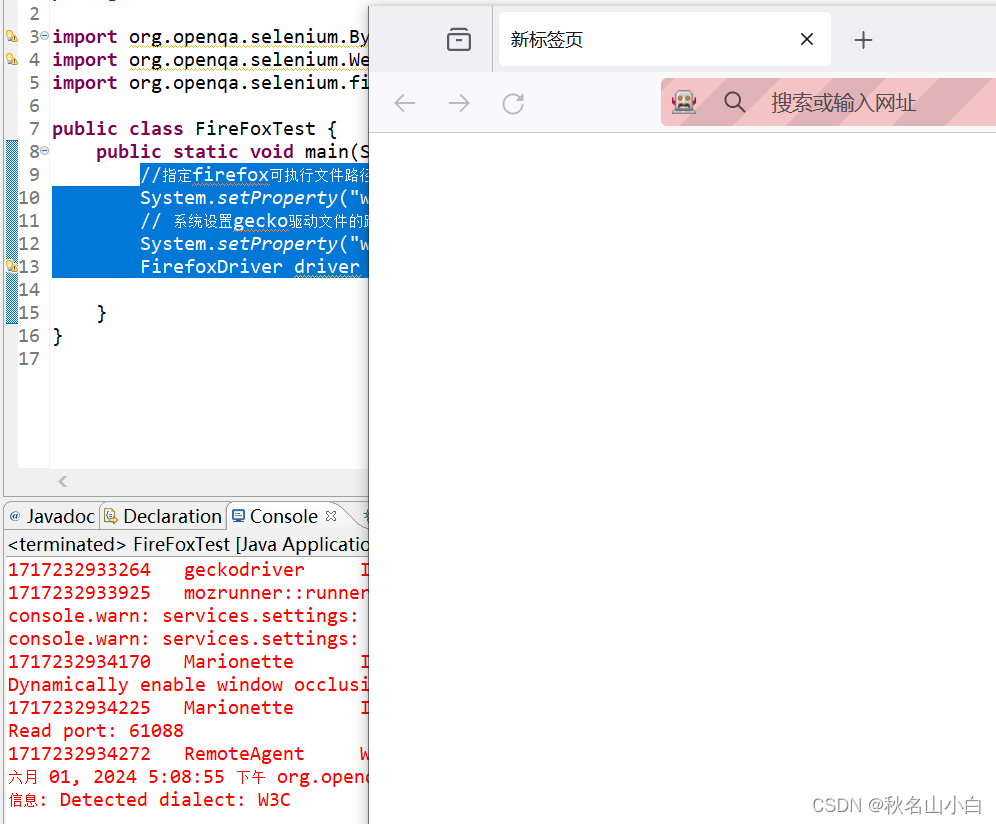

3.训练过程

在训练过程中,首先将预训练好的BLIP-2模型作为初始化点,然后按照指令微调训练的方式对Q-Former部分进行训练。具体来说,对于每个样本,将其中的指令和图像文本对输入到模型中,通过前向传播计算损失函数,并使用优化算法更新Q-Former的参数。在训练过程中,可以使用验证集来监控模型的性能,并根据需要进行调整。

五、实验结果与讨论

通过指令微调训练,InstructBLIP模型在多个多模态任务上取得了优异的性能。与BLIP-2和其他视觉语言模型相比,InstructBLIP在零次学习(Zero-Shot)能力方面表现更为出色,能够在未见过的数据集和任务上实现良好的性能。此外,通过定性和定量评估,我们还发现InstructBLIP在处理复杂多模态任务时具有更高的灵活性和准确性。

六、结论与展望

本文介绍了如何使用大模型InstructBLIP进行指令微调训练以构建通用视觉语言模型。通过详细阐述指令微调训练的步骤和方法,我们展示了InstructBLIP在处理多模态任务时的优势和应用潜力。未来,我们将继续探索InstructBLIP在其他领域的应用,并进一步优化其性能和泛化能力。

![SpringMVC[从零开始]](https://img-blog.csdnimg.cn/direct/22aa08872ce84232a73fea506c7201b9.png)