Pine 鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

什么样的新技术,能在ChatGPT的包围圈里脱颖而出火爆全场?

一部iPhone,两分钟,真人大变数字人!

还是表情动态、眼神细节一比一还原的那种。

没错,动作捕捉视频,发布会现场iPhone录制,后期处理全过程也都当场完成。

在此之前,这位《地狱之刃》女主演经历的动捕都是酱婶的:

复杂的设备必不可少,而且不仅要在脸上标满定位点,后期花费的时间也还得长达几周甚至数月。

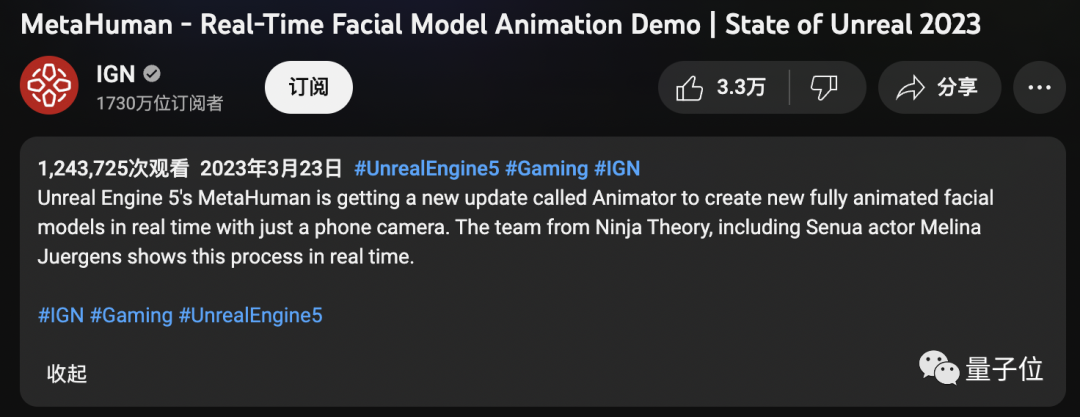

这不,Epic刚把虚幻引擎5这一新能力公布出来,网友们都炸了锅了,相关视频播放量迅速突破百万。

“现场”氛围嘛,总结起来就是一通操作猛如虎,网友直呼太疯狂:

(实现面部建模)从几个月到几分钟,未来几年游戏的发展必定是疯狂的。

还有网友表示,以后再也不能说什么眼见为真了。

三帧视频就能生成3D模型

具体来看看,这一名为“MetaHuman Animator”的骚操作,究竟是如何做到两分钟搞定面部动捕的。

以现场演示为例。首先,演员要录制一段视频,期间可以做出任何表情。可以是夸张的愤怒:

也可以是细小的眼神变化:

并且录制全程只需一部iPhone。

接下来,技术人员将录制好的视频上传到软件,整个处理过程都是在本地进行。

总结下来,处理过程分为两步:

1、最新版本的Live Link Face应用程序会尽可能用最佳的分辨率捕获所有面部动态;

2、MetaHuman Animator使用视频和Dev数据将其转换成高保真的动画。

在这个过程中,先是用Live Link Face对演员的视频进行面部动作捕捉。

完成面捕之后,只需要三帧视频 (正面、左侧面、右侧面)就能生成演员的“元人类DNA”。

其中用到的算法是定制版面部特征算法,生成的过程只要几秒钟。

这样一来,所有的面部数据都会被标定,还原出刚刚视频录制中的面部表情也就更加容易了。

更重要的是,在这个过程中,可以将真人视频与生成的建模视频进行逐帧比较。

然后等几分钟不到,完整的动画视频就成功生成了,最终工作人员要做的就只有微调和导入音频。

在新应用的加持下,做到下图这样的效果,对于工作人员来说也是信手拈来。

算法细节上,Epic是采用自家“面部求解器”和“标志检测器”来确定视频中人物面部的关键操作点。

利用这些关键点,基于语义空间解决方案,AI会将每一帧视频映射到“n维人类空间”数据库中的最近邻居上。

这个所谓“n维人类空间”,是Epic在多年来收集到的详细面部捕捉数据的基础上,挑选打磨过的庞大数据库,包含头部各个部位的各种运动姿态。

网友:3D动画和游戏都要变天了

Epic这波炸场,算是给最近被AI大浪冲击得恍恍惚惚的人类,又添了一点刺激。

有metahuman领域的网友就说“3D动画和游戏都要变天了”:

几个月前用iPhone还只能捕捉到大致的面部肌肉控制。

不过,相比于各种“失业”现场,对于这项技术,更多人乐见其成。

有网友表示,有了这项技术之后,开发人员直接效率翻倍,能够节省太多时间,要做的就只有后期润色。

还有网友已经在期待电影制作人使用这项技术了:

Epic自己则说,新的MetaHuman Animator有利于“复杂角色技术的民主化”。并表示这项新技术有望在今年夏天更广泛地推出。

那么,你期待吗?

参考链接:

[1] https://www.unrealengine.com/en-US/blog/new-metahuman-animator-feature-set-to-bring-easy-high-fidelity-performance-capture-to-metahumans

[2] https://www.youtube.com/watch?v=pnaKyc3mQVk

[3]https://arstechnica.com/gaming/2023/03/epics-new-motion-capture-animation-tech-has-to-be-seen-to-be-believed/

— 完 —

3月29日「中国AIGC产业峰会」

抢票开启

「中国AIGC产业峰会」定档3月29日,线下会场抢票开启!

百度袁佛玉、智源林咏华、澜舟科技周明、小冰徐元春、科大讯飞高建清、启元世界袁泉、云舶科技梅嵩、特赞王喆、微软关玮雅、源码资本黄云刚、元语智能朱雷、无界Ai马千里、Tiamat青柑、峰瑞资本陈石等来自产学研界大咖嘉宾,还有重磅嘉宾陆续确认中。

扫描下方二维码,报名峰会线下会场啦~

点这里👇关注我,记得标星哦~